Inhalt

Inhalt

Zusammenfassung

Teil I: Fehlklassifizierung 2.0: Gesteuert durch Algorithmus

Überwachungsfallstudie I: Fehler bei der Gesichtserkennung

Fallstudie Überwachung II: Geolocation-Checks

Undurchsichtiges Leistungsmanagement

Fallstudie: Algorithmische Steuerung

Ausbau der Strafverfolgungsinfrastruktur

Fallstudie: Austausch von Informationen mit Strafverfolgungsbehörden

Teil II: Ausübung von Datenrechten am Arbeitsplatz: Zugang

Fallstudien: Individuelle DSARs

Rundschreiben und vergebliche Antworten

Inkonsistenter und inkrementeller Datenaustausch

Fallstudien: Plattformantworten auf Batch-Anfragen von WIE

Teil III: Ausübung von Datenrechten am Arbeitsplatz: Rechtsstreitigkeiten

Uber-Fahrer gegen Uber I (allgemeine Transparenzanfragen)

Ola-Treiber vs. Ola (allgemeine Transparenzanfragen)

Uber-Fahrer vs. Uber II (Transparenz bei der automatisierten Entscheidungsfindung)

Berufungsverfahren gegen die Londoner Lizenzvergabe

Fazit: Der Weg zur Ausübung digitaler Rechte am Arbeitsplatz?

Zusammenfassung

Worker Info Exchange wurde eingerichtet, um den Zugang und die Kollektivierung von Daten zu erleichtern, um durch die Einrichtung eines Daten-Trusts Verhandlungsmacht aufzubauen.

Dies war eine Reaktion auf die Entwicklung neuer algorithmischer Managementpraktiken, die tiefe Informationsasymmetrien und die Ausbeutung der Arbeitnehmer verursachten.

Worker Info Exchange zielt darauf ab, die Konvergenz von Daten- und Arbeitnehmerrechten durch Berufung auf die Rechte der Artikel 15, 20 und 22 der DSGVO im Beschäftigungskontext anzugehen.

Dieses Ziel wird durch die weit verbreitete Nichteinhaltung der DSGVO in der Gig-Branche stark behindert.

Wir haben in den letzten acht Monaten über 500 Zugriffsanfragen betroffener Personen an sieben verschiedene Mitfahrplattformen gestellt, darunter Amazon Flex, Bolt, Deliveroo, Free Now, Just Eat, Ola und Uber.

Der Datenzugriff wird von Unternehmen in Frage gestellt, die dunkle Muster einsetzen und die lückenhafte Umsetzung der DSGVO bewusst missbrauchen, was die Mitarbeiter dazu bringt, Probleme vor Gericht zu lösen.

Die Datensammlung durch Gig-Plattformen ist exzessiv und führt zu einer unverhältnismäßigen und nicht nachvollziehbaren Überwachung der Arbeitnehmer sowie zu einer wachsenden Infrastruktur für die Strafverfolgung.

Es gibt keine Transparenz über die verwendeten algorithmischen Managementsysteme. Unternehmenserzählungen darüber, welche Technologien wie eingesetzt werden, sind inkonsistent und unzuverlässig.

© 2021 Worker Info Exchange

© 2021 Worker Info Exchange

Einführung

Das vergangene Jahr hat für Gig-Plattform-Arbeiter einen Wendepunkt bei der Verwirklichung ihrer Arbeits- und digitalen Rechte markiert. Die Praxis der digital vermittelten Arbeit hat zu einer Konvergenz von Beschäftigungs- und Datenschutzrechten geführt, und die zunehmende Prozessführung und Interessenvertretung von Arbeitnehmern hat in diesen Bereichen zu Ergebnissen geführt. In ganz Europa haben Gerichte mehrere bedeutende Urteile gefällt, in denen sie die ausbeuterische Rolle algorithmischer Managementpraktiken durch Gig-Plattformen anerkennen und gleichzeitig den Mangel an Fairness und Transparenz in solchen automatisierten Systemen verurteilen.

In Italien entschied das Gericht in Bologna, dass das Bewertungssystem von Deliveroo Arbeitnehmer diskriminiert hatte, während die Datenschutzbehörde Garante Deliveroo und Glovo zwei DSGVO-Bußgelder verhängte, weil sie die Funktionsweise ihrer Algorithmen für die Stellenzuweisung und das Leistungsmanagement nicht angemessen offenlegten.

Spanien hat das erste Gesetz verabschiedet, das versucht, KI im Bereich der Beschäftigung zu regulieren, indem es sowohl den Arbeiterstatus für Gig-Worker als auch das Recht festlegt, über die Regeln und Parameter der Algorithmen informiert zu werden, denen sie unterliegen - was eine Flut von Beschwerden auslöst. Dies resultierte aus einem weiteren Gerichtsverfahren gegen Glovo, das vor dem spanischen Obersten Gerichtshof endete.

Zusammen mit diesen hochkarätigen Entscheidungen kam der Oberste Gerichtshof des Vereinigten Königreichs in diesem Jahr auch zu dem Schluss, dass Uber-Fahrer an einem Transportdienst beteiligt waren, der „ sehr streng von Uber definiert und kontrolliert wird “, was ein klares Arbeitsverhältnis verriet, das nach Angaben des Unternehmens nicht existierte sein Bestreben, die Arbeitnehmer als unabhängige Auftragnehmer (falsch) einzustufen. Der Beweis für diese Beziehung stammt vor allem aus den datengesteuerten Systemen, die Fahrgemeinschaften verwenden, um ihre Mitarbeiter zu verwalten. Einige der vom Obersten Gerichtshof des Vereinigten Königreichs hervorgehobenen Probleme betrafen das Management von Fahrern durch die algorithmische Überwachung von Jobannahmequoten, Routenwahl, Fahrverhalten und Kundenbewertungen. Obwohl das algorithmische Management eine größere Anerkennung findet, schützen die jüngsten Fortschritte bei den Gerichten die Arbeitnehmer jedoch nicht vollständig vor seinen Schäden. Der den Uber-Fahrern aufgrund der Entscheidung des Obersten Gerichtshofs zuerkannte Arbeitnehmerstatus von Glied (b) ist ein Vermittlerstatus zwischen Auftragnehmer und Arbeitnehmer und schützt sie beispielsweise immer noch nicht vor ungerechtfertigten Entlassungen.

Unsere Erfahrung deutet darauf hin, dass diese algorithmischen Managementtools zusammen mit intensivierten Überwachungspraktiken, die die Mitarbeiter kontinuierlich auf potenzielle Betrugs- oder Fehlverhalten untersuchen, zu einer zutiefst ausbeuterischen Arbeitsumgebung führen. Wir sehen in der gesamten Gig-Branche eine übermäßige Anzahl von automatisierten Kündigungen, von denen wir viele als rechtswidrig gemäß Artikel 22 der Datenschutz-Grundverordnung (DSGVO) erachten . Artikel 22 bietet Arbeitnehmern einen begrenzten Schutz vor den nachteiligen Auswirkungen automatisierter Entscheidungsfindung und Profilerstellung durch das Recht, menschliches Eingreifen zu erwirken und die Entscheidung anzufechten. Art. 15 DSGVO garantiert das Recht, über das Bestehen einer solchen automatisierten Entscheidungsfindung informiert zu werden und aussagekräftige Informationen über die Logik der Verarbeitung zu erhalten.

Ausgehend von diesen Rechten wurde Worker Info Exchange mit dem Ziel gegründet, Gig-Mitarbeiter bei der Navigation durch diesen komplexen und regulierten Raum zu unterstützen. Ziel und Auftrag unserer Arbeit ist es, zu testen, ob diese DSGVO-Instrumente zur Bekämpfung unlauterer Beschäftigungspraktiken und zur Erweiterung des Umfangs der Daten, die Einzelpersonen in ihrer Eigenschaft als Arbeitnehmer zur Verfügung gestellt werden, eingesetzt werden können. Mit anderen Worten, unser Ziel ist es, den Datenzugriff als Methode zum Aufbau kollektiver Arbeitermacht zu nutzen, um Rechtsschutzmechanismen auf einem digital vermittelten Arbeitsmarkt zu testen.

Wenn das Arbeitsverhältnis zwischen der Gig-Plattform und dem Arbeitnehmer durch umfangreiche Datenerhebung und -analyse durchgeführt wird, werden Arbeitsrechte untrennbar mit der Ausübung von Datenrechten verbunden. Gig-Plattformen behaupten die Kontrolle über die Mitarbeiter, indem sie eine Informationsasymmetrie aufrechterhalten, und der Datenzugriff kann ein Mittel sein, um das Macht(un)gleichgewicht aufzudecken, das durch die Informationslücke zwischen Gig-Plattformen und ihren Mitarbeitern entsteht. Der Zugang zu personenbezogenen Daten kann es Arbeitnehmern ermöglichen, ihre Arbeitsbedingungen unabhängig zu bewerten und Fragen zu ihrer Lohnberechnung, der Qualität und Quantität der angebotenen Arbeit zu beantworten sowie die Gründe für ein nachteiliges Leistungsmanagement, einschließlich Entlassungen, in Frage zu stellen und Entlassung.

Unser Ziel bei der Erleichterung des Datenzugriffs ist es, kollektive Datenspeicher zu schaffen, um ein besseres Verständnis der Arbeitsbedingungen und damit der Verhandlungsmacht zu entwickeln. In den letzten Jahren sind eine Reihe bemerkenswerter Initiativen entstanden, die ähnliche Ziele verfolgen, jedoch unterschiedliche Methoden zum Abrufen von Daten verwenden. Einige Projekte in diesem Bereich führen eigene Datenerhebungen und Analysen zu Verdiensten und Leistungen durch, um die Fairness der Arbeitsbedingungen zu beurteilen (z. B. Driver's Seat Coop und WeClock, unter anderem.) Diese alle bieten einzigartige Einblicke in die Gig Economy und sollten als Kontinuum der Datenpraxis betrachtet werden. Wir haben dieses Problem angegangen, indem wir gefordert haben, dass Plattformen die Daten teilen, auf die Arbeitnehmer ein gesetzliches Recht haben. Dies hat jedoch zusätzliche Hindernisse für das übergeordnete Ziel der Datenkollektivierung geschaffen. Wir sind diesen Weg gegangen, weil wir Standards und Präzedenzfälle im Datenschutzrecht setzen wollten, aber auch, weil wir glauben, dass es bestimmte Arten von Informationen gibt, die nur durch direkte Anforderung der Daten bei den Plattformen erhalten werden können.

Wir haben festgestellt, dass es insbesondere im Fall von überwachungsbasierten Vorwürfen über unregelmässige Aktivitäten und Betrug erforderlich ist, die Daten der Unternehmen zu haben, um die Vorwürfe zu verstehen und zu widerlegen. Der Datenzugriff kann uns helfen, die Inkonsistenzen in den von Plattformunternehmen vorgebrachten Erzählungen aufzudecken und die Beweislast von den Arbeitern zurück auf die Plattformen zu verlagern. Aus dieser Perspektive hat sich das Bestreben, Plattformdaten zu fordern, bei der Lösung zahlreicher arbeitsrechtlicher Streitigkeiten als äußerst erfolgreich erwiesen. Die bloße Demonstration der Weigerung von Plattformen, personenbezogene Daten bereitzustellen, hat mehrere (von TfL durchgesetzte) Lizenzwiderrufe gerichtlich rückgängig gemacht und ist damit zu einem zusätzlichen Instrument bei der Ausübung von Arbeitsrechten geworden.

Dies ist der andere Tätigkeitsbereich von Worker Info Exchange; Da wir bei unseren Versuchen, Klarheit und Transparenz über die komplexen Systeme zur Bestimmung der Arbeitsplatzbedingungen zu erlangen, frustriert sind, müssen wir häufig auf Rechtsstreitigkeiten zurückgreifen und Gerichte anrufen, um Entscheidungen im aufstrebenden Bereich der digitalen Arbeitsrechte zu treffen. Die künstliche „Datenkrise“, die die Gig-Plattformen geschaffen haben, ist in vielerlei Hinsicht ein Versuch, die Ressourcen prekärer Arbeitnehmer und Gewerkschaften gleichermaßen zu erschöpfen und zu erschöpfen, indem Streitigkeiten vor Gericht gezogen werden, wo sie verlängert und die Verantwortlichkeit für unternehmerisches Fehlverhalten verzögert werden kann.

Im Einklang mit diesen Handlungssträngen ist dieser Bericht in drei Teile gegliedert: Der erste Abschnitt untersucht verschiedene Facetten des algorithmischen Managements und seine Schäden mit zugehörigen Fallstudien. Der zweite Abschnitt befasst sich mit unserem Prozess bei der Nutzung von Data Subject Access Requests (DSARs), während der dritte einen Überblick über die DSGVO-bezogenen Fälle bietet, die wir in Amsterdam vorangetrieben haben, sowie über die Lizenzierungsfälle, die wir in London unterstützen. Dieser Bericht schließt eine Phase der Arbeit ab, die sich mit diesen Funktionen unserer Organisation befasst und mit Unterstützung der Mozilla Foundation, des Digital Freedom Fund und der Open Society Foundations durchgeführt wurde. Wir hoffen, dass dieser Bericht den aktuellen Stand bei der Ausübung von Rechten an der Schnittstelle von Daten und Arbeit aufzeigt und die kumulativen Auswirkungen wiederholter Nichteinhaltung von Gig-Plattformen aufzeigt.

„Plattformunternehmen agieren in einem gesetzlosen Raum, in dem sie glauben, dass sie die Regeln aufstellen können. Leider ist dies kein Spiel; virtuelle Realitäten haben harte Konsequenzen für Gig-Arbeiter im wirklichen Leben. Ermutigend ist, dass die Arbeitnehmer selbst nicht auf Gesetze warten, sondern politische Entscheidungsträger oder sogar Verbündete in der Menschenrechtsbewegung, um sie zu retten.

Bama Athreya, Fellow, Open Society Foundations

Teil I: Fehlklassifizierung 2.0 Gesteuert durch Algorithmus

Im sechsjährigen Kampf um Arbeitnehmerrechte in der britischen Gig Economy argumentierte Uber, dass es sich lediglich um den Agenten des selbstständigen Fahrers handelt, der nichts weiter tut, als Arbeitsaufträge passiv zu buchen und Zahlungen einzuziehen. Um diese Fiktion voranzutreiben, bauen Gig-Plattformen aufwendige Verträge auf, die den Anschein erwecken, als würden Fahrer und Beifahrer direkt miteinander Geschäfte machen, während tatsächlich alle Fahrgastinformationen von Unternehmen streng abgeschirmt sind. Uber zum Beispiel erstellt im Namen des Fahrers für jeden Mitfahrer eine fiktive Rechnung. Die Rechnung enthält nur den Vornamen des Passagiers und wird nie an den Kunden gesendet.

Diese Fehlklassifizierungstechniken, die in der Gig Economy häufig verwendet werden, ermöglichen es Plattformen, rechtliche Verantwortlichkeiten des Arbeitgebers wie den grundlegenden Schutz der Arbeitnehmerrechte und Sozialversicherungsbeiträge zu vermeiden. In Großbritannien hat es Plattformunternehmen außerdem ermöglicht, die Mehrwertsteuer (MwSt.) zu vermeiden. Aber Anfang dieses Jahres bestätigte der Oberste Gerichtshof das Recht der unteren Gerichte, künstliche Verträge zu verwerfen und die wahre Natur des Arbeitsverhältnisses auf der Grundlage von Beweisen für ein Kontrollverhältnis der Arbeitnehmer durch die Unternehmensleitung zu bestimmen.

Da Plattformunternehmen zu dem Schluss kommen, dass die Verwendung irreführender Verträge als Methode zur Fehlklassifizierung von Beschäftigung nicht mehr praktikabel ist, werden sie versucht sein, die Prozessautomatisierung zu verdoppeln, um die Kontrolle durch das Management zu verschleiern. Die algorithmische Steuerung wird zur Fehlklassifizierung 2.0. Tatsächlich gibt es zahlreiche Beweise dafür, dass dies bereits geschieht. Gig-Plattformen sind entschlossener denn je, Fehlklassifizierungsstrategien zu verfolgen, um die Belegschaft weiterhin zu kontrollieren und gleichzeitig das Risiko zu vermeiden, dass Fahrer vom „Arbeiter“-Status mit eingeschränkten Rechten in den Arbeitnehmerstatus mit wesentlich mehr Rechten übergehen.

Was ist also algorithmische Kontrolle und was sind die spezifischen Risiken für Gig-Worker? Insbesondere in der Mitfahr- und Lieferbranche sind folgende Mittel des algorithmischen Managements von größter Bedeutung für uns:

Überwachung. Aufdringliche Überwachung zum angegebenen Zweck der Sicherheit und Identifizierung. Dies umfasst den Einsatz von Betrugserkennungs- und Gesichtserkennungstechnologien. Uns ist bewusst, dass die Überwachung auch dann durchgeführt wird, wenn sich der Arbeitnehmer nicht eingeloggt hat, um sich für die Arbeit zur Verfügung zu stellen. Dazu gehörte auch die Überwachung der Nutzung der App durch den Arbeitnehmer als Verbraucher.

Leistungsmanagement. Dies beinhaltet, ist aber nicht beschränkt auf die Überwachung des Fahrverhaltens, einschließlich ETA, Kundenbewertungen, Auftragsannahme- und Abschlussquoten, Interaktion mit Support-Mitarbeitern, Verfügbarkeit.

Arbeitsverteilung. Uber hat bis vor kurzem darauf bestanden, dass die Arbeitsverteilung von der Nähe von Fahrern und Fahrgästen abhängt, gibt jedoch jetzt zu, dass vergangenes Verhalten und Präferenzen berücksichtigt werden. Ola räumt ein, dass Fahrerprofile mit „Verdienstprofil“ und „Betrugswahrscheinlichkeit“ bewertet werden werden bei der automatisierten Entscheidungsfindung bei der Arbeitsverteilung verwendet.

Preisgestaltung. Eng verbunden mit der Arbeitsverteilung ist die automatisierte Entscheidungsfindung bei der Preisgestaltung. Die vielleicht bekannteste Methode ist Ubers sogenanntes "Surge" oder "Dynamic Pricing", das vorgibt, die Marktnachfrage mit lokalen Preisschwankungen in Echtzeit zu klären.

Die oben genannten Managemententscheidungen sind meistens automatisiert oder halbautomatisch mit begrenzten menschlichen Eingriffen. Geschäftsmodelle der Gig Economy beruhen auf der Massenautomatisierung von Managemententscheidungen und Arbeitsplatzüberwachung. Während einige Arbeitgeber in diesem Punkt zurückhaltend sind, hat Deliveroo dies in ihrer Datenschutzrichtlinie für Fahrer ganz offen gesagt:

„Angesichts des Umfangs der von uns bearbeiteten Lieferungen verwenden wir automatisierte Systeme, um die oben beschriebenen automatisierten Entscheidungen zu treffen, da sie eine genauere, fairere und effizientere Möglichkeit bieten, mutmaßlichen Betrug zu erkennen, wiederholte Verstöße gegen Ihre Lieferantenvereinbarung zu verhindern und die negativen Auswirkungen auf unser Service. Menschliche Kontrollen wären im Zeitrahmen und angesichts der Liefermengen, die wir bearbeiten, einfach nicht möglich.“

Leistungsmanagement

Dies umfasst, ist aber nicht beschränkt auf die Überwachung des Fahrverhaltens, einschließlich ETA, Kundenbewertungen, Auftragsannahme- und Abschlussraten, Interaktion mit Support-Mitarbeitern, Verfügbarkeit.

Preisgestaltung

Eng verbunden mit der Arbeitszuweisung ist die automatisierte Entscheidungsfindung bei der Preisgestaltung. Die vielleicht bekannteste Methode ist Ubers sogenannte „Surge“- oder „dynamische Preisgestaltung“, die vorgibt, die Marktnachfrage mit lokalen Preisschwankungen in Echtzeit zu klären.

Überwachung

Aufdringliche Überwachung für den angegebenen Zweck der Sicherheit und Identifizierung. Dies umfasst den Einsatz von Betrugserkennungs- und Gesichtserkennungstechnologien. Uns ist bewusst, dass die Überwachung auch dann durchgeführt wird, wenn sich der Arbeitnehmer nicht angemeldet hat, um sich für die Arbeit zur Verfügung zu stellen. Dazu gehörte auch die Überwachung der Nutzung der App durch den Arbeitnehmer als Verbraucher.

Arbeitsverteilung

Uber hat bis vor kurzem darauf bestanden, dass die Arbeitsverteilung von der Nähe von Fahrern und Fahrgästen abhängt, gibt aber jetzt zu, dass vergangenes Verhalten und Vorlieben berücksichtigt werden werden bei der automatisierten Entscheidungsfindung bei der Arbeitsverteilung verwendet.

Teil I: Fehlklassifizierung 2.0 Gesteuert durch Algorithmus

Im sechsjährigen Kampf um Arbeitnehmerrechte in der britischen Gig Economy argumentierte Uber, dass es sich lediglich um den Agenten des selbstständigen Fahrers handelt, der nichts weiter tut, als Arbeitsaufträge passiv zu buchen und Zahlungen einzuziehen. Um diese Fiktion voranzutreiben, bauen Gig-Plattformen aufwendige Verträge auf, die den Anschein erwecken, als würden Fahrer und Beifahrer direkt miteinander Geschäfte machen, während tatsächlich alle Fahrgastinformationen von Unternehmen streng abgeschirmt sind. Uber zum Beispiel erstellt im Namen des Fahrers für jeden Mitfahrer eine fiktive Rechnung. Die Rechnung enthält nur den Vornamen des Passagiers und wird nie an den Kunden gesendet.

Diese Fehlklassifizierungstechniken, die in der Gig Economy häufig verwendet werden, ermöglichen es Plattformen, rechtliche Verantwortlichkeiten des Arbeitgebers wie den grundlegenden Schutz der Arbeitnehmerrechte und Sozialversicherungsbeiträge zu vermeiden. In Großbritannien hat es Plattformunternehmen außerdem ermöglicht, die Mehrwertsteuer (MwSt.) zu vermeiden. Aber Anfang dieses Jahres bestätigte der Oberste Gerichtshof das Recht der unteren Gerichte, künstliche Verträge zu verwerfen und die wahre Natur des Arbeitsverhältnisses auf der Grundlage von Beweisen für ein Kontrollverhältnis der Arbeitnehmer durch die Unternehmensleitung zu bestimmen.

Da Plattformunternehmen zu dem Schluss kommen, dass die Verwendung irreführender Verträge als Methode zur Fehlklassifizierung von Beschäftigung nicht mehr praktikabel ist, werden sie versucht sein, die Prozessautomatisierung zu verdoppeln, um die Kontrolle durch das Management zu verschleiern. Die algorithmische Steuerung wird zur Fehlklassifizierung 2.0. Tatsächlich gibt es zahlreiche Beweise dafür, dass dies bereits geschieht. Gig-Plattformen sind entschlossener denn je, Fehlklassifizierungsstrategien zu verfolgen, um die Belegschaft weiterhin zu kontrollieren und gleichzeitig das Risiko zu vermeiden, dass Fahrer vom „Arbeiter“-Status mit eingeschränkten Rechten in den Arbeitnehmerstatus mit wesentlich mehr Rechten übergehen.

Was ist also algorithmische Kontrolle und was sind die spezifischen Risiken für Gig-Worker? Insbesondere in der Mitfahr- und Lieferbranche sind folgende Mittel des algorithmischen Managements von größter Bedeutung für uns:

Überwachung. Aufdringliche Überwachung zum angegebenen Zweck der Sicherheit und Identifizierung. Dies umfasst den Einsatz von Betrugserkennungs- und Gesichtserkennungstechnologien. Uns ist bewusst, dass die Überwachung auch dann durchgeführt wird, wenn sich der Arbeitnehmer nicht eingeloggt hat, um sich für die Arbeit zur Verfügung zu stellen. Dazu gehörte auch die Überwachung der Nutzung der App durch den Arbeitnehmer als Verbraucher.

Leistungsmanagement. Dies beinhaltet, ist aber nicht beschränkt auf die Überwachung des Fahrverhaltens, einschließlich ETA, Kundenbewertungen, Auftragsannahme- und Abschlussquoten, Interaktion mit Support-Mitarbeitern, Verfügbarkeit.

Arbeitsverteilung. Uber hat bis vor kurzem darauf bestanden, dass die Arbeitsverteilung von der Nähe von Fahrern und Fahrgästen abhängt, gibt jedoch jetzt zu, dass vergangenes Verhalten und Präferenzen berücksichtigt werden. Ola räumt ein, dass Fahrerprofile mit „Verdienstprofil“ und „Betrugswahrscheinlichkeit“ bewertet werden werden bei der automatisierten Entscheidungsfindung bei der Arbeitsverteilung verwendet.

Preisgestaltung. Eng verbunden mit der Arbeitsverteilung ist die automatisierte Entscheidungsfindung bei der Preisgestaltung. Die vielleicht bekannteste Methode ist Ubers sogenanntes "Surge" oder "Dynamic Pricing", das vorgibt, die Marktnachfrage mit lokalen Preisschwankungen in Echtzeit zu klären.

Die oben genannten Managemententscheidungen sind meistens automatisiert oder halbautomatisch mit begrenzten menschlichen Eingriffen. Geschäftsmodelle der Gig Economy beruhen auf der Massenautomatisierung von Managemententscheidungen und Arbeitsplatzüberwachung. Während einige Arbeitgeber in diesem Punkt zurückhaltend sind, hat Deliveroo dies in ihrer Datenschutzrichtlinie für Fahrer ganz offen gesagt:

„Angesichts des Umfangs der von uns bearbeiteten Lieferungen verwenden wir automatisierte Systeme, um die oben beschriebenen automatisierten Entscheidungen zu treffen, da sie eine genauere, fairere und effizientere Möglichkeit bieten, mutmaßlichen Betrug zu erkennen, wiederholte Verstöße gegen Ihre Lieferantenvereinbarung zu verhindern und die negativen Auswirkungen auf unser Service. Menschliche Kontrollen wären im Zeitrahmen und angesichts der Liefermengen, die wir bearbeiten, einfach nicht möglich.“

„Angesichts des Liefervolumens, mit dem wir zu tun haben, verwenden wir automatisierte Systeme, um die oben beschriebenen automatisierten Entscheidungen zu treffen, da sie eine genauere, fairere und effizientere Möglichkeit bieten, Betrugsverdacht zu identifizieren, wiederholte Verstöße gegen Ihre Lieferantenvereinbarung zu verhindern und die negativen Auswirkungen zu begrenzen unser Service. Menschliche Kontrollen wären in dem zeitlichen Rahmen und angesichts des Liefervolumens, mit dem wir es zu tun haben, einfach nicht möglich.“

Überwachung

Aufdringliche Überwachung für den angegebenen Zweck der Sicherheit und Identifizierung. Dies umfasst den Einsatz von Betrugserkennungs- und Gesichtserkennungstechnologien. Uns ist bewusst, dass die Überwachung auch dann durchgeführt wird, wenn sich der Arbeitnehmer nicht angemeldet hat, um sich für die Arbeit zur Verfügung zu stellen. Dazu gehört auch die Überwachung der Nutzung der App durch den Arbeitnehmer als Verbraucher.

Arbeitsverteilung

Uber hat bis vor Kurzem darauf bestanden, dass die Arbeitszuweisung anhand der Nähe von Fahrern und Fahrgästen zueinander entschieden wird, gibt jedoch jetzt an, dass früheres Verhalten und Vorlieben berücksichtigt werden Zuweisung.

Leistungsmanagement

Die Bewertung der Arbeitsleistung umfasst, ist aber nicht beschränkt auf die Überwachung des Fahrverhaltens, einschließlich ETA, Kundenbewertungen, Auftragsannahme- und Abschlussraten, Interaktion mit Support-Mitarbeitern, Verfügbarkeit.

Preisgestaltung

Eng verbunden mit der Arbeitszuteilung ist die automatisierte Preisfindung. Die vielleicht bekannteste Methode ist Ubers sogenannte „Surge“- oder „dynamische Preisgestaltung“, die vorgibt, die Marktnachfrage mit lokalen Preisschwankungen in Echtzeit zu klären.

Wettrüsten in der Überwachung

Seit Uber im Jahr 2020 sein sogenanntes Hybrid Real Time Identification System eingeführt hat, erleben wir ein Wettrüsten in der Gig Economy. Nur einen Tag bevor Transport for London (TfL) im November 2019 seine Entscheidung bekannt gab, die Verlängerung ihrer Lizenz abzulehnen Uber bot an, dieses Überwachungssystem einzuführen, das Gesichtserkennung mit GPS-Überwachung umfasst.

Dies war eine Reaktion auf die Beschwerde von TfL, dass 21 Fahrer (von 90.000, die über mehrere Jahre hinweg analysiert wurden) als am Account-Sharing beteiligt entdeckt wurden, der es potenziell nicht lizenzierten und nicht versicherten Fahrern ermöglichte, ihre Dienste illegal über die App anzubieten. Die Aktivität wurde ermöglicht, indem der GPS-Standort des Geräts auf außerhalb Großbritanniens zurückgesetzt wurde, wo es den Fahrern möglich ist, ihre eigenen Fotos hochzuladen. Diese Lücke wurde von Uber schnell geschlossen und die erkannte Aktivität war im Vergleich zum Umfang des Uber-Betriebs verschwindend gering. Die Einführung der Gesichtserkennungstechnologie durch die Industrie war im Verhältnis zum wahrgenommenen Risiko völlig unverhältnismäßig. Dennoch wurde die Anforderung einer Echtzeit-Identifizierung im September 2020 zu einer Bedingung für die Lizenzverlängerung von Uber beim Westminster Magistrates Court.

Im Fall von Uber haben sowohl das Management der Plattform als auch TfL es versäumt sicherzustellen, dass angemessene Vorkehrungen zum Schutz der Rechte und Freiheiten der Fahrer getroffen wurden, obwohl TfL die Datenschutz-Folgenabschätzung für die Technologie im März 2020 überprüft hat Informationsfreiheitsanfrage an TfL, Zugang zu Ubers DPIA für die Echtzeit-ID-Systeme zu erhalten, aber uns wurde verweigert. Laut TfL-Berichten stammen 94 % der Fahrer von privaten Mietwagen (PHV) aus schwarzen und ethnischen Minderheiten, und die Einführung dieser Technologie, die für ihre geringen Genauigkeitsraten innerhalb dieser Gruppen bekannt ist , hat sich für schutzbedürftige Arbeitnehmer bereits in der Region als katastrophal erwiesen prekäre Beschäftigung.

Bolt hat inzwischen angekündigt , 150 Millionen Euro in KI-Systeme zur Betrugsbekämpfung für Fahrer einschließlich Gesichtserkennung zu investieren. Deliveroo kündigte an , auch Identitätsprüfungen mit Gesichtserkennung einzuführen. Ola Cabs hat auch die Gesichtserkennungserkennung als Funktion seines Guardian-Systems eingeführt , die maschinelles Lernen integriert, von dem sie behaupten, dass es ihnen ermöglicht, „täglich aus Millionen von Datenpunkten zu lernen und sich weiterzuentwickeln, um die Risikosignalisierung und sofortige Lösung zu verbessern“.

FreeNow, ein Joint Venture von Daimler und BMW, überwacht im Rahmen seines Betrugspräventionsprogramms auch die Fahrer genau. Tatsächlich haben von FreeNow beim High Court eingereichte Dokumente in einer gerichtlichen Überprüfung der Entscheidung von TfL, ihnen eine Lizenz in London zu erteilen, offenbart, dass TfL monatliche Berichte über Entlassungen von Fahrern aus verschiedenen Gründen (einschließlich „betrügerischer Aktivitäten“) zu einer Bedingung ihrer kürzliche Lizenzverlängerung. Doch die Beschreibung der zum Zwecke der Betrugsprävention verarbeiteten Daten wirft mehr Fragen auf, als die Datenschutzerklärung von FreeNow beantwortet.

In diesem Dokument erklärt Free Now, dass sie einen „Random Forest“-Algorithmus verwenden, um einen Betrugs-Score zu erstellen, mit dem sie „ die gesendeten Fahrten entsprechend priorisieren. Dies gewährleistet einen fairen und risikominimierten Versand .“ Free Now bestritt die Verwendung dieses Betrugserkennungssystems auf unsere Anfrage im Juni 2021 und behauptete, dass dieser Abschnitt der Datenschutzrichtlinie veraltet sei (siehe Fallstudie des Unternehmens in Abschnitt II des Berichts). Die Beschreibung dieses Systems ist trotz einer Aktualisierung im September 2021 in der Richtlinie geblieben.

Besonders besorgniserregend beim Einsatz dieser Systeme ist, dass sie Fraud Management mit Performance Management vermischen. Die Tatsache, dass solche „Betrugs“-Indikatoren als Variablen für die Arbeitsverteilung verwendet werden und die Verhaltensweisen, die sie erzeugen, auf der Plattform fortgesetzt werden dürfen, zeigt, dass es sich nicht um kriminelle Betrugsfälle, sondern um Kontrollmechanismen handelt, die die Leistungsfähigkeit der Arbeitnehmer bewerten gegen die undurchsichtigen Metriken der Unternehmen. Wir schlagen vor, dass jede in diesen Kontexten verwendete „Betrugs“-Terminologie auch als Teil des Spiels der Fehlklassifizierung dient, um das Arbeitsverhältnis zu verschleiern.

Überwachungsfallstudie I: Fehler bei der Gesichtserkennung

Im April 2020 führte Uber in Großbritannien ein Echtzeit-ID- Prüfsystem (RTID) ein, das eine Kombination aus Gesichtserkennung und Standortprüfung verwendet, um die Identität eines Fahrers zu authentifizieren und zu verhindern, dass der Fahrer den Zugriff auf sein Konto für die Arbeit teilt.

Das RTID-System verwendet die FACE-API von Microsoft, eine Gesichtserkennungssoftware und erfordert, dass Fahrer und Kuriere routinemäßig Selfies in Echtzeit von sich selbst aufnehmen, um die Uber-App weiterhin verwenden zu können. Das Foto wird dann mit dem Profilbild des Fahrerkontos verglichen (und in einigen Gerichtsbarkeiten mit öffentlichen Datenbanken, um „ das Entleihen von Identitäten zu verhindern oder die Identität der Benutzer zu überprüfen “).

Pa Edrissa Manjang arbeitete seit etwa einem Jahr mit Uber zusammen, als er aufgrund eines Fehlers bei der Selfie-Überprüfung deaktiviert wurde. Während Uber-Fahrer und Kuriere routinemäßig Selfies bereitstellen, werden diese nicht auf den Telefonen der Arbeiter gespeichert und sie können die Beweise ihrer Einreichungen nicht aufbewahren. Pa wurde bis zu seiner Entlassung weder verwarnt noch über Probleme informiert; das Echtzeit-ID-Verifizierungssystem schien alle seine Fotos mit einem grünen Häkchen zu bestätigen.

Nach seiner Entlassung schickte Pa zahlreiche Nachrichten an Uber, um das Problem zu beheben, und forderte insbesondere einen Menschen auf, seine Eingaben zu überprüfen. Jedes Mal, wenn Pa mitgeteilt wurde, „waren wir nicht in der Lage, zu bestätigen, dass die bereitgestellten Fotos tatsächlich von Ihnen stammen, und aufgrund anhaltender Unstimmigkeiten haben wir die endgültige Entscheidung getroffen, unsere Partnerschaft mit Ihnen zu beenden.“ Wir erhielten die fraglichen Selfies durch eine Anfrage zum Zugriff auf das Subjekt, die ergab, dass alle Fotos, die Pa eingereicht hatte, tatsächlich von ihm stammten. Dies war das erste Mal, dass es uns gelungen ist, die von einem Kurier oder Fahrer eingereichten Selfies zu erhalten. Es ist unklar, warum diese Anfrage erfolgreich war, wenn viele zuvor gescheitert sind.

Wir haben Anfang des Jahres auch an Microsoft geschrieben, um unsere Bedenken hinsichtlich der unregulierten Nutzung der FACE-API durch Uber auf seiner Plattform zu äußern. Als Reaktion darauf betonte Microsoft, dass alle an der Bereitstellung solcher Technologien beteiligten Parteien Verantwortlichkeiten haben, die Folgendes umfassen: „Einbeziehen sinnvoller menschlicher Überprüfungen, um Fälle von Fehlidentifikationen oder anderen Fehlern zu erkennen und zu beheben“. und "Um Menschen zu unterstützen, die glauben, dass ihre Ergebnisse falsch waren, und um Genauigkeitsschwankungen aufgrund von unterschiedlichen Bedingungen zu erkennen und zu beheben." Pas Fall zeigt deutlich, dass diese entscheidenden Überprüfungen bei der Verarbeitung von RTID-Bildern nicht implementiert wurden.

Pa reicht jetzt ein Verfahren gegen Uber ein, um die rassistisch diskriminierende Einführung der Gesichtserkennung anzufechten, vertreten durch Bates Wells, mit Unterstützung der Equality and Human Rights Commission, der App Drivers and Couriers Union und Worker Info Exchange.

EMBED: Papas Video

Fallstudie Überwachung II: Geolocation-Checks

Während die Verwendung fehlerhafter Gesichtserkennungssysteme zweifellos problematisch ist, haben wir auch gesehen, dass viele Fahrer nach falschen Anschuldigungen von Uber entlassen wurden, dass sie an betrügerischer Kontofreigabe beteiligt waren, nachdem zwei Geräte von Uber gleichzeitig an zwei Standorten erkannt wurden. In allen von uns analysierten Fällen haben wir festgestellt, dass das Problem damit zusammenhängt, dass der Fahrer die App aus Bequemlichkeitsgründen auf zwei Geräten installiert hat, aber nur eines der Geräte für die Arbeit angemeldet war.

Kurz vor 20 Uhr am 11. September 2020 arbeitete Aweso Mowlana für Uber in Südlondon. Er war ein mit 4,95 Sternen bewerteter Fahrer, der in über 5 Jahren bei Uber mehr als 11.500 Fahrten durchgeführt hatte. Aweso hatte gerade einen Passagier in der Nähe von Elephant and Castle abgesetzt, als er sich für eine kurze Pause abmeldete. Wie viele Fahrer hatte Aweso die App auf einem zweiten Gerät installiert, einem iPhone. An diesem Abend hatte er das iPhone zu Hause gelassen und arbeitete mit seinem anderen Telefon, einem Samsung.

Um 20:02 Uhr versuchte Aweso, sich wieder in die Uber-App einzuloggen, um sich für seinen nächsten Job zur Verfügung zu stellen. Bevor er sich wieder einloggen durfte, wurde er im Rahmen von Ubers Real Time Identity Check (RTID) aufgefordert, ein Selfie bereitzustellen. Sein Foto stimmte mit dem Referenzfoto von Uber überein, sodass er den Anmeldevorgang erfolgreich abgeschlossen hat, um seine Schicht fortzusetzen. Aber ihm unbekannt, hatten Uber-Systeme entweder sein zweites Telefon erkannt und/oder angepingt. Sein Sohn hatte versehentlich sein zweites Telefon abgenommen und es zu seiner Freundin in Uxbridge mitgenommen. Uber sagte später, sie hätten um 20:03 Uhr eine RTID-Prüfung von diesem Gerät angefordert, aber zu diesem Zeitpunkt war Aweso bereits in Süd-London online. Uber behauptet, dass die Antwort auf die ID-Prüfung am Abend gegen 23:55 Uhr vom iPhone gesendet wurde.

Am nächsten Tag teilte Uber ihm mit, dass sein Konto „aufgrund verdächtiger Anwendungsaktivitäten gekennzeichnet“ worden sei und dass sein Konto nun gesperrt werde, während „ein spezialisiertes Team dies überprüft“. Einige Zeit später entließ Uber Aweso per SMS endgültig, dass sie auf seinem Konto „Beweise für betrügerische Aktivitäten gefunden“ hätten. Uber behauptete daraufhin, den Zugriff auf sein Konto geteilt zu haben und dabei gegen die Allgemeinen Geschäftsbedingungen verstoßen zu haben. Im nächsten Monat entzog Transport for London Aweso sofort die Lizenz mit der Begründung, dass er aufgrund seiner Entlassung bei Uber nicht mehr als „tauglich und angemessen“ für eine öffentliche Lizenz befunden werden konnte.

Worker Info Exchange unterstützte Aweso dabei, einen Antrag auf Zugang zum Thema zu stellen und die erhaltenen Daten zu analysieren. Eine Datei namens „D River Detailed Device Data “ zeichnet zumindest einen Teil der Daten auf, die von Geräten zu Uber in Echtzeit gestreamt werden. Die eigene Datenschutzrichtlinie von Uber weist darauf hin, dass auf einem Gerät die App im Hintergrund oder Vordergrund geöffnet ist, auch wenn sie nicht online und bereit ist, Tarife zu akzeptieren. In mehr als einem Dutzend Fällen, in denen wir den Entzug der Führerscheine beim Magistrates Court unterstützt haben, wurde jeder Berufung stattgegeben und TfL wurde angewiesen, die Führerscheine wieder einzuführen. Aus dieser Datei konnten wir bis zu 230 Datenzeilen pro Minute sehen, die von Uber von Geräten aufgezeichnet wurden. Die Daten, die Uber von den Geräten von Aweso gesammelt hat, enthalten Geo-Standort, Akkustand, Geschwindigkeit, Kursrichtung, IMEI-Nummer usw.

Die Daten zeigten, dass das Gerät in Uxbridge an diesem Tag noch nie für die Arbeit angemeldet war, da ein Feld mit der Bezeichnung „driver_online“ das iPhone an diesem Tag zu allen Zeiten als „FALSE“ anzeigte, einschließlich der Zeit, zu der es in Uxbridge aufgezeichnet wurde. Dies ist ein Beweis dafür, dass das Gerät nicht für die Arbeit mit anderen geteilt wurde, wie von Uber und Transport for London behauptet. Uber gewährte keinen Zugriff auf personenbezogene Daten, die in beiden RTID-Prüfungen verarbeitet wurden, einschließlich der gesammelten Fotos. Die „Detaillierten Gerätedaten“ zeigen nach 20:03:43 Uhr keine weiteren Aktivitäten für das iPhone. Wir sahen um 23:55 Uhr keine Datennachweise für Geräteaktivitäten, als Uber sagte, dass es eine Antwort auf die zuvor ausgestellte ID-Überprüfung erhalten habe.

Die Erfahrung von Pa und Aweso war im vergangenen Jahr sehr verbreitet und machte einen erheblichen Teil der Fallarbeit aus, die von Worker Info Exchange und der App Drivers & Couriers Union bearbeitet wurde. In London tendierte Transport for London dazu, Fahrern, die angeblich die RTID-Prüfungen von Uber nicht bestanden haben, trotz der offensichtlichen Probleme mit dem System sofort die Lizenzen zu entziehen. Oftmals gibt es vernünftige Erklärungen für die mehrfache Gerätenutzung, die automatisch als Betrug eingestuft wird. Die eigene Datenschutzrichtlinie von Uber weist darauf hin, dass auf einem Gerät die App im Hintergrund oder Vordergrund geöffnet ist, auch wenn sie nicht online und bereit ist, Tarife zu akzeptieren. In mehr als einem Dutzend Fällen, in denen wir den Entzug der Führerscheine beim Magistrates Court unterstützt haben, wurde jeder Berufung stattgegeben und TfL wurde angewiesen, die Führerscheine wieder einzuführen.

Worker Info Exchange, Big Brother Watch und die App Drivers & Couriers Union schrieben einen gemeinsamen Brief an den Bürgermeister von London, um unsere Bedenken hinsichtlich der Abhängigkeit von Transport for London auf fehlerhafte Beweise von Uber bei der Entscheidung über den Widerruf zu äußern, und forderten dies als Vorsitzende des Verkehrssektors für den Londoner Vorstand, dass er eine Überprüfung all dieser unrechtmäßigen Widerrufe anordnet. Bisher haben weder der Bürgermeister noch TfL reagiert.

Undurchsichtiges Leistungsmanagement

Die Undurchsichtigkeit der Plattformunternehmen verhindert das Verständnis der Mitarbeiter dafür, wie algorithmische Steuerung über die Spanne kritischer Prozesse und im Laufe der Zeit integriert werden könnte. Zum Beispiel wurde Arbeitnehmern nicht die Transparenz geboten, auf die sie gesetzlich Anspruch haben, um zu verstehen, wie die Leistungsprofilierung mit der Qualität und Quantität der angebotenen Arbeit sowie den erwarteten Erträgen für diese Arbeit zusammenhängt.

Im Fall von Ola haben wir einige Kenntnisse über die Datenkategorien, die sie in ihren Arbeitsvergabesystemen sammeln und verarbeiten – wie z auf diese Variablen angewendet werden, noch die Logik der Verarbeitung.

Uber behauptet seit langem, dass sein Matching-System ausschließlich durch den Standort bestimmt wird, obwohl die eigene „Partner-Driver“-Schnittstelle etwas anderes vermuten lässt. Das Pro-Programm von Uber (für das Fahrer automatisch angemeldet werden, damit sie im Gegenzug für Vorteile und Belohnungen Anreize erhalten, Leistungsziele zu erreichen) informiert die Fahrer in vagen Worten, dass "höhere Bestätigungsraten kürzere Wartezeiten für Kunden und kürzere Abholzeiten für alle bedeuten". Fahrer“ in Anspielung darauf, dass sinkende Stellenangebote zu weniger Stellenangeboten führen werden.

Uber hat erst kürzlich mehr Transparenz über das Abgleichsystem durch eine Aktualisierung seiner Datenschutzrichtlinie geboten, in der es heißt: „Benutzer können basierend auf Verfügbarkeit, Nähe und anderen Faktoren wie der Wahrscheinlichkeit, eine Reise aufgrund ihres früheren Verhaltens oder ihrer Präferenzen anzunehmen“ zugeordnet werden. zum Zeitpunkt des Schreibens ist jedoch der Link mit weiteren Informationen zum Abgleichsystem unterbrochen, was die Entwicklung dieser Datenverarbeitung bestätigt. Eine kürzlich von uns an TfL gestellte Anfrage zur Informationsfreiheit, in der wir uns erkundigten, welche Aktualisierungen Uber in seinem Matching-System bereitgestellt hatte (wie es bei Änderungen seines Betriebsmodells erforderlich ist), ergab keine Ergebnisse, was die Verschleierung seiner algorithmischen Managementpraktiken weiter hervorhob. und das Fehlen einer behördlichen Aufsicht.

Die jüngsten Enthüllungen zu den Variablen, die die Arbeitsverteilung bestimmen, werfen auch wichtige Fragen zur Qualität der den Fahrern angebotenen Arbeitsplätze auf. Werden Fahrern mit hohen Jobakzeptanzquoten aufgrund einer ähnlichen Profilierung längere Fahrten angeboten, die zu einer höheren Bezahlung führen? Oder, um noch einen Schritt weiter zu gehen: Werden Fahrern durch das dynamische Preissystem unterschiedliche Tarife angeboten? Ob und wie algorithmische Preisgestaltung mit der Arbeitszuteilung verknüpft wird, ist in der Tat ein sensibles Thema, über das noch wenig bekannt ist.

In den letzten Jahren hat Uber die zeit- und entfernungsabhängige Preisgestaltung für Kunden durch ein Festpreismodell ersetzt, bei dem zu Beginn einer Fahrt ein Vorauspreis akzeptiert wird. Uber sagt: „Die Vorab-Preisgestaltung ist dynamisch, was bedeutet, dass der Preis in Echtzeit berechnet wird, um Angebot und Nachfrage auszugleichen.“ In jüngerer Zeit haben Fahrer berichtet, dass für einzelne Jobs sehr niedrige Tarife angeboten werden. Hier bietet sich Uber eine offensichtliche Möglichkeit, seinen Anteil am eventuell von den Passagieren gezahlten Fahrpreis zu erhöhen. Es wurden Bedenken hinsichtlich der diskriminierenden Folgen der Verwendung dieser dynamischen Preissysteme für Fahrgäste geäußert, was die Aussicht aufwirft, dass Fahrer auch einer personalisierten Echtzeit-Preisgestaltung unterliegen könnten. Hier gibt es ernsthafte ethische Probleme, wenn Betreiber schutzbedürftigen Arbeitnehmern niedrigere Preise anbieten, basierend auf einem Profiling, das ihre Bereitschaft vorhersagt, Arbeit zu unterschiedlichen Preisen anzunehmen.

Im Vereinigten Königreich scheinen solche Praktiken im Widerspruch zu den Bestimmungen von Abschnitt 1 des Employment Rights Act zu stehen, der Arbeitnehmer berechtigt, von ihrem Arbeitgeber eine klare Erklärung der Arbeitsbedingungen einschließlich der Lohnsätze zu erhalten.

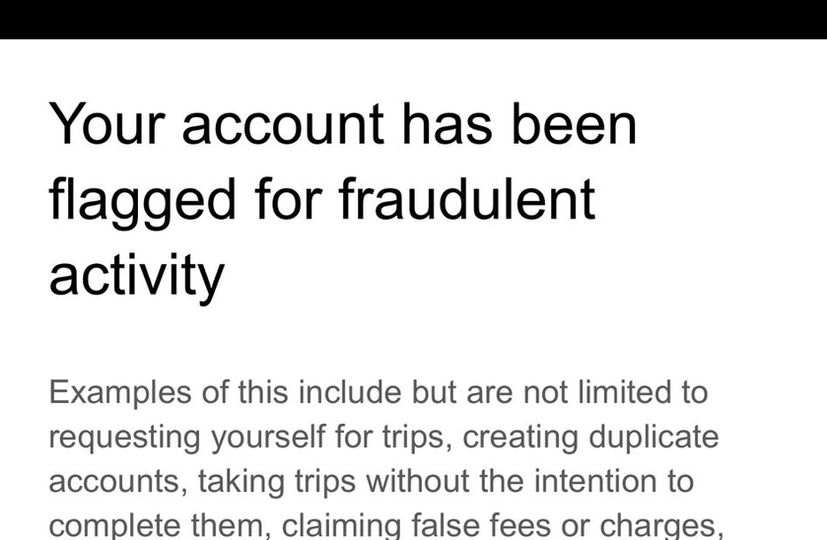

Fallstudie: Algorithmische Steuerung

Uber sendet Fahrern routinemäßig Nachrichten, wenn sie von seinen Betrugserkennungssystemen gemeldet werden, um sie davor zu warnen, dass sie ihren Job verlieren könnten, wenn sie das Verhalten fortsetzen, das das System auslöst. Die Nachrichten enthalten eine nicht erschöpfende Liste der potenziellen Auslöser, liefern jedoch keinen spezifischen Grund für den einzelnen Fahrer, der des Betrugs beschuldigt wird. Als Alexandru die zweite und letzte dieser Nachrichten erhielt, da er wusste, dass eine andere Flagge zur Entlassung führen würde, beschloss er, das Fahrer-Support-Team anzurufen, um weitere Details darüber zu erfahren, warum er das Betrugsbekämpfungssystem auslöste und was er tun konnte, um dies zu vermeiden . Durch den Anruf diskutierten Alexandru und der Support-Mitarbeiter eine Vielzahl von Situationen, die dazu geführt haben könnten, dass seine Reisen unregelmäßig erschienen, und enthüllten die begrenzten Fähigkeiten der Support-Teams, die vom System gemachten Hinweise zu entschlüsseln. Drei Monate nach diesem Anruf schickte Uber eine Entschuldigungsnachricht, dass er die Warnungen irrtümlich erhalten hatte.

Während das Gespräch in Bezug auf das Verständnis der Dilemmata, mit denen sich Autofahrer konfrontiert sehen, wenn Unternehmenspolitik und Fahrgastansprüche auseinandergehen, aufschlussreich ist, war für uns die Diskussion (25 Minuten nach dem Anruf) über einen Umweg, den Alexandru aufgrund von Straßenarbeiten genommen hat, sowie seine niedrige Stellenannahmequoten als mögliche Ursachen für seine Aufdeckung durch das Betrugsbekämpfungssystem. Nach dem Urteil des Obersten Gerichtshofs , das Uber-Fahrer Anfang dieses Jahres als Arbeitnehmer einstufte, behauptete Uber, bedeutende Änderungen an seiner Plattform vorgenommen zu haben, z Das Urteil des Obersten Gerichtshofs galt nicht für aktuelle Uber-Fahrer.

Alexandrus Erfahrung auf der Plattform widerspricht dieser Erzählung, da sich herausstellt, dass er wahrscheinlich wegen einer Abweichung von der Route gemeldet wird (trotz der Tatsache, dass Uber jetzt ein Festpreismodell betreibt, was bedeutet, dass die Fahrer solche Routenänderungen auf eigene Kosten vornehmen). und nicht genug von der ihm auf der Plattform angebotenen Arbeit annimmt. Dieser Aufruf macht unleugbar deutlich, dass die Fahrer in der Praxis immer noch so streng von Uber kontrolliert werden wie zuvor.

Neben diesen Managementpraktiken ist das oben erwähnte Pro-Programm ein weiteres Instrument, mit dem Uber die Kontrolle über seine Mitarbeiter ausübt und gleichzeitig die rechtlichen Verpflichtungen umgeht, die mit einer solchen Kontrolle verbunden sein können. Indem Uber beispielsweise bestimmte Belohnungen, die in der Aufrechterhaltung einer hohen Bewertung gipfeln, an Drittunternehmen bindet oder die Teilnahme an Preisvorteilen durch Verhaltens-Nudging als rein optional darstellt, erzeugt Uber die Illusion, die Fahrer völlig unabhängig und flexibel fahren zu lassen. Das vermeintliche freiwillige Engagement der Fahrer bei diesen Programmen führt zum Verzicht auf Rechte aus einem Arbeitsverhältnis.

EMBED: Alexandrus Video

Ausbau der Strafverfolgungsinfrastruktur

Es gibt auch Belege dafür, dass Plattformen zunehmend zu einer attraktiven Informationsquelle für Polizei- und Sicherheitsdienste geworden sind. In einer Zeugenaussage, die im September 2020 bei der Zulassungsbeschwerde von Uber beim Westminster Magistrates Court als Beweismittel vorgelegt wurde, bescheinigte Ubers General Manager aus Großbritannien und Westeuropa, Jamie Heywood, eine immer engere Beziehung zu Polizei und Sicherheitsdiensten. Dazu gehören das National Counter Terrorism Policing Network, SO15 - das Counter Terrorism Command des Metropolitan Police Service, der National Police Chiefs Council (NPCC), das College of Policing, die National Crime Agency und die British Transport Police. Ein Bereich der Zusammenarbeit betraf das Problem des Drogentransports der sogenannten County Lines. Indem er Detective Inspector Stuart Liddell vom NPCC zitierte, bezeugte Heywood eine reifende Beziehung, die auf einem ausgeklügelten Informationsaustausch basiert:

„Ich bin ermutigt durch das Engagement von Uber in dieser Angelegenheit, und weitere Arbeiten sind [im Jahr 2020] geplant, um auf der bisherigen Arbeit aufzubauen. Dies wird sich auf komplexere Aspekte der County Lines, den Informations- und Informationsfluss und die Stärkung der Beziehung zwischen dem National County Lines Coordination Centre konzentrieren.“

Tatsächlich hat der NPCC den Transport for London-Kommissar Mike Brown unterstützt, um den Lizenzantrag von Uber zu unterstützen. Chief Constable Mark Collins ging sogar so weit zu behaupten, dass eine Entscheidung, Uber die Lizenz zu verweigern, negative Auswirkungen auf die britische Polizei haben könnte.

„Hoffentlich skizziert dieser Brief die negativen Auswirkungen auf die britische Polizei, sollte die Polizei nicht auf die von mir beschriebenen Daten und Informationen zugreifen können.“

Heywood sagte auch aus, dass Collins behauptet habe, dass allein der Metropolitan Police Service jedes Jahr über 2.000 Datenanfragen an Uber gestellt habe. Dies ist eine relativ hohe Anzahl von Anfragen, wenn man bedenkt, dass laut Ubers eigenem Transparenzbericht im Jahr 2020 alle US-Strafverfolgungsbehörden zusammen knapp 5.000 Datenanfragen und alle kanadischen Strafverfolgungsbehörden zusammen nur 411 solcher Anfragen gestellt haben.

Es ist wahrscheinlich, dass das Uber-Management den Druck verspürt, mit Initiativen zur Sammlung von Informationen der Polizei zusammenzuarbeiten, insbesondere angesichts der Entscheidung von Transport for London, die Verlängerung ihrer Lizenz zweimal zu verweigern. Dies liegt daran, dass Abschnitt 17 des Crime and Disorder Act 1998 den Genehmigungsbehörden eine direkte Verantwortung auferlegt, Kriminalität und Unordnung in ihrem Gebiet zu verhindern. Damit müssen Genehmigungsbehörden wie Transport for London Partnerschaften zur Verbrechens- und Störungsreduktion (CDRP) gründen, an denen Verkehrsunternehmen wie Uber voraussichtlich teilnehmen werden.

In den gesetzlichen Leitlinien des Verkehrsministeriums für Zulassungsbehörden bekräftigt die Regierung die Erwartung eines Informationsaustauschs zwischen Polizei, Zulassungsbehörden und Verkehrsunternehmen wie Uber:

„Die Sensibilisierung der Polizeikräfte für den Wert, den die Genehmigungsbehörden den erhaltenen Informationen beimessen, insbesondere bei Informationen ohne Verurteilung, wird dazu beitragen, diese Beziehungen zu fördern und die Vorteile eines größeren Informationsaustauschs zu verstärken. Diese Beziehung kann für beide Seiten von Vorteil sein und der Polizei helfen, Kriminalität zu verhindern. Die Polizei kann von Fahrern und Betreibern wertvolle Erkenntnisse gewinnen...“

Während solche Beziehungen für die Kriminalitätsbekämpfung auf Gemeindeebene von erheblicher Bedeutung sind, scheint das Risiko für die bürgerlichen Freiheiten durch einen relativ einfachen Zugang zu umfangreichen personenbezogenen Daten von Fahrern und Passagieren, die von Plattformen wie Uber, Bolt und Ola . gesammelt und gespeichert werden, wenig beachtet worden zu sein Kabinen.

„Ich bin ermutigt durch das Engagement von Uber in dieser Angelegenheit, und weitere Arbeiten sind [im Jahr 2020] geplant, um auf der bisherigen Arbeit aufzubauen. Dies wird sich auf komplexere Aspekte der County Lines, den Informations- und Geheimdienstfluss und die Stärkung der Beziehung zwischen dem National County Lines Coordination Centre konzentrieren.“

„Hoffentlich skizziert dieser Brief die negativen Auswirkungen auf die britische Polizei, sollte die Polizei nicht auf die von mir beschriebenen Daten und Informationen zugreifen können.“

„Die Sensibilisierung der Polizeikräfte für den Wert, den die Genehmigungsbehörden den erhaltenen Informationen beimessen, insbesondere den Erkenntnissen ohne Verurteilung, wird dazu beitragen, diese Beziehungen zu fördern und die Vorteile eines größeren Informationsaustauschs zu verstärken. Diese Beziehung kann für beide Seiten vorteilhaft sein und der Polizei helfen, Verbrechen zu verhindern. Die Polizei kann wertvolle Informationen von Fahrern und Betreibern gewinnen …“

Fallstudie: Austausch von Informationen mit Strafverfolgungsbehörden

Ein weiterer Arbeiter, der uns um Hilfe bat, war ein Uber-Fahrer, der nach einer Geheimdienstanfrage der Polizei fälschlicherweise für sieben Wochen von der Uber-Plattform suspendiert wurde und einen Verlust von fast 5.000 Pfund erlitt. Im Jahr 2019 erhielt der Fahrer eine Nachricht von Uber, dass er aufgrund einer laufenden Untersuchung vorübergehend suspendiert wurde. Er erhielt weder einen Grund noch eine Frist für seine Suspendierung. Tatsächlich wurde ihm ausdrücklich gesagt, er solle Uber während der Untersuchung nicht kontaktieren. Sieben Wochen später erhielt er einen Anruf, dass er nun arbeiten könne.

Zwei Jahre später enthüllte ein Antrag auf Verlängerung des Führerscheins, den der Fahrer an TfL stellte (der eine erweiterte Offenlegungs- und Sperrdienstprüfung beinhaltet), den Grund für die Aussetzung, als TfL ihn 2019 zu der Lieferung von Medikamenten befragte und drohte, ihm seinen Führerschein zu entziehen. Geschockt von der Enthüllung verlangte der Fahrer eine Kriminalitätsnummer und erkundigte sich nicht nur bei TfL, sondern auch bei der Metropolitan Police.

Wir haben den Fahrer dabei unterstützt, Anträge auf Zugang zum Thema und Beschwerden an Uber, TfL und die Polizei zu stellen. Uber kam der Anfrage nicht nach (der Fahrer wurde darüber informiert, dass seine Anfrage an ein Spezialistenteam weitergeleitet wurde, erhielt jedoch keine weitere Antwort). Die Antwort von TfL deckte jedoch eine umfangreiche E-Mail-Kette zwischen verschiedenen Beamten auf, die versuchten, die Quelle der Informationen zu ermitteln Anfrage. Uber behauptete, sie seien von der Polizei angesprochen worden, während die Polizei keine Aufzeichnungen oder Beweise für die Ermittlung des Fahrers gefunden habe. Schließlich nannte Uber den Beamten, der die Geheimdienstanfrage gestellt hatte, aber als TfL nach Details zu dem Fall fragte, behauptete die OIC, er habe keine Erinnerung an den fraglichen Fahrer.

Die Beschwerde des Fahrers bei der Metropolitan Police wurde schließlich im Oktober 2021 beantwortet und kam zu dem Schluss, dass der Fahrer nie als Verdächtiger identifiziert wurde:

„Die Beamten wurden beauftragt, einen Verdächtigen im Zusammenhang mit einer schweren Straftat zu identifizieren. Den Beamten war der Name einer Person von Interesse mitgeteilt worden. Ich kann bestätigen, dass dies NICHT Sie waren. Am 20. Februar 2019 wurde Uber ein Datenschutzformular mit diesen benannten Verdächtigen übermittelt. Es steht mir nicht frei, hierzu nähere Angaben zu machen.

„Ihr Name wurde zu keiner Zeit in dieser Untersuchung mit Uber erwähnt. Der Beamte hat sich NICHT an Uber gewandt, um nach Informationen zu suchen, die mit Ihnen in Verbindung stehen. Als Ergebnis unserer Untersuchung hat Uber der Polizei Ihre Daten mitgeteilt. Als die Informationen von Uber zurückkamen und sie uns Ihren Namen gaben, wussten wir, dass Sie NICHT mit unseren Ermittlungen in Verbindung stehen, und es wurden keine weiteren Maßnahmen ergriffen und Sie wurden von weiteren Ermittlungen ausgeschlossen.“

„Der Beamte hat weder gegen berufliche Standards verstoßen, noch außerhalb seiner Rolle als Polizeibeamter gehandelt oder seine Macht missbraucht. Ihr Name war nicht der Zweck der Anfrage und wir haben Uber zu keinem Zeitpunkt mitgeteilt, dass Sie eine Person von Interesse sind.“

"Uber sollte vielleicht erklären, wie sie jemanden sperren, der nicht Gegenstand der ursprünglichen Anfrage war und warum Sie nach 10 Tagen nicht automatisch wieder in die App aufgenommen wurden und weiterarbeiten können."

EMBED: Ls Video

„Die Beamten wurden beauftragt, einen Verdächtigen im Zusammenhang mit einem schweren Verbrechen zu identifizieren. Den Beamten war der Name einer Person von Interesse mitgeteilt worden. Ich kann bestätigen, dass Sie das NICHT waren. Am 20. Februar 2019 wurde Uber ein Datenschutzformular mit den genannten Angaben zum Verdächtigen übermittelt. Es steht mir nicht frei, weitere Einzelheiten darüber preiszugeben.

„Ihr Name tauchte zu keinem Zeitpunkt in dieser Rechercheanfrage bei Uber auf. Der Beamte hat sich NICHT an Uber gewandt, um nach Informationen zu suchen, die mit Ihnen in Verbindung stehen. Als Ergebnis unserer Ermittlungen hat Uber der Polizei Ihre Daten zur Verfügung gestellt. Nachdem wir die Informationen von Uber erhalten und uns Ihren Namen mitgeteilt hatten, wussten wir, dass Sie NICHT mit unserer Untersuchung in Verbindung gebracht wurden, und es wurden keine weiteren Maßnahmen ergriffen und Sie wurden von weiteren Ermittlungen ausgeschlossen.“

„Der Beamte hat weder gegen professionelle Standards verstoßen noch außerhalb seiner Rolle als Polizeibeamter gehandelt oder seine Macht missbraucht. Ihr Name war nicht der Zweck der Anfrage und wir haben Uber zu keinem Zeitpunkt mitgeteilt, dass Sie eine Person von Interesse sind.“

„Uber sollte vielleicht erklären, wie sie jemanden suspendieren, der nicht Gegenstand der ursprünglichen Anfrage war, und warum Sie nach 10 Tagen nicht automatisch wieder in die App aufgenommen wurden und weiterarbeiten konnten.“

Teil II: Ausübung von Datenrechten am Arbeitsplatz: Zugang

Das Arbeitsrecht enthält nicht die notwendigen Bestimmungen, um Arbeitnehmer umfassend vor unlauteren Praktiken zu schützen, die sich aus der algorithmischen Verwaltung ergeben. Einzelpersonen haben jedoch Rechte gemäß der DSGVO, die ihre Interessen im Beschäftigungskontext schützen können. Bei der Unterstützung von Arbeitnehmern berufen wir uns auf ihre Rechte gemäß den Artikeln 15, 20 und 22, die ihnen das Recht auf Zugang zu personenbezogenen Daten , das Recht auf Datenübertragbarkeit sowie das Recht auf Unterrichtung über automatisierte Entscheidungsfindung und Logik einräumen der Verarbeitung .

Artikel 22: Betroffene Personen können keinen Entscheidungen mit rechtlicher (oder ähnlich schwerwiegender) Wirkung unterliegen, die ausschließlich auf der automatisierten Verarbeitung von Daten beruhen.

[Wenn der Verantwortliche Daten mit ausdrücklicher Zustimmung der betroffenen Person oder zur Erfüllung eines Vertrags mit ihr verarbeitet, hat die betroffene Person das Recht, eine menschliche Intervention zu erwirken, ihren Standpunkt darzulegen und die Entscheidung anzufechten]

Artikel 15: Die betroffenen Personen haben das Recht, eine Kopie ihrer personenbezogenen Daten zusammen mit zusätzlichen Informationen wie den Zwecken der Datenverarbeitung, Informationen darüber, an wen die Daten weitergegeben werden können, die Dauer der Verarbeitung usw. zu erhalten.

Artikel 20: Betroffene Personen haben das Recht, personenbezogene Daten, die sie einem Verantwortlichen bereitgestellt haben, in einem strukturierten, gängigen und maschinenlesbaren Format zu erhalten. Sie haben auch das Recht, die Daten an einen anderen Verantwortlichen zu übermitteln („portieren“). Soweit möglich, können sie verlangen, dass die Daten direkt von einem Verantwortlichen an einen anderen übermittelt werden.

Obwohl Plattformen den Arbeitnehmern Datendownloads zur Verfügung stellen, lassen diese häufig die Datenkategorien weg, die für die Abfrage der Arbeitsbedingungen am förderlichsten und notwendigsten sind (wie oben aufgeführte Lohngerechtigkeit, Arbeitsplatzzuteilung und -nutzung). In unserem Bestreben, den Anwendungsbereich zu erweitern Daten, die den Mitarbeitern zur Verfügung gestellt werden, stellen wir spezifische Zugangs- und Übertragbarkeitsanfragen, die das gesamte Spektrum der von Gig-Plattformen gesammelten Daten abdecken. Bei diesen Anfragen versuchen wir, drei verschiedene Arten von Daten zu erhalten:

1) Eingabedaten - von den Arbeitern selbst bereitgestellt

2) Beobachtungsdaten – basierend auf der Nutzung von Plattformen durch die Arbeiter (dh Rohmess- und Überwachungsdaten wie Standortdaten, Telematik usw.)

3) Abgeleitete Daten – abgeleitet aus der Analyse von Beobachtungsdaten (z. B. Profilierung des Arbeitnehmerverhaltens in Form von Risiko- und Betrugsbewertungen)

Artikel 22: Betroffene Personen können keinen Entscheidungen mit rechtlicher (oder ähnlich erheblicher) Wirkung unterworfen werden, die ausschließlich auf der automatisierten Verarbeitung von Daten beruhen.

[Verarbeitet der Datenverantwortliche Daten mit ausdrücklicher Zustimmung der betroffenen Person oder zur Erfüllung eines Vertrags mit ihr, hat die betroffene Person das Recht, eine menschliche Intervention zu verlangen, ihren Standpunkt darzulegen und die Entscheidung anzufechten.]

Artikel 15: Betroffene Personen haben das Recht, eine Kopie ihrer personenbezogenen Daten zusammen mit ergänzenden Informationen wie den Zwecken der Datenverarbeitung, Informationen darüber, an wen die Daten weitergegeben werden können, die Dauer der Verarbeitung usw. zu erhalten.

Artikel 20 : Betroffene Personen haben das Recht, personenbezogene Daten, die sie einem Verantwortlichen bereitgestellt haben, in einem strukturierten, gängigen und maschinenlesbaren Format zu erhalten. Sie haben auch das Recht, die Daten an einen anderen Verantwortlichen zu übermitteln („portieren“). Soweit möglich, können sie verlangen, dass die Daten direkt von einem für die Verarbeitung Verantwortlichen an einen anderen übermittelt werden.

Eingabedaten

Wird von den Arbeitern selbst bereitgestellt

Beobachtete Daten

Basierend auf der Nutzung von Plattformen durch Arbeitnehmer (d. h. Mess- und Überwachungsrohdaten wie Standortdaten, Telematik usw.)

Abgeleitete Daten

Abgeleitet aus der Analyse von Beobachtungsdaten (z. B. Profilerstellung des Arbeitnehmerverhaltens in Form von Risiko- und Betrugsbewertungen)

Diese Datenkategorien werden in Leitfäden und Datenschutzrichtlinien oft ausdrücklich erwähnt, aber nicht an Fahrer weitergegeben, wenn sie ihre Daten herunterladen oder Zugriffsanfragen stellen. Wenn Arbeitnehmer nach diesen Informationen suchen, zielen Gig-Plattformen unserer Erfahrung nach darauf ab, den Prozess schwierig und belastend zu gestalten, indem sie sich an einer Vielzahl von nicht konformen Verhaltensweisen beteiligen. Mitarbeiter, die umfassende Daten suchen, müssen sich durch äußerst komplexe und hinderliche Website-Architekturen navigieren und weitere Frustrationsbemühungen von Supportmitarbeitern umgehen, die einfache Verwaltungsprozesse unnötig verlängern oder automatisierte Antworten liefern, die Anfragen nicht angemessen beantworten. Diese Verfahren können als „ dunkle Muster“ beschrieben werden, die darauf abzielen, Arbeitnehmer davon abzuhalten, ihre Rechte als betroffene Personen auszuüben. In den Fällen, in denen Mitarbeiter ihre Daten abrufen können, fehlen häufig erhebliche Segmente oder sie werden in inkonsistenten und nicht maschinenlesbaren Formaten präsentiert, was eine Analyse praktisch unmöglich macht. Diese Akte der Obstruktion zwingen Arbeiter zu wiederholten Anfragen, die Unternehmen letztendlich als Grund dafür verwenden, sie zu diskreditieren.

In allen DSAR-Rückmeldungen, die wir gesehen haben, hat kein Arbeitgeber einen vollständigen und ordnungsgemäßen Bericht über die automatisierte Verarbeitung personenbezogener Daten abgegeben. Dies ist besonders wichtig in Bereichen, die die Beschäftigungssicherheit bestimmen können, wie z. B. Arbeitsverteilung, Leistungsmanagement, Sicherheit und Schutz, wie in diesem Bericht erörtert. Uber und Ola haben vor Gericht argumentiert, dass die Sicherheit ihrer Plattform gefährdet sein könnte, wenn die Logik einer solchen Datenverarbeitung ihren Mitarbeitern offengelegt würde. Unserer Ansicht nach können Sicherheit und Schutz nur verbessert werden, wenn Plattformen transparent Regeln und Leistungsstandards festlegen, anstatt sich auf verdeckte Überwachung und fristlose Entlassungen zu verlassen, die einige der Hauptmotive für DSARs sind.

Angesichts dieser ablehnenden Haltung gegenüber DSARs ist es auch wichtig zu beachten, dass viele Fahrer Vergeltungsmaßnahmen durch Unternehmen befürchten, wenn sie Anfragen stellen. Wenn Gig-Plattformen unangemessene und langwierige Identitätsprüfungen als Reaktion auf Auskunftsanfragen von Personen durchführen, werden Arbeitnehmer leicht entmutigt und eingeschüchtert (siehe E-Mails, die Uber an Fahrer sendet, in den Fallstudien zu Plattformreaktionen). In den zahlreichen Interviews, die wir mit Fahrern geführt haben, wurde häufig darauf hingewiesen, dass langwierige Bestätigungsnachrichten, die in komplexer Rechtssprache übermittelt werden, davon abhalten, Anfragen zu verfolgen. Das Beharren auf der Bitte ist für viele Autofahrer gleichbedeutend damit, den Kopf über die Brüstung zu heben und seine Existenz und Arbeitsplatzsicherheit aufs Spiel zu setzen.

Diese Wahrnehmung ergibt sich oft aus Erfahrungen mit anhaltender Ausbeutung und Unsicherheit, die auf die begrenzten Fähigkeiten und Kenntnisse der Arbeitnehmer bei der Ausübung demokratischer Rechte zurückzuführen sind, sei es im Vereinigten Königreich als Einwanderer oder in ihren Heimatländern, die in vielen Fällen autoritäre Neigungen aufweisen. In einer Belegschaft, die bereits stark fragmentiert und anfällig für wirtschaftliche Prekarität ist, in der das Sicherheitsbedürfnis den Wunsch, Ungerechtigkeiten anzufechten, weit überwiegt, kann die Auswirkung dieser Art von feindseligem Verhalten von Unternehmen nicht hoch genug eingeschätzt werden. Diese Unsicherheit wird zusätzlich durch die Undurchsichtigkeit der Verwaltungsalgorithmen verstärkt. In Ermangelung klarer Erklärungen zur Funktionsweise von Black-Box-Arbeitsverteilungs- oder Leistungsmanagementsystemen wird es für Arbeitnehmer sehr einfach, sich auf spekulative oder sogar konspirative Gedanken darüber einzulassen, wie sich ihre Interaktionen mit der Plattform auf ihre Arbeit auswirken. Dies kann sich dann in ein allgemeines Misstrauen gegenüber anderen Institutionen und eine Abneigung gegen organisierende Aktivitäten ausweiten. Dies sind starke und anhaltende Schwachstellen in der gesamten Belegschaft, die besondere Aufmerksamkeit und Schutz erfordern.

Fallstudien: Individuelle DSARs

Die folgenden Fallstudien zeigen einige der Möglichkeiten, wie Uber bei der Beantwortung von Datenanfragen von Arbeitnehmern obstruktives und nicht konformes Verhalten zeigt. Bezeichnenderweise können diese Beispiele nicht als Ausnahmen oder isolierte Ereignisse von unerfahrenen Support-Mitarbeitern wegerklärt werden. Diese Antworten stellen die Standardverfahren dar, die von Uber befolgt werden, wenn Arbeitnehmer ihre Datenzugriffsrechte ausüben möchten.

Rundschreiben und sinnlose Antworten

M. Ahmed ist ein ehemaliger Uber-Fahrer und Uber Eats-Kurier. Im Oktober 2020 wurden sowohl sein Uber-Fahrer- als auch sein Kurierkonto gesperrt und im Februar 2021 wurde sein Fahrerkonto deaktiviert. Dies betraf auch sein UberEats-Kurierkonto, das anschließend deaktiviert und gelöscht wurde.

Als Herr Ahmed nach dem Grund seiner Entlassung fragte, erhielt er widersprüchliche Antworten. Uber zitierte zunächst fehlgeschlagene Gesichtserkennungsprüfungen und behauptete später, die Deaktivierung sei auf ein hohes Volumen an nicht zugestellten Bestellungen zurückzuführen. Während der gesamten Korrespondenz sprachen sie ihn mit dem falschen Namen an und akzeptierten schließlich, dass die Nachrichten bezüglich der fehlgeschlagenen Echtzeit-ID-Prüfungen irrtümlich gesendet wurden. Die Verwirrung um seine Entlassung veranlasste ihn, nach seinen persönlichen Daten zu suchen.

In den letzten Monaten hat Herr Ahmed versucht, die mit seinem deaktivierten Uber Eats-Konto verbundenen Daten abzurufen. Herr Ahmed versuchte erstmals am 15. April 2021, seine Daten über das Formular „Datenschutzanfrage ohne Uber-Konto einreichen“ auf der Uber-Website abzurufen, da sein Konto nach seiner Kündigung gelöscht worden war.

Als Antwort erhielt er eine E-Mail von Uber, in der es hieß: „Unsere Datenschutzerklärung schränkt unsere Möglichkeit ein, Kontoinhaberinformationen weiterzugeben. Wir können diese Informationen nur durch den in unseren Richtlinien für Datenanfragen beschriebenen Prozess bereitstellen.“ Dieser Vorgang bezieht sich auf die Anmeldung beim Konto und die Anforderung innerhalb des Kontos. „Dennoch sind wir in der Lage, über die entsprechenden Kanäle mit Ihnen zusammenzuarbeiten, um bei Bedarf zu helfen.“

Herr Ahmed schrieb zurück und bat um Rat, wie er auf die Daten zugreifen könnte, die mit seinem jetzt gelöschten Konto verbunden sind. Er erklärte, dass er aus der mit seinem Uber Eats-Konto verknüpften E-Mail schrieb und dass er auch die mit diesem Konto verknüpfte Handynummer angegeben habe. Er fügte hinzu, dass er gerne weitere Informationen zur Bestätigung seiner Identität zur Verfügung stellen würde.

Darauf erhielt Herr Ahmed eine Antwort, in der es hieß, dass seine Besorgnis nicht mit diesem Konto zusammenhängt. Schreiben Sie uns bitte von dem betreffenden Konto aus oder melden Sie sich über help.uber.com mit den entsprechenden Anmeldeinformationen an und teilen Sie uns das Problem mit, damit wir Ihnen weiterhelfen können.“

Herr Ahmed schrieb zurück und fügte ein Bild der Onboarding-E-Mail an, die ihm am 03. Juli 2020 von Uber gesendet wurde, um zu beweisen, dass er von dem entsprechenden Konto aus schrieb. Am 19. April 2021 erhielt er die gleiche Nachricht, dass seine „Bedenken nicht mit diesem Konto zusammenhängen“.

Herr Ahmed schrieb zurück und erklärte erneut, dass er nicht auf sein Konto zugreifen kann und dass er die Details zu seinem Uber Eats-Konto angegeben hat. Er bat um Anleitung, welche anderen Informationen er zur Verfügung stellen könnte, um sich zu identifizieren. Er erhielt keine Antwort.

Zu diesem Zeitpunkt suchte Herr Ahmed Hilfe bei der App Drivers and Couriers Union und Worker Info Exchange und wir eskalierten das Problem mit Uber. Am 11. Mai 2021 erhielt Herr Ahmed eine E-Mail von Uber, in der er gebeten wurde, die von uns in seinem Namen gestellte Anfrage zu bestätigen. Er hat uns schriftlich bestätigt, dass er uns sein Mandat erteilt hat und dass er seine Anfrage bearbeiten möchte.

Am 14. Mai 2021 wurde Herrn Ahmed von Uber ein Formular zur Identitätsprüfung zugesandt, um die Anfrage zu bearbeiten. Das Formular verlangte die gleichen Details, die er bereits in seinen vorherigen Nachrichten mitgeteilt hatte, wie E-Mail, Telefonnummer, Wohnsitzland und die Art der angeforderten Daten. Es wurde auch nach seiner „aktuellen Bewertung“ gefragt – die jedoch nicht zutreffend war, da er keinen Zugriff mehr auf sein Konto hatte. Herr Ahmed schickte das Formular an Uber, erhielt jedoch keine Antwort.

Am 20. Mai 2021 schrieb Herr Ahmed an Uber, um eine Bestätigung über die Bearbeitung seiner Anfrage zu erhalten. Er erhielt keine Antwort.

Zum Zeitpunkt des Schreibens hat Herr Ahmed seine Daten noch nicht erhalten. Auch wurde ihm nicht erklärt, warum seine Anfrage nicht bearbeitet wird.

Inkonsistente und inkrementelle Datenfreigabe

Herr Amini ist ein ehemaliger Uber-Fahrer, der im November 2020 nach einer fehlgeschlagenen Geolokalisierungsprüfung deaktiviert wurde. Uber meldete seine Entlassung bei TfL, der daraufhin Herrn Aminis private Anmietungslizenz entzog und ihn ohne Arbeit zurückließ. Um den Grund für seine Entlassung zu verstehen, versuchte Herr Amini, seine Daten von Uber zu erhalten.

Herr Amini stellte seine erste Anfrage am 13. April 2021 und forderte alle seine personenbezogenen Daten an, einschließlich der 26 Datenkategorien, die in dem von Uber erstellten Leitfaden beschrieben sind , sowie der Bilder, die er als Reaktion auf die Echtzeit-ID-Prüfung eingereicht hatte. Er gab an, dass er Daten über die gesamte Zeit wünschte, in der er als Uber-Fahrer tätig war.

Am 05. Mai 2021 erhielt Herr Amini eine Antwort auf seinen Antrag, die angegebenen Daten deckten jedoch nur die 30 Tage vor seinem Antrag ab. Da Herr Amini in diesem Zeitraum nicht für Uber arbeiten konnte, waren viele der bereitgestellten Datensätze leer.

Mai 2021 stellte Herr Amini einen weiteren Antrag, in dem er erneut erklärte, dass er Daten über den gesamten Zeitraum, in dem er mit Uber zusammengearbeitet hat, angefordert habe, und fügte insbesondere hinzu, dass er bis November 2020 gesammelte Daten wünschte.

Am 28. Mai 2021 erhielt Herr Amini eine Antwort. Er erhielt jedoch erneut unvollständige Daten. Insbesondere war die von Uber bereitgestellte CSV-Datei mit Treiberdetaillierten Gerätedaten vollständig leer.

Am 02.06.2021 stellte Herr Amini einen weiteren Antrag mit der Bitte um die fehlenden Daten. Am 10. Juni 2021 erhielt er seine detaillierten Gerätedaten für den Fahrer für November 2020. Obwohl er angegeben hatte, dass er alle in den von Uber erstellten Leitlinien aufgeführten Datenfelder haben wollte, wurde ihm ein eingeschränkter Datensatz zugesandt, in dem 32 der 50 Daten ausgelassen wurden Felder.

Verschleierung und Widerstand

Herr Majid ist ein ehemaliger Uber-Fahrer, der im September 2020 nach einer fehlgeschlagenen Geolokalisierungsprüfung deaktiviert wurde. Wie im Fall von Herrn Amini meldete Uber die Entlassung von Herrn Majid bei TfL, was dazu führte, dass seine private Mietlizenz widerrufen wurde. Um die Grundlage der Vorwürfe von Uber zu verstehen, versuchte er, an seine Daten zu gelangen.

Herr Majid kontaktierte Uber erstmals am 2. Juni 2021, um seine Daten anzufordern. Als Antwort erhielt er eine Nachricht, in der er gebeten wurde, sein Anliegen kurz zu schildern. Herr Majid antwortete mit seiner Anfrage nach 3 Datenkategorien (von den 26 Kategorien, die in den Leitlinien von Uber aufgeführt sind) für September 2020.

Juni 2021 erhielt Herr Majid eine Nachricht von Uber, in der es hieß: „Unsere Datenschutzrichtlinie erlaubt es uns nicht, Änderungen vorzunehmen oder personenbezogene Daten ohne Kontakt über die mit Ihrem Partnerkonto verknüpfte E-Mail-Adresse zu besprechen. Um Ihnen bei Ihrem speziellen Problem zu helfen, müssen Sie die E-Mail-Adresse verwenden, die mit diesem Konto verknüpft ist. Danke für Ihr Verständnis."

Zu diesem Zeitpunkt kontaktierte uns Herr Majid verwirrt, da er Uber von seinem Konto aus geschrieben hatte. Er schrieb zurück und erklärte Uber, dass er sie kontaktiert habe, indem er sich bei seinem Fahrerkonto angemeldet habe, also schreibe er definitiv von der richtigen E-Mail-Adresse. Er fragte, ob er eine zusätzliche Identifizierung/Dokumentation vorlegen könne, um Uber zu versichern, dass er derjenige war, der die Anfrage gestellt hatte.

Als Antwort erhielt er die gleiche Nachricht von Uber: „Hallo ... danke für deine Nachricht. Wir wissen, dass du gerne Informationen zu einem Uber-Konto besprechen möchtest. Wenn Sie der Kontoinhaber sind, schreiben Sie uns bitte von der E-Mail-Adresse aus, die mit Ihrem Partner-Driver-Konto verknüpft ist, und wir können Ihnen sofort helfen.“

Am 09. Juni 2021 hat sich Herr Majid bei seinem Partnerkonto angemeldet und einen Chat mit dem Uber-Support gestartet, um es erneut zu versuchen. Seine Nachricht, ob er eine Betreff-Zugriffsanfrage stellen könne, wurde ignoriert.

Am 14. Juni 2021 kontaktierte Herr Majid Uber erneut und teilte mit, dass er eine Frage zu seinem Fahrerpartnerkonto habe. Er erhielt eine Antwort von Uber: „Danke für Ihre Kontaktaufnahme … Wir haben die Gelegenheit genutzt, Ihr Anliegen zu prüfen und können feststellen, dass Sie sich bereits zuvor wegen dieses Problems an uns gewandt haben. Eines unserer Teammitglieder untersucht derzeit Ihr Problem und wir werden uns so schnell wie möglich bei Ihnen melden. Um unsere Kommunikation zu rationalisieren und Verwirrung zu vermeiden, werden wir diesen Kontakt schließen.“

Am 16. Juni 2021 kontaktierte Herr Majid Uber erneut und teilte mit, dass er aufgefordert wurde, sich bei seinem Konto anzumelden, um eine Anfrage zu stellen, und er wollte daraufhin Einzelheiten zu seiner Anfrage mitteilen. Er erhielt am folgenden Tag eine Antwort und übermittelte anschließend am 18. Juni 2021 die Details der Anfrage (der drei oben aufgeführten Datensätze).

Nachdem Herr Majid keine Antwort erhalten hatte, kontaktierte er Uber am 28. Juni 2021 erneut und bat um Bestätigung, dass seine Anfrage bearbeitet wurde. Am 01.07.2021 erhielt er eine Antwort, in der ihm mitgeteilt wurde, dass sein Anliegen beim spezialisierten Team vorgetragen worden sei und dieses sich für weitere Untersuchungen mit ihnen in Verbindung setzen werde.

Am 02. Juli 2021 erhielt Herr Majid eine Antwort auf den von ihm am 09. Juni 2021 initiierten Nachrichten-Thread. In dieser Nachricht hieß es, dass Uber verlangt, dass Anfragen persönlich an die Postanschrift von Uber BV in den Niederlanden zugestellt werden.

Herr Majid hat keine weiteren Mitteilungen erhalten.

„Die Frage nach Algorithmen ist zentral für das Thema Uberisierung. Zu oft spielt der Algorithmus die eigentliche Rolle des Chefs, da die Technologie neue Mittel zur Unterordnung der Arbeiter bereitstellt. Es besteht offensichtlich ein Bedarf an Transparenz des algorithmischen Managements, aber über diese Transparenz hinaus besteht ein Bedarf an einem Co-Management des Algorithmus. Arbeitnehmervertreter müssen sich an ihrer Entwicklung beteiligen können.“

Leïla Chaibi, MdEP

Fallstudien: Plattformreaktionen auf

Batch-Anfragen nach Worker Info Exchange

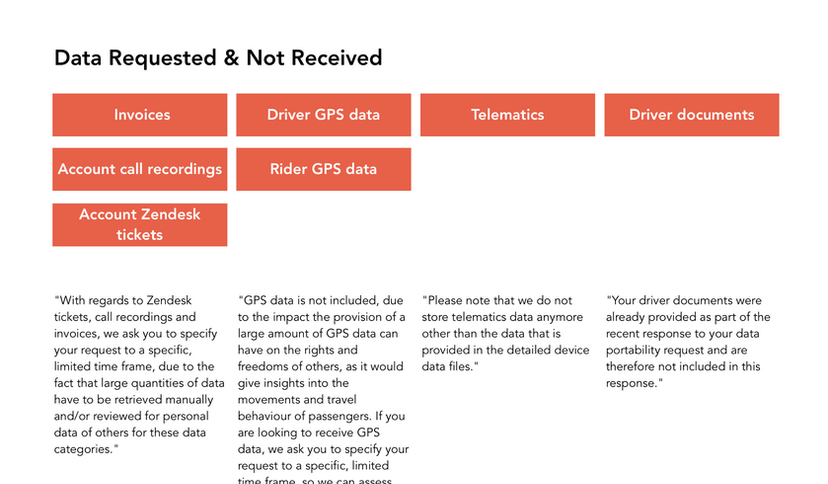

Wie die obigen Beispiele zeigen, können die einzelnen Anfrageprozesse extrem zeit- und kapazitätsintensiv sein. Wir haben daher Prozesse geschaffen, die es uns ermöglichen, im Auftrag von Fahrern Batch-Anfragen zu stellen und dieses komplexe Verfahren zu rationalisieren. Wir haben ein System eingerichtet, das die von Scrive entwickelte elektronische Signatur- und ID-Lösung verwendet, um ein gesetzliches Mandat von Arbeitnehmern zu erhalten, in ihrem Namen Anfragen zu stellen. Diese Lösung beinhaltet auch eine von Onfido durchgeführte ID-Verifizierung (derselbe ID-Verifizierungsdienst, der von Uber verwendet wird), um sicherzustellen, dass sowohl wir als auch der Datenverantwortliche die Identität des Antragstellers sicher sind und deren Datenschutz wahren. Die Identitätsprüfung erfordert, dass die Arbeitnehmer eines der folgenden Ausweisdokumente vorlegen: Reisepass, Führerschein, Personalausweis oder Aufenthaltserlaubnis. Durch diesen Prozess wird für jede Person ein individuelles Einwilligungsdokument erstellt, das elektronisch versiegelt und durch verdeckte Anhänge mit einem Beweisprotokoll zum Nachweis der Echtheit des Identifizierungsverfahrens verifizierbar ist. (Scrive bietet auch einen Service zur Überprüfung der Integrität der Einwilligungsformulare, der in den Dokumenten verlinkt ist.) Wir senden diese Dokumente zusammen mit einer Tabelle mit den Namen, E-Mails, Adressen und Telefonnummern der Arbeitnehmer, die Anfragen stellen.

Einige Unternehmen reagierten offen und kooperativ auf Anfragen, die im Rahmen dieses Verfahrens gestellt wurden, während andere ein weitaus obstruktiveres und feindseligeres Verhalten zeigten. Auch wenn Unternehmen den Aufforderungen nachgekommen sind, gab es jedoch immer wieder Probleme bei der Ermittlung der genauen erfassten Datenkategorien sowie bei der Beschaffung aller angeforderten Daten in einem strukturierten und maschinenlesbaren Format. Nur wenige Unternehmen waren in der Lage, Leitfäden mit klaren Beschreibungen der Datenkategorien bereitzustellen, und die Daten, die wir erhalten haben, weisen oft erhebliche Unstimmigkeiten mit der in den Datenschutzrichtlinien beschriebenen Verarbeitung auf. Im Allgemeinen haben Unternehmen eine Tendenz gezeigt, die Datenpraktiken zu leugnen, die sie nicht offenlegen möchten. In einem Fall behauptete ein Unternehmen, dass die in seiner Datenschutzrichtlinie erwähnte Betrugsbewertung nur im Rahmen eines Prozesses durchgeführt worden sei und dass die Datenschutzrichtlinie veraltet sei. Ein anderer verwies uns auf ein Dokument, von dem sie behaupteten, es habe dasjenige ersetzt, auf das wir unsere Anfrage stützten, obwohl beide Dokumente am selben Tag aktualisiert wurden.