Inhoud

Inhoud

Samenvatting

Deel I: Misclassificatie 2.0: Gecontroleerd door Algoritme

Surveillance Casestudy I: gezichtsherkenning mislukt

Surveillance Casestudy II: Geolocatiecontroles

Ondoorzichtig prestatiebeheer

Casestudy: Algoritmische controle

Uitbreiding van de wetshandhavingsinfrastructuur

Casestudy: informatie delen met wetshandhaving

Deel II: Gegevensrechten uitoefenen op het werk: toegang

Casestudy's: individuele DSAR's

Circulaire en zinloze antwoorden

Inconsistent en incrementeel delen van gegevens

Casestudy's: Platformreacties op batchverzoeken door WIE

Deel III: Gegevensrechten uitoefenen op het werk: geschillen

Uber-chauffeurs v Uber I (algemene transparantieverzoeken)

Ola drivers v. Ola (algemene transparantieverzoeken)

Uber-chauffeurs v. Uber II (transparantie over geautomatiseerde besluitvorming)

Beroepszaken tegen vergunningverlening in Londen

Conclusie: de weg vooruit voor het uitoefenen van digitale rechten op het werk?

Samenvatting

Worker Info Exchange is opgezet om de toegang tot en het verzamelen van gegevens te vergemakkelijken om onderhandelingsmacht op te bouwen door de oprichting van een gegevensvertrouwen.

Dit was een reactie op de ontwikkeling van nieuwe algoritmische managementpraktijken die diepe informatieasymmetrieën en uitbuiting van werknemers veroorzaakten.

Worker Info Exchange heeft tot doel de convergentie van gegevens- en arbeidsrechten aan te pakken door een beroep te doen op de AVG Artikel 15, 20 en 22 rechten in arbeidscontexten.

Dit doel wordt ernstig belemmerd door wijdverbreide niet-naleving van de AVG in de gig-industrie.

We hebben de afgelopen acht maanden meer dan 500 toegangsverzoeken van betrokkenen ingediend bij zeven verschillende platforms voor het delen van ritten, waaronder Amazon Flex, Bolt, Deliveroo, Free Now, Just Eat, Ola en Uber.

De toegang tot gegevens wordt uitgedaagd door bedrijven die donkere patronen toepassen en opzettelijk misbruik maken van de fragmentarische AVG-implementatie, wat werknemers ertoe aanzet problemen voor de rechtbank op te lossen.

Het verzamelen van gegevens door gig-platforms is buitensporig en leidt tot een onevenredig en onverklaarbaar toezicht op werknemers, evenals een groeiende infrastructuur voor wetshandhaving.

Er is geen transparantie over de algoritmische managementsystemen die worden gebruikt. Bedrijfsverhalen over welke technologieën worden gebruikt en hoe, zijn inconsistent en onbetrouwbaar.

© 2021 Worker Info Exchange

© 2021 Worker Info Exchange

Invoering

Het afgelopen jaar betekende een keerpunt voor gig-platformwerkers in de realisatie van hun arbeids- en digitale rechten. De praktijk van digitaal gemedieerd werk heeft geleid tot een convergentie van arbeids- en gegevensbeschermingsrechten en de toenemende rechtszaken en belangenbehartiging door werknemers hebben op deze gebieden resultaten opgeleverd. In heel Europa hebben rechtbanken verschillende belangrijke uitspraken gedaan waarin de uitbuitende rol van algoritmische beheerpraktijken door gig-platforms wordt erkend en tegelijkertijd het gebrek aan eerlijkheid en transparantie in dergelijke geautomatiseerde systemen wordt veroordeeld.

In Italië oordeelde de rechtbank van Bologna dat het beoordelingssysteem van Deliveroo werknemers had gediscrimineerd, terwijl de gegevensbeschermingsautoriteit, Garante, twee AVG-boetes aan Deliveroo en Glovo had opgelegd omdat ze de werking van hun algoritmen voor taaktoewijzing en prestatiebeheer niet adequaat openbaar hadden gemaakt.

Spanje heeft de eerste wetgeving aangenomen om te proberen AI op het gebied van werkgelegenheid te reguleren, waarbij zowel de status van werknemer voor gig-werkers wordt vastgesteld als het recht om geïnformeerd te worden over de regels en parameters van de algoritmen waaraan ze zijn onderworpen - een stortvloed aan klachten ontketend. Dit vloeide voort uit weer een andere rechtszaak tegen Glovo die bij het Spaanse Hooggerechtshof belandde.

Naast deze spraakmakende beslissingen concludeerde het Britse Hooggerechtshof dit jaar ook dat Uber-chauffeurs partij waren bij een vervoersdienst die " zeer strak gedefinieerd en gecontroleerd wordt door Uber " en een duidelijke arbeidsrelatie verraadde, waarvan het bedrijf beweerde dat deze niet bestond in haar streven om de werknemers (verkeerd) te classificeren als onafhankelijke contractanten. Het is veelbetekenend dat het bewijs van deze relatie afkomstig is van de gegevensgestuurde systemen die rideshare-platforms gebruiken om hun personeelsbestand te beheren. Enkele van de problemen die door het Britse Hooggerechtshof naar voren werden gebracht, hadden betrekking op het management van chauffeurs door middel van algoritmische monitoring van de acceptatiegraad van banen, routekeuzes, rijgedrag en klantbeoordelingen. Hoewel er meer erkenning is voor algoritmisch management, beschermen de recente vorderingen bij de rechtbanken de werknemers niet volledig tegen de schade ervan. De arbeidsstatus van lid (b) die aan Uber-chauffeurs wordt gegeven als gevolg van de uitspraak van het Hooggerechtshof, is een intermediaire status tussen aannemer en werknemer en is nog steeds onvoldoende om hen te beschermen tegen bijvoorbeeld onterechte ontslagen.

Onze ervaring suggereert dat deze algoritmische beheertools, met de toevoeging van intensievere surveillancepraktijken, waarbij werknemers voortdurend worden gecontroleerd op mogelijke fraude of wangedrag, resulteren in een zeer uitbuitende werkomgeving. We zien een buitensporig aantal geautomatiseerde ontslagen in de hele gig-industrie, waarvan vele volgens ons onwettig zijn volgens artikel 22 van de Algemene Verordening Gegevensbescherming (AVG) . Artikel 22 biedt werknemers enige beperkte bescherming tegen de nadelige gevolgen van geautomatiseerde besluitvorming en profilering, door middel van het recht om menselijke tussenkomst te verkrijgen en de beslissing aan te vechten. Artikel 15 van de AVG garandeert het recht om geïnformeerd te worden over het bestaan van dergelijke geautomatiseerde besluitvorming en om zinvolle informatie te krijgen over de logica van de verwerking.

Op basis van deze rechten werd Worker Info Exchange opgericht met de missie om gig-werkers te ondersteunen bij het navigeren door deze complexe en onder gereguleerde ruimte. Het doel en de opdracht van ons werk is om te testen of deze AVG-instrumenten kunnen worden gebruikt om oneerlijke arbeidspraktijken aan te pakken en de reikwijdte van de gegevens die beschikbaar worden gesteld aan individuen in hun hoedanigheid als werknemers uit te breiden. Met andere woorden, het is onze ambitie om toegang tot gegevens te gebruiken als een methode om collectieve arbeidskracht op te bouwen voor het testen van verhaalmechanismen in een digitaal gemedieerde arbeidsmarkt.

Wanneer de arbeidsrelatie tussen het klusplatform en de werknemer wordt uitgevoerd door middel van uitgebreide gegevensverzameling en -analyse, worden arbeidsrechten onlosmakelijk verbonden met de uitoefening van gegevensrechten. Gig-platforms zorgen voor controle over werknemers door een informatieasymmetrie te behouden, en gegevenstoegang kan een middel zijn om de (on)balans in de macht bloot te leggen die wordt gegenereerd door de informatiekloof tussen gig-platforms en hun werknemers. Door toegang te krijgen tot persoonlijke gegevens kunnen werknemers onafhankelijke evaluaties maken over hun arbeidsomstandigheden en vragen beantwoorden over hun loonberekeningen, de kwaliteit en kwantiteit van het aangeboden werk, en kunnen ze de gronden voor ongunstig prestatiebeheer aanvechten, waaronder schorsing en ontslag.

Ons doel bij het vergemakkelijken van gegevenstoegang is het creëren van collectieve gegevensopslag om een beter begrip van arbeidsomstandigheden en bijgevolg onderhandelingsmacht te ontwikkelen. In de afgelopen jaren zijn er een aantal opmerkelijke initiatieven ontstaan met vergelijkbare doelen, maar met verschillende methoden voor het ophalen van gegevens. Sommige projecten op dit gebied voeren hun eigen gegevensverzameling en analyses uit over verdiensten en prestaties om de eerlijkheid van de arbeidsvoorwaarden te beoordelen (bijvoorbeeld Driver's Seat Coop en WeClock, Deze bieden allemaal unieke inzichten in de kluseconomie en moeten worden beschouwd als een continuüm van datapraktijken. We hebben dit probleem aangepakt door te eisen dat platforms de gegevens delen waar werknemers wettelijk recht op hebben, maar dit heeft extra obstakels geïntroduceerd voor het grotere doel van het verzamelen van gegevens. We hebben deze route gekozen omdat we normen en precedenten wilden scheppen in de wetgeving inzake gegevensbescherming, maar ook omdat we van mening zijn dat er bepaalde soorten informatie zijn die alleen kunnen worden verkregen door de gegevens rechtstreeks bij de platforms op te vragen.

We hebben geconstateerd, met name in het geval van door surveillance aangewakkerde beschuldigingen van onregelmatige activiteiten en fraude, dat het nodig is om over de gegevens van de bedrijven te beschikken om de beschuldigingen te begrijpen en te betwisten. Gegevenstoegang kan ons helpen de inconsistenties in de verhalen van platformbedrijven op te sporen en de bewijslast van de werknemers terug naar de platforms te verplaatsen. Vanuit dit perspectief is het streven om platformgegevens te eisen uiterst succesvol gebleken bij het oplossen van tal van arbeidsgeschillen. De eenvoudige demonstratie van de weigering van platforms om persoonlijke gegevens te verstrekken heeft verschillende intrekkingen van licenties (afgedwongen door TfL) voor de rechtbank ongedaan gemaakt en is zo een extra hulpmiddel geworden bij de uitoefening van arbeidsrechten.

Dit vormt de andere tak van activiteit voor Worker Info Exchange; omdat we gefrustreerd zijn in onze pogingen om duidelijkheid en transparantie te krijgen over de complexe systemen die de arbeidsomstandigheden bepalen, moeten we vaak onze toevlucht nemen tot rechtszaken en ons tot rechtbanken wenden voor beslissingen op het opkomende gebied van digitale arbeidsrechten. De kunstmatige 'datacrisis' die de gig-platforms hebben gecreëerd, is in veel opzichten een poging om de hulpbronnen van zowel precaire werknemers als vakbonden uit te putten en uit te putten door geschillen voor de rechtbanken te brengen waar ze kunnen worden verlengd en de aansprakelijkheid voor wangedrag van bedrijven wordt vertraagd.

In lijn met deze activiteiten is dit rapport in drie delen geschreven: Het eerste deel onderzoekt verschillende facetten van algoritmisch beheer en de nadelen ervan, met bijbehorende casestudies. De tweede sectie behandelt ons proces bij het gebruik van Data Subject Access Requests (DSAR's), terwijl de derde een overzicht biedt van de AVG-gerelateerde zaken die we in Amsterdam hebben opgepakt, evenals de licentiezaken die we ondersteunen in Londen. Dit rapport sluit een werkperiode af waarin deze functies van onze organisatie worden aangepakt, uitgevoerd met de steun van de Mozilla Foundation, Digital Freedom Fund en Open Society Foundations. We hopen dat dit rapport de huidige stand van zaken in de uitoefening van rechten op het snijvlak van data en arbeid zal aantonen en de cumulatieve effecten zal onthullen van herhaalde niet-naleving door gig-platforms.

"Platformbedrijven opereren in een wetteloze ruimte waar ze denken dat ze de regels kunnen maken. Helaas is dit geen spel; virtuele realiteiten hebben harde gevolgen voor kluswerkers in het echte leven. Wat bemoedigend is, is dat werknemers zelf niet wachten op wetten, beleidsmakers of zelfs bondgenoten in de mensenrechtenbeweging om hen te redden. Gigantische arbeiders organiseren en gebruiken hun collectieve stem om nieuwe beschermingen te eisen die geschikt zijn voor hun doel in een digitaliserende economie."

Bama Athreya, Fellow, Open Society Foundations

Deel I: Misclassificatie 2.0 Gecontroleerd door Algoritme

In de zes jaar durende strijd om de rechten van werknemers in de Britse gig-economie, voerde Uber aan dat het slechts de agent van de zelfstandige chauffeur was die niets anders deed dan passief werkorders boeken en betalingen innen. Om deze fictie verder te brengen, stellen gig-platforms uitgebreide contracten op waardoor het lijkt alsof de bestuurder en passagier rechtstreeks met elkaar zaken doen, terwijl in feite alle passagiersinformatie nauw wordt afgeschermd door bedrijven. Uber genereert bijvoorbeeld namens de chauffeur een fictieve factuur voor elke passagier die ze vervoeren. De factuur vermeldt alleen de voornaam van de passagier en wordt nooit daadwerkelijk naar de klant gestuurd.

Deze misclassificatietechnieken, die vaak worden gebruikt in de gig-economie, stellen platforms in staat om wettelijke verantwoordelijkheden van werkgevers, zoals basisbescherming van werknemersrechten en premies voor nationale verzekeringen, te vermijden. In het VK heeft het platformbedrijven ook in staat gesteld om omzetbelasting over de toegevoegde waarde (btw) te ontwijken. Maar eerder dit jaar bevestigde het Hooggerechtshof het recht van de lagere rechtbanken om kunstmatige contracten af te schaffen en de ware aard van de arbeidsrelatie vast te stellen op basis van het bewijs van een managementrelatie met controle over werknemers.

Aangezien platformbedrijven tot de conclusie komen dat het gebruik van misleidende contracten niet langer levensvatbaar is als methode voor misclassificatie van werkgelegenheid, zullen ze in de verleiding komen om te dubbelen op procesautomatisering om de managementcontrole te verbergen. Algoritmische controle wordt misclassificatie 2.0. Er is inderdaad voldoende bewijs dat dit al gebeurt. Gig-platforms zijn vastbeslotener dan ooit om misclassificatiestrategieën na te streven, zodat ze het personeelsbestand kunnen blijven controleren en tegelijkertijd het risico vermijden dat chauffeurs van de 'werknemer'-status met beperkte rechten naar de werknemersstatus met aanzienlijk meer rechten kunnen overstappen.

Dus wat is algoritmische controle en wat zijn de specifieke risico's voor kluswerkers? In de ride-share- en bezorgindustrie zijn met name de volgende middelen voor algoritmisch beheer die ons het meest zorgen baren:

Toezicht. Intrusief toezicht voor het aangegeven doel van beveiliging en identificatie. Dit omvat het gebruik van fraudedetectie- en gezichtsherkenningstechnologieën. We zijn ons ervan bewust dat er toezicht wordt gehouden, zelfs als de werknemer niet heeft ingelogd om zich beschikbaar te stellen voor het werk. Het omvatte ook het toezicht houden op het gebruik van de app door de werknemer als consument.

Prestatiebeheer. Dit omvat maar is niet beperkt tot monitoring van het rijgedrag, inclusief ETA, klantbeoordelingen, acceptatie- en voltooiingspercentages van taken, interactie met ondersteunend personeel, beschikbaarheid.

Toewijzing van werk. Uber heeft er tot voor kort op aangedrongen dat de werkverdeling wordt bepaald op basis van de nabijheid van chauffeurs en passagiers bij elkaar, maar geeft nu toe dat er rekening wordt gehouden met gedrag en voorkeuren uit het verleden. Ola geeft toe dat chauffeursprofielen met scores voor 'verdienprofiel' en 'fraudewaarschijnlijkheid' worden gebruikt bij de geautomatiseerde besluitvorming over de werkverdeling.

Prijzen. Nauw verwant aan werktoewijzing is geautomatiseerde besluitvorming over prijzen. Misschien wel de meest bekende methode is Uber's zogenaamde 'surge' of 'dynamic pricing', die beweert de marktvraag te zuiveren met realtime, lokale prijsschommelingen.

Bovenstaande managementbeslissingen zijn meestal geautomatiseerd of semi-automatisch met beperkte menselijke tussenkomst. Bedrijfsmodellen van de kluseconomie zijn gebaseerd op massale automatisering van managementbeslissingen en toezicht op de werkplek. Hoewel sommige werkgevers op dit punt terughoudend zijn, is Deliveroo hier vrij openhartig over geweest in hun privacybeleid voor rijders :

“Gezien het volume aan leveringen waarmee we te maken hebben, gebruiken we geautomatiseerde systemen om de hierboven beschreven geautomatiseerde beslissingen te nemen, omdat ze een nauwkeurigere, eerlijkere en efficiëntere manier bieden om vermoedelijke fraude te identificeren, herhaalde schendingen van uw leveranciersovereenkomst te voorkomen en de negatieve impact op onze service. Menselijke controles zouden simpelweg niet mogelijk zijn in de tijdsbestekken en gezien de volumes van leveringen waarmee we te maken hebben.”

Prestatiebeheer

Dit omvat maar is niet beperkt tot monitoring van het rijgedrag, inclusief ETA, klantbeoordelingen, acceptatie- en voltooiingspercentages van taken, interactie met ondersteunend personeel, beschikbaarheid.

Prijzen

Nauw verwant aan werktoewijzing is geautomatiseerde besluitvorming over prijzen. Misschien wel de meest bekende methode is Uber's zogenaamde 'surge' of 'dynamic pricing', die beweert de marktvraag te zuiveren met realtime, lokale prijsschommelingen.

Toezicht

Intrusief toezicht voor het aangegeven doel van beveiliging en identificatie. Dit omvat het gebruik van fraudedetectie- en gezichtsherkenningstechnologieën. We zijn ons ervan bewust dat er toezicht wordt gehouden, zelfs wanneer de werknemer niet heeft ingelogd om zich beschikbaar te stellen voor het werk. Het omvatte ook het toezicht houden op het gebruik van de app door de werknemer als consument.

Werktoewijzing

Uber heeft er tot voor kort op aangedrongen dat de werkverdeling wordt bepaald op basis van de nabijheid van chauffeurs en passagiers bij elkaar, maar geeft nu toe dat er rekening wordt gehouden met gedrag en voorkeuren uit het verleden. Ola geeft toe dat chauffeursprofielen met scores voor 'verdienprofiel' en 'fraudewaarschijnlijkheid' worden gebruikt bij de geautomatiseerde besluitvorming over de werkverdeling.

Deel I: Misclassificatie 2.0 Gecontroleerd door Algoritme

In de zes jaar durende strijd om de rechten van werknemers in de Britse gig-economie, voerde Uber aan dat het slechts de agent van de zelfstandige chauffeur was die niets anders deed dan passief werkorders boeken en betalingen innen. Om deze fictie verder te brengen, stellen gig-platforms uitgebreide contracten op waardoor het lijkt alsof de bestuurder en passagier rechtstreeks met elkaar zaken doen, terwijl in feite alle passagiersinformatie nauw wordt afgeschermd door bedrijven. Uber genereert bijvoorbeeld namens de chauffeur een fictieve factuur voor elke passagier die ze vervoeren. De factuur vermeldt alleen de voornaam van de passagier en wordt nooit daadwerkelijk naar de klant gestuurd.

Deze misclassificatietechnieken, die vaak worden gebruikt in de gig-economie, stellen platforms in staat om wettelijke verantwoordelijkheden van werkgevers, zoals basisbescherming van werknemersrechten en premies voor nationale verzekeringen, te vermijden. In het VK heeft het platformbedrijven ook in staat gesteld om omzetbelasting over de toegevoegde waarde (btw) te ontwijken. Maar eerder dit jaar bevestigde het Hooggerechtshof het recht van de lagere rechtbanken om kunstmatige contracten af te schaffen en de ware aard van de arbeidsrelatie vast te stellen op basis van het bewijs van een managementrelatie met controle over werknemers.

Aangezien platformbedrijven tot de conclusie komen dat het gebruik van misleidende contracten niet langer levensvatbaar is als methode voor misclassificatie van werkgelegenheid, zullen ze in de verleiding komen om te dubbelen op procesautomatisering om de managementcontrole te verbergen. Algoritmische controle wordt misclassificatie 2.0. Er is inderdaad voldoende bewijs dat dit al gebeurt. Gig-platforms zijn vastbeslotener dan ooit om misclassificatiestrategieën na te streven, zodat ze het personeelsbestand kunnen blijven controleren en tegelijkertijd het risico vermijden dat chauffeurs van de 'werknemer'-status met beperkte rechten naar de werknemersstatus met aanzienlijk meer rechten kunnen overstappen.

Dus wat is algoritmische controle en wat zijn de specifieke risico's voor kluswerkers? In de ride-share- en bezorgindustrie zijn met name de volgende middelen voor algoritmisch beheer die ons het meest zorgen baren:

Toezicht. Intrusief toezicht voor het aangegeven doel van beveiliging en identificatie. Dit omvat het gebruik van fraudedetectie- en gezichtsherkenningstechnologieën. We zijn ons ervan bewust dat er toezicht wordt gehouden, zelfs als de werknemer niet heeft ingelogd om zich beschikbaar te stellen voor het werk. Het omvatte ook het toezicht houden op het gebruik van de app door de werknemer als consument.

Prestatiebeheer. Dit omvat maar is niet beperkt tot monitoring van het rijgedrag, inclusief ETA, klantbeoordelingen, acceptatie- en voltooiingspercentages van taken, interactie met ondersteunend personeel, beschikbaarheid.

Toewijzing van werk. Uber heeft er tot voor kort op aangedrongen dat de werkverdeling wordt bepaald op basis van de nabijheid van chauffeurs en passagiers bij elkaar, maar geeft nu toe dat er rekening wordt gehouden met gedrag en voorkeuren uit het verleden. Ola geeft toe dat chauffeursprofielen met scores voor 'verdienprofiel' en 'fraudewaarschijnlijkheid' worden gebruikt bij de geautomatiseerde besluitvorming over de werkverdeling.

Prijzen. Nauw verwant aan werktoewijzing is geautomatiseerde besluitvorming over prijzen. Misschien wel de meest bekende methode is Uber's zogenaamde 'surge' of 'dynamic pricing', die beweert de marktvraag te zuiveren met realtime, lokale prijsschommelingen.

Bovenstaande managementbeslissingen zijn meestal geautomatiseerd of semi-automatisch met beperkte menselijke tussenkomst. Bedrijfsmodellen van de kluseconomie zijn gebaseerd op massale automatisering van managementbeslissingen en toezicht op de werkplek. Hoewel sommige werkgevers op dit punt terughoudend zijn, is Deliveroo hier vrij openhartig over geweest in hun privacybeleid voor rijders :

“Gezien het volume aan leveringen waarmee we te maken hebben, gebruiken we geautomatiseerde systemen om de hierboven beschreven geautomatiseerde beslissingen te nemen, omdat ze een nauwkeurigere, eerlijkere en efficiëntere manier bieden om vermoedelijke fraude te identificeren, herhaalde schendingen van uw leveranciersovereenkomst te voorkomen en de negatieve impact op onze service. Menselijke controles zouden simpelweg niet mogelijk zijn in de tijdsbestekken en gezien de volumes van leveringen waarmee we te maken hebben.”

“Gezien het volume aan leveringen waarmee we te maken hebben, gebruiken we geautomatiseerde systemen om de hierboven beschreven geautomatiseerde beslissingen te nemen, omdat ze een nauwkeurigere, eerlijkere en efficiëntere manier bieden om vermoedelijke fraude te identificeren, herhaalde schendingen van uw leveranciersovereenkomst te voorkomen en de negatieve impact op onze service. Menselijke controles zouden eenvoudigweg niet mogelijk zijn in de tijdsbestekken en gezien de volumes van leveringen waarmee we te maken hebben.”

Toezicht

Intrusief toezicht voor het aangegeven doel van beveiliging en identificatie. Dit omvat het gebruik van fraudedetectie- en gezichtsherkenningstechnologieën. We zijn ons ervan bewust dat er toezicht wordt gehouden, zelfs wanneer de werknemer niet heeft ingelogd om zich beschikbaar te stellen voor het werk. Het omvat ook het toezicht houden op het gebruik van de app door de werknemer als consument.

Werktoewijzing

Uber heeft er tot voor kort op aangedrongen dat de werkverdeling wordt bepaald op basis van de nabijheid van chauffeurs en passagiers bij elkaar, maar stelt nu dat er rekening wordt gehouden met gedrag en voorkeuren uit het verleden. Ola gebruikt chauffeursprofielen die 'fraudewaarschijnlijkheidsscores' bevatten in geautomatiseerde besluitvorming voor werk toewijzing.

Prestatiebeheer

Beoordeling van werkprestaties omvat, maar is niet beperkt tot, monitoring van rijgedrag, inclusief ETA, klantbeoordelingen, werkaanvaarding en voltooiingspercentages, interactie met ondersteunend personeel, beschikbaarheid.

Prijzen

Nauw verwant aan werktoewijzing is geautomatiseerde prijsstelling. Misschien wel de meest bekende methode is de zogenaamde 'surge' of 'dynamic pricing' van Uber, die beweert de marktvraag te zuiveren met realtime, lokale prijsschommelingen.

Surveillance wapenwedloop

We zien een wapenwedloop in de gig-economie sinds Uber in 2020 zijn zogenaamde Hybrid Real Time Identification System introduceerde. Slechts een dag voordat Transport for London (TfL) in november 2019 haar beslissing aankondigde om de verlenging van hun licentie te weigeren, Uber bood aan om dit bewakingssysteem te introduceren dat gezichtsherkenning met GPS-monitoring omvat.

Dit was een reactie op de klacht van TfL dat 21 chauffeurs waren gedetecteerd (van de 90.000 geanalyseerde over meerdere jaren) als betrokken bij het delen van accounts, waardoor potentieel niet-gelicentieerde en onverzekerde chauffeurs illegaal hun diensten via de app konden aanbieden. De activiteit werd mogelijk gemaakt door de GPS-locatie van het apparaat te resetten naar buiten het VK, waar het voor chauffeurs mogelijk is om hun eigen foto's te uploaden. Dit gat werd snel gedicht door Uber en de gedetecteerde activiteit was verwaarloosbaar klein in vergelijking met de schaal van de operatie van Uber. De introductie van gezichtsherkenningstechnologie door de industrie is volkomen onevenredig in verhouding tot het waargenomen risico. Desalniettemin werd de vereiste voor realtime identificatie een voorwaarde voor de verlenging van de licentie van Uber bij de Westminster Magistrates Court in september 2020.

In het geval van Uber hebben zowel het management van het platform als TfL er niet in geslaagd ervoor te zorgen dat er passende waarborgen werden ingevoerd om de rechten en vrijheden van chauffeurs te beschermen, ondanks het feit dat TfL de gegevensbeschermingseffectbeoordeling voor de technologie in maart 2020 heeft beoordeeld. vrijheid van informatie verzoek aan TfL om toegang te krijgen tot Uber's DPIA voor de realtime ID-systemen, maar we werden geweigerd. Volgens TfL-rapporten is 94% van de chauffeurs van particuliere huurauto's afkomstig uit zwarte en etnische minderheden en de introductie van deze technologie, die algemeen bekend staat om zijn lage nauwkeurigheidspercentages binnen deze groepen , is rampzalig gebleken voor kwetsbare werknemers die al in onzeker werk.

Bolt heeft sindsdien aangekondigd dat het € 150 miljoen investeert in antifraudedetectiesystemen voor AI-bestuurders, waaronder gezichtsherkenning. Deliveroo kondigde aan dat ook zij identiteitscontroles voor gezichtsherkenning zouden invoeren. Ola Cabs heeft ook identificatie met gezichtsherkenning uitgerold als een functie van zijn Guardian-systeem , met machine learning waarvan ze beweren dat ze "elke dag continu kunnen leren en evolueren van miljoenen datapunten, om risicosignalering en onmiddellijke oplossing te verbeteren."

FreeNow, een joint venture van Daimler en BMW, houdt ook nauwlettend toezicht op bestuurders als onderdeel van hun fraudepreventieprogramma. Uit documenten die door FreeNow bij het Hooggerechtshof waren ingediend in een Judicial Review van TfL's beslissing om hen een licentie in Londen te verlenen, onthulden ze inderdaad dat TfL maandelijkse rapporten heeft gemaakt over het ontslag van chauffeurs om verschillende redenen (waaronder 'frauduleuze activiteit') als voorwaarde voor hun recente licentieverlenging. Maar de beschrijving van de gegevens die worden verwerkt met het oog op fraudepreventie roept meer vragen op dan het privacybeleid van FreeNow beantwoordt.

In dit document stelt Free Now dat ze een 'random forest'-algoritme gebruiken om een fraudescore te produceren die ze gebruiken om ' de verzonden ritten dienovereenkomstig te prioriteren. Dit zorgt voor een eerlijke en risicogeminimaliseerde verzending .” Free Now betwistte hun gebruik van dit fraudedetectiesysteem toen we er in juni 2021 naar vroegen en beweerde dat dit gedeelte van het privacybeleid verouderd was (zie de bedrijfscasestudy in hoofdstuk II van het rapport). De beschrijving van dit systeem is in het beleid gebleven, ondanks een update in september 2021.

Wat vooral zorgwekkend is aan het gebruik van deze systemen, is dat ze fraudebeheer vermengen met prestatiebeheer. Het feit dat dergelijke 'fraude'-indicatoren worden gebruikt als variabelen voor de werktoewijzing en dat het gedrag dat ze genereert op het platform mag blijven bestaan, toont aan dat dit geen gevallen van criminele fraude zijn, maar controlemechanismen die beoordelen hoe goed werknemers presteren tegen de ondoorzichtige maatstaven van bedrijven. We stellen voor dat alle 'fraude'-terminologie die in deze contexten wordt gebruikt, ook deel uitmaakt van het spel van misclassificatie, dat bedoeld is om de arbeidsrelatie te verbergen.

Surveillance Casestudy I: gezichtsherkenning mislukt

In april 2020 introduceerde Uber een Real Time ID-check (RTID)-systeem in het VK dat een combinatie van gezichtsherkenning en locatiecontrole gebruikt om de identiteit van een bestuurder te verifiëren en om te voorkomen dat chauffeurs toegang tot hun account delen voor werk.

Het RTID-systeem maakt gebruik van Microsoft's FACE API, gezichtsherkenningssoftware en vereist dat chauffeurs en koeriers routinematig realtime selfies van zichzelf maken om de Uber-app te blijven gebruiken. De foto wordt vervolgens vergeleken met de profielfoto van het account van de bestuurder (en in sommige rechtsgebieden, met openbare databases om " het lenen van identiteiten te voorkomen of om de identiteit van gebruikers te verifiëren ").

Pa Edrissa Manjang werkte ongeveer een jaar met Uber toen hij werd gedeactiveerd vanwege een mislukte selfie-verificatie. Terwijl Uber-chauffeurs en koeriers routinematig selfies verstrekken, worden deze niet opgeslagen op de telefoons van de werknemers en kunnen ze het bewijs van hun inzendingen niet bewaren. Pa kreeg tot zijn ontslag geen waarschuwingen of kennisgevingen van problemen; het Real Time ID-verificatiesysteem bleek al zijn foto's goed te keuren met een groen vinkje.

Na zijn ontslag stuurde Pa talloze berichten naar Uber om het probleem op te lossen, waarbij hij specifiek vroeg of een mens zijn inzendingen kon beoordelen. Elke keer dat Pa te horen kreeg: "We waren niet in staat om te bevestigen dat de verstrekte foto's daadwerkelijk van jou waren en vanwege aanhoudende mismatches, hebben we de definitieve beslissing genomen om onze samenwerking met jou te beëindigen." We hebben de selfies in kwestie verkregen via een verzoek om toegang tot het onderwerp, waaruit bleek dat alle foto's die Pa had ingediend in feite van hem waren. Dit was de eerste keer dat we erin slaagden om de door een koerier of chauffeur ingestuurde selfies te bemachtigen. Het is onduidelijk waarom dit verzoek slaagde, terwijl velen ervoor faalden.

We hebben eerder dit jaar ook naar Microsoft geschreven om onze zorgen te uiten over het ongereguleerde gebruik van FACE API door Uber op zijn platform. In reactie daarop benadrukte Microsoft dat alle partijen die betrokken zijn bij de implementatie van dergelijke technologieën verantwoordelijkheden hebben, waaronder: "het opnemen van zinvolle menselijke beoordeling om gevallen van verkeerde identificatie of andere fouten op te sporen en op te lossen" en "om ondersteuning te bieden aan mensen die denken dat hun resultaten onjuist waren; en om fluctuaties in nauwkeurigheid als gevolg van variatie in omstandigheden te identificeren en aan te pakken." Het geval van Pa toont duidelijk aan dat deze cruciale controles niet zijn geïmplementeerd bij de verwerking van RTID-beelden.

Pa spant nu een zaak aan tegen Uber om de raciaal discriminerende toepassing van gezichtsherkenning aan te vechten, vertegenwoordigd door Bates Wells, met steun van de Equality and Human Rights Commission, de App Drivers and Couriers Union en Worker Info Exchange.

EMBED: Pa's video

Surveillance Casestudy II: Geolocatiecontroles

Hoewel het gebruik van gebrekkige gezichtsherkenningssystemen ongetwijfeld problematisch is, hebben we ook gezien dat veel chauffeurs werden ontslagen na valse beschuldigingen van Uber dat ze frauduleus waren met het delen van accounts nadat twee apparaten door Uber op twee locaties tegelijkertijd waren gedetecteerd. In alle gevallen die we hebben geanalyseerd, hebben we geconstateerd dat het probleem te maken heeft met het stuurprogramma dat de app voor het gemak op twee apparaten heeft geïnstalleerd, maar met slechts één van de apparaten die is aangemeld voor werk.

Net voor 20.00 uur op 11 september 2020 was Aweso Mowlana aan het werk voor Uber in Zuid-Londen. Hij was een chauffeur met een rating van 4,95 sterren die in meer dan 5 jaar bij Uber meer dan 11.500 ritten had gemaakt. Aweso had net een passagier afgezet bij Elephant and Castle toen hij zich afmeldde voor een korte pauze. Zoals veel stuurprogramma's had Aweso de app op een tweede apparaat geïnstalleerd, namelijk een iPhone. Die avond had hij de iPhone thuisgelaten en werkte hij met zijn andere telefoon, een Samsung.

Om 20:02 probeerde Aweso opnieuw in te loggen op de Uber-app om zichzelf beschikbaar te maken voor zijn volgende baan. Voordat hij weer mocht inloggen, werd hem gevraagd een selfie te maken als onderdeel van de Real Time Identity Check (RTID) van Uber. Zijn foto kwam overeen met de referentiefoto van Uber, dus hij voltooide de aanmeldingsprocedure om zijn dienst voort te zetten. Maar wat hij niet wist, Uber-systemen hadden zijn tweede telefoon gedetecteerd en/of gepingd. Zijn zoon had per ongeluk zijn tweede telefoon opgepakt en meegenomen naar het huis van zijn vriendin in Uxbridge. Uber zei later dat ze om 20:03 uur een RTID-controle van dit apparaat hadden aangevraagd, maar tegen die tijd was Aweso al online in Zuid-Londen. Uber beweert dat het antwoord op de ID-controle die avond rond 23:55 vanaf de iPhone is verzonden.

De volgende dag liet Uber hem weten dat zijn account was 'gemarkeerd voor verdachte applicatie-activiteit' en dat zijn account nu zou worden opgeschort terwijl 'een gespecialiseerd team dit beoordeelt'. Enige tijd later ontsloeg Uber Aweso permanent via sms dat ze 'bewijs hadden gevonden dat op frauduleuze activiteiten wees' voor zijn account. Uber beweerde vervolgens dat hij de toegang tot zijn account deelde en daarmee de algemene voorwaarden had geschonden. De volgende maand trok Transport for London onmiddellijk de vergunning van Aweso in op grond van het feit dat hij niet langer 'fit and proper' kon worden bevonden om een openbare vergunning te bezitten op grond van zijn ontslag bij Uber.

Worker Info Exchange hielp Aweso bij het indienen van een verzoek om toegang tot het onderwerp en het analyseren van de ontvangen gegevens. Eén bestand met de naam 'D river Gedetailleerde apparaatgegevens ' registreert ten minste een deel van de gegevens die in realtime van apparaten naar Uber worden gestreamd. Het eigen privacybeleid van Uber geeft aan dat waar een apparaat de app op de achtergrond of voorgrond heeft geopend, zelfs als deze niet online is en klaar is om tarieven te accepteren. In meer dan een dozijn zaken waarin we bestuurders ondersteunden die in beroep gingen tegen hun intrekking bij de Magistrates Court, werd elk beroep gegrond verklaard en werd TfL bevolen om de licenties te herstellen. Uit dit bestand konden we zien dat maar liefst 230 rijen gegevens per minuut door Uber werden vastgelegd vanaf apparaten. De gegevens die Uber van de apparaten van Aweso heeft verzameld, zijn inbegrepen geolocatie, batterijniveau, snelheid, koers, IMEI-nummer enz.

Uit de gegevens bleek dat het apparaat in Uxbridge die dag nooit was ingelogd voor werk omdat een veld met de titel 'driver_online' de iPhone die dag altijd als 'FALSE' liet zien, inclusief het tijdstip waarop deze bij Uxbridge was opgenomen. Dit is het bewijs dat het apparaat niet werd gedeeld voor werk met anderen, zoals beweerd door Uber en Transport for London. Uber heeft geen toegang verleend tot de persoonsgegevens die zijn verwerkt in beide RTID-controles, inclusief de verzamelde foto's. De 'Gedetailleerde apparaatgegevens' laten na 20:03:43 uur geen gegevens zien van verdere activiteit voor de iPhone. We zagen geen gegevensbewijs van apparaatactiviteit om 23:55 uur toen Uber zei een reactie te hebben ontvangen op de eerder afgegeven ID-controle.

De ervaring van Pa en Aweso was het afgelopen jaar zeer wijdverbreid en vormde een aanzienlijk aantal zaken die werden afgehandeld door Worker Info Exchange en de App Drivers & Couriers Union. In Londen had Transport for London de neiging om onmiddellijk de rijbewijzen in te trekken van chauffeurs die naar verluidt niet waren geslaagd voor de RTID-controles van Uber, ondanks de duidelijke problemen met het systeem. Er zijn vaak redelijke verklaringen voor het gebruik van meerdere apparaten die automatisch als fraude worden geclassificeerd. Het eigen privacybeleid van Uber geeft aan dat waar een apparaat de app op de achtergrond of voorgrond heeft geopend, zelfs als deze niet online is en klaar is om tarieven te accepteren. In meer dan een dozijn zaken waarin we bestuurders ondersteunden die in beroep gingen tegen hun intrekking bij de Magistrates Court, werd elk beroep gegrond verklaard en werd TfL bevolen om de licenties te herstellen.

Worker Info Exchange, Big Brother Watch en de App Drivers & Couriers Union schreven een gezamenlijke brief aan de burgemeester van Londen om onze bezorgdheid te uiten over het vertrouwen van Transport for London op gebrekkig bewijs van Uber bij het nemen van een intrekkingsbeslissing en eisten dat, als voorzitter van Transport for London voor de raad van bestuur van Londen, dat hij een herziening van al dergelijke onrechtmatige intrekkingen gelast. Tot op heden hebben noch de burgemeester noch TfL gereageerd.

Ondoorzichtig prestatiebeheer

De ondoorzichtigheid van platformbedrijven belemmert werknemers om te begrijpen hoe algoritmische controle kan worden geïntegreerd in de hele reeks kritieke processen en in de loop van de tijd. Zo hebben werknemers bijvoorbeeld niet de transparantie gekregen waar ze wettelijk recht op hebben om te begrijpen hoe prestatieprofilering verband houdt met de kwaliteit en kwantiteit van het aangeboden werk en met de verwachte opbrengsten van dergelijk werk.

In het geval van Ola hebben we enige kennis van de gegevenscategorieën die ze verzamelen en verwerken in hun werktoewijzingssystemen - zoals fraudewaarschijnlijkheidsscores, verdienprofiel, boekingsacceptatie en annuleringsgeschiedenis, maar dit onthult niet de verschillende wegingen toegepast op deze variabelen, noch op de logica van de verwerking.

Uber heeft lang volgehouden dat het matchingsysteem uitsluitend wordt bepaald door de locatie, ondanks dat de eigen "Partner-Driver"-interface anders suggereert. Uber's Pro-programma (waarvoor chauffeurs automatisch worden ingeschreven zodat ze kunnen worden gestimuleerd om prestatiedoelen te halen in ruil voor voordelen en beloningen) informeert chauffeurs in vage taal dat "hogere bevestigingspercentages kortere wachttijden voor klanten en kortere ophaaltijden voor iedereen betekenen chauffeurs” losjes zinspelend op het feit dat afnemende banen zullen leiden tot minder vacatures.

Uber heeft pas onlangs meer transparantie geboden over het matchingsysteem door middel van een update van hun privacybeleid waarin staat: "Gebruikers kunnen worden gematcht op basis van beschikbaarheid, nabijheid en andere factoren, zoals de waarschijnlijkheid dat ze een reis accepteren op basis van hun gedrag of voorkeuren in het verleden" maar op het moment van schrijven is de link met meer informatie over het matchingsysteem verbroken, wat getuigt van de evoluerende aard van dergelijke gegevensverwerking. Een recent verzoek om vrijheid van informatie dat we bij TfL hebben ingediend, met de vraag welke updates Uber had verstrekt op zijn matchingsysteem (zoals het verplicht is te doen bij het aanbrengen van wijzigingen in zijn bedrijfsmodel), leverde geen resultaten op, wat de verduistering van zijn algoritmische beheerpraktijken nog meer benadrukt en het ontbreken van regelgevend toezicht.

De recente onthullingen over de variabelen die de werkverdeling bepalen, roepen ook belangrijke vragen op over de kwaliteit van de banen die aan chauffeurs worden aangeboden. Krijgen chauffeurs met een hoge werkaanvaarding ritten aangeboden van langere lengte en duur, resulterend in een hoger loon, op basis van vergelijkbare profilering? Of, nog een stap verder: krijgen chauffeurs verschillende tarieven aangeboden via het dynamische prijssysteem? Of en hoe algoritmische prijsstelling samengaat met werktoewijzing, is inderdaad een gevoelige kwestie waarover nog weinig bekend is.

In de afgelopen jaren heeft Uber de variabele prijsstelling voor tijd en afstand aan klanten vervangen door een vast prijsmodel waarbij een prijs vooraf wordt geaccepteerd aan het begin van een reis. Uber stelt: "prijsbepaling vooraf is dynamisch, wat betekent dat de prijs in realtime wordt berekend om vraag en aanbod in evenwicht te brengen." Meer recentelijk hebben chauffeurs gemeld dat ze zeer lage tarieven krijgen voor individuele banen. Hier ligt een voor de hand liggende kans voor Uber om zijn aandeel in het uiteindelijke tarief dat passagiers betalen te vergroten. Er is bezorgdheid geuit over de discriminerende gevolgen van het gebruik van deze dynamische prijsstellingssystemen voor passagiers, waardoor het vooruitzicht ontstaat dat chauffeurs ook onderworpen kunnen worden aan realtime gepersonaliseerde prijzen. Er zijn hier ernstige ethische problemen als operators lagere prijzen aanbieden aan kwetsbare werknemers op basis van profilering die hun bereidheid om werk tegen verschillende prijspunten te accepteren voorspelt.

In het VK lijken dergelijke praktijken in strijd te zijn met de bepalingen van sectie 1 van de Employment Rights Act, die werknemers het recht geeft om van hun werkgever een duidelijke verklaring te ontvangen van de voorwaarden van hun werk, met inbegrip van loontarieven.

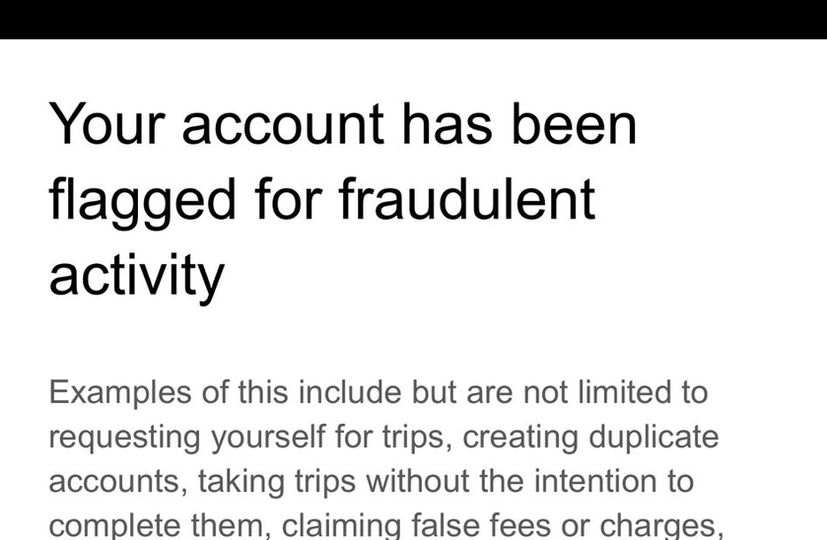

Casestudy: Algoritmische controle

Uber stuurt chauffeurs routinematig berichten wanneer ze worden gemarkeerd door zijn fraudedetectiesystemen om hen te waarschuwen dat ze hun baan kunnen verliezen als ze doorgaan met welk gedrag dan ook dat het systeem activeert. De berichten bevatten een niet-limitatieve lijst van mogelijke triggers, maar geven geen specifieke reden voor de individuele bestuurder die van fraude wordt beschuldigd. Toen Alexandru de tweede en laatste van deze berichten ontving, wetende dat een nieuwe vlag zou resulteren in ontslag, besloot hij het ondersteuningsteam van de chauffeur te bellen om meer informatie te krijgen over waarom hij het fraudebestrijdingssysteem activeerde en wat hij kon doen om dit te voorkomen . Tijdens het gesprek bespraken Alexandru en de ondersteuningsmedewerker verschillende situaties waardoor zijn reizen mogelijk onregelmatig leken, en onthulden de beperkte mogelijkheden van ondersteuningsteams om de indicaties van het systeem te ontcijferen. Drie maanden na dit telefoontje stuurde Uber een verontschuldigingsbericht waarin stond dat hij de waarschuwingen ten onrechte had gekregen.

Hoewel het gesprek verhelderend is in termen van het begrijpen van de dilemma's waarmee chauffeurs worden geconfronteerd wanneer het bedrijfsbeleid en de eisen van passagiers uiteenlopen, was de discussie (25 minuten na het gesprek) over een omweg die Alexandru nam vanwege wegwerkzaamheden, van bijzonder belang voor ons, evenals zijn lage baanacceptatiecijfers als mogelijke oorzaken van zijn ontdekking door het fraudebestrijdingssysteem. Naar aanleiding van de uitspraak van het Hooggerechtshof die Uber-chauffeurs eerder dit jaar als werknemers bestempelde, beweerde Uber aanzienlijke wijzigingen aan zijn platform te hebben aangebracht , zoals het bieden van transparantie over prijs en bestemming, en het schrappen van strafmaatregelen voor het weigeren van banen, in een poging om te betogen dat de uitspraak van het Hooggerechtshof was niet van toepassing op huidige Uber-chauffeurs.

Alexandru's ervaring op het platform druist in tegen dit verhaal, aangezien het duidelijk wordt dat hij waarschijnlijk wordt gemarkeerd voor het afwijken van de route (ondanks het feit dat Uber nu een model met een vaste prijs hanteert, wat inhoudt dat chauffeurs dergelijke routewijzigingen op eigen kosten maken) en niet genoeg accepteren van het werk dat hem op het platform wordt aangeboden. Deze oproep maakt onmiskenbaar duidelijk dat chauffeurs in de praktijk nog steeds even streng worden gecontroleerd door Uber als voorheen.

Naast deze managementpraktijken is het hierboven genoemde Pro-programma een ander hulpmiddel dat Uber gebruikt om controle uit te oefenen over zijn personeel, terwijl het de wettelijke verplichtingen ontwijkt die met dergelijke controle gepaard kunnen gaan. Door bijvoorbeeld bepaalde beloningen, die voortvloeien uit het behouden van een hoge rating, te koppelen aan externe bedrijven of door deelname aan prijsvoordelen als puur optioneel te presenteren door middel van gedragsnudging, creëert Uber de illusie chauffeurs volledig onafhankelijk en flexibel te laten werken. De veronderstelde vrijwillige betrokkenheid van de chauffeurs bij deze programma's resulteert in het opgeven van rechten die voortvloeien uit het hebben van een arbeidsrelatie.

EMBED: Alexandru's video

Uitbreiding van de wetshandhavingsinfrastructuur

Ook zijn er aanwijzingen dat platforms in toenemende mate een aantrekkelijke informatiebron zijn geworden voor politie- en veiligheidsdiensten. In een getuigenverklaring die in september 2020 als bewijsmateriaal werd gepresenteerd tijdens het vergunningsberoep van Uber bij de Westminster Magistrates Court, getuigde Jamie Heywood, algemeen directeur van Uber uit het VK en West-Europa, van een steeds nauwere relatie met de politie en veiligheidsdiensten. Deze omvatten het National Counter Terrorism Policing Network, SO15 - het Counter Terrorism Command van de Metropolitan Police Service, de National Police Chiefs Council (NPCC), het College of Policing, de National Crime Agency en de British Transport Police. Een samenwerkingsgebied was het probleem van het zogenaamde County Lines-transport van drugs. Heywood citeerde rechercheur-inspecteur Stuart Liddell van de NPCC en getuigde van een volwassen wordende relatie op basis van geavanceerde niveaus van het delen van inlichtingen:

“Ik ben bemoedigd door de betrokkenheid van Uber met betrekking tot deze kwestie en er zijn verdere werkzaamheden gepland [in 2020] om voort te bouwen op het werk tot nu toe. Dit zal zich richten op meer ingewikkelde aspecten van de County Lines, de stroom van informatie en inlichtingen en de versterking van de relatie tussen het National County Lines Coördinatiecentrum.”

De NPCC heeft inderdaad gelobbyd voor Mike Brown, commissaris van Transport for London, ter ondersteuning van het beroep van Uber op de vergunning. Chief Constable Mark Collins ging zelfs zo ver dat hij suggereerde dat een beslissing om Uber hun vergunning te weigeren, een negatief effect zou kunnen hebben op de Britse politie.

"Hopelijk schetst deze brief de negatieve impact op de Britse politie als de politie geen toegang zou hebben tot de gegevens en informatie die ik heb beschreven."

Heywood getuigde ook dat Collins had beweerd dat de Metropolitan Police Service alleen al meer dan 2000 verzoeken om gegevens aan Uber per jaar deed. Dit is een relatief hoog aantal verzoeken, aangezien volgens Uber's eigen Transparantierapport in 2020 alle Amerikaanse wetshandhavingsinstanties samen iets minder dan 5.000 gegevensverzoeken hebben ingediend en alle Canadese wetshandhavingsinstanties samen slechts 411 dergelijke verzoeken hebben gedaan.

Het is waarschijnlijk dat het management van Uber onder druk staat om samen te werken met initiatieven voor het verzamelen van inlichtingen van de politie, met name in het licht van het besluit van Transport for London om de verlenging van hun licentie twee keer te weigeren. Dit komt omdat artikel 17 van de Crime and Disorder Act 1998 een directe verantwoordelijkheid legt bij de vergunningverlenende autoriteiten om misdaad en ongeregeldheden in hun gebied te voorkomen. Dit stelt vergunningverlenende autoriteiten zoals Transport for London verplicht om Crime and Disorder Reduction Partnerships (CDRP) op te richten waaraan vervoerders zoals Uber naar verwachting zullen deelnemen.

In de wettelijke richtlijnen van het Department for Transport aan vergunningverlenende autoriteiten versterkt de regering de verwachting van het delen van inlichtingen tussen de politie, vergunningverlenende autoriteiten en vervoerders zoals Uber:

“Het vergroten van het bewustzijn bij politiediensten van de waarde die vergunningverlenende autoriteiten hechten aan de ontvangen informatie, met name over niet-veroordelingsinformatie, zal deze relaties helpen bevorderen en de voordelen van een grotere uitwisseling van informatie versterken. Deze relatie kan voor beide partijen voordelig zijn en de politie helpen criminaliteit te voorkomen. De politie kan waardevolle informatie verkrijgen van chauffeurs en machinisten...”

Hoewel dergelijke relaties van groot belang zijn voor misdaadbestrijding op gemeenschapsniveau, lijkt er weinig aandacht te zijn voor het risico voor de burgerlijke vrijheden van relatief gemakkelijke toegang tot rijke persoonlijke gegevens van chauffeurs en passagiers, zoals verzameld en opgeslagen door platforms zoals Uber, Bolt en Ola taxi's.

“Ik ben bemoedigd door de betrokkenheid van Uber met betrekking tot deze kwestie en er zijn verdere werkzaamheden gepland [in 2020] om voort te bouwen op het werk tot nu toe. Dit zal zich richten op meer ingewikkelde aspecten van de County Lines, de stroom van informatie en inlichtingen en de versterking van de relatie tussen het National County Lines Coördinatiecentrum.”

"Hopelijk schetst deze brief de negatieve impact op de Britse politie als de politie geen toegang zou hebben tot de gegevens en informatie die ik heb beschreven."

“Het vergroten van het bewustzijn bij politiediensten van de waarde die vergunningverlenende autoriteiten hechten aan de ontvangen informatie, met name over niet-veroordelingsinformatie, zal deze relaties helpen bevorderen en de voordelen van een grotere uitwisseling van informatie versterken. Deze relatie kan voor beide partijen voordelig zijn en de politie helpen criminaliteit te voorkomen. De politie kan waardevolle informatie verkrijgen van chauffeurs en machinisten...”

Casestudy: informatie delen met wetshandhaving

Een andere medewerker die ons benaderde voor hulp was een Uber-chauffeur die zeven weken lang ten onrechte van het Uber-platform was geschorst, met een verlies van bijna £ 5000, na een verzoek van de politie om inlichtingen. In 2019 kreeg de chauffeur een bericht van Uber waarin stond dat hij tijdelijk geschorst was vanwege een lopend onderzoek. Hij kreeg noch een reden, noch een termijn voor zijn schorsing. Hij kreeg zelfs uitdrukkelijk te horen geen contact op te nemen met Uber terwijl zij het onderzoek uitvoerden. Zeven weken later kreeg hij een telefoontje met de mededeling dat hij nu kon werken.

Twee jaar later onthulde een aanvraag voor verlenging van het rijbewijs die de bestuurder bij TfL had ingediend (inclusief een verbeterde controle op openbaarmaking en blokkering van service) de reden voor schorsing, toen TfL hem ondervroeg over het verstrekken van drugs in 2019 en dreigde zijn rijbewijs in te nemen. Geschokt door de onthulling eiste de chauffeur een misdaadreferentienummer en deed hij verder onderzoek, niet alleen bij TfL, maar ook bij de Metropolitan Police.

We hebben de chauffeur geholpen bij het indienen van toegangsverzoeken en klachten bij Uber, TfL en de politie. Uber voldeed niet aan het verzoek (de chauffeur kreeg te horen dat zijn verzoek was doorgegeven aan een gespecialiseerd team maar kreeg geen verdere reactie), maar het antwoord van TfL bracht een uitgebreide reeks e-mails aan het licht tussen verschillende functionarissen terwijl ze probeerden de bron van de informatie te achterhalen verzoek. Uber beweerde dat ze door de politie waren benaderd, terwijl de politie geen gegevens of bewijs van onderzoek naar de bestuurder kon vinden. Uiteindelijk noemde Uber de officier die het inlichtingenverzoek had gedaan, maar toen TfL details over de zaak zocht, beweerde de OIC dat hij zich de bestuurder in kwestie niet kon herinneren.

De klacht die de bestuurder bij de Metropolitan Police had ingediend, werd uiteindelijk beantwoord in oktober 2021 en concludeerde dat de bestuurder nooit als verdachte was geïdentificeerd:

“Agenten kregen de taak om een verdachte te identificeren in verband met een ernstig misdrijf. Officieren hadden de naam van een persoon van belang doorgegeven. Ik kan bevestigen dat jij dit NIET was. Op 20 februari 2019 is een gegevensbeschermingsformulier ingediend bij Uber met de genoemde verdachtegegevens. Ik ben niet vrij om hierover nadere details te verstrekken.

“Je naam kwam in geen enkel stadium voor in dit onderzoeksonderzoek bij Uber. De officier benaderde Uber NIET op zoek naar informatie die met u te maken had. Naar aanleiding van ons onderzoek heeft Uber uw gegevens aan de politie verstrekt. Toen de informatie eenmaal van Uber was ontvangen en ze ons uw naam hadden gegeven, wisten we dat u NIET aan ons onderzoek was gekoppeld en werd er geen verdere actie ondernomen en werd u uitgesloten van verder onderzoek.”

“De officier heeft geen enkele professionele standaard geschonden, handelde niet buiten zijn rol als politieagent en heeft zijn macht niet misbruikt. Uw naam was niet het doel van het verzoek en we hebben Uber op geen enkel moment verteld dat u een persoon van belang was."

"Uber zou misschien moeten uitleggen hoe ze iemand schorsen die niet het onderwerp was van het oorspronkelijke verzoek en ook waarom je na 10 dagen niet automatisch werd hersteld in de app en in staat was om door te werken."

EMBED: L's video

“Agenten kregen de taak om een verdachte te identificeren in verband met een ernstig misdrijf. Officieren hadden de naam van een persoon van belang doorgegeven. Ik kan bevestigen dat jij dit NIET was. Op 20 februari 2019 is een gegevensbeschermingsformulier ingediend bij Uber met de genoemde verdachtegegevens. Ik ben niet vrij om hierover nadere details te verstrekken.

“Je naam kwam in geen enkel stadium voor in dit onderzoeksonderzoek bij Uber. De officier benaderde Uber NIET op zoek naar informatie die met u te maken had. Naar aanleiding van ons onderzoek heeft Uber uw gegevens aan de politie verstrekt. Toen de informatie eenmaal van Uber was ontvangen en ze ons uw naam hadden gegeven, wisten we dat u NIET aan ons onderzoek was gekoppeld en werd er geen verdere actie ondernomen en werd u uitgesloten van verder onderzoek.”

“De officier heeft geen enkele professionele standaard geschonden, handelde niet buiten zijn rol als politieagent en heeft zijn macht niet misbruikt. Uw naam was niet het doel van het verzoek en we hebben Uber op geen enkel moment verteld dat u een persoon van belang was."

"Uber zou misschien moeten uitleggen hoe ze iemand schorsen die niet het onderwerp was van het oorspronkelijke verzoek en ook waarom je na 10 dagen niet automatisch werd hersteld in de app en in staat was om door te werken."

Deel II: Gegevensrechten uitoefenen op het werk: toegang

Het arbeidsrecht bevat niet de nodige bepalingen om werknemers volledig te beschermen tegen de oneerlijke praktijken die voortvloeien uit algoritmisch beheer. Individuen hebben echter rechten onder de AVG die hun belangen binnen arbeidscontexten kunnen beschermen. Bij het ondersteunen van werknemers doen we een beroep op hun rechten zoals gedefinieerd in artikel 15, 20 en 22, die hen het recht geven op toegang tot persoonlijke gegevens , het recht op gegevensoverdraagbaarheid , evenals het recht om geïnformeerd te worden over geautomatiseerde besluitvorming en de logica van verwerking .

Artikel 22: Betrokkenen kunnen niet worden onderworpen aan beslissingen met juridische (of vergelijkbare significante) gevolgen, uitsluitend gebaseerd op de geautomatiseerde verwerking van gegevens.

[Als de verwerkingsverantwoordelijke gegevens verwerkt met de uitdrukkelijke toestemming van de betrokkene, of voor de uitvoering van een contract met hem, heeft de betrokkene het recht om menselijke tussenkomst te verkrijgen, zijn standpunt kenbaar te maken en de beslissing aan te vechten]

Artikel 15: Betrokkenen hebben het recht om een kopie van hun persoonsgegevens te ontvangen, samen met aanvullende informatie zoals de doeleinden van de gegevensverwerking, informatie over met wie de gegevens kunnen worden gedeeld, de duur van de verwerking enz.

Artikel 20 : Betrokkenen hebben het recht om persoonsgegevens die zij aan een verwerkingsverantwoordelijke hebben verstrekt te ontvangen in een gestructureerd, veelgebruikt en machineleesbaar formaat. Ze hebben ook het recht om de gegevens door te sturen ('porteren') naar een andere verwerkingsverantwoordelijke. Waar mogelijk kunnen ze vragen om de gegevens rechtstreeks van de ene controller naar de andere te verzenden.

Hoewel platforms gegevensdownloads beschikbaar stellen aan werknemers, laten deze vaak de gegevenscategorieën weg die het meest bevorderlijk en noodzakelijk zijn voor het onderzoeken van de arbeidsvoorwaarden (zoals eerlijk loon, baantoewijzing en gebruik zoals hierboven vermeld). In ons streven om de reikwijdte van gegevens die beschikbaar worden gesteld aan werknemers, doen we specifieke verzoeken om toegang tot en overdraagbaarheid van personen die het volledige scala van data-gig-platforms omvatten die van hen worden verzameld. In deze verzoeken proberen we drie verschillende soorten gegevens te verkrijgen:

1) Invoergegevens - verstrekt door de werknemers zelf

2) Observatiegegevens – gebaseerd op het gebruik van platforms door werknemers (dwz onbewerkte meet- en bewakingsgegevens zoals locatiegegevens, telematica enz.)

3) Afgeleide gegevens – afgeleid van analyse van observatiegegevens (bijv. profilering van het gedrag van werknemers in de vorm van risico- en fraudebeoordelingen)

Artikel 22: Betrokkenen kunnen niet worden onderworpen aan beslissingen met juridische (of vergelijkbare significante) gevolgen, uitsluitend gebaseerd op de geautomatiseerde verwerking van gegevens.

[Als de verwerkingsverantwoordelijke gegevens verwerkt met de uitdrukkelijke toestemming van de betrokkene, of voor de uitvoering van een contract met hem, heeft de betrokkene het recht om menselijke tussenkomst te verkrijgen, zijn standpunt kenbaar te maken en de beslissing aan te vechten]

Artikel 15: Betrokkenen hebben het recht om een kopie van hun persoonsgegevens te ontvangen, samen met aanvullende informatie zoals de doeleinden van de gegevensverwerking, informatie over met wie de gegevens kunnen worden gedeeld, de duur van de verwerking enz.

Artikel 20 : Betrokkenen hebben het recht om persoonsgegevens die zij aan een verwerkingsverantwoordelijke hebben verstrekt te ontvangen in een gestructureerd, veelgebruikt en machineleesbaar formaat. Ze hebben ook het recht om de gegevens door te sturen ('porteren') naar een andere verwerkingsverantwoordelijke. Waar mogelijk kunnen ze vragen om de gegevens rechtstreeks van de ene controller naar de andere te verzenden.

Invoergegevens

Geleverd door de arbeiders zelf

geobserveerde gegevens

Gebaseerd op het gebruik van platforms door werknemers (dwz onbewerkte meet- en bewakingsgegevens zoals locatiegegevens, telematica enz.)

afgeleide gegevens

Afgeleid van analyse van observatiegegevens (bijv. profilering van werknemersgedrag in de vorm van risico- en fraudebeoordelingen)

Deze categorieën gegevens worden vaak expliciet gemaakt in begeleidingsdocumenten en privacybeleid, maar worden niet gedeeld met bestuurders wanneer ze hun gegevens downloaden of toegangsverzoeken indienen. Onze ervaring is dat wanneer werknemers deze informatie zoeken, gig-platforms ernaar streven het proces moeilijk en belastend te maken door zich bezig te houden met een verscheidenheid aan niet-conform gedrag. Werknemers die op zoek zijn naar uitgebreide gegevens, moeten navigeren door buitengewoon complexe en belemmerende website-architecturen en moeten verdere frustratie-inspanningen van ondersteuningsmedewerkers omzeilen, die onnodig eenvoudige administratieve processen verlengen of geautomatiseerde antwoorden geven die er niet in slagen om vragen adequaat te beantwoorden. Deze procedures kunnen worden omschreven als ' donkere patronen' die zijn ontworpen om werknemers weg te leiden van het uitoefenen van hun rechten als betrokkenen. Wanneer werknemers hun gegevens kunnen verkrijgen, ontbreken vaak aanzienlijke segmenten of worden ze gepresenteerd in inconsistente en niet-machineleesbare formaten, waardoor analyse feitelijk onmogelijk wordt. Deze daden van obstructie dwingen werknemers om herhaalde verzoeken in te dienen die bedrijven uiteindelijk gebruiken als reden om ze in diskrediet te brengen.

In alle DSAR-aangiften die we hebben gezien, heeft geen enkele werkgever een volledig en correct overzicht gegeven van geautomatiseerde verwerking van persoonsgegevens. Dit is met name belangrijk op gebieden die de zekerheid van werkgelegenheid kunnen bepalen, zoals werktoewijzing, prestatiebeheer, veiligheid en beveiliging, zoals besproken in dit rapport. Uber en Ola hebben in de rechtbank betoogd dat de veiligheid en beveiliging van hun platform in gevaar kan komen als de logica van dergelijke gegevensverwerking aan hun werknemers wordt bekendgemaakt. Naar onze mening kunnen veiligheid en beveiliging alleen worden verbeterd als platforms transparant regels en prestatienormen vaststellen in plaats van te vertrouwen op heimelijk toezicht en ontslag op staande voet, wat enkele van de belangrijkste drijfveren van DSAR's zijn.

Gezien deze hardnekkige houding ten opzichte van DSAR's, is het ook belangrijk op te merken dat veel chauffeurs bang zijn voor vergelding door bedrijven voor het doen van verzoeken. Wanneer gig-platforms buitensporige en langdurige identiteitscontroles uitvoeren als reactie op verzoeken om toegang tot subjecten, worden werknemers gemakkelijk ontmoedigd en geïntimideerd (zie e-mails die Uber naar chauffeurs stuurt in de casestudy's van platformrespons). Tijdens de talrijke interviews die we met chauffeurs hebben gehouden, is er vaak naar lange, bevestiging zoekende berichten, overgebracht in complexe juridische taal, verwezen als afschrikmiddel voor het nakomen van verzoeken. Voor veel chauffeurs is het volharden in het verzoek gelijk aan het met het hoofd boven de borstwering steken en iemands levensonderhoud en werkzekerheid op het spel zetten.

Deze perceptie komt vaak voort uit ervaringen van voortdurende uitbuiting en onveiligheid, als gevolg van het beperkte vermogen en de beperkte kennis van werknemers om democratische rechten uit te oefenen, zowel in het VK als immigranten of in hun thuisland, dat in veel gevallen autoritaire neigingen vertoont. In een personeelsbestand dat al sterk gefragmenteerd is en vatbaar is voor economische onzekerheid, waar de behoefte aan veiligheid veel groter is dan de wens om onrecht aan te vechten, kan de impact van dit soort vijandig gedrag van bedrijven niet worden overschat. Deze onzekerheid wordt nog verergerd door de ondoorzichtigheid van de beheeralgoritmen. Bij gebrek aan duidelijke uitleg over hoe black-box werktoewijzing of prestatiebeheersystemen werken, wordt het voor werknemers heel gemakkelijk om speculatief of zelfs samenzweerder te denken over hoe hun interacties met het platform hun werk beïnvloeden. Dit kan zich vervolgens uitstrekken tot een algemeen wantrouwen jegens andere instellingen en een afkeer van het organiseren van activiteiten. Dit zijn sterke en hardnekkige kwetsbaarheden binnen het personeelsbestand die bijzondere aandacht en beveiliging vereisen.

Casestudy's: individuele DSAR's

De volgende casestudy's laten een aantal manieren zien waarop Uber obstructief en niet-conform gedrag vertoont bij het reageren op gegevensverzoeken van werknemers. Het is opmerkelijk dat deze voorbeelden niet kunnen worden weggeredeneerd als uitzonderingen of geïsoleerde gebeurtenissen met betrekking tot onervaren ondersteuningsmedewerkers. Deze antwoorden vertegenwoordigen de standaardprocedures die Uber volgt wanneer werknemers hun gegevenstoegangsrechten willen uitoefenen.

Circulaire en zinloze antwoorden

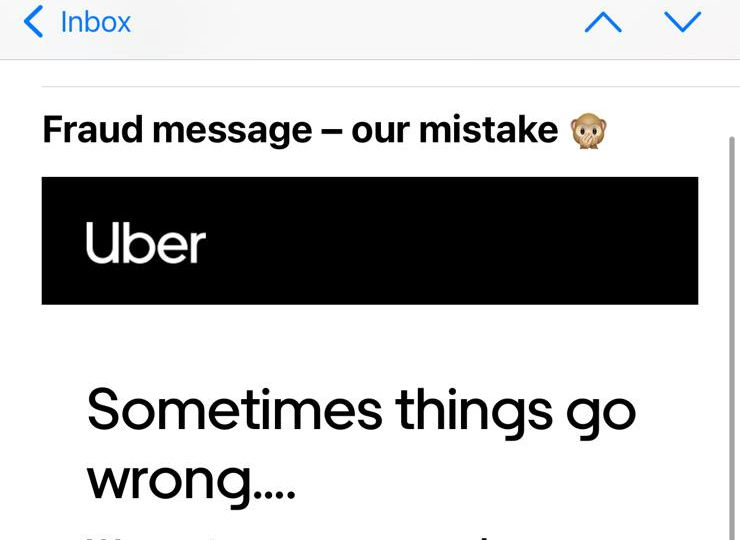

M. Ahmed is een voormalig Uber-chauffeur en Uber Eats-koerier. In oktober 2020 werden zowel zijn Uber-chauffeurs- als koeriersaccounts opgeschort en in februari 2021 werd zijn chauffeursaccount gedeactiveerd. Dit had ook gevolgen voor zijn UberEats-koeriersaccount, dat vervolgens werd gedeactiveerd en verwijderd.

Toen de heer Ahmed naar de reden van zijn ontslag vroeg, kreeg hij tegenstrijdige antwoorden. Uber noemde aanvankelijk mislukte gezichtsherkenningscontroles en beweerde later dat de deactivering te wijten was aan een groot aantal niet-bezorgde bestellingen. Tijdens de correspondentie spraken ze hem met de verkeerde naam aan en accepteerden ze uiteindelijk dat de berichten met betrekking tot de mislukte realtime ID-controles ten onrechte waren verzonden. De verwarring rond zijn ontslag bracht hem ertoe zijn persoonlijke gegevens op te vragen.

De afgelopen maanden heeft de heer Ahmed geprobeerd de gegevens op te halen die zijn gekoppeld aan zijn gedeactiveerde Uber Eats-account. De heer Ahmed probeerde op 15 april 2021 voor het eerst zijn gegevens te verkrijgen via het formulier 'Een privacyaanvraag indienen zonder een Uber-account' op de Uber-website, aangezien zijn account was verwijderd na zijn ontslag.

Als reactie ontving hij een e-mail van Uber waarin stond: “Onze privacyverklaring beperkt ons vermogen om informatie over rekeninghouders te delen. We kunnen deze informatie alleen verstrekken via het proces dat wordt beschreven in onze richtlijnen voor gegevensverzoeken.” Dit proces verwijst naar inloggen op het account en het verzoek indienen vanuit het account. "Dat gezegd hebbende, kunnen we via de juiste kanalen met u samenwerken om waar nodig te helpen."

De heer Ahmed schreef terug en vroeg om advies over hoe hij toegang kon krijgen tot de gegevens die zijn gekoppeld aan zijn nu verwijderde account. Hij legde uit dat hij aan het schrijven was vanuit het e-mailadres dat aan zijn Uber Eats-account was gekoppeld en dat hij ook het mobiele nummer had opgegeven dat aan dit account was gekoppeld. Hij voegde eraan toe dat hij graag meer informatie zou verstrekken om zijn identiteit te bevestigen.

Hierop ontving de heer Ahmed een reactie waarin stond dat zijn “bezorgdheid geen verband houdt met dit account. Schrijf ons alstublieft vanaf het betreffende account of meld u aan via help.uber.com met relevante inloggegevens en laat het ons weten over het probleem, zodat we u verder kunnen helpen.”

De heer Ahmed schreef terug en voegde een afbeelding bij van de onboarding-e-mail die Uber op 3 juli 2020 naar hem stuurde om aan te tonen dat hij aan het schrijven was vanaf het relevante account. Op 19 april 2021 ontving hij hetzelfde bericht waarin stond dat zijn "bezorgdheid geen verband houdt met dit account".

De heer Ahmed schreef terug en legde nogmaals uit dat hij geen toegang heeft tot zijn account en dat hij de details van zijn Uber Eats-account heeft verstrekt. Hij vroeg om advies over welke andere informatie hij zou kunnen verstrekken om zichzelf te identificeren. Hij kreeg geen reactie.

Op dat moment zocht de heer Ahmed hulp bij de App Drivers and Couriers Union en Worker Info Exchange en we hebben het probleem met Uber geëscaleerd. Op 11 mei 2021 ontving de heer Ahmed een e-mail van Uber waarin hem werd gevraagd het namens hem door ons gedane verzoek te bevestigen. Hij schreef terug waarin hij bevestigde dat hij ons zijn mandaat had gegeven en dat hij graag wilde dat zijn verzoek in behandeling werd genomen.

Op 14 mei 2021 ontving de heer Ahmed een identiteitsverificatieformulier van Uber om het verzoek te verwerken. Het formulier vroeg om dezelfde details die hij al in zijn eerdere berichten had gedeeld, zoals e-mail, telefoonnummer, land van verblijf, het type gevraagde gegevens. Het vroeg ook om zijn "huidige beoordeling" - die niet van toepassing was, omdat hij geen toegang meer had tot zijn account. De heer Ahmed stuurde het formulier naar Uber, maar hij kreeg geen antwoord.

Op 20 mei 2021 schreef de heer Ahmed Uber om bevestiging dat ze zijn verzoek aan het verwerken waren. Hij kreeg geen reactie.

Op het moment van schrijven heeft de heer Ahmed zijn gegevens niet ontvangen. Ook heeft hij geen uitleg gekregen waarom zijn verzoek niet in behandeling wordt genomen.

Inconsistent en incrementeel delen van gegevens

De heer Amini is een voormalig Uber-chauffeur die in november 2020 werd gedeactiveerd na een mislukte geolocatiecontrole . Uber meldde zijn ontslag aan TfL, die vervolgens de privéhuurlicentie van de heer Amini introk, waardoor hij zonder werk achterbleef. In een poging om de oorzaak van zijn ontslag te begrijpen, probeerde de heer Amini zijn gegevens van Uber te verkrijgen.

De heer Amini deed zijn eerste verzoek op 13 april 2021 en vroeg om al zijn persoonlijke gegevens, inclusief de 26 gegevenscategorieën die worden beschreven in het door Uber opgestelde richtsnoer , evenals de afbeeldingen die hij heeft ingediend als reactie op realtime ID-controles. Hij gaf aan dat hij gegevens wilde hebben over de hele periode dat hij actief was als Uber-chauffeur.

De heer Amini ontving op 5 mei 2021 een reactie op zijn verzoek, maar de verstrekte gegevens hadden alleen betrekking op de 30 dagen voorafgaand aan zijn verzoek. Omdat de heer Amini in deze periode niet voor Uber had kunnen werken, waren veel van de aangeleverde datasets blanco.

De heer Amini deed vervolgens op 6 mei 2021 opnieuw een verzoek, waarbij hij nogmaals verklaarde dat hij om gegevens vroeg over de hele periode dat hij met Uber heeft gewerkt, waarbij hij er specifiek aan toevoegde dat hij gegevens wenste die tot november 2020 werden verzameld.

De heer Amini ontving op 28 mei 2021 een reactie. Hij kreeg echter opnieuw onvolledige gegevens toegestuurd. In het bijzonder was de Driver Detail Device Data csv die door Uber werd geleverd, volledig leeg.

De heer Amini deed op 2 juni 2021 opnieuw een verzoek om de ontbrekende gegevens. Hij ontving zijn gedetailleerde apparaatgegevens voor november 2020 op 10 juni 2021. Ondanks dat hij had aangegeven dat hij alle gegevensvelden wilde hebben die in de door Uber geproduceerde richtlijnen worden vermeld, ontving hij echter een beperkte dataset waarin 32 van de 50 gegevens werden weggelaten. velden.

Verduistering en weerstand

De heer Majid is een voormalig Uber-chauffeur die in september 2020 werd gedeactiveerd na een mislukte geolocatiecontrole. Net als in het geval van de heer Amini, meldde Uber het ontslag van de heer Majid aan TfL, waardoor zijn privéhuurlicentie werd ingetrokken. In een poging om de basis van de beschuldigingen van Uber te begrijpen, probeerde hij zijn gegevens te verkrijgen.

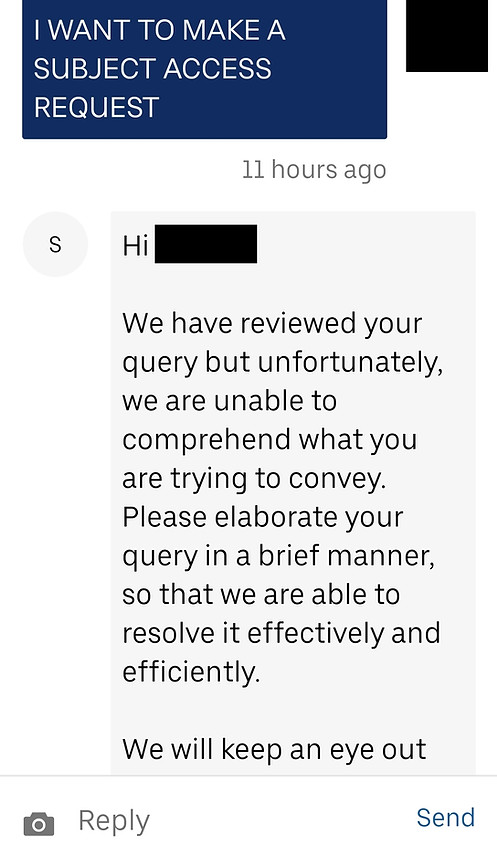

De heer Majid nam op 2 juni 2021 voor het eerst contact op met Uber om zijn gegevens op te vragen. In reactie daarop ontving hij een bericht waarin hem werd gevraagd zijn zorg in het kort uit te werken. De heer Majid antwoordde met zijn verzoek om 3 gegevenscategorieën (van de 26 categorieën die worden vermeld in de richtsnoeren van Uber) voor september 2020.

Op 8 juni 2021 ontving de heer Majid een bericht van Uber waarin stond: “Ons privacybeleid staat ons niet toe om wijzigingen aan te brengen of persoonlijke informatie te bespreken zonder contact via het e-mailadres dat is gekoppeld aan uw partneraccount. Om u te helpen met uw specifieke probleem, moet u zich aanmelden met het e-mailadres dat aan dat account is gekoppeld. Bedankt voor het begrip."

In dit stadium nam de heer Majid contact met ons op, verward, omdat hij vanaf zijn account naar Uber had geschreven. Hij schreef terug en legde aan Uber uit dat hij contact met hen had opgenomen door in te loggen op zijn chauffeursaccount, dus hij schreef zeker vanaf het juiste e-mailadres. Hij vroeg of hij aanvullende identificatie/documentatie kon overleggen om Uber te verzekeren dat hij degene was die het verzoek deed.

Als reactie kreeg hij hetzelfde bericht van Uber: “Hallo... bedankt voor je bericht. We begrijpen dat je informatie over een Uber-account wilt bespreken. Als u de accounthouder bent, schrijf dan in vanaf het e-mailadres dat is gekoppeld aan uw Partner-Driver-account, dan kunnen we u meteen helpen.'

Op 09 juni 2021 logde de heer Majid in op zijn partneraccount en begon een chat met Uber-ondersteuning om het opnieuw te proberen. Zijn bericht met de vraag of hij een verzoek om toegang tot het onderwerp kon indienen, werd genegeerd.

Op 14 juni 2021 nam de heer Majid opnieuw contact op met Uber, met de mededeling dat hij een vraag had over zijn chauffeurspartneraccount. Hij ontving een reactie van Uber: "Bedankt voor het contact... We hebben van de gelegenheid gebruik gemaakt om uw bezorgdheid te beoordelen en kunnen zien dat u eerder contact met ons heeft opgenomen over dit probleem. Een van onze teamleden onderzoekt momenteel uw probleem en we nemen zo snel mogelijk contact met u op. Om onze communicatie te stroomlijnen en verwarring te voorkomen, gaan we door met het beëindigen van dit contact.”

Op 16 juni 2021 nam de heer Majid opnieuw contact op met Uber, waarbij hij verklaarde dat hem was gevraagd in te loggen op zijn account om een verzoek in te dienen, en nadat hij dit had gedaan, wilde hij details van zijn verzoek delen. Hij ontving de volgende dag een reactie en stuurde vervolgens op 18 juni 2021 de details van het verzoek (van de drie hierboven genoemde datasets).

Toen hij geen antwoord kreeg, nam de heer Majid op 28 juni 2021 opnieuw contact op met Uber om te bevestigen dat zijn verzoek werd verwerkt. Op 1 juli 2021 ontving hij een antwoord waarin stond dat zijn bezorgdheid was geuit bij het gespecialiseerde team en dat zij contact zouden opnemen om het verder te onderzoeken.

Op 2 juli 2021 ontving de heer Majid een reactie op de berichtenreeks die hij op 09 juni 2021 had gestart. In dit bericht stond dat Uber vereist dat verzoeken persoonlijk worden betekend aan het postadres van Uber BV in Nederland.

De heer Majid heeft geen verdere communicatie ontvangen.

“De kwestie van algoritmen staat centraal in het thema uberisatie. Te vaak is het het algoritme dat de echte rol van de baas speelt, aangezien technologie nieuwe middelen biedt voor de ondergeschiktheid van arbeiders. Er is duidelijk behoefte aan transparantie van algoritmisch beheer, maar naast deze transparantie is er ook behoefte aan medebeheer van het algoritme. Werknemersvertegenwoordigers moeten kunnen deelnemen aan hun ontwikkeling."

Leïla Chaibi, EP-lid

Casestudy's: Platformreacties op

Batchverzoeken door Worker Info Exchange

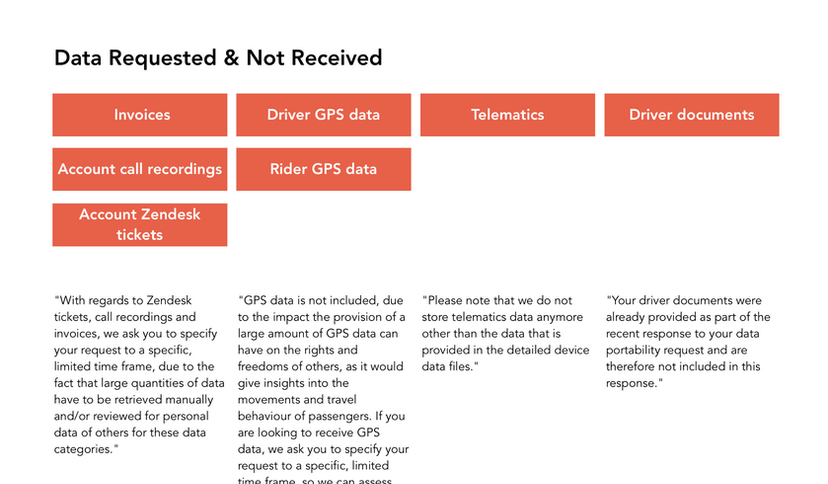

Zoals blijkt uit de bovenstaande voorbeelden, kunnen de individuele aanvraagprocessen extreem tijdrovend en capaciteitsintensief zijn. We hebben daarom processen gecreëerd waarmee we batchverzoeken kunnen doen namens chauffeurs en deze complexe procedure kunnen stroomlijnen. We hebben een systeem opgezet met behulp van de door Scrive ontwikkelde elektronische handtekening- en ID-oplossing om een wettelijk mandaat van werknemers te ontvangen om namens hen verzoeken in te dienen. Deze oplossing omvat ook een ID-verificatie uitgevoerd door Onfido (dezelfde ID-verificatieservice die door Uber wordt gebruikt), om ervoor te zorgen dat zowel wij als de gegevensbeheerder zeker kunnen zijn van de identiteit van de aanvrager en hun gegevensprivacy kunnen behouden. De identiteitsverificatie vereist dat de werknemers een van de volgende identiteitsdocumenten overleggen: paspoort, rijbewijs, identiteitskaart of verblijfsvergunning. Door dit proces wordt voor elke persoon een individueel toestemmingsdocument gemaakt dat elektronisch is verzegeld en verifieerbaar door verborgen bijlagen met een bewijslogboek om de authenticiteit van het identificatieproces te bewijzen. (Scrive biedt ook een service om de integriteit van de toestemmingsformulieren te verifiëren, waarnaar in de documenten is gelinkt.) We sturen deze documenten samen met een spreadsheet met de namen, e-mails, adressen en telefoonnummers van de werknemers die verzoeken indienen.

Sommige bedrijven zijn ontvankelijk en coöperatief geweest bij het reageren op verzoeken die via deze procedure zijn gedaan, terwijl andere zich veel meer belemmerend en vijandig hebben gedragen. Maar zelfs wanneer bedrijven aan de verzoeken hebben voldaan, zijn er consistente problemen geweest bij het vaststellen van de precieze verzamelde gegevenscategorieën en het verkrijgen van alle gevraagde gegevens in een gestructureerd en machineleesbaar formaat. Er zijn maar weinig bedrijven in staat geweest om begeleidingsdocumenten te verstrekken met duidelijke beschrijvingen van de gegevenscategorieën, en de gegevens die we hebben ontvangen vertoonden vaak significante tegenstrijdigheden met de verwerking die wordt beschreven in het privacybeleid. Over het algemeen hebben bedrijven de neiging getoond om de gegevenspraktijken die ze niet openbaar willen maken te ontkennen. In één geval beweerde een bedrijf dat de fraudebeoordeling waarnaar in hun privacybeleid wordt verwezen, alleen was uitgevoerd als onderdeel van een proef en dat het privacybeleid verouderd was. Een ander verwees ons naar een document waarvan zij beweerden dat het het document waarop we ons verzoek baseerden, had vervangen, ook al waren beide documenten op dezelfde datum bijgewerkt.

Ondanks deze moeilijkheden was de meest controversiële tegenwerking waarmee we te maken hebben gehad de ontzegging van ons recht om namens de werknemers op te treden bij het indienen van verzoeken om toegang tot personen als derde partij. Dit ondubbelzinnige recht (duidelijk vermeld in de richtlijnen van de ICO en zelfs gepromoot door het hervormingsvoorstel van de regering van de AVG) werd door zowel Bolt als Uber in twijfel getrokken. Hoewel het duidelijk is dat de weerstand het verzoekproces frustreert, wijst het ook op een belangrijke leemte in de bestaande richtlijnen voor identiteitsverificatieprocessen. Wanneer bedrijven aandringen op het uitvoeren van identiteitscontroles door direct contact te leggen met werknemers en hen te onderwerpen aan juridisch complexe correspondentie, ontkent dit grotendeels het doel om een beroep te doen op derden voor verzoeken. Er is hier een zorgwekkend conflict tussen de rechten van de respectieve partijen die dringende regelgeving vereist om ervoor te zorgen dat het niet wordt misbruikt en gemanipuleerd om de informatieasymmetrieën te verdiepen.

Deliveroo