Contenuti

Contenuti

Riepilogo

Parte I: Classificazione errata 2.0: Controllata dall'algoritmo

Caso di studio di sorveglianza I: mancato riconoscimento facciale

Caso di studio di sorveglianza II: controlli di geolocalizzazione

Gestione opaca delle prestazioni

Caso di studio: controllo algoritmico

Espansione delle infrastrutture delle forze dell'ordine

Caso di studio: condivisione dell'intelligence con le forze dell'ordine

Parte II: Esercizio dei diritti sui dati sul lavoro: accesso

Casi di studio: DSAR individuali

Condivisione dati incoerente e incrementale

Casi di studio: risposte della piattaforma alle richieste batch di WIE

Parte III: Esercizio dei diritti sui dati sul lavoro: contenzioso

Driver Uber contro Uber I (richieste di trasparenza generale)

Ola driver v. Ola (richieste di trasparenza generale)

Driver Uber contro Uber II (trasparenza sul processo decisionale automatizzato)

Casi di ricorso per licenza di Londra

Conclusione: la strada da percorrere per esercitare i diritti digitali sul lavoro?

Riepilogo

Worker Info Exchange è stato istituito per facilitare l'accesso e la collettivizzazione dei dati per costruire potere contrattuale attraverso l'istituzione di un trust di dati.

Ciò è avvenuto in risposta allo sviluppo di nuove pratiche di gestione algoritmica che creano profonde asimmetrie informative e sfruttamento dei lavoratori.

Worker Info Exchange mira ad affrontare la convergenza dei dati e dei diritti dei lavoratori invocando i diritti degli articoli 15, 20 e 22 del GDPR nei contesti di lavoro.

Questo obiettivo è gravemente ostacolato dalla diffusa non conformità al GDPR in tutto il settore dei concerti.

Abbiamo effettuato oltre 500 richieste di accesso ai dati personali negli ultimi otto mesi a sette diverse piattaforme di condivisione del viaggio tra cui Amazon Flex, Bolt, Deliveroo, Free Now, Just Eat, Ola e Uber.

L'accesso ai dati è messo in discussione dalle aziende che implementano modelli oscuri e abusano deliberatamente dell'implementazione irregolare del GDPR, che spinge i lavoratori a risolvere i problemi in tribunale.

La raccolta di dati da parte delle piattaforme di concerti è eccessiva e porta a una sorveglianza sproporzionata e irresponsabile dei lavoratori, nonché a un'infrastruttura in espansione delle forze dell'ordine.

Non c'è trasparenza sui sistemi di gestione algoritmica utilizzati. Le narrazioni aziendali su quali tecnologie vengono utilizzate e come sono incoerenti e inaffidabili.

© 2021 Scambio di informazioni sui lavoratori

© 2021 Scambio di informazioni sui lavoratori

introduzione

L'anno passato ha segnato un punto di svolta per i lavoratori della piattaforma gig nella realizzazione dei loro diritti occupazionali e digitali. La pratica del lavoro mediato digitalmente ha portato a una convergenza dei diritti del lavoro e della protezione dei dati e la crescente attività di contenzioso e di advocacy da parte dei lavoratori ha prodotto risultati in questi ambiti. In tutta Europa, i tribunali hanno emesso diverse sentenze significative che riconoscono il ruolo di sfruttamento delle pratiche di gestione algoritmica da parte delle piattaforme gig, condannando anche la mancanza di equità e trasparenza in tali sistemi automatizzati.

In Italia, il tribunale di Bologna ha stabilito che il sistema di rating di Deliveroo ha discriminato i lavoratori mentre l'autorità per la protezione dei dati, Garante, ha notificato due sanzioni GDPR a Deliveroo e Glovo a causa della loro incapacità di divulgare adeguatamente il funzionamento dei loro algoritmi di assegnazione dei lavori e di gestione delle prestazioni.

La Spagna ha approvato la prima legge per tentare di regolamentare l'IA in materia di occupazione, stabilendo sia lo status di lavoratore per i gig worker sia il diritto di essere informati sulle regole e i parametri degli algoritmi a cui sono soggetti, scatenando un torrente di lamentele. Ciò è il risultato di un altro caso giudiziario contro Glovo che è finito nella Corte Suprema spagnola.

Insieme a queste decisioni di alto profilo, la Corte Suprema del Regno Unito ha anche concluso quest'anno che i conducenti di Uber erano parte di un servizio di trasporto che è " molto strettamente definito e controllato da Uber " tradendo un chiaro rapporto di lavoro, che la società sosteneva non esistesse in il suo tentativo di (erroneamente) classificare i lavoratori come appaltatori indipendenti. Significativamente, la prova di questa relazione proviene dai sistemi basati sui dati che le piattaforme di rideshare utilizzano per gestire la propria forza lavoro. Alcune delle problematiche evidenziate dalla Corte Suprema del Regno Unito relative alla gestione degli autisti attraverso il monitoraggio algoritmico dei tassi di accettazione del lavoro, delle scelte di percorso, del comportamento di guida e delle valutazioni dei clienti. Tuttavia, anche se c'è un maggiore riconoscimento della gestione algoritmica, i recenti successi nei tribunali non proteggono completamente i lavoratori dai suoi danni. Lo status di lavoratore arto (b) concesso agli autisti Uber a seguito della decisione della Corte Suprema è uno status intermedio tra appaltatore e dipendente , e non riesce ancora a proteggerli da licenziamenti illegittimi, ad esempio.

La nostra esperienza suggerisce che questi strumenti di gestione algoritmica, con l'aggiunta di intensificare le pratiche di sorveglianza, scrutando continuamente i lavoratori per potenziali frodi o illeciti, stanno dando luogo a un ambiente di lavoro profondamente sfruttatore. Stiamo assistendo a un numero eccessivo di licenziamenti automatizzati nell'intero settore dei concerti, molti dei quali riteniamo siano illegali ai sensi dell'articolo 22 del Regolamento generale sulla protezione dei dati (GDPR) . L'articolo 22 fornisce ai lavoratori alcune protezioni limitate contro gli effetti negativi del processo decisionale automatizzato e della profilazione, attraverso il diritto di ottenere l'intervento umano e contestare la decisione. L'articolo 15 del GDPR garantisce il diritto di essere informato sull'esistenza di tale processo decisionale automatizzato e di ricevere informazioni significative sulla logica del trattamento.

Prendendo come base questi diritti, Worker Info Exchange è stato creato con la missione di supportare i gig worker nella navigazione in questo spazio complesso e poco regolamentato. L'obiettivo e il compito del nostro lavoro è verificare se questi strumenti GDPR possono essere utilizzati per affrontare pratiche di lavoro sleali ed espandere la portata dei dati messi a disposizione degli individui nella loro qualità di lavoratori. In altre parole, la nostra ambizione è utilizzare l'accesso ai dati come metodo per costruire il potere collettivo dei lavoratori per testare i meccanismi di ricorso in un mercato del lavoro mediato digitalmente.

Quando il rapporto di lavoro tra la piattaforma gig e il lavoratore viene eseguito attraverso un'ampia raccolta e analisi di dati, i diritti del lavoro diventano indissolubilmente legati all'esercizio dei diritti sui dati. Le piattaforme gig affermano il controllo sui lavoratori mantenendo un'asimmetria informativa e l'accesso ai dati può fornire un mezzo per esporre il potere (squilibrio) generato dal divario informativo tra le piattaforme gig e i loro lavoratori. L'accesso ai dati personali può consentire ai lavoratori di effettuare valutazioni indipendenti sulle proprie condizioni di lavoro e rispondere a domande relative al calcolo della retribuzione, alla qualità e alla quantità del lavoro offerto, nonché contestare i motivi della gestione delle prestazioni negative, compresa la sospensione e licenziamento.

Il nostro obiettivo nel facilitare l'accesso ai dati è creare archivi collettivi di dati per sviluppare una maggiore comprensione delle condizioni di lavoro e, di conseguenza, del potere contrattuale. Negli ultimi anni sono emerse alcune iniziative degne di nota che operano con finalità simili ma utilizzando metodologie differenti per il recupero dei dati. Alcuni progetti in questo campo eseguono la propria raccolta di dati e analisi su guadagni e prestazioni per valutare l'equità delle condizioni di lavoro (ad esempio Driver's Seat Coop e WeClock, tra gli altri.) Questi tutti presentano intuizioni uniche nella gig economy e dovrebbero essere considerati come un continuum di pratica dei dati. Abbiamo affrontato questo problema chiedendo che le piattaforme condividano i dati a cui i lavoratori hanno diritto legalmente, tuttavia ciò ha introdotto ulteriori ostacoli all'obiettivo più ampio della collettivizzazione dei dati. Abbiamo intrapreso questa strada perché volevamo stabilire standard e precedenti nella normativa sulla protezione dei dati, ma anche perché riteniamo che alcune tipologie di informazioni si possano ottenere solo richiedendo i dati direttamente dalle piattaforme.

Abbiamo riscontrato, in particolare nel caso di accuse alimentate dalla sorveglianza di attività irregolari e frodi, che è necessario disporre dei dati in possesso delle società per comprendere e contestare le accuse. L'accesso ai dati può aiutarci a portare alla luce le incongruenze nelle narrazioni avanzate dalle società di piattaforme e aiutare a spostare l'onere della prova dai lavoratori alle piattaforme. Da questo punto di vista, lo sforzo di richiedere dati sulla piattaforma si è dimostrato estremamente efficace nella risoluzione di numerose controversie sul lavoro. La semplice dimostrazione del rifiuto delle piattaforme di fornire i dati personali ha annullato diverse revoche di licenza (applicate da TfL) in tribunale e diventa quindi uno strumento aggiuntivo nell'esercizio dei diritti del lavoro.

Questo costituisce l'altro ramo di attività per Worker Info Exchange; poiché siamo frustrati nei nostri tentativi di ottenere chiarezza e trasparenza sui complessi sistemi che determinano le condizioni del luogo di lavoro, abbiamo spesso bisogno di ricorrere a contenziosi e rivolgerci ai tribunali per decisioni nel campo emergente dei diritti del lavoro digitale. L'artificiale "crisi dei dati" che le piattaforme di concerti hanno creato è per molti versi un tentativo di esaurire e impoverire le risorse dei lavoratori precari e dei sindacati, attirando le controversie nei tribunali dove possono essere prolungate e la responsabilità per cattiva condotta aziendale ritardata.

In linea con questi filoni di attività, questo rapporto è scritto in tre parti: La prima sezione esplora diversi aspetti della gestione algoritmica e dei suoi danni, con studi di casi associati. La seconda sezione tratta del nostro processo di utilizzo delle richieste di accesso ai dati (DSAR) mentre la terza offre una panoramica dei casi relativi al GDPR che abbiamo portato avanti ad Amsterdam e dei casi di licenza che stiamo supportando a Londra. Questo rapporto conclude un periodo di lavoro rivolto a queste funzioni della nostra organizzazione, svolto con il supporto di Mozilla Foundation, Digital Freedom Fund e Open Society Foundations. Ci auguriamo che questo rapporto dimostri lo stato attuale dell'esercizio dei diritti all'intersezione di dati e lavoro e riveli gli effetti cumulativi di ripetute non conformità da parte delle piattaforme di concerti.

"Le società di piattaforme operano in uno spazio senza legge in cui credono di poter stabilire le regole. Sfortunatamente questo non è un gioco; le realtà virtuali hanno dure conseguenze per i gig worker nella vita reale. Ciò che è incoraggiante è che i lavoratori stessi non aspettano le leggi, politici o persino alleati del movimento per i diritti umani per salvarli. I gig worker si stanno organizzando e usando la loro voce collettiva per chiedere nuove protezioni adatte allo scopo in un'economia digitalizzata".

Bama Athreya, Fellow, Open Society Foundations

Parte I: Classificazione errata 2.0 Controllato da Algoritmo

Nella battaglia di sei anni per i diritti dei lavoratori nella gig economy del Regno Unito, Uber ha sostenuto che era semplicemente l'agente dell'autista autonomo che non faceva altro che prenotare passivamente gli ordini di lavoro e riscuotere i pagamenti. Per far progredire questa finzione, le piattaforme dei concerti stabiliscono contratti elaborati che fanno sembrare che il conducente e il passeggero stiano effettuando transazioni direttamente tra loro, quando in realtà tutte le informazioni sui passeggeri sono strettamente protette dalle aziende. Uber, ad esempio, genera una fattura fittizia per conto del conducente per ogni passeggero che trasporta. La fattura riporterà solo il nome del passeggero e non viene mai effettivamente inviata al cliente.

Queste tecniche di classificazione errata, comunemente utilizzate nella gig economy, consentono alle piattaforme di evitare le responsabilità legali dei datori di lavoro come le protezioni dei diritti fondamentali dei lavoratori e i contributi assicurativi nazionali. Nel Regno Unito ha anche consentito alle società di piattaforme di evitare l'imposta sul valore aggiunto sulle vendite (IVA). Ma all'inizio di quest'anno, la Corte Suprema ha affermato il diritto dei tribunali inferiori di scartare i contratti artificiali e di determinare la vera natura del rapporto di lavoro sulla base dell'evidenza di un rapporto di gestione di controllo sui lavoratori.

Poiché le società di piattaforme concludono che l'utilizzo di contratti ingannevoli non è più praticabile come metodo di classificazione errata dell'occupazione, saranno tentate di raddoppiare l'automazione dei processi per l'occultamento del controllo di gestione. Il controllo algoritmico diventa misclassificazione 2.0. In effetti, ci sono ampie prove che ciò stia già accadendo. Le piattaforme di concerti sono più determinate che mai a perseguire strategie di classificazione errata in modo da poter continuare a controllare la forza lavoro evitando il rischio che i conducenti possano passare dallo stato di "lavoratore" con diritti limitati allo stato di lavoratore con sostanzialmente più diritti.

Quindi cos'è il controllo algoritmico e quali sono i rischi specifici per i gig worker? Nei settori del ride-sharing e delle consegne, in particolare, i mezzi di gestione algoritmica di maggiore interesse per noi includono quanto segue:

Sorveglianza. Sorveglianza intrusiva per lo scopo dichiarato di sicurezza e identificazione. Ciò comprende l'uso di tecnologie di rilevamento delle frodi e di riconoscimento facciale. Siamo consapevoli che la sorveglianza viene condotta anche quando il lavoratore non ha effettuato il login per rendersi disponibile al lavoro. Comprendeva anche la sorveglianza dell'utilizzo dell'app da parte del lavoratore come consumatore.

Gestione delle prestazioni. Ciò include ma non è limitato al monitoraggio del comportamento di guida, inclusi ETA, valutazioni dei clienti, tassi di accettazione e completamento del lavoro, interazione con il personale di supporto, disponibilità.

Allocazione del lavoro. Fino a poco tempo fa Uber ha insistito sul fatto che l'assegnazione del lavoro fosse decisa in base alla vicinanza reciproca di conducenti e passeggeri, tuttavia ora ammette che il comportamento e le preferenze del passato sono presi in considerazione. Ola ammette che i profili dei conducenti che includono il punteggio "profilo di guadagno" e "probabilità di frode" sono utilizzati nel processo decisionale automatizzato di allocazione del lavoro.

Prezzi. Strettamente correlato all'allocazione del lavoro è il processo decisionale automatizzato dei prezzi. Forse il metodo più noto è il cosiddetto "surge" o "prezzo dinamico" di Uber che pretende di eliminare la domanda del mercato con fluttuazioni dei prezzi locali in tempo reale.

Le decisioni di gestione di cui sopra sono per lo più automatizzate o semiautomatiche con un intervento umano limitato. I modelli di business della gig economy si basano sull'automazione di massa delle decisioni gestionali e sulla supervisione del posto di lavoro. Mentre alcuni datori di lavoro sono reticenti su questo punto, Deliveroo è stato piuttosto schietto a riguardo nella loro politica sulla privacy dei ciclisti:

“Dato il volume delle consegne di cui ci occupiamo, utilizziamo sistemi automatizzati per prendere le decisioni automatizzate sopra descritte in quanto forniscono un modo più accurato, equo ed efficiente per identificare sospette frodi, prevenire ripetute violazioni del Contratto con i fornitori e limitare l'impatto negativo su nostro servizio. I controlli umani semplicemente non sarebbero possibili nei tempi e dati i volumi di consegne di cui ci occupiamo”.

Gestione delle prestazioni

Ciò include, a titolo esemplificativo ma non esaustivo, il monitoraggio del comportamento alla guida, inclusi ETA, valutazioni dei clienti, tassi di accettazione e completamento del lavoro, interazione con il personale di supporto, disponibilità.

Prezzo

Strettamente correlato all'allocazione del lavoro è il processo decisionale automatizzato sui prezzi. Forse il metodo più noto è il cosiddetto "surge" o "prezzi dinamici" di Uber che pretende di compensare la domanda del mercato con fluttuazioni dei prezzi locali in tempo reale.

Sorveglianza

Sorveglianza intrusiva per lo scopo dichiarato di sicurezza e identificazione. Ciò comprende l'uso di tecnologie di rilevamento delle frodi e riconoscimento facciale. Siamo consapevoli che la sorveglianza viene svolta anche quando il lavoratore non ha effettuato il login per rendersi disponibile al lavoro. Comprendeva anche la sorveglianza dell'utilizzo dell'app da parte del lavoratore come consumatore.

Assegnazione del lavoro

Fino a poco tempo Uber ha insistito sul fatto che l'assegnazione del lavoro fosse decisa in base alla vicinanza di conducenti e passeggeri l'uno all'altro, tuttavia ora ammette che il comportamento e le preferenze del passato vengono presi in considerazione. Ola ammette che i profili del conducente che includono il punteggio "profilo di guadagno" e "probabilità di frode" sono utilizzati nel processo decisionale automatizzato di allocazione del lavoro.

Parte I: Classificazione errata 2.0 Controllato da Algoritmo

Nella battaglia di sei anni per i diritti dei lavoratori nella gig economy del Regno Unito, Uber ha sostenuto che era semplicemente l'agente dell'autista autonomo che non faceva altro che prenotare passivamente gli ordini di lavoro e riscuotere i pagamenti. Per far progredire questa finzione, le piattaforme dei concerti stabiliscono contratti elaborati che fanno sembrare che il conducente e il passeggero stiano effettuando transazioni direttamente tra loro, quando in realtà tutte le informazioni sui passeggeri sono strettamente protette dalle aziende. Uber, ad esempio, genera una fattura fittizia per conto del conducente per ogni passeggero che trasporta. La fattura riporterà solo il nome del passeggero e non viene mai effettivamente inviata al cliente.

Queste tecniche di classificazione errata, comunemente utilizzate nella gig economy, consentono alle piattaforme di evitare le responsabilità legali dei datori di lavoro come le protezioni dei diritti fondamentali dei lavoratori e i contributi assicurativi nazionali. Nel Regno Unito ha anche consentito alle società di piattaforme di evitare l'imposta sul valore aggiunto sulle vendite (IVA). Ma all'inizio di quest'anno, la Corte Suprema ha affermato il diritto dei tribunali inferiori di scartare i contratti artificiali e di determinare la vera natura del rapporto di lavoro sulla base dell'evidenza di un rapporto di gestione di controllo sui lavoratori.

Poiché le società di piattaforme concludono che l'utilizzo di contratti ingannevoli non è più praticabile come metodo di classificazione errata dell'occupazione, saranno tentate di raddoppiare l'automazione dei processi per l'occultamento del controllo di gestione. Il controllo algoritmico diventa misclassificazione 2.0. In effetti, ci sono ampie prove che ciò stia già accadendo. Le piattaforme di concerti sono più determinate che mai a perseguire strategie di classificazione errata in modo da poter continuare a controllare la forza lavoro evitando il rischio che i conducenti possano passare dallo stato di "lavoratore" con diritti limitati allo stato di lavoratore con sostanzialmente più diritti.

Quindi cos'è il controllo algoritmico e quali sono i rischi specifici per i gig worker? Nei settori del ride-sharing e delle consegne, in particolare, i mezzi di gestione algoritmica di maggiore interesse per noi includono quanto segue:

Sorveglianza. Sorveglianza intrusiva per lo scopo dichiarato di sicurezza e identificazione. Ciò comprende l'uso di tecnologie di rilevamento delle frodi e di riconoscimento facciale. Siamo consapevoli che la sorveglianza viene condotta anche quando il lavoratore non ha effettuato il login per rendersi disponibile al lavoro. Comprendeva anche la sorveglianza dell'utilizzo dell'app da parte del lavoratore come consumatore.

Gestione delle prestazioni. Ciò include ma non è limitato al monitoraggio del comportamento di guida, inclusi ETA, valutazioni dei clienti, tassi di accettazione e completamento del lavoro, interazione con il personale di supporto, disponibilità.

Allocazione del lavoro. Fino a poco tempo fa Uber ha insistito sul fatto che l'assegnazione del lavoro fosse decisa in base alla vicinanza reciproca di conducenti e passeggeri, tuttavia ora ammette che il comportamento e le preferenze del passato sono presi in considerazione. Ola ammette che i profili dei conducenti che includono il punteggio "profilo di guadagno" e "probabilità di frode" sono utilizzati nel processo decisionale automatizzato di allocazione del lavoro.

Prezzi. Strettamente correlato all'allocazione del lavoro è il processo decisionale automatizzato dei prezzi. Forse il metodo più noto è il cosiddetto "surge" o "prezzo dinamico" di Uber che pretende di eliminare la domanda del mercato con fluttuazioni dei prezzi locali in tempo reale.

Le decisioni di gestione di cui sopra sono per lo più automatizzate o semiautomatiche con un intervento umano limitato. I modelli di business della gig economy si basano sull'automazione di massa delle decisioni gestionali e sulla supervisione del posto di lavoro. Mentre alcuni datori di lavoro sono reticenti su questo punto, Deliveroo è stato piuttosto schietto a riguardo nella loro politica sulla privacy dei ciclisti:

“Dato il volume delle consegne di cui ci occupiamo, utilizziamo sistemi automatizzati per prendere le decisioni automatizzate sopra descritte in quanto forniscono un modo più accurato, equo ed efficiente per identificare sospette frodi, prevenire ripetute violazioni del Contratto con i fornitori e limitare l'impatto negativo su nostro servizio. I controlli umani semplicemente non sarebbero possibili nei tempi e dati i volumi di consegne di cui ci occupiamo”.

"Dato il volume delle consegne con cui ci occupiamo, utilizziamo sistemi automatizzati per prendere le decisioni automatizzate sopra descritte in quanto forniscono un modo più accurato, equo ed efficiente per identificare sospette frodi, prevenire ripetute violazioni del contratto con il fornitore e limitare l'impatto negativo su nostro servizio. I controlli umani semplicemente non sarebbero possibili nei tempi e dati i volumi di consegne con cui ci occupiamo”.

Sorveglianza

Sorveglianza intrusiva per lo scopo dichiarato di sicurezza e identificazione. Ciò comprende l'uso di tecnologie di rilevamento delle frodi e riconoscimento facciale. Siamo consapevoli che la sorveglianza viene svolta anche quando il lavoratore non ha effettuato il login per rendersi disponibile al lavoro. Include anche la sorveglianza dell'utilizzo dell'app da parte del lavoratore come consumatore.

Assegnazione del lavoro

Fino a poco tempo Uber ha insistito sul fatto che l'assegnazione del lavoro fosse decisa in base alla vicinanza di conducenti e passeggeri tra loro, tuttavia ora afferma che il comportamento e le preferenze passate sono presi in considerazione. Ola utilizza profili di guida che includono "punteggi di probabilità di frode" nel processo decisionale automatizzato per il lavoro assegnazione.

Gestione delle prestazioni

La valutazione delle prestazioni lavorative include, a titolo esemplificativo ma non esaustivo, il monitoraggio del comportamento alla guida, inclusi ETA, valutazioni dei clienti, tassi di accettazione e completamento del lavoro, interazione con il personale di supporto, disponibilità.

Prezzo

Strettamente correlato all'allocazione del lavoro è l'impostazione automatizzata dei prezzi. Forse il metodo più noto è il cosiddetto "surge" o "prezzi dinamici" di Uber che pretende di eliminare la domanda del mercato con fluttuazioni dei prezzi locali in tempo reale.

Corsa agli armamenti di sorveglianza

Abbiamo assistito a una corsa agli armamenti di sorveglianza nella gig economy da quando Uber ha introdotto il suo cosiddetto sistema ibrido di identificazione in tempo reale nel 2020. Solo un giorno prima che Transport for London (TfL) annunciasse la sua decisione di rifiutare il rinnovo della licenza nel novembre 2019, Uber si è offerta di introdurre questo sistema di sorveglianza che incorpora il riconoscimento facciale con il monitoraggio GPS.

Ciò è avvenuto in risposta alla denuncia di TfL secondo cui 21 conducenti erano stati rilevati (su 90.000 analizzati in diversi anni) come impegnati nella condivisione di account che consentivano ai conducenti potenzialmente privi di licenza e non assicurati di offrire illegalmente i propri servizi sull'app. L'attività è stata resa possibile reimpostando la posizione GPS del dispositivo al di fuori del Regno Unito, dove è possibile per i conducenti caricare le proprie foto. Questo divario è stato rapidamente colmato da Uber e l'attività rilevata è stata incredibilmente piccola rispetto alla scala delle operazioni di Uber. L'introduzione della tecnologia di riconoscimento facciale da parte dell'industria è stata del tutto sproporzionata rispetto al rischio percepito. Tuttavia, il requisito per l'identificazione in tempo reale è diventato una condizione per il rinnovo della licenza di Uber presso la Westminster Magistrates Court nel settembre 2020.

Nel caso di Uber, sia la gestione della piattaforma che TfL non sono riusciti a garantire che fossero messe in atto tutele adeguate per proteggere i diritti e le libertà dei conducenti nonostante TfL avesse esaminato la valutazione d'impatto sulla protezione dei dati per la tecnologia nel marzo 2020. Abbiamo fatto un libertà di informazione richiesta a TfL di avere accesso alla DPIA di Uber per i sistemi di identificazione in tempo reale ma ci è stato negato. Secondo i rapporti di TfL , il 94% dei conducenti di veicoli a noleggio privati (PHV) proviene da ambienti di minoranza etnica e nera e l'introduzione di questa tecnologia, che è ben nota per i suoi bassi tassi di precisione all'interno di questi gruppi , si è rivelata disastrosa per i lavoratori vulnerabili già in lavoro precario.

Da allora Bolt ha annunciato che stava investendo 150 milioni di euro in sistemi di rilevamento antifrode dei conducenti di intelligenza artificiale, incluso il riconoscimento facciale. Deliveroo ha annunciato che anche loro avrebbero introdotto controlli di identità con riconoscimento facciale. Ola Cabs ha anche implementato l' identificazione con riconoscimento facciale come caratteristica del suo sistema Guardian , incorporando l'apprendimento automatico che secondo loro consente loro di "apprendere ed evolversi continuamente da milioni di punti dati ogni singolo giorno, per migliorare la segnalazione del rischio e la risoluzione istantanea".

FreeNow, una joint venture tra Daimler e BMW, sorveglia da vicino i conducenti come parte del loro programma di prevenzione delle frodi. Infatti, i documenti depositati da FreeNow con l'Alta Corte in una revisione giudiziaria della decisione di TfL di concedere loro una licenza a Londra, hanno rivelato che TfL ha reso rapporti mensili di licenziamenti di conducenti per vari motivi (tra cui "attività fraudolenta") una condizione della loro recente rinnovo della patente. Ma la descrizione dei dati elaborati ai fini della prevenzione delle frodi solleva più domande di quelle a cui risponde la politica sulla privacy di FreeNow.

In questo documento, Free Now afferma che utilizzano un algoritmo di "foresta casuale" per produrre un punteggio di frode che utilizzano per " dare priorità ai viaggi spediti di conseguenza. Ciò garantisce una spedizione equa e con rischi ridotti al minimo ”. Free Now ha contestato il loro utilizzo di questo sistema di rilevamento delle frodi quando abbiamo chiesto informazioni a riguardo nel giugno 2021, sostenendo che questa sezione dell'informativa sulla privacy era obsoleta (consultare il caso di studio dell'azienda nella sezione II del rapporto). Tuttavia, la descrizione di questo sistema è rimasta in polizza, nonostante un aggiornamento effettuato a settembre 2021.

Ciò che è particolarmente preoccupante nell'uso di questi sistemi è che confondono la gestione delle frodi con la gestione delle prestazioni. Il fatto che tali indicatori 'frodi' siano utilizzati come variabili per l'allocazione del lavoro e che i comportamenti che li generano possano continuare sulla piattaforma dimostra che non si tratta di frodi criminali, ma di meccanismi di controllo, che valutano il rendimento dei lavoratori contro le metriche opache stabilite dalle aziende. Suggeriamo che qualsiasi terminologia 'frode' utilizzata in questi contesti funzioni anche come parte del gioco di errata classificazione, progettato per nascondere il rapporto di lavoro.

Caso di studio di sorveglianza I: mancato riconoscimento facciale

Nell'aprile 2020, Uber ha introdotto un sistema di verifica dell'identità in tempo reale (RTID) nel Regno Unito che utilizza una combinazione che include il riconoscimento facciale e il controllo della posizione per autenticare l'identità di un conducente e tentare di impedire che il conducente condivida l'accesso al proprio account per lavoro.

Il sistema RTID incorpora l'uso dell'API FACE di Microsoft, il software di riconoscimento facciale e richiede che conducenti e corrieri si facciano regolarmente selfie in tempo reale per continuare a utilizzare l'app Uber. La foto viene quindi confrontata con l'immagine del profilo dell'account del conducente (e in alcune giurisdizioni, con database pubblici per " prevenire il prestito di identità o per verificare l'identità degli utenti ").

Pa Edrissa Manjang lavorava con Uber da circa un anno quando è stato disattivato a causa di un errore nella verifica dei selfie. Sebbene gli autisti e i corrieri di Uber forniscano abitualmente selfie, questi non vengono memorizzati sui telefoni dei lavoratori e non possono conservare le prove delle loro richieste. A Pa non è stato dato alcun avvertimento o notificato di eventuali problemi fino al suo licenziamento; il sistema di verifica dell'identità in tempo reale sembrava approvare tutte le sue fotografie con un segno di spunta verde.

Dopo il suo licenziamento, Pa ha inviato numerosi messaggi a Uber per correggere il problema, chiedendo in particolare a un essere umano di rivedere le sue presentazioni. Ogni volta che a Pa è stato detto "non siamo stati in grado di confermare che le foto fornite fossero effettivamente di te e, a causa di continue discrepanze, abbiamo preso la decisione finale sulla fine della nostra partnership con te". Abbiamo ottenuto i selfie in questione attraverso una richiesta di accesso del soggetto, che ha rivelato che tutte le foto inviate da Pa erano in realtà di lui. Questo è stato il primo caso in cui siamo riusciti a ottenere i selfie inviati da un corriere o da un autista. Non è chiaro perché questa richiesta abbia avuto successo quando molti prima di fallire.

Abbiamo anche scritto a Microsoft all'inizio dell'anno per sollevare le nostre preoccupazioni sull'uso non regolamentato dell'API FACE da parte di Uber sulla sua piattaforma. In risposta , Microsoft ha sottolineato che tutte le parti coinvolte nell'implementazione di tali tecnologie hanno responsabilità che includono: "incorporare una revisione umana significativa per rilevare e risolvere casi di identificazione errata o altri errori" e "fornire supporto alle persone che ritengono che i loro risultati non siano corretti e identificare e affrontare le fluttuazioni di precisione dovute alla variazione delle condizioni". Il caso di Pa dimostra chiaramente che questi controlli cruciali non sono stati implementati nell'elaborazione delle immagini RTID.

Pa sta ora intentando una causa contro Uber per contestare il suo utilizzo del riconoscimento facciale discriminatorio dal punto di vista razziale, rappresentato da Bates Wells, con il sostegno della Commissione per l'uguaglianza e i diritti umani, l'App Drivers and Couriers Union e Worker Info Exchange.

EMBED: il video di Pa

Caso di studio di sorveglianza II: controlli di geolocalizzazione

Sebbene l'uso di sistemi di riconoscimento facciale difettosi sia indubbiamente problematico, abbiamo anche visto molti conducenti licenziati dopo false accuse da parte di Uber di essere coinvolti in una condivisione fraudolenta dell'account dopo che due dispositivi sono stati rilevati da Uber in due posizioni contemporaneamente. In tutti i casi che abbiamo analizzato, abbiamo riscontrato che il problema è legato al fatto che il conducente ha installato l'app su due dispositivi per comodità ma con uno solo dei dispositivi loggato per lavoro.

Poco prima delle 20:00 dell'11 settembre 2020, Aweso Mowlana stava lavorando per Uber nel sud di Londra. Era un autista valutato con 4,95 stelle che aveva effettuato più di 11.500 viaggi in oltre 5 anni di lavoro per Uber. Aweso aveva appena lasciato un passeggero vicino a Elephant and Castle quando si è disconnesso per una breve pausa. Come molti driver, Aweso aveva installato l'app su un secondo dispositivo che era un iPhone. Quella sera in particolare aveva lasciato l'iPhone a casa e stava lavorando con l'altro suo telefono, un Samsung.

Alle 20:02 Aweso ha tentato di accedere nuovamente all'app Uber per rendersi disponibile per il suo prossimo lavoro. Prima che gli fosse permesso di accedere nuovamente, gli è stato chiesto di fornire un selfie come parte del Real Time Identity Check (RTID) di Uber. La sua foto corrispondeva alla foto di riferimento di Uber, quindi ha completato con successo la procedura di accesso per continuare il suo turno. Ma a sua insaputa, i sistemi Uber avevano rilevato e/o eseguito il ping del suo secondo telefono. Suo figlio aveva preso per errore il suo secondo telefono e lo aveva portato con sé a casa della sua ragazza a Uxbridge. Uber in seguito ha affermato di aver richiesto un controllo RTID da questo dispositivo alle 20:03, ma a quel punto Aweso era già online nel sud di Londra. Uber afferma che la risposta al controllo dell'identità è stata inviata dall'iPhone intorno alle 23:55 di quella sera.

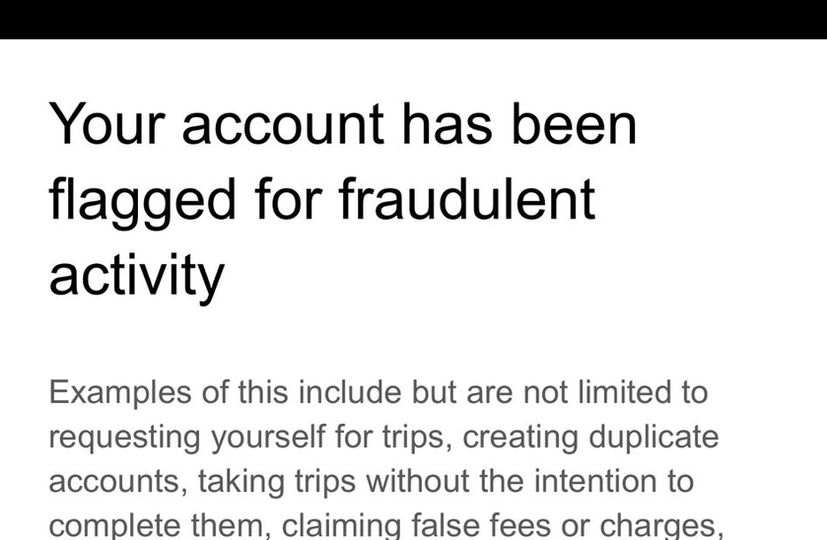

Il giorno successivo, Uber lo ha informato che il suo account era stato "segnalato per attività di applicazioni sospette" e che il suo account sarebbe stato sospeso mentre "un team specializzato lo esaminava". Qualche tempo dopo, Uber ha definitivamente licenziato Aweso tramite messaggio dicendo di aver "trovato prove che indicano attività fraudolente" sul suo account. Uber ha quindi affermato di condividere l'accesso al suo account e di aver violato i termini e le condizioni. Il mese successivo Transport for London ha immediatamente revocato la licenza di Aweso sulla base del fatto che non poteva più essere ritenuto "adatto e idoneo" a detenere una licenza pubblica a causa del suo licenziamento da Uber.

Worker Info Exchange ha assistito Aweso nell'effettuare una richiesta di accesso al soggetto e nell'analizzare i dati ricevuti. Un file chiamato "D river Detailed Device Data " registra almeno alcuni dei dati in streaming dai dispositivi a Uber in tempo reale. La politica sulla privacy di Uber indica che dove un dispositivo ha l'app aperta in background o in primo piano, anche se non online e pronta ad accettare tariffe. In più di una dozzina di casi in cui abbiamo sostenuto l'appello dei conducenti contro le loro revoche presso la Magistrates Court, ogni ricorso è stato accolto e TfL è stato ordinato di ripristinare le patenti. Da questo file potremmo vedere fino a 230 righe di dati al minuto registrate da Uber dai dispositivi. I dati raccolti da Uber dai dispositivi di Aweso inclusi geolocalizzazione, livello della batteria, velocità, rotta, numero IMEI ecc.

I dati hanno mostrato che il dispositivo in Uxbridge non era mai stato connesso per lavoro quel giorno perché un campo intitolato "driver_online" mostrava l'iPhone come "FALSO" in ogni momento quel giorno, incluso l'orario in cui è stato registrato su Uxbridge. Questa è la prova che il dispositivo non è stato condiviso per lavoro con altri, come affermato da Uber e Transport for London. Uber non è riuscito a fornire l'accesso ai dati personali elaborati in entrambi i controlli RTID, comprese le foto raccolte. I "Dati dettagliati del dispositivo" non mostrano alcuna registrazione di ulteriori attività per l'iPhone dopo le 20:03:43. Non abbiamo riscontrato alcuna prova di dati sull'attività del dispositivo alle 23:55 quando Uber ha affermato di aver ricevuto una risposta al controllo dell'identità emesso in precedenza.

L'esperienza di Pa e Aweso è stata molto diffusa durante lo scorso anno e ha costituito un volume significativo di casi gestiti da Worker Info Exchange e dall'App Drivers & Couriers Union. A Londra, Transport for London tendeva a revocare immediatamente le patenti dei conducenti che avrebbero fallito i controlli RTID di Uber nonostante gli ovvi problemi con il sistema. Esistono spesso spiegazioni ragionevoli per l'utilizzo di più dispositivi che vengono automaticamente classificati come frode. La politica sulla privacy di Uber indica che dove un dispositivo ha l'app aperta in background o in primo piano, anche se non online e pronta ad accettare tariffe. In più di una dozzina di casi in cui abbiamo sostenuto l'appello dei conducenti contro le loro revoche presso la Magistrates Court, ogni ricorso è stato accolto e TfL è stato ordinato di ripristinare le patenti.

Worker Info Exchange, Big Brother Watch e App Drivers & Couriers Union hanno scritto una lettera congiunta al sindaco di Londra per sollevare le nostre preoccupazioni sulla dipendenza di Transport for London da prove errate di Uber nel prendere una decisione di revoca e lo hanno chiesto, in qualità di presidente dei trasporti per il consiglio di Londra, che ordini una revisione di tutte queste revoche illecite. Ad oggi né il sindaco né TfL hanno risposto.

Gestione opaca delle prestazioni

L'opacità delle società di piattaforme inibisce la comprensione da parte dei lavoratori di come il controllo algoritmico potrebbe essere integrato nell'arco di processi critici e nel tempo. Ad esempio, ai lavoratori non è stata fornita la trasparenza a cui hanno legalmente diritto per comprendere come la profilazione delle prestazioni si colleghi alla qualità e alla quantità del lavoro offerto, nonché ai rendimenti attesi per tale lavoro.

Nel caso di Ola, abbiamo una certa conoscenza delle categorie di dati che raccolgono ed elaborano nei loro sistemi di allocazione del lavoro - come i punteggi di probabilità di frode, il profilo di guadagno, l'accettazione delle prenotazioni e la cronologia delle cancellazioni, tra gli altri - tuttavia ciò non rivela le diverse ponderazioni applicata a queste variabili, né la logica di elaborazione.

Uber ha a lungo sostenuto che il suo sistema di corrispondenza è determinato esclusivamente dalla posizione, nonostante la propria interfaccia "Partner-Driver" suggerisca diversamente. Il programma Pro di Uber (a cui i conducenti vengono automaticamente iscritti in modo che possano essere incentivati a raggiungere gli obiettivi di prestazione in cambio di vantaggi e premi) informa i conducenti in un linguaggio vago che "tassi di conferma più elevati significano tempi di attesa più brevi per i clienti e tempi di ritiro più brevi per tutti conducenti” alludendo vagamente al fatto che il calo di posti di lavoro si tradurrà in un minor numero di offerte di lavoro.

Solo di recente Uber ha offerto maggiore trasparenza sul sistema di abbinamento attraverso un aggiornamento alla sua politica sulla privacy che afferma: "Gli utenti possono essere abbinati in base a disponibilità, vicinanza e altri fattori come la probabilità di accettare un viaggio in base al loro comportamento o alle loro preferenze passate" ma, nel momento in cui scriviamo, il collegamento che offre ulteriori informazioni sul sistema di riscontro risulta interrotto, attestando la natura evolutiva di tale trattamento dei dati. Una recente richiesta di libertà di informazione che abbiamo fatto a TfL, chiedendoci quali aggiornamenti avesse fornito Uber sul suo sistema di abbinamento (come è obbligato a fare quando apporta modifiche al suo modello operativo) non ha prodotto risultati, evidenziando ulteriormente l'offuscamento delle sue pratiche di gestione algoritmica e l'assenza di controlli regolamentari.

Le recenti rivelazioni sulle variabili che determinano l'allocazione del lavoro sollevano anche importanti interrogativi sulla qualità dei posti di lavoro offerti agli autisti. Agli autisti con alti tassi di accettazione del lavoro vengono offerti viaggi di maggiore durata e durata, con conseguente aumento della retribuzione, sulla base di una profilazione simile? Oppure, andando oltre, ai conducenti vengono offerte tariffe diverse attraverso il sistema di tariffazione dinamica? In effetti, se e come il pricing algoritmico venga unito all'allocazione del lavoro è una questione delicata di cui si sa ancora poco.

Negli ultimi anni, Uber ha sostituito i prezzi variabili di tempo e distanza per i clienti con un modello di prezzo fisso in cui viene accettato un prezzo anticipato all'inizio di un viaggio. Uber afferma che "il prezzo iniziale è dinamico, il che significa che il prezzo viene elaborato in tempo reale per aiutare a bilanciare la domanda e l'offerta". Più di recente, gli autisti hanno riferito di aver offerto tariffe molto basse per i singoli lavori. C'è un'ovvia opportunità per Uber di aumentare la sua quota dell'eventuale tariffa pagata dai passeggeri. Sono state espresse preoccupazioni in merito agli esiti discriminatori dell'utilizzo di questi sistemi di tariffazione dinamica sui passeggeri, il che introduce la prospettiva che anche i conducenti possano essere soggetti a tariffe personalizzate in tempo reale. Ci sono seri problemi etici qui se gli operatori offrono prezzi più bassi ai lavoratori vulnerabili sulla base di una profilazione che prevede la loro disponibilità ad accettare lavoro a prezzi diversi.

Nel Regno Unito, tali pratiche sembrano essere contrarie alle disposizioni della Sezione 1 dell'Employment Rights Act che autorizza i lavoratori a ricevere dal proprio datore di lavoro una chiara dichiarazione dei termini delle condizioni del loro lavoro, comprese le tariffe salariali.

Caso di studio: controllo algoritmico

Uber invia regolarmente messaggi ai conducenti quando vengono segnalati dai suoi sistemi di rilevamento delle frodi per avvertirli che potrebbero perdere il lavoro se continuano qualsiasi comportamento stia attivando il sistema. I messaggi contengono un elenco non esaustivo dei potenziali fattori scatenanti, ma non forniscono un motivo specifico per il singolo conducente accusato di frode. Quando Alexandru ha ricevuto il secondo e ultimo di questi messaggi, sapendo che un'altra bandiera avrebbe comportato il licenziamento, ha deciso di chiamare il team di supporto del conducente per ottenere ulteriori dettagli sul motivo per cui stava attivando il sistema antifrode e cosa poteva fare per evitarlo . Attraverso la chiamata , Alexandru e l'agente di supporto hanno discusso una serie di situazioni che potrebbero aver fatto apparire irregolari i suoi viaggi, rivelando la limitata capacità che i team di supporto hanno nel decifrare le indicazioni fornite dal sistema. Tre mesi dopo questa chiamata, Uber ha inviato un messaggio di scuse affermando che gli erano stati inviati gli avvertimenti per errore.

Mentre la conversazione è illuminante in termini di comprensione dei dilemmi che i conducenti devono affrontare quando la politica aziendale e le richieste dei passeggeri divergono, di particolare interesse per noi è stata la discussione (25 minuti dopo la chiamata) relativa a una deviazione che Alexandru ha preso a causa di lavori stradali, così come il suo basso tassi di accettazione del lavoro come potenziali cause del suo rilevamento da parte del sistema antifrode. A seguito della sentenza della Corte Suprema che ha classificato gli autisti Uber come lavoratori all'inizio di quest'anno, Uber ha affermato di aver apportato modifiche significative alla sua piattaforma come l'offerta di trasparenza del prezzo e della destinazione, nonché la rimozione di misure punitive per il rifiuto di posti di lavoro, nel tentativo di sostenere che la sentenza della Corte Suprema non si applicava agli attuali conducenti Uber.

L'esperienza di Alexandru sulla piattaforma è contraria a questa narrativa, poiché diventa evidente che è probabile che sia stato segnalato per aver deviato dal percorso (nonostante il fatto che Uber ora utilizzi un modello a prezzo fisso, il che significa che i conducenti apportano tali modifiche al percorso a proprie spese) e non accettando abbastanza del lavoro offertogli sulla piattaforma. Questa chiamata rende innegabilmente chiaro che in pratica i conducenti sono ancora strettamente controllati da Uber come prima.

Oltre a queste pratiche di gestione, il programma Pro di cui sopra è un altro strumento che Uber utilizza per esercitare il controllo sulla sua forza lavoro, eludendo gli obblighi legali che possono essere associati a tale controllo. Ad esempio, legando determinati premi che culminano dal mantenimento di un rating elevato a società terze o presentando la partecipazione ai vantaggi sui prezzi come puramente facoltativa attraverso il nudging comportamentale, Uber crea l'illusione di lasciare che i conducenti operino in completa indipendenza e flessibilità. Il presunto impegno volontario dei conducenti in questi programmi comporta la rinuncia ai diritti derivanti dall'avere un rapporto di lavoro.

EMBED: il video di Alexandru

Espansione delle infrastrutture delle forze dell'ordine

È inoltre dimostrato che le piattaforme sono diventate sempre più un'attraente fonte di intelligence per la polizia e i servizi di sicurezza. In una dichiarazione di un testimone presentata come prova nel settembre 2020 all'appello di Uber presso la Westminster Magistrates Court, il direttore generale di Uber dal Regno Unito e dall'Europa occidentale Jamie Heywood ha attestato un rapporto sempre più stretto con la polizia e i servizi di sicurezza. Questi includono il National Counter Terrorism Policing Network, SO15 - il Comando Antiterrorismo del Metropolitan Police Service, il National Police Chiefs Council (NPCC), il College of Policing, la National Crime Agency e la British Transport Police. Un'area di cooperazione è stata il problema del cosiddetto trasporto di droga sulle linee della contea. Citando l'ispettore Stuart Liddell dell'NPCC, Heywood ha testimoniato di una relazione matura basata su sofisticati livelli di condivisione delle informazioni:

“Sono incoraggiato dall'impegno mostrato da Uber in merito a questa questione e sono previsti ulteriori lavori [nel 2020] per sviluppare il lavoro finora. Questo si concentrerà su aspetti più intricati dei County Lines, sul flusso di informazioni e intelligence e sul rafforzamento delle relazioni tra il National County Lines Coordination Centre”.

In effetti, l'NPCC ha esercitato pressioni sul commissario del Transport for London Mike Brown a sostegno del ricorso per la licenza di Uber. Il capo della polizia Mark Collins è arrivato al punto di suggerire che la decisione di negare a Uber la licenza potrebbe avere un impatto negativo sulla polizia britannica.

"Speriamo che questa lettera evidenzi l'impatto negativo sulla polizia britannica nel caso in cui la polizia non fosse in grado di accedere ai dati e alle informazioni che ho descritto".

Heywood ha anche testimoniato che Collins aveva affermato che il solo servizio di polizia metropolitana ha inviato oltre 2.000 richieste di dati a Uber ogni anno. Si tratta di un numero relativamente elevato di richieste considerando che, secondo lo stesso Rapporto sulla trasparenza di Uber, nel 2020 tutte le autorità di contrasto statunitensi messe insieme hanno effettuato poco meno di 5.000 richieste di dati e tutte le autorità di polizia canadesi messe insieme hanno fatto solo 411 di tali richieste.

È probabile che la direzione di Uber senta la pressione di collaborare con le iniziative di raccolta di informazioni della polizia, in particolare alla luce della decisione di Transport for London di rifiutare il rinnovo della licenza due volte. Questo perché la sezione 17 del Crime and Disorder Act 1998 attribuisce una responsabilità diretta alle autorità preposte al rilascio delle licenze per prevenire crimini e disordini nella loro area. Ciò stabilisce l'obbligo per le autorità preposte al rilascio delle licenze come Transport for London di stabilire Crime and Disorder Reduction Partnerships (CDRP) a cui dovrebbero partecipare operatori di trasporto come Uber.

Nelle linee guida statutarie del Dipartimento dei trasporti per le autorità preposte al rilascio delle licenze, il governo rafforza l'aspettativa di condivisione di informazioni tra polizia, autorità preposte al rilascio delle licenze e operatori dei trasporti come Uber:

“Aumentare la consapevolezza tra le forze di polizia del valore posto dalle autorità preposte al rilascio delle licenze sulle informazioni ricevute, in particolare sull'intelligence non convinta, contribuirà a promuovere queste relazioni e rafforzerà i benefici di una maggiore condivisione delle informazioni. Questa relazione può essere reciprocamente vantaggiosa, aiutando la polizia a prevenire il crimine. La polizia può ottenere preziose informazioni da autisti e operatori...”

Sebbene tali relazioni abbiano un'importanza significativa per il controllo della criminalità a livello di comunità, sembra che si sia prestata poca attenzione al rischio per le libertà civili di un accesso relativamente facile a ricchi dati personali di conducenti e passeggeri raccolti e archiviati da piattaforme come Uber, Bolt e Ola taxi.

“Sono incoraggiato dall'impegno mostrato da Uber in merito a questa questione e sono previsti ulteriori lavori [nel 2020] per basarsi sul lavoro svolto finora. Ciò si concentrerà su aspetti più intricati delle County Lines, sul flusso di informazioni e intelligence e sul rafforzamento del rapporto tra il National County Lines Coordination Center".

"Si spera che questa lettera delinei l'impatto negativo sulla polizia del Regno Unito se la polizia non fosse in grado di accedere ai dati e alle informazioni che ho descritto".

“Aumentare la consapevolezza tra le forze di polizia del valore che le autorità preposte al rilascio delle licenze attribuiscono alle informazioni ricevute, in particolare all'intelligence senza condanne, aiuterà a promuovere queste relazioni e rafforzerà i vantaggi di una maggiore condivisione delle informazioni. Questa relazione può essere reciprocamente vantaggiosa, aiutando la polizia a prevenire la criminalità. La polizia può ottenere preziose informazioni da conducenti e operatori…”

Caso di studio: condivisione dell'intelligence con le forze dell'ordine

Un altro lavoratore che si è rivolto a noi per chiedere aiuto è stato un autista Uber che è stato erroneamente sospeso dalla piattaforma Uber per sette settimane, subendo una perdita di quasi £ 5000, a seguito di una richiesta di intelligence fatta dalla polizia. Nel 2019, l'autista ha ricevuto un messaggio da Uber in cui si affermava di essere stato temporaneamente sospeso a causa di un'indagine in corso. Non gli è stato dato né un motivo, né un termine per la sua sospensione. Infatti gli è stato espressamente detto di non contattare Uber mentre svolgevano le indagini. Sette settimane dopo, ricevette una chiamata che lo informava che ora poteva lavorare.

Due anni dopo, una domanda di rinnovo della patente presentata dal conducente a TfL (che include un controllo avanzato di Disclosure and Barring Service) ha rivelato il motivo della sospensione, quando TfL lo ha interrogato sulla fornitura di droga nel 2019 e ha minacciato di togliergli la patente. Scioccato dalla rivelazione, l'autista ha chiesto un numero di riferimento del crimine e ha svolto ulteriori indagini non solo con TfL, ma anche con la polizia metropolitana.

Abbiamo aiutato l'autista a presentare richieste di accesso e reclami a Uber, TfL e alla polizia. Uber non è riuscito a soddisfare la richiesta (l'autista è stato informato che la sua richiesta è stata trasmessa a un team di specialisti ma non ha ricevuto ulteriore risposta), tuttavia, la risposta di TfL ha scoperto una vasta catena di e-mail tra vari funzionari mentre tentavano di identificare la fonte dell'intelligence richiesta. Uber ha affermato di essere stato avvicinato dalla polizia mentre la polizia non è riuscita a individuare alcun record o prova delle indagini sull'autista. Alla fine, Uber ha chiamato l'ufficiale che aveva fatto la richiesta di intelligence, ma quando TfL ha cercato dettagli sul caso, l'OIC ha affermato di non avere alcun ricordo dell'autista in questione.

La denuncia che l'autista ha presentato alla polizia metropolitana ha finalmente ricevuto risposta nell'ottobre 2021 e ha concluso che l'autista non era mai stato identificato come sospetto:

“Gli agenti avevano il compito di identificare un sospetto in relazione a un reato grave. Agli agenti era stato passato il nome di una persona di interesse. Posso confermare che NON eri tu. Il 20 febbraio 2019 è stato inviato a Uber un modulo per la protezione dei dati con i suddetti dettagli sospetti. Non sono libero di rivelare ulteriori dettagli su questo.

“In nessuna fase il tuo nome è apparso in questa ricerca effettuata con Uber. L'ufficiale NON si è avvicinato a Uber alla ricerca di alcuna informazione collegata a te. A seguito della nostra indagine, Uber ha fornito i tuoi dati alla polizia. Una volta che le informazioni sono state ricevute da Uber e ci hanno fornito il tuo nome, sapevamo che NON eri collegato alla nostra indagine e non sono state intraprese ulteriori azioni e sei stato escluso da ulteriori indagini".

“L'ufficiale non ha violato alcuno standard professionale né ha agito al di fuori del suo ruolo di agente di polizia o ha abusato del suo potere. Il tuo nome non era lo scopo della richiesta e in nessun momento abbiamo detto a Uber che eri una persona di interesse".

"Uber dovrebbe forse spiegare come sospende qualcuno che non era l'oggetto della richiesta originale e anche perché, dopo 10 giorni, non sei stato automaticamente reintegrato nell'app e in grado di continuare a lavorare".

EMBED: il video di L

“Gli agenti avevano il compito di identificare un sospetto in relazione a un reato grave. Gli agenti avevano ricevuto il nome di una persona di interesse. Posso confermare che questo NON eri tu. Il 20 febbraio 2019 è stato inviato a Uber un modulo per la protezione dei dati con i dettagli del sospetto denominato. Non sono autorizzato a rivelare ulteriori dettagli in merito.

"In nessuna fase il tuo nome è apparso in questa richiesta di ricerca fatta con Uber. L'ufficiale NON si è avvicinato a Uber per cercare informazioni a te collegate. A seguito della nostra indagine, Uber ha fornito i tuoi dati alla polizia. Una volta che le informazioni sono state ricevute da Uber e ci hanno fornito il tuo nome, sapevamo che NON eri collegato alla nostra indagine e non sono state intraprese ulteriori azioni e sei stato escluso da qualsiasi ulteriore richiesta.

“L'ufficiale non ha violato alcuno standard professionale, né ha agito al di fuori del suo ruolo di agente di polizia o abusato del suo potere. Il tuo nome non era lo scopo della richiesta e in nessun momento abbiamo detto a Uber che eri una persona di interesse".

"Uber dovrebbe forse spiegare come sospende qualcuno che non era oggetto della richiesta originaria e anche perché, dopo 10 giorni, non sei stato automaticamente reintegrato nell'app e in grado di continuare a lavorare".

Parte II: Esercizio dei diritti sui dati sul lavoro: accesso

Il diritto del lavoro non dispone delle disposizioni necessarie per tutelare pienamente i lavoratori dalle pratiche sleali derivanti dalla gestione algoritmica. Tuttavia, gli individui hanno diritti ai sensi del GDPR che possono proteggere i loro interessi nei contesti di lavoro. Nel supportare i lavoratori, invochiamo i loro diritti come definiti dagli articoli 15, 20 e 22, che conferiscono loro il diritto di accesso ai dati personali , il diritto alla portabilità dei dati , nonché il diritto di essere informati sul processo decisionale automatizzato e sulla logica di lavorazione .

Articolo 22: Gli interessati non possono essere soggetti a decisioni con effetti giuridici (o ugualmente significativi), basate unicamente sul trattamento automatizzato dei dati.

[Se il titolare del trattamento tratta i dati con il consenso esplicito dell'interessato, o per l'esecuzione di un contratto con esso, l'interessato ha il diritto di ottenere l'intervento umano, di esprimere il proprio punto di vista e di impugnare la decisione]

Articolo 15: Gli interessati hanno il diritto di ricevere una copia dei propri dati personali, insieme a informazioni supplementari quali le finalità del trattamento dei dati, informazioni su chi i dati possono essere condivisi, la durata del trattamento, ecc.

Articolo 20: Gli interessati hanno il diritto di ricevere i dati personali che hanno fornito a un titolare del trattamento in un formato strutturato, di uso comune e leggibile da dispositivo automatico. Hanno anche il diritto di trasmettere ("portare") i dati a un altro titolare del trattamento. Ove possibile, possono chiedere che i dati siano trasmessi direttamente da un titolare all'altro.

Sebbene le piattaforme mettano a disposizione dei lavoratori il download di dati, queste spesso omettono le categorie di dati più favorevoli e necessarie per interrogare le condizioni di lavoro (come l'equità della retribuzione, l'allocazione e l'utilizzo del lavoro come sopra elencati). Nella nostra aspirazione ad ampliare l'ambito di dati messi a disposizione dei lavoratori, effettuiamo richieste specifiche di accesso e portabilità dei soggetti che coprono l'intera gamma di piattaforme di data gig raccolte da loro. In queste richieste, cerchiamo di ottenere tre diversi tipi di dati:

1) Dati di input - forniti dagli stessi lavoratori

2) Dati di osservazione – basati sull'utilizzo delle piattaforme da parte dei lavoratori (es. dati grezzi di misurazione e sorveglianza come dati di posizione, telematica ecc.)

3) Dati dedotti - derivati dall'analisi dei dati di osservazione (ad es. profilazione del comportamento dei lavoratori sotto forma di valutazioni di rischio e frode)

Articolo 22: Gli interessati non possono essere soggetti a decisioni con effetti giuridici (o similari significativi), basate unicamente sul trattamento automatizzato dei dati.

[Se il titolare del trattamento tratta dati con il consenso esplicito dell'interessato, o per l'esecuzione di un contratto con esso, l'interessato ha diritto di ottenere l'intervento umano, di esprimere il proprio punto di vista e di impugnare la decisione]

Articolo 15: Gli interessati hanno il diritto di ricevere una copia dei propri dati personali, insieme a informazioni integrative quali le finalità del trattamento dei dati, le informazioni su chi i dati possono essere condivisi, la durata del trattamento, ecc.

Articolo 20 : Gli interessati hanno il diritto di ricevere in un formato strutturato, di uso comune e leggibile da dispositivo automatico i dati personali che hanno fornito a un titolare del trattamento. Hanno altresì il diritto di trasmettere ("portare") i dati ad un altro titolare del trattamento. Ove possibile, possono chiedere che i dati siano trasmessi direttamente da un titolare all'altro.

Dati in ingresso

Fornito dagli stessi lavoratori

Dati osservati

Basato sull'uso delle piattaforme da parte dei lavoratori (es. dati grezzi di misurazione e sorveglianza come dati di localizzazione, telematica ecc.)

Dati dedotti

Derivato dall'analisi dei dati di osservazione (es. profilazione del comportamento dei lavoratori sotto forma di valutazione dei rischi e delle frodi)

Queste categorie di dati sono spesso esplicitate nei documenti di orientamento e nelle politiche sulla privacy ma non vengono condivise con i conducenti quando scaricano i propri dati o effettuano richieste di accesso ai soggetti. Nella nostra esperienza, quando i lavoratori cercano queste informazioni, le piattaforme di gig mirano a rendere il processo difficile e gravoso impegnandosi in una varietà di comportamenti non conformi. I lavoratori che cercano dati completi devono navigare in architetture di siti Web estremamente complesse e ostruttive e devono aggirare ulteriori sforzi di frustrazione da parte degli agenti di supporto, che prolungano inutilmente semplici processi amministrativi o forniscono risposte automatizzate che non riescono a rispondere adeguatamente alle domande. Queste procedure possono essere descritte come " modelli oscuri" concepiti per allontanare i lavoratori dall'esercitare i propri diritti in quanto interessati. Nelle occasioni in cui i lavoratori sono in grado di ottenere i propri dati, spesso mancano segmenti considerevoli o vengono presentati in formati incoerenti e non leggibili dalla macchina, rendendo l'analisi effettivamente impossibile. Questi atti di ostruzione costringono i lavoratori a fare ripetute richieste che le aziende alla fine usano come motivo per screditarli.

In tutti i resi DSAR che abbiamo visto, nessun datore di lavoro ha fornito un resoconto completo e corretto del trattamento automatizzato dei dati personali. Ciò è particolarmente importante in aree che possono determinare la sicurezza dell'occupazione come l'allocazione del lavoro, la gestione delle prestazioni, la sicurezza e la protezione, come discusso nel presente rapporto. Uber e Ola hanno sostenuto in tribunale che la sicurezza e la protezione della loro piattaforma potrebbero essere compromesse se la logica di tale trattamento dei dati viene divulgata ai loro lavoratori. A nostro avviso, la sicurezza e la protezione possono essere migliorate solo quando le piattaforme stabiliscono in modo trasparente regole e standard di prestazione piuttosto che fare affidamento su sorveglianza segreta e licenziamenti sommari, che sono alcuni dei principali motivatori dei DSAR.

Dato questo atteggiamento di resistenza nei confronti dei DSAR, è anche importante notare che molti conducenti temono ritorsioni da parte delle aziende per aver presentato richieste. Quando le piattaforme gig eseguono controlli di identità smisurati e prolungati in risposta alle richieste di accesso dei soggetti, i lavoratori vengono facilmente scoraggiati e intimiditi (vedi e-mail inviate agli autisti da Uber nei casi studio di risposta della piattaforma). Attraverso le numerose interviste che abbiamo condotto con gli autisti, lunghi messaggi di ricerca di conferma, veicolati in un linguaggio legale complesso, sono stati spesso citati come deterrenti al perseguimento delle richieste. Per molti automobilisti, l'atto di insistere con la richiesta equivale a mettere la testa sopra il parapetto ea mettere a rischio il proprio sostentamento e la sicurezza del lavoro.

Questa percezione deriva spesso da esperienze di sfruttamento continuo e insicurezza, a seguito delle limitate capacità e conoscenze dei lavoratori nell'esercizio dei diritti democratici, sia nel Regno Unito come immigrati che nei loro paesi d'origine, che in molti casi mostrano tendenze autoritarie. In una forza lavoro già molto frammentata e soggetta alla precarietà economica, dove il bisogno di sicurezza supera di gran lunga il desiderio di sfidare l'ingiustizia, l'impatto di questo tipo di comportamento ostile da parte delle aziende non può essere sopravvalutato. Questa insicurezza è ulteriormente aggravata dall'opacità degli algoritmi di gestione. In assenza di spiegazioni chiare su come funzionano i sistemi di allocazione del lavoro o di gestione delle prestazioni, diventa molto facile per i lavoratori impegnarsi in pensieri speculativi o addirittura cospirativi su come le loro interazioni con la piattaforma influiscono sul loro lavoro. Ciò può poi sfociare in una sfiducia generalizzata nei confronti delle altre istituzioni e in un'avversione verso l'attività organizzativa. Si tratta di vulnerabilità forti e persistenti in tutta la forza lavoro che richiedono particolare attenzione e salvaguardia.

Casi di studio: DSAR individuali

I seguenti casi di studio dimostrano alcuni dei modi in cui Uber si impegna in comportamenti ostruzionistici e non conformi nel rispondere alle richieste di dati da parte dei lavoratori. Significativamente, questi esempi non possono essere spiegati come eccezioni o eventi isolati riguardanti agenti di supporto inesperti. Queste risposte rappresentano le procedure standard seguite da Uber quando i lavoratori desiderano esercitare i propri diritti di accesso ai dati.

Risposte circolari e futili

M. Ahmed è un ex autista di Uber e corriere di Uber Eats. Nell'ottobre 2020, sia il suo account di autista che quello di corriere Uber sono stati sospesi e nel febbraio 2021 il suo account di autista è stato disattivato. Ciò ha interessato anche il suo account corriere UberEats, che è stato successivamente disattivato e cancellato.

Quando il sig. Ahmed ha chiesto la causa del suo licenziamento, ha ricevuto risposte contraddittorie. Inizialmente Uber ha citato i controlli di riconoscimento facciale falliti e in seguito ha affermato che la disattivazione era dovuta a un elevato volume di ordini non consegnati. Durante tutta la corrispondenza, si sono rivolti a lui con il nome sbagliato e alla fine hanno accettato che i messaggi relativi ai controlli falliti dell'ID in tempo reale fossero stati inviati per errore. La confusione intorno al suo licenziamento lo ha portato a cercare i suoi dati personali.

Negli ultimi mesi il signor Ahmed ha cercato di recuperare i dati associati al suo account Uber Eats disattivato. Il signor Ahmed ha cercato per la prima volta di ottenere i suoi dati il 15 aprile 2021, tramite il modulo "Invia una richiesta di informazioni sulla privacy senza un account Uber" sul sito Web di Uber, poiché il suo account era stato cancellato a seguito del suo licenziamento.

In risposta, ha ricevuto un'e-mail da Uber in cui si affermava: "La nostra Informativa sulla privacy limita la nostra capacità di condividere le informazioni del titolare dell'account. Possiamo fornire queste informazioni solo attraverso il processo delineato nelle nostre linee guida per la richiesta di dati". Questo processo si riferisce all'accesso all'account e all'esecuzione della richiesta dall'interno dell'account. "Detto questo, siamo in grado di lavorare con te attraverso i canali appropriati per aiutarti se necessario."

Il signor Ahmed ha risposto chiedendo consiglio su come accedere ai dati associati al suo account ora cancellato. Ha spiegato che stava scrivendo dall'e-mail associata al suo account Uber Eats e che aveva fornito anche il numero di cellulare associato a questo account. Ha aggiunto che era felice di fornire ulteriori informazioni per confermare la sua identità.

A questo, il signor Ahmed ha ricevuto una risposta in cui affermava che la sua "preoccupazione non è correlata a questo account. Scrivici dall'account interessato o accedi tramite help.uber.com con le credenziali pertinenti e facci sapere del problema in modo che possiamo aiutarti ulteriormente.

Il signor Ahmed ha risposto, allegando un'immagine dell'e-mail di onboarding inviatagli da Uber il 3 luglio 2020, per dimostrare che stava scrivendo dall'account in questione. Il 19 aprile 2021, ha ricevuto lo stesso messaggio in cui si affermava che la sua "preoccupazione non è correlata a questo account".

Il signor Ahmed ha risposto spiegando ancora una volta che non è in grado di accedere al suo account e che ha fornito i dettagli associati al suo account Uber Eats. Ha chiesto di ricevere indicazioni su quali altre informazioni potrebbe fornire per identificarsi. Non ha ricevuto risposta.

A questo punto Ahmed ha chiesto aiuto all'App Drivers and Couriers Union e al Worker Info Exchange e abbiamo intensificato il problema con Uber. L'11 maggio 2021, il sig. Ahmed ha ricevuto un'e-mail da Uber che gli chiedeva di confermare la richiesta da noi avanzata per suo conto. Ci ha risposto confermando che ci aveva dato il suo mandato e che desiderava che la sua richiesta fosse evasa.

Il 14 maggio 2021, Uber ha inviato al sig. Ahmed un modulo di verifica dell'identità per elaborare la richiesta. Il modulo richiedeva gli stessi dettagli che aveva già condiviso nei suoi messaggi precedenti come email, numero di telefono, paese di residenza, tipo di dati richiesti. Ha anche chiesto la sua "valutazione attuale" - che era inapplicabile, poiché non aveva più accesso al suo account. Il signor Ahmed ha inviato il modulo a Uber, ma non ha ricevuto alcuna risposta.

Il 20 maggio 2021, Ahmed ha scritto a Uber per ottenere conferma che stavano elaborando la sua richiesta. Non ha ricevuto risposta.

Al momento in cui scriviamo, il sig. Ahmed non ha ricevuto i suoi dati. Né gli è stata data alcuna spiegazione del motivo per cui la sua richiesta non viene elaborata.

Condivisione dati incoerente e incrementale

Il signor Amini è un ex autista di Uber che è stato disattivato nel novembre 2020 a seguito di un controllo di geolocalizzazione fallito . Uber ha denunciato il suo licenziamento a TfL, che ha poi revocato la licenza di noleggio privato di Amini, lasciandolo senza lavoro. Nel tentativo di comprendere la causa del suo licenziamento, il signor Amini ha cercato di ottenere i suoi dati da Uber.

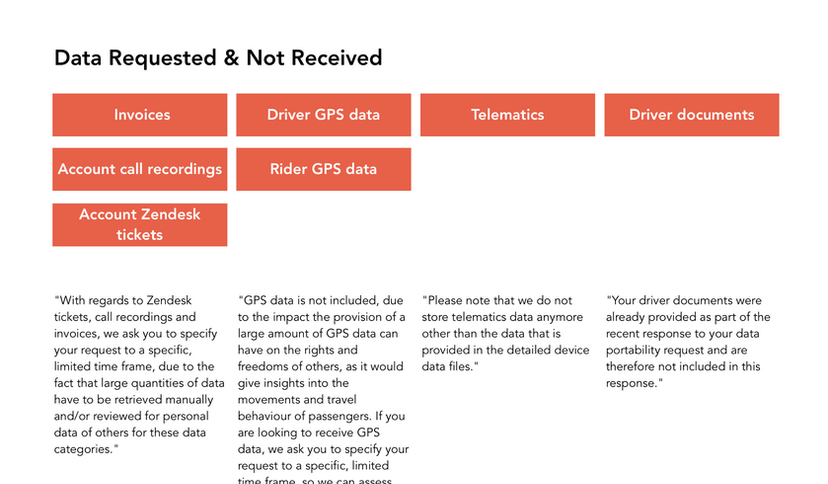

Il signor Amini ha presentato la sua prima richiesta il 13 aprile 2021 e ha chiesto tutti i suoi dati personali, comprese le 26 categorie di dati delineate nel documento di orientamento prodotto da Uber, nonché le immagini da lui inviate in risposta ai controlli dell'identità in tempo reale. Ha specificato di volere dati che coprano l'intero periodo in cui è stato attivo come autista Uber.

Il sig. Amini ha ricevuto risposta alla sua richiesta il 5 maggio 2021, tuttavia i dati forniti coprivano solo i 30 giorni precedenti la sua richiesta. Poiché il signor Amini non ha potuto lavorare per Uber durante questo periodo, molti dei set di dati forniti erano vuoti.

Il sig. Amini ha quindi presentato un'altra richiesta il 06 maggio 2021, affermando ancora una volta che richiedeva dati relativi all'intero arco temporale in cui ha lavorato con Uber, aggiungendo in particolare che desiderava i dati raccolti fino a novembre 2020.

Il sig. Amini ha ricevuto una risposta il 28 maggio 2021. Tuttavia, ancora una volta gli sono stati inviati dati incompleti. In particolare, il file CSV Driver Detailed Device Data fornito da Uber era completamente vuoto.

Il 2 giugno 2021 il sig. Amini ha presentato un'altra richiesta chiedendo i dati mancanti. Ha ricevuto i dati dettagliati sul dispositivo del conducente per novembre 2020 il 10 giugno 2021. Tuttavia, nonostante abbia specificato di volere tutti i campi dati elencati nelle note di orientamento prodotte da Uber, gli è stato inviato un set di dati limitato che ha omesso 32 dei 50 dati campi.

Offuscamento e resistenza

Il signor Majid è un ex autista di Uber che è stato disattivato nel settembre 2020 a seguito di un controllo di geolocalizzazione fallito. Come nel caso di Amini, Uber ha segnalato a TfL il licenziamento di Majid, che ha causato la revoca della sua licenza di noleggio privato. Nel tentativo di comprendere la base delle accuse di Uber, ha cercato di ottenere i suoi dati.

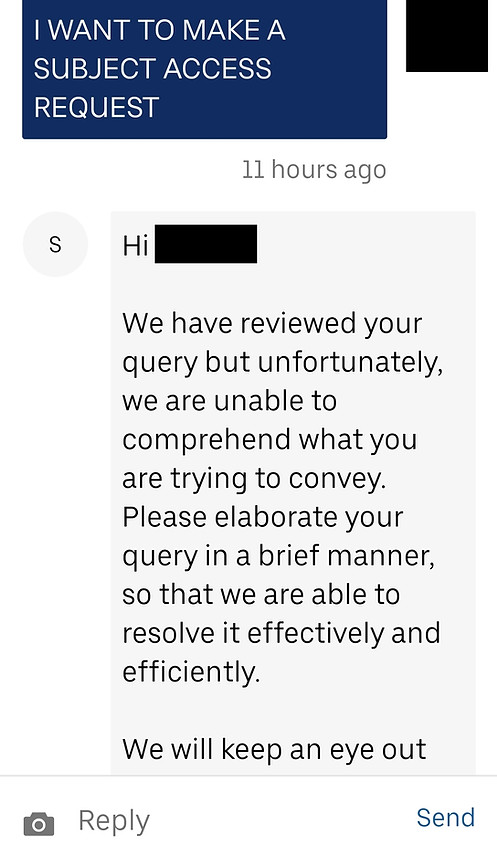

Majid ha contattato per la prima volta Uber per richiedere i suoi dati il 2 giugno 2021. In risposta, ha ricevuto un messaggio che gli chiedeva di elaborare brevemente la sua preoccupazione. Il sig. Majid ha risposto con la sua richiesta di 3 categorie di dati (delle 26 categorie elencate nelle note di orientamento di Uber) per settembre 2020.

L'8 giugno 2021, Majid ha ricevuto un messaggio da Uber in cui si affermava: "La nostra Informativa sulla privacy non ci consente di apportare modifiche o discutere di informazioni personali senza contatto tramite l'indirizzo e-mail associato al tuo account partner. Per aiutarti con il tuo problema specifico, dovrai scrivere utilizzando l'indirizzo email associato a quell'account. Grazie per la comprensione."

A questo punto il signor Majid ci ha contattato, confuso, poiché aveva scritto a Uber dal suo account. Ha risposto, spiegando a Uber che li aveva contattati accedendo al suo account autista, quindi stava sicuramente scrivendo dall'indirizzo email corretto. Ha chiesto se poteva fornire qualsiasi ulteriore identificazione/documentazione per assicurare a Uber che era lui a fare la richiesta.

In risposta, ha ricevuto lo stesso messaggio da Uber: "Ciao... grazie per il tuo messaggio. Ci risulta che desideri discutere di informazioni relative a un account Uber. Se sei il titolare dell'account, scrivi dall'indirizzo e-mail associato al tuo account Partner-Driver e saremo in grado di aiutarti immediatamente.”

Il 9 giugno 2021, il signor Majid ha effettuato l'accesso al suo account partner e ha avviato una chat con l'assistenza Uber per riprovare. Il suo messaggio che chiedeva se poteva fare una richiesta di accesso al soggetto è stato ignorato.

Il 14 giugno 2021, Majid ha contattato ancora una volta Uber, affermando di avere una domanda sul suo account di partner di guida. Ha ricevuto una risposta da Uber: "Grazie per averci contattato... Abbiamo colto l'occasione per esaminare la tua preoccupazione e possiamo vedere che ci hai già contattato in merito a questo problema. Uno dei membri del nostro team sta attualmente esaminando il tuo problema e ti ricontatteremo il prima possibile. Per semplificare la nostra comunicazione ed evitare qualsiasi confusione, stiamo procedendo alla chiusura di questo contatto".

Il 16 giugno 2021, Majid ha contattato nuovamente Uber, affermando che gli era stato chiesto di accedere al suo account per effettuare una richiesta e, dopo averlo fatto, voleva condividere i dettagli della sua richiesta. Ha ricevuto una risposta il giorno successivo e successivamente ha inviato i dettagli della richiesta (dei tre set di dati sopra elencati) il 18 giugno 2021.

Non avendo ricevuto risposta, il sig. Majid ha contattato nuovamente Uber il 28 giugno 2021, chiedendo conferma che la sua richiesta fosse in fase di elaborazione. Il 1° luglio 2021, ha ricevuto una risposta in cui si affermava che la sua preoccupazione era stata sollevata con il team specializzato e che sarebbero stati in contatto per indagare ulteriormente.

Il 2 luglio 2021, Majid ha ricevuto una risposta al thread di messaggi che aveva avviato il 9 giugno 2021. Questo messaggio affermava che Uber richiede che le richieste vengano notificate personalmente all'indirizzo postale di Uber BV nei Paesi Bassi.

Il sig. Majid non ha ricevuto ulteriori comunicazioni.

“La questione degli algoritmi è centrale nel tema dell'uberizzazione. Troppo spesso è l'algoritmo a svolgere il vero ruolo del capo, poiché la tecnologia fornisce nuovi mezzi per la subordinazione dei lavoratori. Ovviamente c'è bisogno di trasparenza della gestione algoritmica, ma al di là di questa trasparenza, c'è bisogno di una cogestione dell'algoritmo. I rappresentanti dei lavoratori devono poter partecipare al loro sviluppo".

Leila Chaibi, eurodeputata

Casi di studio: risposte della piattaforma a

Richieste batch per scambio di informazioni sui lavoratori

Come dimostrato dagli esempi precedenti, i singoli processi di richiesta possono richiedere molto tempo e capacità. Abbiamo quindi creato dei processi che ci consentono di effettuare richieste batch per conto degli autisti e snellire questa complessa procedura. Abbiamo creato un sistema utilizzando la soluzione di firma elettronica e ID sviluppata da Scrive per ricevere un mandato legale dai lavoratori per fare richieste per loro conto. Questa soluzione include anche una verifica dell'identità eseguita da Onfido (lo stesso servizio di verifica dell'identità utilizzato da Uber), per garantire che sia noi che il titolare del trattamento possiamo essere certi dell'identità del richiedente e preservare la riservatezza dei dati. La verifica dell'identità richiede che i lavoratori presentino uno dei seguenti documenti di identità: passaporto, patente di guida, carta d'identità o permesso di soggiorno. Attraverso questo processo viene creato un documento di consenso individuale per ogni individuo che viene sigillato elettronicamente e verificabile attraverso allegati nascosti contenenti un registro delle prove per dimostrare l'autenticità del processo di identificazione. (Scrive fornisce anche un servizio per verificare l'integrità dei moduli di consenso, a cui è collegato nei documenti.) Inviamo questi documenti, insieme a un foglio di calcolo contenente i nomi, le e-mail, gli indirizzi e i numeri di telefono dei lavoratori che fanno richiesta.

Alcune aziende sono state disponibili e collaborative nel rispondere alle richieste fatte attraverso questa procedura, mentre altre hanno adottato comportamenti molto più ostili e ostili. Tuttavia, anche quando le aziende hanno ottemperato alle richieste, vi sono stati problemi consistenti nello stabilire le precise categorie di dati raccolti, nonché nell'ottenere tutti i dati richiesti in un formato strutturato e leggibile da una macchina. Poche aziende sono state in grado di fornire documenti di orientamento con descrizioni chiare delle categorie di dati e i dati che abbiamo ricevuto hanno spesso mostrato incongruenze significative con il trattamento descritto nelle politiche sulla privacy. In generale, le aziende hanno mostrato la tendenza a negare le pratiche sui dati che non desiderano divulgare. In un caso, una società ha affermato che la valutazione della frode a cui si fa riferimento nella propria informativa sulla privacy era stata intrapresa solo nell'ambito di un processo e che l'informativa sulla privacy era obsoleta. Un altro ci ha indirizzato a un documento che secondo loro aveva sostituito quello su cui stavamo basando la nostra richiesta, anche se entrambi i documenti sono stati aggiornati alla stessa data.