Contenido

Contenido

Resumen

Parte I: Clasificación errónea 2.0: controlado por algoritmo

Estudio de caso de vigilancia I: Fallo en el reconocimiento facial

Estudio de caso de vigilancia II: Verificaciones de geolocalización

Gestión del rendimiento opaco

Estudio de caso: control algorítmico

Expansión de la infraestructura de aplicación de la ley

Estudio de caso: intercambio de inteligencia con las fuerzas del orden

Parte II: Ejercicio de los derechos sobre los datos en el trabajo: acceso

Estudios de caso: DSAR individuales

Respuestas circulares e inútiles

Intercambio de datos incremental e inconsistente

Estudios de caso: Respuestas de la plataforma a solicitudes por lotes de WIE

Parte III: Ejercicio de los derechos sobre los datos en el trabajo: litigio

Conductores Uber vs Uber I (solicitudes de transparencia general)

Ola drivers v. Ola (solicitudes generales de transparencia)

Uber drivers v. Uber II (transparencia en la toma de decisiones automatizada)

Casos de apelación de licencias de Londres

Conclusión: ¿El camino a seguir para el ejercicio de los derechos digitales en el trabajo?

Resumen

Worker Info Exchange se creó para facilitar el acceso y la colectivización de datos a fin de generar poder de negociación mediante el establecimiento de un fideicomiso de datos.

Esto fue en respuesta al desarrollo de nuevas prácticas de gestión algorítmica que crearon profundas asimetrías informativas y explotación de los trabajadores.

Worker Info Exchange tiene como objetivo abordar la convergencia de datos y derechos laborales invocando los derechos de los artículos 15, 20 y 22 del RGPD en contextos laborales.

Este objetivo se ve gravemente obstaculizado por el incumplimiento generalizado del RGPD en la industria de los conciertos.

Hemos realizado más de 500 solicitudes de acceso de sujetos de datos en los últimos ocho meses a siete plataformas de viajes compartidos diferentes, incluidas Amazon Flex, Bolt, Deliveroo, Free Now, Just Eat, Ola y Uber.

El acceso a los datos es desafiado por empresas que implementan patrones oscuros y abusan deliberadamente de la implementación irregular del RGPD, lo que impulsa a los trabajadores a resolver problemas en los tribunales.

La recopilación de datos por plataformas de conciertos es excesiva y conduce a una vigilancia desproporcionada e irresponsable de los trabajadores, así como a una infraestructura de aplicación de la ley en expansión.

No hay transparencia sobre los sistemas de gestión algorítmica que se utilizan. Las narrativas de la empresa sobre qué tecnologías se utilizan y cómo son inconsistentes y poco fiables.

© 2021 Intercambio de información del trabajador

© 2021 Intercambio de información del trabajador

Introducción

El año pasado marcó un punto de inflexión para los trabajadores de plataformas de conciertos en la realización de sus derechos laborales y digitales. La práctica del trabajo mediado digitalmente ha llevado a una convergencia de los derechos laborales y de protección de datos y la creciente actividad de litigio y defensa de los trabajadores ha estado dando resultados en estos dominios. En toda Europa, los tribunales han emitido varios juicios importantes que reconocen el papel explotador de las prácticas de gestión algorítmica por parte de las plataformas de conciertos, al tiempo que condenan la falta de equidad y transparencia en dichos sistemas automatizados.

En Italia, el tribunal de Bolonia dictaminó que el sistema de calificación de Deliveroo había discriminado a los trabajadores, mientras que la autoridad de protección de datos, Garante, impuso dos multas de GDPR a Deliveroo y Glovo debido a que no revelaron adecuadamente el funcionamiento de su asignación de trabajo y algoritmos de gestión del desempeño.

España aprobó la primera legislación para intentar regular la IA en el ámbito del empleo, estableciendo tanto la condición de trabajador para los trabajadores de concierto como el derecho a ser informado sobre las reglas y parámetros de los algoritmos a los que están sujetos, lo que desencadenó un torrente de quejas. Esto fue el resultado de otro caso judicial contra Glovo que terminó en el Tribunal Supremo de España.

Junto con estas decisiones de alto perfil, la Corte Suprema del Reino Unido también concluyó este año que los conductores de Uber eran parte de un servicio de transporte que está " muy estrictamente definido y controlado por Uber ", lo que traiciona una relación laboral clara, que, según la compañía, no existía en su esfuerzo por (mal) clasificar a los trabajadores como contratistas independientes. Significativamente, la evidencia de esta relación proviene de los sistemas basados en datos que utilizan las plataformas de viajes compartidos para administrar su fuerza laboral. Algunas de las cuestiones destacadas por la Corte Suprema del Reino Unido se relacionan con la gestión de los conductores a través del seguimiento algorítmico de las tasas de aceptación del trabajo, las opciones de ruta, el comportamiento de conducción y las valoraciones de los clientes. Sin embargo, aunque existe un mayor reconocimiento de la gestión algorítmica, los recientes avances en los tribunales no protegen por completo a los trabajadores contra sus daños. El estatus de trabajador de extremidad (b) otorgado a los conductores de Uber como resultado de la decisión de la Corte Suprema es un estatus de intermediario entre el contratista y el empleado , y aún no los protege de despidos injustos, por ejemplo.

Nuestra experiencia sugiere que estas herramientas de gestión algorítmica, junto con la intensificación de las prácticas de vigilancia, el escrutinio continuo de los trabajadores en busca de posibles fraudes o irregularidades, están dando como resultado un entorno de trabajo profundamente explotador. Estamos viendo una cantidad excesiva de despidos automatizados en toda la industria de los conciertos, muchos de los cuales creemos que son ilegales de acuerdo con el artículo 22 del Reglamento general de protección de datos (GDPR) . El artículo 22 proporciona a los trabajadores algunas protecciones limitadas contra los efectos adversos de la toma de decisiones automatizada y la elaboración de perfiles, a través del derecho a obtener la intervención humana y a impugnar la decisión. El artículo 15 del RGPD garantiza el derecho a ser informado sobre la existencia de dicha toma de decisiones automatizada y a recibir información significativa sobre la lógica del procesamiento.

Tomando estos derechos como base, Worker Info Exchange se creó con la misión de ayudar a los trabajadores a navegar en este espacio complejo y poco regulado. El objetivo y el cometido de nuestro trabajo es probar si estos instrumentos del RGPD se pueden utilizar para abordar las prácticas laborales injustas y ampliar el alcance de los datos que se ponen a disposición de las personas en su calidad de trabajadores. En otras palabras, nuestra ambición es utilizar el acceso a los datos como un método para desarrollar el poder colectivo de los trabajadores para probar los mecanismos de reparación en un mercado laboral mediado digitalmente.

Cuando la relación laboral entre la plataforma de conciertos y el trabajador se ejecuta a través de una amplia recopilación y análisis de datos, los derechos laborales se vinculan inextricablemente con el ejercicio de los derechos sobre los datos. Las plataformas de conciertos afirman el control sobre los trabajadores al mantener una asimetría de información, y el acceso a los datos puede proporcionar un medio para exponer el (des) equilibrio de poder generado por la brecha de información entre las plataformas de conciertos y sus trabajadores. Obtener acceso a datos personales puede permitir a los trabajadores realizar evaluaciones independientes sobre sus condiciones de trabajo y responder preguntas sobre sus cálculos salariales, la calidad y cantidad de trabajo ofrecido, así como desafiar los motivos de una gestión del desempeño adversa, incluida la suspensión y despido.

Nuestro objetivo al facilitar el acceso a los datos es crear almacenes colectivos de datos para desarrollar una mayor comprensión de las condiciones laborales y, en consecuencia, poder de negociación. En los últimos años, han surgido una serie de iniciativas destacadas que operan con objetivos similares pero utilizan diferentes metodologías para recuperar datos. Algunos proyectos en este campo ejecutan su propia recopilación de datos y análisis sobre ganancias y desempeño para evaluar la equidad de las condiciones laborales (por ejemplo, Driver's Seat Coop y WeClock, entre otros). Todos ellos presentan una visión única de la economía de los conciertos y deben considerarse como parte de un continuo de la práctica de los datos. Hemos abordado este problema exigiendo que las plataformas compartan los datos a los que los trabajadores tienen derecho legalmente; sin embargo, esto ha introducido obstáculos adicionales al objetivo más amplio de colectivizar los datos. Tomamos este camino porque queríamos sentar estándares y precedentes en la ley de protección de datos, pero también porque creemos que hay cierto tipo de información que solo se puede obtener solicitando los datos directamente desde las plataformas.

Hemos descubierto, particularmente en el caso de denuncias de actividad irregular y fraude alimentadas por vigilancia, que es necesario tener los datos en poder de las empresas para comprender y rebatir las acusaciones. El acceso a los datos puede ayudarnos a descubrir las inconsistencias en las narrativas avanzadas por las empresas de plataformas y ayudar a trasladar la carga de la prueba de los trabajadores a las plataformas. Desde esta perspectiva, el esfuerzo de los datos de la plataforma exigente ha demostrado ser un gran éxito en la resolución de numerosos conflictos laborales. La simple demostración de la negativa de las plataformas a proporcionar datos personales ha revertido varias revocaciones de licencias (ejecutadas por TfL) en los tribunales y, por lo tanto, se ha convertido en una herramienta adicional en el ejercicio de los derechos laborales.

Ésta constituye la otra rama de actividad de Worker Info Exchange; Como nos sentimos frustrados en nuestros intentos de ganar claridad y transparencia sobre los complejos sistemas que determinan las condiciones del lugar de trabajo, con frecuencia necesitamos recurrir a litigios y acudir a los tribunales para obtener decisiones en el campo emergente de los derechos laborales digitales. La 'crisis de datos' artificial que han creado las plataformas de conciertos es, en muchos sentidos, un intento de agotar y agotar los recursos de los trabajadores precarios y de los sindicatos al llevar las disputas a los tribunales, donde pueden prolongarse y retrasarse la rendición de cuentas por mala conducta empresarial.

De acuerdo con estas líneas de actividad, este informe está escrito en tres partes: La primera sección explora diferentes facetas de la gestión algorítmica y sus daños, con estudios de casos asociados. La segunda sección trata sobre nuestro proceso en la utilización de solicitudes de acceso de sujetos de datos (DSAR), mientras que la tercera ofrece una descripción general de los casos relacionados con GDPR que hemos llevado adelante en Ámsterdam, así como los casos de licencia que apoyamos en Londres. Este informe concluye un período de trabajo sobre estas funciones de nuestra organización, realizado con el apoyo de la Fundación Mozilla, Digital Freedom Fund y Open Society Foundations. Esperamos que este informe demuestre la situación actual en el ejercicio de los derechos en la intersección de los datos y el trabajo y revele los efectos acumulativos del incumplimiento reiterado por parte de las plataformas de conciertos.

"Las empresas de plataformas operan en un espacio sin ley donde creen que pueden hacer las reglas. Desafortunadamente, esto no es un juego; las realidades virtuales tienen duras consecuencias para los trabajadores temporales en la vida real. Lo que es alentador es que los propios trabajadores no están esperando leyes, políticos o incluso aliados en el movimiento de derechos humanos para rescatarlos. Los trabajadores temporales se están organizando y utilizando su voz colectiva para exigir nuevas protecciones que se ajusten a su propósito en una economía digitalizada".

Bama Athreya, miembro, fundaciones de la sociedad abierta

Parte I: Clasificación errónea 2.0 Controlado por algoritmo

En la batalla de seis años por los derechos de los trabajadores en la economía de conciertos del Reino Unido, Uber argumentó que era simplemente el agente del conductor autónomo que no hacía nada más que reservar pasivamente órdenes de trabajo y cobrar el pago. Para avanzar en esta ficción, las plataformas de conciertos establecen elaborados contratos que hacen que parezca que el conductor y el pasajero están realizando transacciones directamente entre sí, cuando en realidad toda la información de los pasajeros está estrechamente protegida por las empresas. Uber, por ejemplo, genera una factura teórica en nombre del conductor para cada pasajero que transporta. La factura citará solo el nombre del pasajero y nunca se envía al cliente.

Estas técnicas de clasificación errónea, que se utilizan comúnmente en la economía de los conciertos, permiten que las plataformas eviten las responsabilidades legales de los empleadores, como la protección de los derechos básicos de los trabajadores y las contribuciones al seguro nacional. En el Reino Unido, también ha permitido a las empresas de plataformas evitar el impuesto sobre las ventas (IVA). Pero a principios de este año, la Corte Suprema afirmó el derecho de los tribunales inferiores a descartar los contratos artificiales y determinar la verdadera naturaleza de la relación laboral con base en la evidencia de una relación de gestión de control sobre los trabajadores.

A medida que las empresas de plataformas concluyan que el uso de contratos engañosos ya no es viable como método de clasificación errónea de empleos, se verán tentadas a duplicar la automatización de procesos para ocultar el control de gestión. El control algorítmico se convierte en una clasificación errónea 2.0. De hecho, existe amplia evidencia de que esto ya está sucediendo. Las plataformas de conciertos están más decididas que nunca a perseguir estrategias de clasificación errónea para poder seguir controlando la fuerza laboral y evitar el riesgo de que los conductores se gradúen del estado de 'trabajador' con derechos limitados al estado de empleado con sustancialmente más derechos.

Entonces, ¿qué es el control algorítmico y cuáles son los riesgos específicos para los trabajadores de conciertos? En las industrias de transporte compartido y entrega, específicamente, los medios de gestión algorítmica que más nos preocupan incluyen lo siguiente:

Vigilancia. Vigilancia intrusiva con el propósito declarado de seguridad e identificación. Esto abarca el uso de tecnologías de detección de fraude y reconocimiento facial. Somos conscientes de que la vigilancia se lleva a cabo incluso cuando el trabajador no ha iniciado sesión para estar disponible para trabajar. También incluyó vigilar el uso de la aplicación por parte del trabajador como consumidor.

Gestión del rendimiento. Esto incluye, entre otros, el seguimiento del comportamiento de conducción, incluida la ETA, las calificaciones de los clientes, las tasas de aceptación y finalización del trabajo, la interacción con el personal de apoyo y la disponibilidad.

Localización de trabajo. Uber ha insistido hasta hace muy poco en que la asignación del trabajo se decide en función de la proximidad entre conductores y pasajeros; sin embargo, ahora admite que se tienen en cuenta el comportamiento y las preferencias anteriores. Ola admite que los perfiles de los conductores que incluyen la puntuación de 'perfil de ganancias' y 'probabilidad de fraude' se utilizan en la toma de decisiones automatizada de asignación de trabajo.

Precios. Estrechamente relacionado con la asignación de trabajo está la toma de decisiones de precios automatizada. Quizás el método más conocido es el llamado 'aumento' o 'precio dinámico' de Uber, que pretende despejar la demanda del mercado con fluctuaciones de precios locales en tiempo real.

Las decisiones de gestión anteriores son en su mayoría automatizadas o semiautomatizadas con una intervención humana limitada. Los modelos de negocio de la economía de los conciertos se basan en la automatización masiva de las decisiones de gestión y la supervisión del lugar de trabajo. Si bien algunos empleadores se muestran reticentes en este punto, Deliveroo ha sido bastante franco al respecto en su política de privacidad de usuarios :

“Dado el volumen de entregas con las que tratamos, utilizamos sistemas automatizados para tomar las decisiones automatizadas descritas anteriormente, ya que brindan una forma más precisa, justa y eficiente de identificar sospechas de fraude, evitando incumplimientos repetidos de su Acuerdo de proveedor y limitando el impacto negativo en nuestro servicio. Los controles humanos simplemente no serían posibles en los plazos y dados los volúmenes de entregas con las que nos ocupamos ".

Gestión del rendimiento

Esto incluye, entre otros, el monitoreo del comportamiento de conducción, incluida la ETA, las calificaciones de los clientes, las tasas de aceptación y finalización del trabajo, la interacción con el personal de apoyo y la disponibilidad.

Precios

Estrechamente relacionado con la asignación de trabajo está la toma de decisiones de fijación de precios automatizada. Quizás el método más conocido es el llamado "aumento" o "precio dinámico" de Uber, que pretende despejar la demanda del mercado con fluctuaciones de precios locales en tiempo real.

Vigilancia

Vigilancia intrusiva con el propósito declarado de seguridad e identificación. Esto abarca el uso de tecnologías de detección de fraude y reconocimiento facial. Somos conscientes de que la vigilancia se lleva a cabo incluso cuando el trabajador no ha iniciado sesión para estar disponible para trabajar. También incluía la vigilancia del uso de la aplicación por parte del trabajador como consumidor.

Localización de trabajo

Hasta hace muy poco, Uber ha insistido en que la asignación de trabajo se decide en función de la proximidad entre los conductores y los pasajeros, pero ahora admite que se tienen en cuenta el comportamiento y las preferencias anteriores. se utilizan en la toma de decisiones automatizada de asignación de trabajo.

Parte I: Clasificación errónea 2.0 Controlado por algoritmo

En la batalla de seis años por los derechos de los trabajadores en la economía de conciertos del Reino Unido, Uber argumentó que era simplemente el agente del conductor autónomo que no hacía nada más que reservar pasivamente órdenes de trabajo y cobrar el pago. Para avanzar en esta ficción, las plataformas de conciertos establecen elaborados contratos que hacen que parezca que el conductor y el pasajero están realizando transacciones directamente entre sí, cuando en realidad toda la información de los pasajeros está estrechamente protegida por las empresas. Uber, por ejemplo, genera una factura teórica en nombre del conductor para cada pasajero que transporta. La factura citará solo el nombre del pasajero y nunca se envía al cliente.

Estas técnicas de clasificación errónea, que se utilizan comúnmente en la economía de los conciertos, permiten que las plataformas eviten las responsabilidades legales de los empleadores, como la protección de los derechos básicos de los trabajadores y las contribuciones al seguro nacional. En el Reino Unido, también ha permitido a las empresas de plataformas evitar el impuesto sobre las ventas (IVA). Pero a principios de este año, la Corte Suprema afirmó el derecho de los tribunales inferiores a descartar los contratos artificiales y determinar la verdadera naturaleza de la relación laboral con base en la evidencia de una relación de gestión de control sobre los trabajadores.

A medida que las empresas de plataformas concluyan que el uso de contratos engañosos ya no es viable como método de clasificación errónea de empleos, se verán tentadas a duplicar la automatización de procesos para ocultar el control de gestión. El control algorítmico se convierte en una clasificación errónea 2.0. De hecho, existe amplia evidencia de que esto ya está sucediendo. Las plataformas de conciertos están más decididas que nunca a perseguir estrategias de clasificación errónea para poder seguir controlando la fuerza laboral y evitar el riesgo de que los conductores se gradúen del estado de 'trabajador' con derechos limitados al estado de empleado con sustancialmente más derechos.

Entonces, ¿qué es el control algorítmico y cuáles son los riesgos específicos para los trabajadores de conciertos? En las industrias de transporte compartido y entrega, específicamente, los medios de gestión algorítmica que más nos preocupan incluyen lo siguiente:

Vigilancia. Vigilancia intrusiva con el propósito declarado de seguridad e identificación. Esto abarca el uso de tecnologías de detección de fraude y reconocimiento facial. Somos conscientes de que la vigilancia se lleva a cabo incluso cuando el trabajador no ha iniciado sesión para estar disponible para trabajar. También incluyó vigilar el uso de la aplicación por parte del trabajador como consumidor.

Gestión del rendimiento. Esto incluye, entre otros, el seguimiento del comportamiento de conducción, incluida la ETA, las calificaciones de los clientes, las tasas de aceptación y finalización del trabajo, la interacción con el personal de apoyo y la disponibilidad.

Localización de trabajo. Uber ha insistido hasta hace muy poco en que la asignación del trabajo se decide en función de la proximidad entre conductores y pasajeros; sin embargo, ahora admite que se tienen en cuenta el comportamiento y las preferencias anteriores. Ola admite que los perfiles de los conductores que incluyen la puntuación de 'perfil de ganancias' y 'probabilidad de fraude' se utilizan en la toma de decisiones automatizada de asignación de trabajo.

Precios. Estrechamente relacionado con la asignación de trabajo está la toma de decisiones de precios automatizada. Quizás el método más conocido es el llamado 'aumento' o 'precio dinámico' de Uber, que pretende despejar la demanda del mercado con fluctuaciones de precios locales en tiempo real.

Las decisiones de gestión anteriores son en su mayoría automatizadas o semiautomatizadas con una intervención humana limitada. Los modelos de negocio de la economía de los conciertos se basan en la automatización masiva de las decisiones de gestión y la supervisión del lugar de trabajo. Si bien algunos empleadores se muestran reticentes en este punto, Deliveroo ha sido bastante franco al respecto en su política de privacidad de usuarios :

“Dado el volumen de entregas con las que tratamos, utilizamos sistemas automatizados para tomar las decisiones automatizadas descritas anteriormente, ya que brindan una forma más precisa, justa y eficiente de identificar sospechas de fraude, evitando incumplimientos repetidos de su Acuerdo de proveedor y limitando el impacto negativo en nuestro servicio. Los controles humanos simplemente no serían posibles en los plazos y dados los volúmenes de entregas con las que nos ocupamos ".

“Dado el volumen de entregas que manejamos, utilizamos sistemas automatizados para tomar las decisiones automatizadas descritas anteriormente, ya que brindan una forma más precisa, justa y eficiente de identificar sospechas de fraude, prevenir incumplimientos repetidos de su Acuerdo de proveedor y limitar el impacto negativo en nuestro servicio. Los controles humanos simplemente no serían posibles en los plazos y dados los volúmenes de entregas que manejamos”.

Vigilancia

Vigilancia intrusiva con el propósito declarado de seguridad e identificación. Esto abarca el uso de tecnologías de detección de fraude y reconocimiento facial. Somos conscientes de que la vigilancia se lleva a cabo incluso cuando el trabajador no ha iniciado sesión para estar disponible para trabajar. También incluye la vigilancia del uso que el trabajador hace de la aplicación como consumidor.

Localización de trabajo

Uber ha insistido hasta hace muy poco en que la asignación de trabajo se decide en función de la proximidad entre los conductores y los pasajeros, pero ahora afirma que se tienen en cuenta el comportamiento y las preferencias anteriores. Ola utiliza perfiles de conductor que incluyen "puntuaciones de probabilidad de fraude" en la toma de decisiones automatizada para el trabajo. asignación.

Gestión del rendimiento

La evaluación del desempeño laboral incluye, entre otros, el monitoreo del comportamiento de conducción, incluida la ETA, las calificaciones de los clientes, las tasas de aceptación y finalización del trabajo, la interacción con el personal de apoyo y la disponibilidad.

Precios

Estrechamente relacionado con la asignación de trabajo está la fijación automática de precios. Quizás el método más conocido es el llamado "aumento" o "precio dinámico" de Uber, que pretende despejar la demanda del mercado con fluctuaciones de precios locales en tiempo real.

Carrera armamentista de vigilancia

Hemos presenciado una carrera de armas de vigilancia en la economía de los conciertos desde que Uber introdujo su llamado Sistema de identificación en tiempo real híbrido durante 2020. Justo un día antes de que Transport for London (TfL) anunciara su decisión de rechazar la renovación de su licencia en noviembre de 2019, Uber se ofreció a introducir este sistema de vigilancia que incorpora reconocimiento facial con monitoreo GPS.

Esto fue en respuesta a la queja de TfL de que se había detectado a 21 conductores (de los 90,000 analizados durante varios años) que participaban en el intercambio de cuentas, lo que permitía a los conductores potencialmente sin licencia y sin seguro ofrecer ilegalmente sus servicios en la aplicación. La actividad fue posible al restablecer la ubicación GPS del dispositivo como fuera del Reino Unido, donde es posible que los conductores carguen sus propias fotos. Uber cerró rápidamente esta brecha y la actividad detectada fue extremadamente pequeña en comparación con la escala de la operación de Uber. La introducción de la tecnología de reconocimiento facial por parte de la industria ha sido completamente desproporcionada en relación con el riesgo percibido. Sin embargo, el requisito de identificación en tiempo real pasó a convertirse en una condición para la renovación de la licencia de Uber en el Tribunal de Magistrados de Westminster en septiembre de 2020.

En el caso de Uber, tanto la administración de la plataforma como TfL no han logrado garantizar que se implementaron las salvaguardas adecuadas para proteger los derechos y libertades de los conductores a pesar de que TfL había revisado la evaluación de impacto de protección de datos para la tecnología en marzo de 2020. Solicitud de libertad de información a TfL para tener acceso a la DPIA de Uber para los sistemas de identificación en tiempo real, pero se nos negó. Según los informes de TfL , el 94% de los conductores de vehículos de alquiler privados (PHV) provienen de minorías negras y étnicas y la introducción de esta tecnología, que es bien reconocida por sus bajas tasas de precisión dentro de estos grupos , ha demostrado ser desastrosa para los trabajadores vulnerables que ya están en empleo precario.

Desde entonces, Bolt anunció que estaba invirtiendo 150 millones de euros en sistemas de detección antifraude de controladores de inteligencia artificial, incluido el reconocimiento facial. Deliveroo anunció que ellos también introducirían controles de identidad por reconocimiento facial. Ola Cabs también ha implementado la identificación de reconocimiento facial como una característica de su sistema Guardian , incorporando el aprendizaje automático que, según ellos, les permite "aprender y evolucionar continuamente a partir de millones de puntos de datos todos los días, para mejorar la señalización de riesgos y la resolución instantánea".

FreeNow, una empresa conjunta de Daimler y BMW, también vigila de cerca a los conductores como parte de su programa de prevención del fraude. De hecho, los documentos presentados por FreeNow ante el Tribunal Superior en una revisión judicial de la decisión de TfL de otorgarles una licencia en Londres, revelaron que TfL ha realizado informes mensuales de despidos de conductores por diversas razones (incluida la 'actividad fraudulenta') una condición de su Renovación reciente de licencia. Pero la descripción de los datos procesados con el fin de prevenir el fraude plantea más preguntas de las que responde la política de privacidad de FreeNow.

En este documento, Free Now afirma que utilizan un algoritmo de "bosque aleatorio" para producir una puntuación de fraude que utilizan para " priorizar los viajes enviados en consecuencia". Esto asegura un envío justo y con riesgo mínimo ”. Free Now impugnó el uso de este sistema de detección de fraude cuando preguntamos al respecto en junio de 2021, alegando que esta sección de la política de privacidad estaba desactualizada (consulte el estudio de caso de la empresa en la sección II del informe). Sin embargo, la descripción de este sistema se ha mantenido en la política, a pesar de una actualización realizada en septiembre de 2021.

Lo que es particularmente preocupante sobre el uso de estos sistemas es que combinan la gestión del fraude con la gestión del desempeño. El hecho de que dichos indicadores de 'fraude' se utilicen como variables para la asignación de trabajo y que se permita que los comportamientos que los generan continúen en la plataforma demuestra que no se trata de instancias de fraude criminal, sino de mecanismos de control, que evalúan el desempeño de los trabajadores. frente a las opacas métricas establecidas por las empresas. Sugerimos que cualquier terminología de 'fraude' utilizada en estos contextos también funciona como parte del juego de clasificación errónea, diseñado para ocultar la relación laboral.

Estudio de caso de vigilancia I: Fallo en el reconocimiento facial

En abril de 2020, Uber introdujo un sistema de verificación de identificación en tiempo real (RTID) en el Reino Unido que utiliza una combinación que incluye reconocimiento facial y verificación de ubicación para autenticar la identidad de un conductor e intentar evitar que los conductores compartan el acceso a su cuenta para trabajar.

El sistema RTID incorpora el uso de la API FACE de Microsoft, el software de reconocimiento facial y requiere que los conductores y mensajeros se tomen selfies en tiempo real de forma rutinaria para seguir usando la aplicación Uber. Luego, la foto se compara con la imagen de perfil de la cuenta del conductor (y en algunas jurisdicciones, con bases de datos públicas para " evitar el préstamo de identidad o para verificar las identidades de los usuarios ").

Pa Edrissa Manjang había estado trabajando con Uber durante aproximadamente un año cuando fue desactivado debido a una falla en la verificación de la selfie. Si bien los conductores y mensajeros de Uber brindan selfies de manera rutinaria, estos no se almacenan en los teléfonos de los trabajadores y no pueden retener la evidencia de sus envíos. Pa no recibió advertencias ni notificó ningún problema hasta su despido; el sistema de verificación de identificación en tiempo real pareció aprobar todas sus fotografías con un cheque verde.

Después de su despido, Pa envió numerosos mensajes a Uber para rectificar el problema, pidiendo específicamente que un humano revisara sus presentaciones. Cada vez que le dijeron a Pa "no pudimos confirmar que las fotos proporcionadas eran en realidad tuyas y debido a las continuas discrepancias, tomamos la decisión final de poner fin a nuestra asociación contigo". Obtuvimos las selfies en cuestión a través de una solicitud de acceso de sujeto, que reveló que todas las fotos que Pa envió eran en realidad suyas. Esta fue la primera instancia en la que logramos obtener las selfies enviadas por un mensajero o conductor. No está claro por qué esta solicitud tuvo éxito cuando muchas antes fracasaron.

También escribimos a Microsoft a principios de año para plantear nuestras preocupaciones con respecto al uso no regulado de la API FACE por parte de Uber en su plataforma. En respuesta , Microsoft enfatizó que todas las partes involucradas en la implementación de dichas tecnologías tienen responsabilidades que incluyen: "incorporar una revisión humana significativa para detectar y resolver casos de identificación errónea u otras fallas". y "para brindar apoyo a las personas que creen que sus resultados fueron incorrectos e identificar y abordar las fluctuaciones en la precisión debido a la variación en las condiciones". El caso de Pa demuestra claramente que estos controles cruciales no se han implementado en el procesamiento de imágenes RTID.

Pa ahora presenta un caso contra Uber para impugnar su despliegue de reconocimiento facial racialmente discriminatorio, representado por Bates Wells, con el apoyo de la Comisión de Igualdad y Derechos Humanos, App Drivers and Couriers Union y Worker Info Exchange.

EMBED: video de papá

Estudio de caso de vigilancia II: Verificaciones de geolocalización

Si bien el uso de sistemas de reconocimiento facial defectuosos es indudablemente problemático, también hemos visto que muchos conductores fueron despedidos después de falsas acusaciones de Uber de que participaban en el uso compartido de cuentas fraudulentas después de que Uber detectara dos dispositivos en dos ubicaciones al mismo tiempo. En todos los casos que hemos analizado, hemos encontrado que el problema está relacionado con que el controlador instaló la aplicación en dos dispositivos por conveniencia, pero solo uno de los dispositivos inició sesión para trabajar.

Justo antes de las 8 pm del 11 de septiembre de 2020 y Aweso Mowlana estaba trabajando para Uber en el sur de Londres. Era un conductor con calificación de 4.95 estrellas que había realizado más de 11,500 viajes en más de 5 años trabajando para Uber. Aweso acababa de dejar a un pasajero cerca de Elephant and Castle cuando se desconectó para un breve descanso. Como muchos controladores, Aweso había instalado la aplicación en un segundo dispositivo que era un iPhone. Esa noche en particular había dejado el iPhone en casa y estaba trabajando con su otro teléfono, un Samsung.

A las 8:02 pm, Aweso intentó volver a iniciar sesión en la aplicación Uber para estar disponible para su próximo trabajo. Antes de que se le permitiera volver a iniciar sesión, se le pidió que proporcionara una selfie como parte de la Verificación de identidad en tiempo real (RTID) de Uber. Su foto coincidía con la foto de referencia de Uber, por lo que completó con éxito el procedimiento de inicio de sesión para continuar su turno. Pero sin que él lo supiera, los sistemas de Uber habían detectado y / o hecho ping a su segundo teléfono. Su hijo había cogido su segundo teléfono por error y se lo había llevado a la casa de su novia en Uxbridge. Uber dijo más tarde que solicitaron un cheque RTID de este dispositivo a las 8:03 pm, pero en ese momento Aweso ya estaba en línea en el sur de Londres. Uber afirma que la respuesta a la verificación de identidad se envió desde el iPhone alrededor de las 11:55 p.m. de esa noche.

Al día siguiente, Uber le informó que su cuenta había sido 'marcada por actividad de aplicación sospechosa' y que su cuenta ahora se suspendería mientras 'un equipo especializado revisa esto'. Algún tiempo después, Uber despidió permanentemente a Aweso a través de un mensaje de texto diciendo que habían 'encontrado evidencia que indica actividad fraudulenta' en su cuenta. Luego, Uber alegó que estaba compartiendo el acceso a su cuenta y, al hacerlo, había incumplido los términos y condiciones. Al mes siguiente, Transport for London revocó de inmediato la licencia de Aweso con el argumento de que ya no se podía considerar que estuviera "en forma y adecuado" para tener una licencia pública debido a su despido de Uber.

Worker Info Exchange ayudó a Aweso a realizar una solicitud de acceso al sujeto y analizar los datos recibidos. Un archivo llamado ' Datos detallados del dispositivo de D river' registra al menos algunos de los datos que se transmiten desde los dispositivos a Uber en tiempo real. La propia política de privacidad de Uber indica que cuando un dispositivo tiene la aplicación abierta en segundo plano o en primer plano, incluso si no está en línea y está lista para aceptar tarifas. En más de una docena de casos en los que apoyamos que los conductores apelaran sus revocaciones en el Tribunal de Magistrados, se confirmó cada apelación y se ordenó a TfL que restableciera las licencias. A partir de este archivo, pudimos ver hasta 230 filas de datos por minuto que Uber registra desde los dispositivos. Los datos que Uber recopiló de los dispositivos de Aweso incluyeron ubicación geográfica, nivel de batería, velocidad, rumbo del curso, número IMEI, etc.

Los datos mostraron que el dispositivo en Uxbridge nunca había iniciado sesión para trabajar ese día porque un campo titulado 'driver_online' mostraba el iPhone como 'FALSO' en todo momento ese día, incluida la hora en que se registró en Uxbridge. Esta es una prueba de que el dispositivo no se estaba compartiendo para trabajar con otros, como alegan Uber y Transport for London. Uber no proporcionó acceso a los datos personales procesados en ambas verificaciones de RTID, incluidas las fotos recopiladas. Los 'Datos detallados del dispositivo' no muestran ningún registro de ninguna actividad adicional para el iPhone después de las 8:03:43 pm. No vimos evidencia de datos de actividad del dispositivo a las 11:55 p.m. cuando Uber dijo que recibió una respuesta a la verificación de identificación emitida anteriormente.

La experiencia de Pa y Aweso fue muy frecuente durante el año pasado y representó un volumen significativo de casos manejados por Worker Info Exchange y App Drivers & Couriers Union. En Londres, Transport for London tendió a revocar de inmediato las licencias de los conductores que, según se informó, no aprobaron los controles RTID de Uber a pesar de los problemas obvios con el sistema. A menudo, existen explicaciones razonables para el uso de varios dispositivos que se clasifican automáticamente como fraude. La propia política de privacidad de Uber indica que cuando un dispositivo tiene la aplicación abierta en segundo plano o en primer plano, incluso si no está en línea y está lista para aceptar tarifas. En más de una docena de casos en los que apoyamos que los conductores apelaran sus revocaciones en el Tribunal de Magistrados, se confirmó cada apelación y se ordenó a TfL que restableciera las licencias.

Worker Info Exchange, Big Brother Watch y App Drivers & Couriers Union escribieron una carta conjunta al alcalde de Londres para plantear nuestras preocupaciones sobre la confianza de Transport for London en pruebas defectuosas de Uber para tomar una decisión de revocación y exigieron que, como presidente de Transportes para la junta de Londres, que ordene una revisión de todas esas revocaciones injustas. Hasta la fecha, ni el alcalde ni TfL han respondido.

Gestión del rendimiento opaco

La opacidad de las empresas de plataformas inhibe la comprensión de los trabajadores sobre cómo se puede integrar el control algorítmico en la gama de procesos críticos y a lo largo del tiempo. Por ejemplo, a los trabajadores no se les ha proporcionado la transparencia a la que tienen derecho legalmente para comprender cómo el perfil de desempeño se relaciona con la calidad y cantidad del trabajo ofrecido, así como con los rendimientos esperados para dicho trabajo.

En el caso de Ola, tenemos cierto conocimiento de las categorías de datos que recopilan y procesan en sus sistemas de asignación de trabajo, como puntajes de probabilidad de fraude, perfil de ganancias, historial de aceptación y cancelación de reservas, entre otros, sin embargo, esto no revela las diferentes ponderaciones. aplicado a estas variables, ni la lógica de procesamiento.

Uber ha sostenido durante mucho tiempo que su sistema de emparejamiento está determinado únicamente por la ubicación, a pesar de que su propia interfaz "Partner-Driver" sugiere lo contrario. El programa Pro de Uber (en el que los conductores se inscriben automáticamente para que puedan ser incentivados a cumplir los objetivos de rendimiento a cambio de beneficios y recompensas) informa a los conductores en un lenguaje vago que “las tasas de confirmación más altas significan tiempos de espera más cortos para los clientes y tiempos de recogida más cortos para todos conductores ”, aludiendo vagamente al hecho de que la disminución de puestos de trabajo resultará en menos ofertas de trabajo.

Uber solo recientemente ha ofrecido más transparencia en el sistema de coincidencia a través de una actualización de su política de privacidad que establece que "los usuarios pueden ser emparejados en función de la disponibilidad, la proximidad y otros factores, como la probabilidad de aceptar un viaje en función de su comportamiento o preferencias anteriores". pero, en el momento de redactar este documento, el enlace que ofrece más información sobre el sistema de comparación está roto, lo que demuestra la naturaleza cambiante de dicho procesamiento de datos. Una solicitud reciente de libertad de información que le hicimos a TfL, preguntando qué actualizaciones había proporcionado Uber en su sistema de emparejamiento (como está obligado a hacer cuando realiza cambios en su modelo operativo) no arrojó resultados, lo que destaca aún más la ofuscación de sus prácticas de gestión algorítmica. y la ausencia de supervisión regulatoria.

Las recientes revelaciones sobre las variables que determinan la asignación de trabajo también plantean importantes preguntas sobre la calidad de los trabajos ofrecidos a los conductores. ¿Se ofrecen a los conductores con altas tasas de aceptación del trabajo viajes de mayor duración y duración, lo que resulta en un salario más alto, sobre la base de perfiles similares? O, yendo un paso más allá, ¿se ofrecen tarifas diferentes a los conductores a través del sistema de precios dinámicos? De hecho, si los precios algorítmicos se combinan con la asignación de trabajo, y cómo, es un tema delicado sobre el que aún se sabe poco.

En los últimos años, Uber ha reemplazado los precios variables de tiempo y distancia para los clientes por un modelo de precios fijos en el que se acepta un precio por adelantado al comienzo de un viaje. Uber afirma que "el precio inicial es dinámico, lo que significa que el precio se calcula en tiempo real para ayudar a equilibrar la oferta y la demanda". Más recientemente, los conductores han informado que se les ofrecen tarifas muy bajas para trabajos individuales. Existe una oportunidad obvia para que Uber aumente su participación en la tarifa eventual pagada por los pasajeros. Se han planteado preocupaciones sobre los resultados discriminatorios del uso de estos sistemas de precios dinámicos en los pasajeros, lo que introduce la posibilidad de que los conductores también puedan estar sujetos a precios personalizados en tiempo real. Aquí existen serios problemas éticos si los operadores ofrecen precios más bajos a los trabajadores vulnerables basándose en la elaboración de perfiles que predice su voluntad de aceptar trabajo a diferentes precios.

En el Reino Unido, estas prácticas parecen ser contrarias a las disposiciones de la Sección 1 de la Ley de Derechos Laborales que da derecho a los trabajadores a recibir de su empleador una declaración clara de los términos de las condiciones de su trabajo, incluidas las tasas de pago.

Estudio de caso: control algorítmico

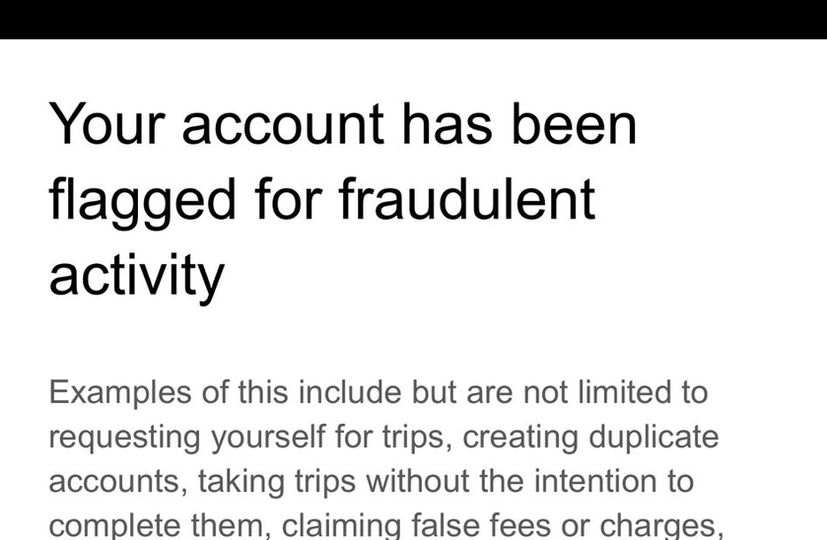

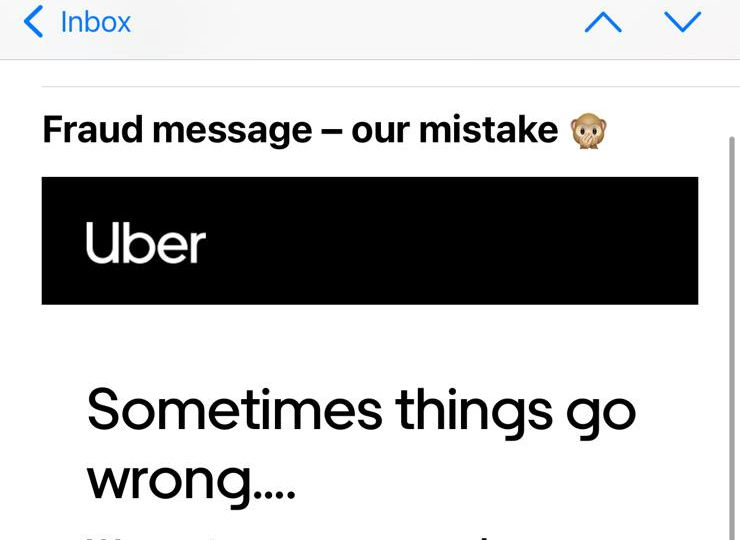

Uber envía mensajes a los conductores de forma rutinaria cuando son marcados por sus sistemas de detección de fraude para advertirles que pueden perder su trabajo si continúan con cualquier comportamiento que esté activando el sistema. Los mensajes contienen una lista no exhaustiva de los posibles desencadenantes, pero no proporcionan una razón específica para el conductor individual que está siendo acusado de fraude. Cuando Alexandru recibió el segundo y último de estos mensajes, sabiendo que otra bandera resultaría en el despido, decidió llamar al equipo de apoyo al conductor para obtener más detalles sobre por qué estaba activando el sistema antifraude y qué podía hacer para evitarlo. . A través de la llamada , Alexandru y el agente de soporte discutieron una variedad de situaciones que pueden haber causado que sus viajes parecieran irregulares, revelando la capacidad limitada que tienen los equipos de soporte para descifrar las indicaciones hechas por el sistema. Tres meses después de esta llamada, Uber envió un mensaje de disculpa indicando que le habían enviado las advertencias por error.

Si bien la conversación es esclarecedora en términos de comprensión de los dilemas que enfrentan los conductores cuando la política de la empresa y las demandas de los pasajeros divergen, de particular interés para nosotros fue la discusión (25 minutos después de la llamada) sobre un desvío que Alexandru tomó debido a obras viales, así como su baja las tasas de aceptación de puestos de trabajo como posibles causas de su detección por parte del sistema antifraude. Tras el fallo de la Corte Suprema que clasificó a los conductores de Uber como trabajadores a principios de este año, Uber afirmó haber realizado cambios significativos en su plataforma , como ofrecer transparencia de precio y destino, así como eliminar las medidas punitivas por rechazar trabajos, en un intento por argumentar que el fallo de la Corte Suprema no se aplicó a los conductores actuales de Uber.

La experiencia de Alexandru en la plataforma va en contra de esta narrativa, ya que se hace evidente que es probable que lo marquen por desviarse de la ruta (a pesar del hecho de que Uber ahora opera un modelo de precio fijo, lo que significa que los conductores realizan tales cambios de ruta por su cuenta) y no aceptar lo suficiente del trabajo que se le ofreció en la plataforma. Esta llamada deja indudablemente claro que, en la práctica, los conductores siguen estando tan controlados por Uber como antes.

Además de estas prácticas de gestión, el programa Pro mencionado anteriormente es otra herramienta que Uber utiliza para ejercer control sobre su fuerza laboral, al tiempo que elude las obligaciones legales que puedan estar asociadas con dicho control. Por ejemplo, al vincular ciertas recompensas que culminan por mantener una calificación alta a empresas de terceros o presentar la participación en los beneficios de precios como puramente opcional a través de un empujón de comportamiento, Uber crea la ilusión de permitir que los conductores operen con total independencia y flexibilidad. El supuesto compromiso voluntario de los conductores con estos programas resulta en la renuncia a los derechos resultantes de tener una relación laboral.

EMBED: video de Alexandru

Expansión de la infraestructura de aplicación de la ley

También hay evidencia de que las plataformas se han convertido cada vez más en una fuente atractiva de inteligencia para la policía y los servicios de seguridad. En una declaración de un testigo presentada como prueba en septiembre de 2020 en la apelación de licencia de Uber en el Tribunal de Magistrados de Westminster, el gerente general de Uber del Reino Unido y Europa Occidental, Jamie Heywood, atestiguó una relación cada vez más cercana con la policía y los servicios de seguridad. Estos incluyen la Red Nacional de Policía contra el Terrorismo, SO15 - el Comando contra el Terrorismo del Servicio de Policía Metropolitana, el Consejo de Jefes de Policía Nacional (NPCC), el Colegio de Policía, la Agencia Nacional contra el Crimen y la Policía de Transporte Británica. Un área de cooperación ha sido el problema del transporte de drogas llamado County Lines. Citando al inspector detective Stuart Liddell del NPCC, Heywood testificó sobre una relación madura basada en niveles sofisticados de intercambio de inteligencia:

“Me alienta el compromiso mostrado por Uber con respecto a este asunto y se planea trabajar más [en 2020] para aprovechar el trabajo hasta ahora. Esto se centrará en aspectos más intrincados de las Líneas del Condado, el flujo de información e inteligencia y el fortalecimiento de la relación entre el Centro Nacional de Coordinación de las Líneas del Condado ".

De hecho, el NPCC presionó al comisionado de Transporte para Londres, Mike Brown, en apoyo de la apelación de la licencia de Uber. El jefe de policía Mark Collins incluso llegó a sugerir que la decisión de negarle a Uber su licencia podría tener un impacto negativo en la policía del Reino Unido.

"Con suerte, esta carta describe el impacto negativo en la actuación policial del Reino Unido en caso de que la policía no pueda acceder a los datos y la información que he descrito".

Heywood también testificó que Collins había afirmado que solo el Servicio de Policía Metropolitana realizaba más de 2.000 solicitudes de datos a Uber cada año. Este es un número relativamente alto de solicitudes considerando que, según el propio Informe de Transparencia de Uber, en 2020 todas las autoridades policiales de EE. UU. Juntas realizaron poco menos de 5,000 solicitudes de datos y todas las autoridades policiales canadienses juntas hicieron solo 411 solicitudes de este tipo.

Es probable que la administración de Uber se sienta presionada a cooperar con las iniciativas de recopilación de inteligencia policial, particularmente a la luz de la decisión de Transport for London de rechazar la renovación de su licencia dos veces. Esto se debe a que la sección 17 de la Ley de delitos y desórdenes de 1998 asigna una responsabilidad directa a las autoridades que otorgan licencias para prevenir el crimen y el desorden en su área. Esto establece un requisito para que las autoridades que otorgan licencias, como Transport for London, establezcan asociaciones de reducción de delitos y desórdenes (CDRP) en las que se espera que participen operadores de transporte como Uber.

En la orientación legal del Departamento de Transporte para las autoridades que otorgan licencias, el gobierno refuerza la expectativa de intercambio de inteligencia entre la policía, las autoridades que otorgan licencias y los operadores de transporte como Uber:

“Aumentar la conciencia entre las fuerzas policiales sobre el valor que las autoridades otorgan a la información recibida, particularmente en inteligencia sin convicciones, ayudará a promover estas relaciones y reforzará los beneficios de un mayor intercambio de información. Esta relación puede ser de beneficio mutuo, ayudando a la policía a prevenir el crimen. La policía puede obtener información valiosa de los conductores y operadores ... "

Si bien estas relaciones tienen una importancia significativa para el control del crimen a nivel comunitario, parece que se ha prestado poca atención al riesgo para las libertades civiles de un acceso relativamente fácil a los datos personales de conductores y pasajeros recopilados y almacenados por plataformas como Uber, Bolt y Ola. Taxis.

“Me alienta el compromiso mostrado por Uber con respecto a este asunto y se planea más trabajo [en 2020] para aprovechar el trabajo realizado hasta ahora. Esto se centrará en aspectos más intrincados de las Líneas del Condado, el flujo de información e inteligencia y el fortalecimiento de la relación entre el Centro Nacional de Coordinación de las Líneas del Condado”.

“Con suerte, esta carta describe el impacto negativo en la policía del Reino Unido en caso de que la policía no pueda acceder a los datos y la información que he descrito”.

“Aumentar la conciencia entre las fuerzas policiales sobre el valor que las autoridades otorgantes de licencias otorgan a la información recibida, particularmente sobre la inteligencia sin condena, ayudará a promover estas relaciones y reforzará los beneficios de un mayor intercambio de información. Esta relación puede ser mutuamente beneficiosa, ayudando a la policía a prevenir delitos. La policía puede obtener inteligencia valiosa de los conductores y operadores...”

Estudio de caso: intercambio de inteligencia con las fuerzas del orden

Otro trabajador que se acercó a nosotros en busca de ayuda fue un conductor de Uber que fue suspendido por error de la plataforma de Uber durante siete semanas, incurriendo en una pérdida de casi £ 5000, luego de una solicitud de inteligencia realizada por la policía. En 2019, el conductor recibió un mensaje de Uber indicando que fue suspendido temporalmente debido a una investigación en curso. No se le dio una razón ni un plazo para su suspensión. De hecho, le dijeron expresamente que no contactara a Uber mientras realizaban la investigación. Siete semanas después, recibió una llamada informándole que ahora podía trabajar.

Dos años después, una solicitud de renovación de licencia que el conductor hizo a TfL (que incluye una verificación mejorada de Divulgación y restricción del servicio) reveló el motivo de la suspensión, cuando TfL lo interrogó sobre el suministro de drogas en 2019 y amenazó con quitarle la licencia. Conmocionado por la revelación, el conductor exigió un número de referencia del crimen e hizo más investigaciones no solo con TfL, sino también con la Policía Metropolitana.

Ayudamos al conductor a realizar solicitudes de acceso de sujetos y quejas a Uber, TfL y la policía. Uber no cumplió con la solicitud (se informó al conductor que su solicitud se pasó a un equipo de especialistas pero no recibió más respuesta) sin embargo, la respuesta de TfL descubrió una extensa cadena de correos electrónicos entre varios funcionarios mientras intentaban identificar la fuente de la inteligencia. solicitud. Uber afirmó que la policía se les acercó, mientras que la policía no pudo localizar ningún registro o evidencia de la investigación del conductor. Finalmente, Uber nombró al oficial que había hecho la solicitud de inteligencia, pero cuando TfL buscó detalles sobre el caso, la OIC afirmó que no recordaba al conductor en cuestión.

La denuncia que el conductor hizo a la Policía Metropolitana fue finalmente respondida en octubre de 2021 y concluyó que el conductor nunca había sido identificado como sospechoso:

“Los agentes tenían la tarea de identificar a un sospechoso en relación con un delito grave. A los agentes se les había pasado el nombre de una persona de interés. Puedo confirmar que NO eras tú. Se envió un formulario de protección de datos el 20 de febrero de 2019 a Uber con los detalles del sospechoso nombrado. No tengo la libertad de revelar más detalles sobre esto.

“En ningún momento apareció su nombre en esta consulta de investigación realizada con Uber. El oficial NO se acercó a Uber en busca de información relacionada con usted. Como resultado de nuestra consulta, Uber proporcionó a la policía sus datos. Una vez que se recibió la información de Uber y nos dieron su nombre, supimos que NO estaba vinculado a nuestra investigación y no se tomaron más medidas y se lo excluyó de cualquier otra investigación ".

“El oficial no ha violado ningún estándar profesional ni ha actuado fuera de su función como oficial de policía ni ha abusado de su poder. Tu nombre no era el propósito de la solicitud y en ningún momento le dijimos a Uber que eras una persona de interés ".

"Uber tal vez debería explicar cómo suspenden a alguien que no era el sujeto de la solicitud original y también por qué, después de 10 días, no se te reintegró automáticamente a la aplicación y no pudiste seguir trabajando".

EMBED: Video de L

“Los oficiales tenían la tarea de identificar a un sospechoso en relación con un delito grave. A los oficiales se les había pasado el nombre de una persona de interés. Puedo confirmar que NO fuiste tú. El 20 de febrero de 2019 se envió un formulario de protección de datos a Uber con los detalles del sospechoso nombrado. No tengo la libertad de revelar más detalles sobre esto.

“En ningún momento su nombre apareció en esta investigación realizada con Uber. El oficial NO se acercó a Uber en busca de información relacionada con usted. Como resultado de nuestra investigación, Uber proporcionó a la policía sus datos. Una vez que se recibió la información de Uber y nos dieron su nombre, supimos que NO estaba vinculado a nuestra investigación y no se tomaron más medidas y se le excluyó de cualquier otra investigación”.

“El oficial no ha violado ningún estándar profesional ni actuó fuera de su rol como oficial de policía ni abusó de su poder. Su nombre no era el propósito de la solicitud y en ningún momento le dijimos a Uber que usted era una persona de interés”.

“Uber quizás debería explicar cómo suspenden a alguien que no era el sujeto de la solicitud original y también por qué, después de 10 días, no se le restableció automáticamente en la aplicación y no pudo seguir trabajando”.

Parte II: Ejercicio de los derechos sobre los datos en el trabajo: acceso

La legislación laboral no cuenta con las disposiciones necesarias para proteger plenamente a los trabajadores de las prácticas desleales derivadas de la gestión algorítmica. Sin embargo, las personas tienen derechos en virtud del RGPD que pueden proteger sus intereses en contextos laborales. Al apoyar a los trabajadores, invocamos sus derechos definidos en los artículos 15, 20 y 22, que les otorgan el derecho a acceder a los datos personales , el derecho a la portabilidad de los datos , así como el derecho a ser informados sobre la toma de decisiones automatizada y la lógica. de procesamiento .

Artículo 22: Los interesados no pueden estar sujetos a decisiones con efectos legales (o igualmente significativos), basadas únicamente en el procesamiento automatizado de datos.

[Si el responsable del tratamiento procesa datos con el consentimiento explícito del interesado, o para la ejecución de un contrato con él, el interesado tiene derecho a obtener la intervención humana, a expresar su punto de vista y a impugnar la decisión]

Artículo 15: Los interesados tienen derecho a recibir una copia de sus datos personales, junto con información complementaria, como los fines del procesamiento de datos, información sobre con quién se pueden compartir los datos, la duración del procesamiento, etc.

Articulo 20: Los interesados tienen derecho a recibir los datos personales que hayan proporcionado a un controlador en un formato estructurado, de uso común y legible por máquina. También tienen derecho a transmitir ("puerto") los datos a otro responsable del tratamiento. Cuando sea posible, pueden solicitar que los datos se transmitan directamente de un responsable del tratamiento a otro.

Si bien las plataformas hacen que las descargas de datos estén disponibles para los trabajadores, con frecuencia omiten las categorías de datos más propicias y necesarias para interrogar las condiciones de trabajo (como la equidad de pago, la asignación y la utilización del trabajo como se enumeran anteriormente). En nuestra aspiración de expandir el alcance de datos puestos a disposición de los trabajadores, realizamos solicitudes específicas de portabilidad y acceso de sujetos que cubren la gama completa de datos que las plataformas de conciertos recopilan de ellos. En estas solicitudes buscamos obtener tres tipos de datos diferentes:

1) Datos de entrada, proporcionados por los propios trabajadores

2) Datos de observación: basados en el uso de plataformas por parte de los trabajadores (es decir, datos brutos de medición y vigilancia, como datos de ubicación, telemática, etc.)

3) Datos inferidos: derivados del análisis de datos de observación (por ejemplo, elaboración de perfiles del comportamiento de los trabajadores en forma de evaluaciones de riesgo y fraude)

Artículo 22: Los interesados no pueden ser objeto de decisiones con efectos jurídicos (o de similar trascendencia), basadas únicamente en el tratamiento automatizado de datos.

[Si el responsable del tratamiento trata los datos con el consentimiento explícito del interesado, o para la ejecución de un contrato con él, el interesado tiene derecho a obtener la intervención humana, a expresar su punto de vista y a impugnar la decisión]

Artículo 15: Los interesados tienen derecho a recibir una copia de sus datos personales, junto con información complementaria, como los fines del procesamiento de datos, información sobre con quién se pueden compartir los datos, la duración del procesamiento, etc.

Artículo 20 : Los interesados tienen derecho a recibir los datos personales que hayan proporcionado a un responsable del tratamiento en un formato estructurado, de uso común y lectura mecánica. También tienen derecho a transmitir ('portar') los datos a otro controlador. Cuando sea factible, pueden solicitar que los datos se transmitan directamente de un controlador a otro.

Datos de entrada

Proporcionado por los propios trabajadores.

Datos observados

Basado en el uso de las plataformas por parte de los trabajadores (es decir, datos de medición y vigilancia sin procesar, como datos de ubicación, telemática, etc.)

Datos inferidos

Derivado del análisis de datos de observación (p. ej., elaboración de perfiles del comportamiento de los trabajadores en forma de evaluaciones de riesgo y fraude)

Estas categorías de datos a menudo se hacen explícitas en los documentos de orientación y las políticas de privacidad, pero no se comparten con los conductores cuando descargan sus datos o realizan solicitudes de acceso de sujetos. En nuestra experiencia, cuando los trabajadores buscan esta información, las plataformas de conciertos tienen como objetivo hacer que el proceso sea difícil y oneroso al involucrarse en una variedad de comportamientos de incumplimiento. Los trabajadores que buscan datos completos tienen que navegar por arquitecturas de sitios web extremadamente complejas y obstruccionistas y deben eludir esfuerzos adicionales de frustración por parte de los agentes de soporte, que prolongan innecesariamente los procesos administrativos simples o brindan respuestas automáticas que no responden adecuadamente a las consultas. Estos procedimientos pueden describirse como " patrones oscuros" diseñados para alejar a los trabajadores del ejercicio de sus derechos como interesados. En las ocasiones en que los trabajadores pueden obtener sus datos, a menudo faltan segmentos considerables o se presentan en formatos inconsistentes y no legibles por máquina, lo que hace que el análisis sea efectivamente imposible. Estos actos de obstrucción obligan a los trabajadores a realizar solicitudes reiteradas que las empresas finalmente utilizan como motivo para desacreditarlos.

En todas las devoluciones de DSAR que hemos visto, ningún empleador ha brindado una cuenta completa y adecuada del procesamiento automatizado de datos personales. Esto es particularmente importante en áreas que pueden determinar la seguridad del empleo, como la asignación de trabajo, la gestión del desempeño, la seguridad y la protección, como se analiza en este informe. Uber y Ola han argumentado ante los tribunales que la seguridad de su plataforma puede verse comprometida si la lógica de dicho procesamiento de datos se revela a sus trabajadores. En nuestra opinión, la seguridad y la protección solo se pueden mejorar cuando las plataformas establecen reglas y estándares de desempeño de manera transparente en lugar de depender de la vigilancia encubierta y los despidos sumarios, que son algunos de los motivadores clave de las DSAR.

Dada esta actitud resistente a los DSAR, también es importante tener en cuenta que muchos conductores temen represalias por parte de las empresas por realizar solicitudes. Cuando las plataformas de conciertos realizan verificaciones de identidad inmoderadas y prolongadas en respuesta a las solicitudes de acceso de los sujetos, los trabajadores se desaniman e intimidan fácilmente (consulte los correos electrónicos que Uber envía a los conductores en los estudios de casos de respuesta de la plataforma). En las numerosas entrevistas que hemos realizado con los conductores, los mensajes extensos de búsqueda de confirmación, transmitidos en un lenguaje legal complejo, se han mencionado con frecuencia como disuasivos para continuar con las solicitudes. Para muchos conductores, el acto de insistir en la solicitud equivale a sacar la cabeza por encima del parapeto y arriesgar el sustento y la seguridad laboral.

Esta percepción a menudo surge de experiencias de explotación e inseguridad continuas, derivadas de la capacidad y el conocimiento limitados de los trabajadores para ejercer los derechos democráticos, ya sea en el Reino Unido como inmigrantes o en sus países de origen, que en muchos casos muestran tendencias autoritarias. En una fuerza laboral que ya está muy fragmentada y propensa a la precariedad económica, donde la necesidad de seguridad supera con creces el deseo de desafiar la injusticia, el impacto de este tipo de comportamiento hostil por parte de las empresas no puede subestimarse. Esta inseguridad se ve agravada además por la opacidad de los algoritmos de gestión. En ausencia de explicaciones claras de cómo funcionan los sistemas de gestión del rendimiento o asignación de trabajo de caja negra, se vuelve muy fácil para los trabajadores involucrarse en pensamientos especulativos o incluso conspirativos sobre cómo sus interacciones con la plataforma afectan su trabajo. Esto puede luego extenderse a una desconfianza generalizada hacia otras instituciones y una aversión hacia la actividad organizativa. Estas son vulnerabilidades fuertes y persistentes en la fuerza laboral que requieren especial atención y protección.

Estudios de caso: DSAR individuales

Los siguientes estudios de caso demuestran algunas de las formas en que Uber se involucra en comportamientos obstructivos y de incumplimiento al responder a las solicitudes de datos de los trabajadores. Es significativo que estos ejemplos no se puedan explicar como excepciones o eventos aislados relacionados con agentes de soporte sin experiencia. Estas respuestas representan los procedimientos estándar que sigue Uber cuando los trabajadores desean ejercer sus derechos de acceso a los datos.

Respuestas circulares e inútiles

M. Ahmed es un ex conductor de Uber y mensajero de Uber Eats. En octubre de 2020, se suspendieron sus cuentas de conductor y mensajería de Uber, y en febrero de 2021, se desactivó su cuenta de conductor. Esto también afectó a su cuenta de mensajería UberEats, que posteriormente fue desactivada y eliminada.

Cuando el Sr. Ahmed preguntó por la causa de su despido, recibió respuestas contradictorias. Uber inicialmente citó verificaciones de reconocimiento facial fallidas y luego afirmó que la desactivación se debió a un gran volumen de pedidos no entregados. A lo largo de la correspondencia, se dirigieron a él por el nombre equivocado y finalmente aceptaron que los mensajes relacionados con las verificaciones de identificación en tiempo real fallidas se enviaron por error. La confusión en torno a su despido lo llevó a buscar sus datos personales.

En los últimos meses, Ahmed ha estado tratando de recuperar los datos asociados con su cuenta de Uber Eats desactivada. Ahmed intentó por primera vez obtener sus datos el 15 de abril de 2021, a través del formulario 'Enviar una consulta de privacidad sin una cuenta de Uber' en el sitio web de Uber, ya que su cuenta había sido eliminada después de su despido.

En respuesta, recibió un correo electrónico de Uber que decía: “Nuestro Aviso de privacidad limita nuestra capacidad para compartir la información del titular de la cuenta. Solo podemos proporcionar esta información a través del proceso descrito en nuestras pautas de solicitud de datos ". Este proceso se refiere a iniciar sesión en la cuenta y realizar la solicitud desde dentro de la cuenta. "Dicho esto, podemos trabajar con usted a través de los canales adecuados para ayudar según sea necesario".

Ahmed respondió pidiendo consejo sobre cómo podría acceder a los datos asociados con su cuenta ahora eliminada. Explicó que estaba escribiendo desde el correo electrónico asociado con su cuenta de Uber Eats y que también había proporcionado el número de teléfono móvil asociado con esta cuenta. Añadió que estaba feliz de proporcionar más información para confirmar su identidad.

A esto, el Sr. Ahmed recibió una respuesta indicando que su “preocupación no está relacionada con esta cuenta. Por favor escríbanos desde la cuenta en cuestión o inicie sesión a través de help.uber.com con las credenciales relevantes e infórmenos sobre el problema para que podamos ayudarlo más ".

Ahmed respondió, adjuntando una imagen del correo electrónico de incorporación que le envió Uber el 3 de julio de 2020, para demostrar que estaba escribiendo desde la cuenta correspondiente. El 19 de abril de 2021 recibió el mismo mensaje en el que indica que su “preocupación no está relacionada con esta cuenta”.

Ahmed respondió explicando una vez más que no puede acceder a su cuenta y que había proporcionado los detalles asociados con su cuenta de Uber Eats. Pidió recibir orientación sobre qué otra información podría proporcionar para identificarse. No recibió respuesta.

En este punto, el Sr. Ahmed buscó la ayuda de App Drivers and Couriers Union y Worker Info Exchange y escalamos el problema con Uber. El 11 de mayo de 2021, el Sr. Ahmed recibió un correo electrónico de Uber pidiéndole que confirmara la solicitud que hicimos en su nombre. Respondió confirmando que nos había dado su mandato y que le gustaría que se procesara su solicitud.

El 14 de mayo de 2021, Uber envió a Ahmed un formulario de verificación de identidad para procesar la solicitud. El formulario pedía los mismos detalles que ya había compartido en sus mensajes anteriores, como correo electrónico, número de teléfono, país de residencia, el tipo de datos solicitados. También solicitó su "calificación actual", que era inaplicable, ya que ya no tenía acceso a su cuenta. Ahmed envió el formulario a Uber, pero no recibió ninguna respuesta.

El 20 de mayo de 2021, Ahmed escribió a Uber para obtener confirmación de que estaban procesando su solicitud. No recibió respuesta.

En el momento de redactar este informe, el Sr. Ahmed no ha recibido sus datos. Tampoco se le ha dado ninguna explicación de por qué no se está tramitando su solicitud.

Intercambio de datos incremental e inconsistente

Amini es un ex conductor de Uber que fue desactivado en noviembre de 2020 luego de una verificación de geolocalización fallida . Uber informó su despido a TfL, quien luego revocó la licencia de contratación privada de Amini, dejándolo sin trabajo. En un intento por comprender la causa de su despido, Amini trató de obtener sus datos de Uber.

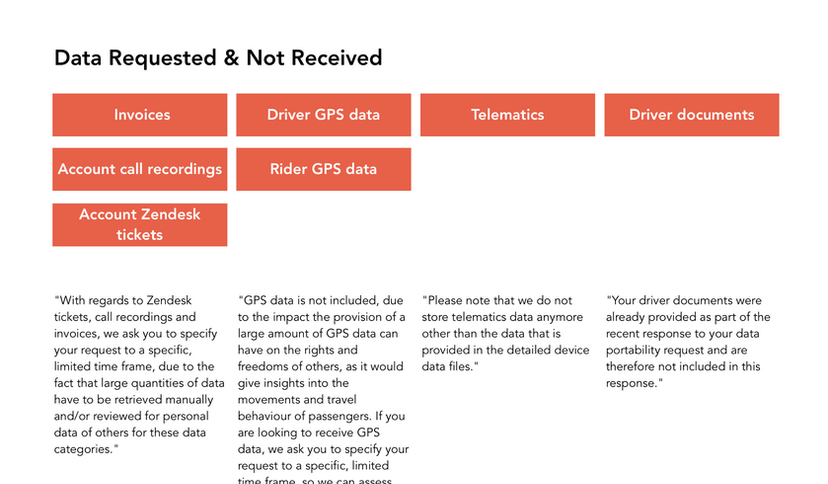

Amini hizo su primera solicitud el 13 de abril de 2021 y solicitó todos sus datos personales, incluidas las 26 categorías de datos descritas en el documento de orientación elaborado por Uber, así como las imágenes enviadas por él en respuesta a las verificaciones de identificación en tiempo real. Especificó que quería datos que cubrieran todo el período que ha estado activo como conductor de Uber.

El Sr. Amini recibió una respuesta a su solicitud el 5 de mayo de 2021, sin embargo, los datos proporcionados solo cubrieron los 30 días anteriores a su solicitud. Dado que Amini no pudo trabajar para Uber durante este período, muchos de los conjuntos de datos proporcionados estaban en blanco.

Luego, Amini hizo otra solicitud el 6 de mayo de 2021, declarando una vez más que estaba solicitando datos sobre todo el período de tiempo que ha trabajado con Uber, y agregó específicamente que deseaba datos recopilados hasta noviembre de 2020.

El Sr. Amini recibió una respuesta el 28 de mayo de 2021. Sin embargo, una vez más se le enviaron datos incompletos. Específicamente, el csv de datos detallados del dispositivo del controlador proporcionado por Uber estaba completamente en blanco.

El Sr. Amini hizo otra solicitud el 2 de junio de 2021 solicitando los datos faltantes. Recibió los datos detallados del dispositivo del controlador para noviembre de 2020 el 10 de junio de 2021. Sin embargo, a pesar de especificar que quería todos los campos de datos enumerados en las notas de orientación producidas por Uber, se le envió un conjunto de datos restringido que omitía 32 de los 50 datos. los campos.

Ofuscación y resistencia

Majid es un exconductor de Uber que fue desactivado en septiembre de 2020 luego de una verificación de geolocalización fallida. Al igual que en el caso de Amini, Uber informó del despido de Majid a TfL, lo que provocó la revocación de su licencia de alquiler privado. En un esfuerzo por comprender la base de las acusaciones de Uber, intentó obtener sus datos.

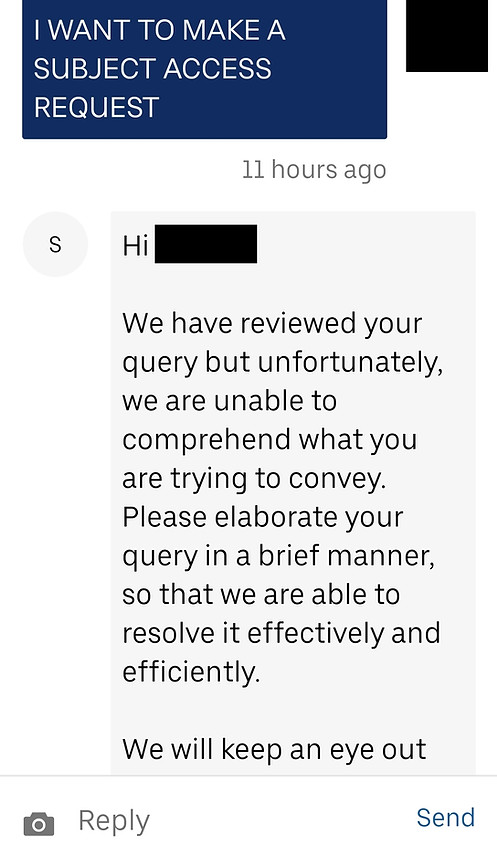

Majid se puso en contacto por primera vez con Uber para solicitar sus datos el 2 de junio de 2021. En respuesta, recibió un mensaje en el que se le pedía que explicara su preocupación de manera breve. Majid respondió con su solicitud de 3 categorías de datos (de las 26 categorías enumeradas en las notas de orientación de Uber) para septiembre de 2020.

El 8 de junio de 2021, el Sr. Majid recibió un mensaje de Uber que decía: “Nuestra Política de privacidad no nos permite realizar cambios o discutir información personal sin contacto a través de la dirección de correo electrónico asociada con su cuenta de socio. Para ayudarlo con su problema específico, deberá escribir utilizando la dirección de correo electrónico asociada con esa cuenta. Gracias por entender."

En esta etapa, el señor Majid se puso en contacto con nosotros, confundido, ya que le había escrito a Uber desde su cuenta. Él respondió, explicando a Uber que se comunicó con ellos iniciando sesión en su cuenta de conductor, por lo que definitivamente estaba escribiendo desde la dirección de correo electrónico correcta. Preguntó si podía proporcionar alguna identificación / documentación adicional para asegurarle a Uber que era él quien hacía la solicitud.

En respuesta, recibió el mismo mensaje de Uber: “Hola ... gracias por tu mensaje. Entendemos que le gustaría hablar sobre información relacionada con una cuenta de Uber. Si usted es el titular de la cuenta, escriba desde la dirección de correo electrónico asociada con su cuenta Partner-Driver y podremos ayudarlo de inmediato ".

El 9 de junio de 2021, Majid inició sesión en su cuenta de socio e inició un chat con el soporte de Uber para volver a intentarlo. Se ignoró su mensaje preguntándole si podía realizar una solicitud de acceso al sujeto.

El 14 de junio de 2021, Majid se puso en contacto con Uber una vez más y le dijo que tenía una consulta sobre su cuenta de socio conductor. Recibió una respuesta de Uber: “Gracias por comunicarse ... Hemos aprovechado la oportunidad para revisar su inquietud y podemos ver que ya se comunicó con nosotros sobre este tema. Uno de los miembros de nuestro equipo está investigando su problema y nos comunicaremos con usted lo antes posible. Para agilizar nuestra comunicación y evitar confusiones, vamos a cerrar este contacto ".

El 16 de junio de 2021, Majid se puso en contacto con Uber una vez más, indicando que se le había pedido que iniciara sesión en su cuenta para realizar una solicitud y, una vez hecho, quería compartir los detalles de su solicitud. Recibió una respuesta al día siguiente y, posteriormente, envió detalles de la solicitud (de los tres conjuntos de datos enumerados anteriormente) el 18 de junio de 2021.

Al no recibir respuesta, Majid se puso en contacto con Uber nuevamente el 28 de junio de 2021, en busca de confirmación de que su solicitud estaba siendo procesada. El 1 de julio de 2021, recibió una respuesta en la que se indicaba que su preocupación había sido planteada al equipo especializado y que se pondrían en contacto para investigar más a fondo.

El 2 de julio de 2021, el Sr. Majid recibió una respuesta al hilo de mensajes que había iniciado el 9 de junio de 2021. Este mensaje indicaba que Uber requiere que las solicitudes se envíen personalmente a la dirección postal de Uber BV en los Países Bajos.

Majid no ha recibido más comunicaciones.

“La cuestión de los algoritmos es central en el tema de la uberización. Con demasiada frecuencia, es el algoritmo el que juega el papel real del jefe, ya que la tecnología proporciona nuevos medios para la subordinación de los trabajadores. Obviamente, existe la necesidad de transparencia en la gestión algorítmica, pero más allá de esta transparencia, existe la necesidad de una gestión conjunta del algoritmo. Los representantes de los trabajadores deben poder participar en su desarrollo”.

Leila Chaibi, eurodiputada

Estudios de caso: Respuestas de la plataforma a

Solicitudes por lotes por intercambio de información del trabajador

Como se demuestra en los ejemplos anteriores, los procesos de solicitud individuales pueden consumir mucho tiempo y capacidad. Por lo tanto, hemos creado procesos que nos permiten realizar solicitudes por lotes en nombre de los conductores y agilizar este complejo procedimiento. Hemos establecido un sistema que utiliza la solución de identificación y firma electrónica desarrollada por Scrive para recibir un mandato legal de los trabajadores para realizar solicitudes en su nombre. Esta solución también incluye una verificación de identidad realizada por Onfido (el mismo servicio de verificación de identidad utilizado por Uber), para garantizar que tanto nosotros como el controlador de datos podamos estar seguros de la identidad del solicitante y preservar la privacidad de sus datos. La verificación de identificación requiere que los trabajadores presenten uno de los siguientes documentos de identificación: pasaporte, licencia de conducir, tarjeta de identidad o permiso de residencia. A través de este proceso, se crea un documento de consentimiento individual para cada individuo que está sellado electrónicamente y es verificable a través de adjuntos ocultos que contienen un registro de evidencia para probar la autenticidad del proceso de identificación. (Scrive también proporciona un servicio para verificar la integridad de los formularios de consentimiento, que está vinculado en los documentos). Enviamos estos documentos, junto con una hoja de cálculo que contiene los nombres, correos electrónicos, direcciones y números de teléfono de los trabajadores que realizan las solicitudes.