Conteúdo

Conteúdo

Resumo

Parte I: Classificação errada 2.0: Controlado por Algoritmo

Estudo de caso de vigilância I: falha de reconhecimento facial

Estudo de caso de vigilância II: verificações de geolocalização

Opaco Performance Management

Estudo de Caso: Controle Algorítmico

Expansão da infraestrutura de aplicação da lei

Estudo de caso: compartilhamento de inteligência com agentes da lei

Parte II: Exercício dos direitos de dados no trabalho: acesso

Estudos de caso: DSARs individuais

Compartilhamento de dados inconsistentes e incrementais

Estudos de caso: respostas da plataforma para solicitações em lote por WIE

Parte III: Exercício dos direitos de dados no trabalho: litígio

Drivers Uber v Uber I (solicitações gerais de transparência)

Drivers Ola v. Ola (solicitações gerais de transparência)

Drivers Uber v. Uber II (transparência na tomada de decisão automatizada)

Casos de apelação de licenciamento de Londres

Conclusão: o caminho a seguir para o exercício dos direitos digitais no trabalho?

Resumo

Worker Info Exchange foi criado para facilitar o acesso e coletivização de dados para construir poder de barganha por meio do estabelecimento de um trust de dados.

Isso foi em resposta ao desenvolvimento de novas práticas de gerenciamento algorítmico, criando profundas assimetrias informacionais e exploração do trabalhador.

O Worker Info Exchange visa abordar a convergência de dados e direitos trabalhistas invocando os direitos do Artigo 15, 20 e 22 do RGPD em contextos de emprego.

Essa meta é severamente prejudicada pela não conformidade generalizada com o GDPR em toda a indústria de shows.

Fizemos mais de 500 solicitações de acesso de titulares de dados nos últimos oito meses para sete plataformas de compartilhamento de transporte diferentes, incluindo Amazon Flex, Bolt, Deliveroo, Free Now, Just Eat, Ola e Uber.

O acesso aos dados é desafiado por empresas que implantam padrões obscuros e deliberadamente abusam da implementação irregular do GDPR, o que leva os trabalhadores a resolverem os problemas no tribunal.

A coleta de dados por plataformas de giga é excessiva e leva à vigilância desproporcional e inexplicável dos trabalhadores, bem como a uma infraestrutura de aplicação da lei em expansão.

Não há transparência sobre os sistemas de gerenciamento algorítmicos usados. As narrativas da empresa sobre quais tecnologias são usadas e como são inconsistentes e não confiáveis.

© 2021 Troca de informações do trabalhador

© 2021 Troca de informações do trabalhador

Introdução

O ano passado marcou uma virada para os trabalhadores de plataformas de shows na realização de seus empregos e direitos digitais. A prática do trabalho mediado digitalmente levou a uma convergência dos direitos de proteção de dados e emprego, e a crescente atividade de litígio e advocacia por parte dos trabalhadores tem rendido resultados nesses domínios. Em toda a Europa, os tribunais aprovaram vários julgamentos significativos reconhecendo o papel explorador das práticas de gerenciamento algorítmico por plataformas de gig e, ao mesmo tempo, condenando a falta de justiça e transparência em tais sistemas automatizados.

Na Itália, o tribunal de Bolonha decidiu que o sistema de classificação da Deliveroo havia discriminado os trabalhadores, enquanto a autoridade de proteção de dados, Garante, aplicou duas multas GDPR a Deliveroo e Glovo devido à falha em divulgar adequadamente o funcionamento de seus algoritmos de alocação de trabalho e gerenciamento de desempenho.

A Espanha aprovou a primeira legislação para tentar regulamentar a IA na área de emprego, estabelecendo tanto a condição de trabalhador para os trabalhadores de gig quanto o direito de ser informado sobre as regras e parâmetros dos algoritmos a que estão sujeitos - desencadeando uma torrente de reclamações. Isso resultou de mais um processo judicial contra Glovo, que acabou na Suprema Corte espanhola.

Junto com essas decisões de alto perfil, a Suprema Corte do Reino Unido também concluiu este ano que os motoristas do Uber faziam parte de um serviço de transporte " estritamente definido e controlado pelo Uber ", traindo uma relação de trabalho clara, que a empresa alegou não existir em seu esforço para (des) classificar os trabalhadores como contratantes independentes. Significativamente, a evidência dessa relação vem dos sistemas baseados em dados que as plataformas de compartilhamento de viagens usam para gerenciar suas forças de trabalho. Algumas das questões destacadas pela Suprema Corte do Reino Unido estavam relacionadas à gestão de motoristas por meio do monitoramento algorítmico das taxas de aceitação de empregos, escolhas de rotas, comportamento ao dirigir e classificações de clientes. No entanto, embora haja um maior reconhecimento da gestão algorítmica, os ganhos recentes nos tribunais não protegem totalmente os trabalhadores contra seus danos. O status de trabalhador limb (b) concedido aos motoristas do Uber como resultado da decisão da Suprema Corte é um status intermediário entre o contratante e o empregado , e ainda não consegue protegê-los de demissões injustas, por exemplo.

Nossa experiência sugere que essas ferramentas de gerenciamento algorítmico, com a adição de práticas de vigilância intensivas, examinando continuamente os trabalhadores em busca de fraudes ou irregularidades em potencial, estão resultando em um ambiente de trabalho profundamente explorador. Estamos vendo um número excessivo de demissões automatizadas em toda a indústria de shows, muitas das quais acreditamos ser ilegais de acordo com o Artigo 22 do Regulamento Geral de Proteção de Dados (GDPR) . O Artigo 22 fornece aos trabalhadores algumas proteções limitadas contra os efeitos adversos da tomada de decisão automatizada e definição de perfis, por meio do direito de obter intervenção humana e contestar a decisão. O artigo 15 do RGPD garante o direito de ser informado sobre a existência de tal tomada de decisão automatizada e de receber informações significativas sobre a lógica de processamento.

Tendo esses direitos como base, o Worker Info Exchange foi criado com a missão de apoiar os trabalhadores de gig na navegação neste complexo e sob o espaço regulamentado. O objetivo e a missão de nosso trabalho é testar se esses instrumentos do GDPR podem ser utilizados para lidar com práticas de emprego injustas e expandir o escopo dos dados disponibilizados a indivíduos na qualidade de trabalhadores. Em outras palavras, nossa ambição é usar o acesso aos dados como um método de construção do poder coletivo do trabalhador para testar os mecanismos de reparação em um mercado de trabalho mediado digitalmente.

Quando a relação de emprego entre a plataforma de trabalho e o trabalhador é executada por meio de extensa coleta e análise de dados, os direitos trabalhistas tornam-se inextricavelmente ligados ao exercício dos direitos de dados. As plataformas de giga asseguram o controle sobre os trabalhadores, mantendo uma assimetria informacional, e o acesso aos dados pode fornecer um meio de expor o (i) equilíbrio de poder gerado pela lacuna de informações entre as plataformas de giga e seus funcionários. O acesso aos dados pessoais pode permitir que os trabalhadores façam avaliações independentes sobre suas condições de trabalho e respondam a perguntas sobre seus cálculos de pagamento, a qualidade e a quantidade do trabalho oferecido, bem como desafiar os motivos para uma gestão de desempenho adversa, incluindo suspensão e demissão.

Nosso objetivo ao facilitar o acesso aos dados é criar armazenamentos coletivos de dados para desenvolver uma maior compreensão das condições de trabalho e, consequentemente, do poder de barganha. Nos últimos anos, várias iniciativas dignas de nota surgiram operando com objetivos semelhantes, mas usando metodologias diferentes para a recuperação de dados. Alguns projetos neste campo executam sua própria coleta de dados e análises sobre ganhos e desempenho para avaliar a justiça das condições de trabalho (por exemplo, Driver's Seat Coop e WeClock, entre outros.) Todos estes apresentam percepções exclusivas sobre a economia de gig e devem ser considerados como constituindo um continuum de prática de dados. Abordamos esse problema exigindo que as plataformas compartilhem os dados aos quais os trabalhadores têm direito legal, no entanto, isso introduziu obstáculos adicionais ao objetivo maior de coletivizar os dados. Seguimos este caminho porque pretendíamos estabelecer padrões e precedentes na legislação de proteção de dados, mas também porque acreditamos que existem certos tipos de informação que só podem ser obtidos solicitando os dados diretamente nas plataformas.

Verificamos, em particular no caso da vigilância alimentada por alegações de atividade irregular e fraude, que é necessário ter os dados em poder das empresas para compreender e contestar as denúncias. O acesso aos dados pode nos ajudar a descobrir as inconsistências nas narrativas apresentadas pelas empresas de plataforma e ajudar a transferir o ônus da prova dos trabalhadores de volta para as plataformas. Dessa perspectiva, o esforço de exigir dados de plataforma tem se mostrado extremamente bem-sucedido na resolução de inúmeras disputas trabalhistas. A simples demonstração da recusa das plataformas em fornecer dados pessoais reverteu várias revogações de licenças (aplicadas pela TfL) em tribunal e, assim, tornou-se uma ferramenta adicional no exercício dos direitos laborais.

Este constitui o outro ramo de atividade do Worker Info Exchange; como estamos frustrados em nossas tentativas de obter clareza e transparência sobre os sistemas complexos que determinam as condições do local de trabalho, frequentemente precisamos recorrer a litígios e recorrer aos tribunais para decisões no campo emergente dos direitos trabalhistas digitais. A artificial 'crise de dados' que as plataformas de show criaram é, de muitas maneiras, uma tentativa de exaurir e esgotar os recursos de trabalhadores precários e sindicatos, levando as disputas aos tribunais, onde podem ser prolongadas e a responsabilidade por má conduta corporativa, adiada.

Em linha com essas vertentes de atividade, este relatório é escrito em três partes: A primeira seção explora diferentes facetas do gerenciamento algorítmico e seus danos, com estudos de caso associados. A segunda seção trata de nosso processo de utilização de Solicitações de Acesso de Titulares de Dados (DSARs), enquanto a terceira oferece uma visão geral dos casos relacionados ao GDPR que levamos adiante em Amsterdã, bem como os casos de licenciamento que apoiamos em Londres. Este relatório conclui um período de trabalho que aborda essas funções de nossa organização, realizado com o apoio da Mozilla Foundation, Digital Freedom Fund e Open Society Foundations. Esperamos que este relatório demonstre a situação atual no exercício dos direitos na interseção de dados e mão de obra e revele os efeitos cumulativos do não cumprimento repetido por plataformas de show.

"As empresas de plataforma estão operando em um espaço sem lei, onde acreditam que podem fazer as regras. Infelizmente, isso não é um jogo; as realidades virtuais têm consequências duras para os trabalhadores temporários na vida real. O que é encorajador é que os próprios trabalhadores não estão esperando por leis, legisladores ou mesmo aliados do movimento de direitos humanos para resgatá-los. Os trabalhadores temporários estão se organizando e usando sua voz coletiva para exigir novas proteções que sejam adequadas ao propósito de uma economia digitalizada."

Bama Athreya, Fellow, Open Society Foundations

Parte I: Classificação errada 2.0 Controlado por Algoritmo

Na batalha de seis anos pelos direitos dos trabalhadores na economia do Reino Unido, o Uber argumentou que era apenas o agente do motorista autônomo que não fazia nada mais do que registrar passivamente as ordens de serviço e receber o pagamento. Para avançar nessa ficção, as plataformas de show estabelecem contratos elaborados que fazem parecer que o motorista e o passageiro estão negociando diretamente um com o outro, quando na verdade todas as informações dos passageiros são protegidas de perto pelas empresas. O Uber, por exemplo, gera uma fatura fictícia em nome do motorista para cada passageiro que transporta. A fatura mencionará apenas o primeiro nome do passageiro e nunca será enviada ao cliente.

Essas técnicas de classificação incorreta, comumente usadas na economia de gig, permitem que as plataformas evitem as responsabilidades legais do empregador, como proteções básicas dos direitos do trabalhador e contribuições para o seguro nacional. No Reino Unido, também permitiu que as empresas de plataforma evitassem o imposto sobre vendas de valor agregado (IVA). Mas no início deste ano, o Supremo Tribunal Federal afirmou o direito dos tribunais inferiores de descartar contratos artificiais e determinar a verdadeira natureza da relação de trabalho com base na evidência de uma relação de controle de gestão sobre os trabalhadores.

À medida que as empresas de plataforma concluem que o uso de contratos enganosos não é mais viável como método de classificação incorreta de empregos, elas serão tentadas a dobrar a automação de processos para ocultar o controle de gestão. O controle algorítmico torna-se uma classificação incorreta 2.0. Na verdade, há ampla evidência de que isso já está acontecendo. As plataformas Gig estão mais determinadas do que nunca a buscar estratégias de classificação incorreta para que possam continuar a controlar a força de trabalho, evitando o risco de que os motoristas passem do status de 'trabalhador' com direitos limitados ao status de funcionário com substancialmente mais direitos.

Então, o que é controle algorítmico e quais são os riscos específicos para os trabalhadores do show? Nos setores de compartilhamento de carona e entrega, especificamente, os meios de gerenciamento algorítmico de maior preocupação para nós incluem o seguinte:

Vigilância. Vigilância intrusiva para o propósito declarado de segurança e identificação. Isso inclui o uso de tecnologias de detecção de fraude e reconhecimento facial. Estamos cientes de que a vigilância é realizada mesmo quando o trabalhador não está logado para se colocar à disposição para trabalhar. Também incluiu o monitoramento do uso do aplicativo pelo trabalhador como consumidor.

Gestão de desempenho. Isso inclui, mas não se limita ao monitoramento do comportamento ao dirigir, incluindo ETA, avaliações do cliente, taxas de aceitação e conclusão do trabalho, interação com a equipe de suporte, disponibilidade.

Alocação de trabalho. O Uber tem insistido até recentemente que a alocação de trabalho é decidida na proximidade de motoristas e passageiros entre si, entretanto agora admite que o comportamento e as preferências anteriores são levados em consideração. Ola admite que os perfis do motorista incluem 'perfil de ganho' e pontuação de 'probabilidade de fraude' são usados na tomada de decisão automatizada de alocação de trabalho.

Preços. Intimamente relacionado à alocação de trabalho está a tomada de decisão automatizada de preços. Talvez o método mais conhecido seja o chamado 'aumento' ou 'preço dinâmico' do Uber, que pretende limpar a demanda do mercado com flutuações de preços locais em tempo real.

As decisões de gerenciamento acima são em sua maioria automatizadas ou semiautomáticas com intervenção humana limitada. Os modelos de negócios da economia gigante dependem da automação em massa das decisões de gerenciamento e da supervisão do local de trabalho. Embora alguns empregadores sejam reticentes neste ponto, a Deliveroo foi bastante franca sobre isso em sua política de privacidade do passageiro:

“Dado o volume de entregas com que lidamos, usamos sistemas automatizados para tomar as decisões automatizadas descritas acima, pois fornecem uma maneira mais precisa, justa e eficiente de identificar suspeitas de fraude, evitando violações repetidas de seu Contrato de Fornecedor e limitando o impacto negativo sobre nosso serviço. Os controles humanos simplesmente não seriam possíveis nos prazos e dados os volumes de entregas com que lidamos. ”

Gestão de Desempenho

Isso inclui, mas não se limita ao monitoramento do comportamento de direção, incluindo ETA, classificações de clientes, taxas de aceitação e conclusão de trabalhos, interação com a equipe de suporte, disponibilidade.

Preços

Intimamente relacionado à alocação de trabalho está a tomada de decisão automatizada de preços. Talvez o método mais conhecido seja o chamado 'surge' ou 'preço dinâmico' da Uber, que pretende limpar a demanda do mercado com flutuações de preços locais em tempo real.

Vigilância

Vigilância intrusiva com o propósito declarado de segurança e identificação. Isso abrange o uso de tecnologias de detecção de fraude e reconhecimento facial. Estamos cientes de que a vigilância é realizada mesmo quando o trabalhador não está logado para se colocar à disposição para o trabalho. Também incluiu a vigilância do uso do aplicativo pelo trabalhador como consumidor.

Alocação de trabalho

Até muito recentemente, a Uber insistiu que a alocação de trabalho é decidida na proximidade de motoristas e passageiros, mas agora admite que o comportamento e as preferências anteriores são levados em consideração. são usados na tomada de decisão automatizada de alocação de trabalho.

Parte I: Classificação errada 2.0 Controlado por Algoritmo

Na batalha de seis anos pelos direitos dos trabalhadores na economia do Reino Unido, o Uber argumentou que era apenas o agente do motorista autônomo que não fazia nada mais do que registrar passivamente as ordens de serviço e receber o pagamento. Para avançar nessa ficção, as plataformas de show estabelecem contratos elaborados que fazem parecer que o motorista e o passageiro estão negociando diretamente um com o outro, quando na verdade todas as informações dos passageiros são protegidas de perto pelas empresas. O Uber, por exemplo, gera uma fatura fictícia em nome do motorista para cada passageiro que transporta. A fatura mencionará apenas o primeiro nome do passageiro e nunca será enviada ao cliente.

Essas técnicas de classificação incorreta, comumente usadas na economia de gig, permitem que as plataformas evitem as responsabilidades legais do empregador, como proteções básicas dos direitos do trabalhador e contribuições para o seguro nacional. No Reino Unido, também permitiu que as empresas de plataforma evitassem o imposto sobre vendas de valor agregado (IVA). Mas no início deste ano, o Supremo Tribunal Federal afirmou o direito dos tribunais inferiores de descartar contratos artificiais e determinar a verdadeira natureza da relação de trabalho com base na evidência de uma relação de controle de gestão sobre os trabalhadores.

À medida que as empresas de plataforma concluem que o uso de contratos enganosos não é mais viável como método de classificação incorreta de empregos, elas serão tentadas a dobrar a automação de processos para ocultar o controle de gestão. O controle algorítmico torna-se uma classificação incorreta 2.0. Na verdade, há ampla evidência de que isso já está acontecendo. As plataformas Gig estão mais determinadas do que nunca a buscar estratégias de classificação incorreta para que possam continuar a controlar a força de trabalho, evitando o risco de que os motoristas passem do status de 'trabalhador' com direitos limitados ao status de funcionário com substancialmente mais direitos.

Então, o que é controle algorítmico e quais são os riscos específicos para os trabalhadores do show? Nos setores de compartilhamento de carona e entrega, especificamente, os meios de gerenciamento algorítmico de maior preocupação para nós incluem o seguinte:

Vigilância. Vigilância intrusiva para o propósito declarado de segurança e identificação. Isso inclui o uso de tecnologias de detecção de fraude e reconhecimento facial. Estamos cientes de que a vigilância é realizada mesmo quando o trabalhador não está logado para se colocar à disposição para trabalhar. Também incluiu o monitoramento do uso do aplicativo pelo trabalhador como consumidor.

Gestão de desempenho. Isso inclui, mas não se limita ao monitoramento do comportamento ao dirigir, incluindo ETA, avaliações do cliente, taxas de aceitação e conclusão do trabalho, interação com a equipe de suporte, disponibilidade.

Alocação de trabalho. O Uber tem insistido até recentemente que a alocação de trabalho é decidida na proximidade de motoristas e passageiros entre si, entretanto agora admite que o comportamento e as preferências anteriores são levados em consideração. Ola admite que os perfis do motorista incluem 'perfil de ganho' e pontuação de 'probabilidade de fraude' são usados na tomada de decisão automatizada de alocação de trabalho.

Preços. Intimamente relacionado à alocação de trabalho está a tomada de decisão automatizada de preços. Talvez o método mais conhecido seja o chamado 'aumento' ou 'preço dinâmico' do Uber, que pretende limpar a demanda do mercado com flutuações de preços locais em tempo real.

As decisões de gerenciamento acima são em sua maioria automatizadas ou semiautomáticas com intervenção humana limitada. Os modelos de negócios da economia gigante dependem da automação em massa das decisões de gerenciamento e da supervisão do local de trabalho. Embora alguns empregadores sejam reticentes neste ponto, a Deliveroo foi bastante franca sobre isso em sua política de privacidade do passageiro:

“Dado o volume de entregas com que lidamos, usamos sistemas automatizados para tomar as decisões automatizadas descritas acima, pois fornecem uma maneira mais precisa, justa e eficiente de identificar suspeitas de fraude, evitando violações repetidas de seu Contrato de Fornecedor e limitando o impacto negativo sobre nosso serviço. Os controles humanos simplesmente não seriam possíveis nos prazos e dados os volumes de entregas com que lidamos. ”

“Dado o volume de entregas com as quais lidamos, usamos sistemas automatizados para tomar as decisões automatizadas descritas acima, pois fornecem uma maneira mais precisa, justa e eficiente de identificar suspeitas de fraude, evitando violações repetidas do seu Contrato de Fornecedor e limitando o impacto negativo sobre nosso serviço. As verificações humanas simplesmente não seriam possíveis nos prazos e nos volumes de entregas com os quais lidamos.”

Vigilância

Vigilância intrusiva com o propósito declarado de segurança e identificação. Isso abrange o uso de tecnologias de detecção de fraude e reconhecimento facial. Estamos cientes de que a vigilância é realizada mesmo quando o trabalhador não está logado para se colocar à disposição para o trabalho. Também inclui a vigilância do uso do aplicativo pelo trabalhador como consumidor.

Alocação de trabalho

Até muito recentemente, Uber insistiu que a alocação de trabalho é decidida na proximidade de motoristas e passageiros, mas agora afirma que o comportamento e as preferências anteriores são levados em consideração. alocação.

Gestão de Desempenho

A avaliação do desempenho no trabalho inclui, mas não se limita ao monitoramento do comportamento de direção, incluindo ETA, classificações do cliente, taxas de aceitação e conclusão do trabalho, interação com a equipe de suporte, disponibilidade.

Preços

Intimamente relacionado à alocação de trabalho está a definição automatizada de preços. Talvez o método mais conhecido seja o chamado 'aumento' ou 'preço dinâmico' do Uber, que pretende limpar a demanda do mercado com flutuações de preços locais em tempo real.

Corrida de armas de vigilância

Temos visto uma corrida armamentista de vigilância na economia de gig desde que o Uber introduziu seu chamado Sistema de Identificação em Tempo Real Híbrido em 2020. Apenas um dia antes do Transport for London (TfL) anunciar sua decisão de recusar a renovação de sua licença em novembro de 2019, O Uber se ofereceu para apresentar este sistema de vigilância que incorpora reconhecimento facial com monitoramento por GPS.

Isso foi em resposta à reclamação do TfL de que 21 motoristas foram detectados (de 90.000 analisados ao longo de vários anos) como envolvidos no compartilhamento de contas, o que permitiu que motoristas potencialmente sem licença e sem seguro oferecessem ilegalmente seus serviços no aplicativo. A atividade foi possível redefinindo a localização GPS do dispositivo como fora do Reino Unido, onde os motoristas podem enviar suas próprias fotos. Essa lacuna foi rapidamente fechada pelo Uber e a atividade detectada foi incrivelmente pequena em comparação com a escala de operação do Uber. A introdução da tecnologia de reconhecimento facial pela indústria foi totalmente desproporcional em relação ao risco percebido. No entanto, a exigência de identificação em tempo real passou a ser uma condição para a renovação da licença do Uber no Tribunal de Magistrados de Westminster em setembro de 2020.

No caso do Uber, tanto a gestão da plataforma quanto o TfL não conseguiram garantir que as salvaguardas adequadas fossem implementadas para proteger os direitos e liberdades dos motoristas, apesar de o TfL ter revisado a avaliação do impacto da proteção de dados para a tecnologia em março de 2020. Fizemos um solicitação de liberdade de informação ao TfL para ter acesso ao DPIA da Uber para os sistemas de identificação em tempo real, mas foi-nos negada. De acordo com relatórios da TfL , 94% dos motoristas de veículos de aluguel privado (PHV) são de origens negras e de minorias étnicas e a introdução desta tecnologia, que é bem reconhecida por suas baixas taxas de precisão dentro desses grupos , provou ser desastrosa para trabalhadores vulneráveis já em emprego precário.

A Bolt anunciou que estava investindo 150 milhões de euros em sistemas de detecção antifraude para drivers de IA, incluindo reconhecimento facial. A Deliveroo anunciou que eles também introduziriam verificações de identidade de reconhecimento facial. A Ola Cabs também lançou a identificação de reconhecimento facial como um recurso de seu sistema Guardian , incorporando o aprendizado de máquina que, segundo eles, permite "aprender e evoluir continuamente a partir de milhões de pontos de dados todos os dias, para melhorar a sinalização de risco e a resolução instantânea".

A FreeNow, uma joint venture da Daimler e da BMW, também acompanha de perto os motoristas como parte de seu programa de prevenção de fraude. Na verdade, os documentos apresentados pela FreeNow com o Tribunal Superior em uma Revisão Judicial da decisão da TfL de conceder-lhes uma licença em Londres, revelaram que a TfL fez relatórios mensais de demissões de motoristas por várias razões (incluindo 'atividade fraudulenta') uma condição de sua renovação recente da licença. Mas a descrição dos dados processados com o propósito de prevenção de fraude levanta mais questões do que as respondidas pela política de privacidade do FreeNow.

Neste documento, o Free Now afirma que eles usam um algoritmo de 'floresta aleatória' para produzir uma pontuação de fraude que eles usam para “ priorizar as viagens despachadas de acordo. Isso garante um despacho justo e com minimização de riscos . ” A Free Now contestou o uso desse sistema de detecção de fraude quando questionamos sobre isso em junho de 2021, alegando que esta seção da política de privacidade estava desatualizada (consulte o estudo de caso da empresa na seção II do relatório.) No entanto, a descrição deste sistema permaneceu na política, apesar de uma atualização feita em setembro de 2021.

O que é particularmente preocupante sobre o uso desses sistemas é que eles combinam gerenciamento de fraude com gerenciamento de desempenho. O fato de tais indicadores de 'fraude' serem utilizados como variáveis de alocação de trabalho e os comportamentos que os geram continuarem na plataforma demonstra que não se trata de fraudes criminais, mas de mecanismos de controle que avaliam o desempenho dos trabalhadores contra as métricas opacas definidas pelas empresas. Sugerimos que qualquer terminologia de 'fraude' usada nesses contextos também funcione como parte do jogo de classificação incorreta, projetado para ocultar a relação de trabalho.

Estudo de caso de vigilância I: falha de reconhecimento facial

Em abril de 2020, o Uber introduziu um sistema de verificação de ID em tempo real (RTID) no Reino Unido que usa uma combinação que inclui reconhecimento facial e verificação de localização para autenticar a identidade de um motorista e para tentar evitar que o motorista compartilhe o acesso à sua conta para o trabalho.

O sistema RTID incorpora o uso da API FACE da Microsoft, software de reconhecimento facial e exige que os motoristas e mensageiros tirem selfies em tempo real de si mesmos para continuar usando o aplicativo Uber. A foto é então verificada com a foto do perfil da conta do motorista (e em algumas jurisdições, com bancos de dados públicos para “ evitar o empréstimo de identidade ou para verificar a identidade dos usuários ”).

Pa Edrissa Manjang trabalhava com o Uber há cerca de um ano quando foi desativado devido a uma falha na verificação de selfies. Embora os motoristas e mensageiros do Uber forneçam selfies rotineiramente, elas não são armazenadas nos telefones dos funcionários e eles não podem reter as evidências de suas apresentações. Pa não recebeu nenhum aviso ou notificação de quaisquer problemas até sua demissão; o sistema de verificação de identidade em tempo real parecia aprovar todas as suas fotos com uma marca verde.

Após sua demissão, Pa enviou várias mensagens ao Uber para retificar o problema, especificamente pedindo a um humano para revisar seus envios. Cada vez que Pa foi informado de “não fomos capazes de confirmar se as fotos fornecidas eram realmente suas e, devido a incompatibilidades contínuas, tomamos a decisão final sobre encerrar nossa parceria com você”. Obtivemos as selfies em questão por meio de uma solicitação de acesso do sujeito, que revelou que todas as fotos que Pa enviou eram na verdade dele. Essa foi a primeira vez em que conseguimos obter as selfies enviadas por um mensageiro ou motorista. Não está claro por que esse pedido foi bem-sucedido quando muitos antes dele falharam.

Também escrevemos para a Microsoft no início do ano para levantar nossas preocupações com relação ao uso não regulamentado da API FACE pelo Uber em sua plataforma. Em resposta , a Microsoft enfatizou que todas as partes envolvidas na implantação de tais tecnologias têm responsabilidades que incluem: "incorporar revisão humana significativa para detectar e resolver casos de identificação incorreta ou outra falha" e "para fornecer suporte às pessoas que acreditam que seus resultados foram incorretos; e para identificar e resolver flutuações na precisão devido à variação nas condições." O caso de Pa demonstra claramente que essas verificações cruciais não foram implementadas no processamento de imagens RTID.

Pa está agora abrindo um processo contra o Uber para desafiar sua implantação de reconhecimento facial racialmente discriminatório, representado por Bates Wells, com o apoio da Comissão de Igualdade e Direitos Humanos, do Sindicato de Drivers e Correios de Aplicativos e do Worker Info Exchange.

EMBED: vídeo do Pa

Estudo de caso de vigilância II: verificações de geolocalização

Embora o uso de sistemas de reconhecimento facial com falhas seja sem dúvida problemático, também vimos muitos motoristas serem demitidos após falsas acusações do Uber de que estavam envolvidos em compartilhamento fraudulento de contas depois que dois dispositivos foram detectados pelo Uber em dois locais ao mesmo tempo. Em todos os casos que analisamos, descobrimos que o problema está relacionado ao driver ter instalado o aplicativo em dois dispositivos por conveniência, mas com apenas um dos dispositivos conectado para funcionar.

Pouco antes das 20h do dia 11 de setembro de 2020, Aweso Mowlana estava trabalhando para o Uber no sul de Londres. Ele era um motorista de 4,95 estrelas que realizou mais de 11.500 viagens em mais de 5 anos trabalhando para o Uber. Aweso tinha acabado de deixar um passageiro perto de Elephant and Castle quando fez logoff para uma pequena pausa. Como muitos drivers, Aweso instalou o aplicativo em um segundo dispositivo que era um iPhone. Nessa noite em particular, ele havia deixado o iPhone em casa e estava trabalhando com seu outro telefone, um Samsung.

Às 20h02, Aweso tentou se conectar novamente ao aplicativo Uber para se tornar disponível para seu próximo trabalho. Antes de poder fazer o login novamente, ele foi solicitado a fornecer uma selfie como parte da Verificação de identidade em tempo real (RTID) do Uber. Sua foto correspondia à foto de referência do Uber, então ele concluiu com êxito o procedimento de logon para continuar seu turno. Mas sem que ele soubesse, os sistemas Uber detectaram e / ou pingaram seu segundo telefone. Seu filho pegou o segundo telefone por engano e o levou para a casa de sua namorada em Uxbridge. O Uber disse mais tarde que solicitou uma verificação RTID deste dispositivo às 20h03, mas a essa altura o Aweso já estava online no sul de Londres. O Uber afirma que a resposta à verificação de identidade foi enviada do iPhone por volta das 23h55 daquela noite.

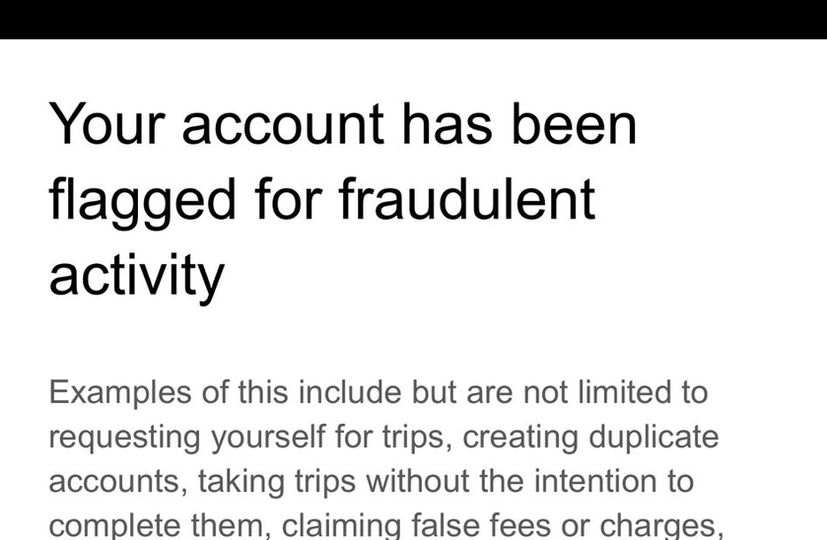

No dia seguinte, o Uber o informou que sua conta havia sido 'sinalizada por atividade de aplicativo suspeita' e que sua conta seria suspensa enquanto 'uma equipe especializada analisa isso'. Algum tempo depois, o Uber dispensou Aweso permanentemente por mensagem de texto dizendo que eles haviam 'encontrado evidências indicando atividade fraudulenta' em sua conta. O Uber então alegou que estava compartilhando o acesso à sua conta e, ao fazer isso, violou os termos e condições. No mês seguinte, o Transport for London revogou imediatamente a licença de Aweso com o fundamento de que ele não poderia mais ser considerado "apto e adequado" para possuir uma licença pública com base em sua demissão do Uber.

O Worker Info Exchange ajudou Aweso a fazer uma solicitação de acesso de assunto e a analisar os dados recebidos. Um arquivo chamado 'D river Detailed Device Data ' registra pelo menos parte do fluxo de dados de dispositivos para o Uber em tempo real. A própria política de privacidade do Uber indica que onde um dispositivo tem o aplicativo aberto em segundo ou primeiro plano, mesmo se não estiver online e pronto para aceitar tarifas. Em mais de uma dúzia de casos em que apoiamos a apelação dos motoristas de suas revogações no Tribunal de Magistrados, todos os recursos foram confirmados e o TfL recebeu ordem de restabelecer as licenças. A partir desse arquivo, podemos ver até 230 linhas de dados por minuto sendo registrados pelo Uber a partir de dispositivos. Os dados que o Uber coletou dos dispositivos do Aweso incluíram geolocalização, nível de bateria, velocidade, rumo do curso, número IMEI etc.

Os dados mostraram que o dispositivo em Uxbridge nunca havia se logado para trabalhar naquele dia porque um campo intitulado 'driver_online' mostrou o iPhone como 'FALSE' em todos os momentos daquele dia, incluindo o horário em que foi gravado em Uxbridge. Esta é a prova de que o dispositivo não estava sendo compartilhado para o trabalho com outras pessoas, conforme alegado pelo Uber e pela Transport for London. O Uber não forneceu acesso aos dados pessoais processados em ambos os cheques RTID, incluindo as fotos coletadas. Os 'Dados Detalhados do Dispositivo' não mostram nenhum registro de qualquer outra atividade do iPhone após 20h03min43s. Não vimos nenhuma evidência de dados de atividade do dispositivo às 23h55, quando o Uber disse que recebeu uma resposta ao cheque de identidade emitido anteriormente.

A experiência de Pa e Aweso foi muito prevalente durante o ano passado e representou um volume significativo de casos tratados pelo Worker Info Exchange e pela App Drivers & Couriers Union. Em Londres, a Transport for London tendeu a revogar imediatamente as carteiras de motoristas que haviam falhado nas verificações RTID do Uber, apesar dos problemas óbvios com o sistema. Freqüentemente, há explicações razoáveis para o uso de vários dispositivos que são automaticamente classificados como fraude. A própria política de privacidade do Uber indica que onde um dispositivo tem o aplicativo aberto em segundo ou primeiro plano, mesmo se não estiver online e pronto para aceitar tarifas. Em mais de uma dúzia de casos em que apoiamos a apelação dos motoristas de suas revogações no Tribunal de Magistrados, todos os recursos foram confirmados e o TfL recebeu ordem de restabelecer as licenças.

Worker Info Exchange, Big Brother Watch e App Drivers & Couriers Union escreveram uma carta conjunta ao prefeito de Londres para levantar nossas preocupações sobre a confiança do Transport for London em evidências falhas do Uber para tomar uma decisão de revogação e exigiu isso, como Presidente de Transporte para o conselho de Londres, que ordenasse uma revisão de todas essas revogações ilícitas. Até o momento, nem o prefeito nem o TfL responderam.

Opaco Performance Management

A opacidade das empresas de plataforma inibe a compreensão do trabalhador de como o controle algorítmico pode ser integrado ao longo do período de processos críticos e ao longo do tempo. Por exemplo, os trabalhadores não receberam a transparência a que têm direito legalmente para compreender como o perfil de desempenho se relaciona com a qualidade e a quantidade do trabalho oferecido, bem como com os rendimentos esperados para esse trabalho.

No caso de Ola, temos algum conhecimento das categorias de dados que eles coletam e processam em seus sistemas de alocação de trabalho - como pontuação de probabilidade de fraude, perfil de ganho, aceitação de reserva e histórico de cancelamento, entre outros - no entanto, isso não revela as diferentes ponderações aplicada a essas variáveis, nem a lógica de processamento.

O Uber há muito afirma que seu sistema de correspondência é exclusivamente determinado pela localização, apesar de sua própria interface “Parceiro-Driver” sugerir o contrário. O programa Pro do Uber (no qual os motoristas são automaticamente inscritos para que possam ser incentivados a cumprir as metas de desempenho em troca de benefícios e recompensas) informa aos motoristas em linguagem vaga que "taxas de confirmação mais altas significam tempos de espera mais curtos para os clientes e tempos de coleta mais curtos para todos motoristas ”, referindo-se vagamente ao fato de que empregos em declínio resultarão em menos ofertas de emprego.

O Uber recentemente ofereceu mais transparência no sistema de correspondência por meio de uma atualização de sua política de privacidade que afirma: “Os usuários podem ser correspondidos com base na disponibilidade, proximidade e outros fatores, como probabilidade de aceitar uma viagem com base em seu comportamento ou preferências anteriores” mas, no momento da redação, o link que oferecia mais informações sobre o sistema de correspondência foi quebrado, atestando a natureza evolutiva de tal processamento de dados. Uma recente solicitação de liberdade de informação que fizemos ao TfL, perguntando sobre quais atualizações o Uber havia fornecido em seu sistema de correspondência (como é obrigado a fazer ao fazer alterações em seu modelo operacional) não retornou resultados, destacando ainda mais a ofuscação de suas práticas de gerenciamento algorítmico e a ausência de supervisão regulatória.

As recentes revelações sobre as variáveis que determinam a alocação do trabalho também levantam questões importantes sobre a qualidade dos empregos oferecidos aos motoristas. Os motoristas com altas taxas de aceitação de emprego oferecem viagens de longa duração e duração, resultando em salários mais altos, com base em perfis semelhantes? Ou, indo um passo além, os motoristas são oferecidos taxas diferentes por meio do sistema de preços dinâmico? De fato, se e como a precificação algorítmica é combinada com a alocação de trabalho é uma questão sensível sobre a qual pouco ainda se sabe.

Nos últimos anos, o Uber substituiu os preços variáveis de tempo e distância para os clientes por um modelo de preço fixo no qual um preço inicial é aceito no início da viagem. O Uber afirma que “o preço inicial é dinâmico, o que significa que o preço é calculado em tempo real para ajudar a equilibrar a oferta e a demanda”. Mais recentemente, os motoristas relataram ter recebido ofertas de taxas muito baixas para empregos individuais. Há uma oportunidade óbvia aqui para o Uber aumentar sua participação na eventual tarifa paga pelos passageiros. Foram levantadas preocupações sobre os resultados discriminatórios do uso desses sistemas de preços dinâmicos sobre os passageiros, o que introduz a perspectiva de que os motoristas também podem estar sujeitos a preços personalizados em tempo real. Há sérios problemas éticos aqui se os operadores estão oferecendo preços mais baixos para trabalhadores vulneráveis com base em perfis que prevêem sua disposição de aceitar trabalho com preços diferentes.

No Reino Unido, tais práticas parecem contrariar as disposições da Seção 1 da Lei de Direitos do Trabalho, que dá aos trabalhadores o direito de receber de seu empregador uma declaração clara dos termos e condições de seu trabalho, incluindo taxas de pagamento.

Estudo de Caso: Controle Algorítmico

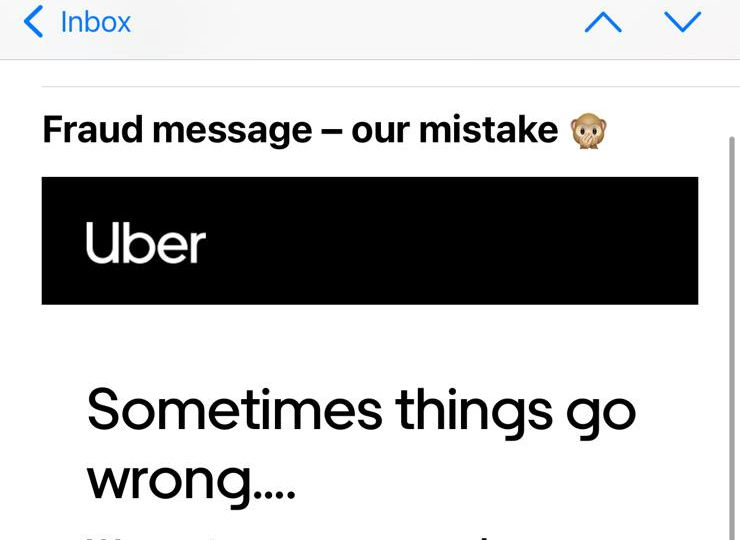

O Uber envia rotineiramente mensagens aos motoristas quando eles são sinalizados por seus sistemas de detecção de fraude para avisá-los de que podem perder o emprego se continuarem com qualquer comportamento que esteja acionando o sistema. As mensagens contêm uma lista não exaustiva dos gatilhos potenciais, mas não fornecem um motivo específico para o motorista individual que está sendo acusado de fraude. Quando Alexandru recebeu a segunda e última dessas mensagens, sabendo que outra bandeira resultaria em demissão, ele decidiu ligar para a equipe de suporte do motorista para obter mais detalhes sobre por que ele estava acionando o sistema antifraude e o que ele poderia fazer para evitá-lo . Por meio da ligação , Alexandru e o agente de suporte discutiram uma série de situações que podem ter feito suas viagens parecerem irregulares, revelando a capacidade limitada das equipes de suporte em decifrar as indicações feitas pelo sistema. Três meses após essa ligação, o Uber enviou uma mensagem de desculpas informando que os avisos foram enviados por engano.

Embora a conversa seja esclarecedora em termos de compreensão dos dilemas que os motoristas enfrentam quando a política da empresa e as demandas dos passageiros divergem, foi de particular interesse para nós a discussão (25 minutos de chamada) sobre um desvio que Alexandru fez devido a obras rodoviárias, bem como seu baixo taxas de aceitação de trabalho como causas potenciais de sua detecção pelo sistema antifraude. Após a decisão da Suprema Corte que classificou os motoristas do Uber como trabalhadores no início deste ano, o Uber afirmou ter feito mudanças significativas em sua plataforma , como oferecer transparência de preço e destino, bem como remover medidas punitivas para recusar empregos, em uma tentativa de argumentar que a decisão da Suprema Corte não se aplica aos atuais motoristas do Uber.

A experiência de Alexandru na plataforma vai contra esta narrativa, pois se torna aparente que ele provavelmente está sendo sinalizado por desvio de rota (apesar do fato de que o Uber agora opera um modelo de preço fixo, o que significa que os motoristas fazem essas alterações de rota às suas próprias custas) e não aceitando o suficiente do trabalho oferecido a ele na plataforma. Esta ligação deixa inegavelmente claro que, na prática, os motoristas ainda são controlados pelo Uber como antes.

Além dessas práticas de gestão, o programa Pro citado acima é outra ferramenta que o Uber utiliza para exercer o controle sobre sua força de trabalho, evitando as obrigações legais que podem estar associadas a esse controle. Por exemplo, ao vincular certas recompensas que culminam em manter uma classificação elevada para empresas terceirizadas ou apresentar a participação em benefícios de preços como puramente opcional por meio de incentivos comportamentais, o Uber cria a ilusão de permitir que os motoristas operem com total independência e flexibilidade. O suposto engajamento voluntário dos motoristas nesses programas resulta na renúncia de direitos decorrentes do vínculo empregatício.

EMBED: vídeo de Alexandru

Expansão da infraestrutura de aplicação da lei

Também há evidências de que as plataformas têm se tornado cada vez mais uma fonte atraente de inteligência para a polícia e os serviços de segurança. Em uma declaração de testemunha apresentada como prova em setembro de 2020 no recurso de licenciamento do Uber no Tribunal de Magistrados de Westminster, o gerente geral do Uber no Reino Unido e na Europa Ocidental, Jamie Heywood, atestou um relacionamento cada vez mais próximo com a polícia e os serviços de segurança. Isso inclui a National Counter Terrorism Policing Network, SO15 - o Comando Antiterrorismo do Metropolitan Police Service, o National Police Chiefs Council (NPCC), o College of Policing, a National Crime Agency e a British Transport Police. Uma área de cooperação tem sido o problema do chamado transporte de drogas da County Lines. Citando o detetive inspetor Stuart Liddell do NPCC, Heywood testemunhou um relacionamento amadurecido com base em níveis sofisticados de compartilhamento de inteligência:

“Estou encorajado com o envolvimento demonstrado pelo Uber em relação a este assunto e mais trabalho está planejado [em 2020] para desenvolver o trabalho até agora. Isso se concentrará em aspectos mais intrincados das Linhas do Condado, o fluxo de informações e inteligência e o fortalecimento da relação entre o Centro de Coordenação das Linhas do Condado Nacional. ”

Na verdade, o NPCC fez lobby para o Comissário de Transporte de Londres, Mike Brown, em apoio ao recurso de licença do Uber. O chefe de polícia Mark Collins chegou a sugerir que uma decisão de negar a licença ao Uber poderia ter um impacto negativo no policiamento do Reino Unido.

“Esperançosamente, esta carta descreve o impacto negativo sobre o policiamento do Reino Unido caso a polícia não consiga acessar os dados e informações que descrevi.”

Heywood também testemunhou que Collins alegou que apenas o Serviço de Polícia Metropolitana fazia mais de 2.000 solicitações de dados ao Uber a cada ano. Este é um número relativamente alto de solicitações, considerando que, de acordo com o próprio Relatório de Transparência do Uber, em 2020 todas as autoridades policiais dos EUA juntas fizeram pouco menos de 5.000 solicitações de dados e todas as autoridades policiais canadenses juntas fizeram apenas 411 dessas solicitações.

É provável que a administração do Uber sinta pressão para cooperar com as iniciativas de coleta de inteligência policial, especialmente à luz da decisão da Transport for London de recusar a renovação de sua licença duas vezes. Isso ocorre porque a seção 17 do Crime and Disorder Act 1998 coloca uma responsabilidade direta sobre as autoridades de licenciamento para prevenir o crime e a desordem em sua área. Isso cria um requisito para que as autoridades de licenciamento, como a Transport for London, estabeleçam parcerias para redução do crime e desordem (CDRP), nas quais se espera que operadoras de transporte como a Uber participem.

Na orientação estatutária do Departamento de Transporte às autoridades licenciadoras, o governo reforça a expectativa de compartilhamento de inteligência entre a polícia, autoridades licenciadoras e operadoras de transporte como a Uber:

“Aumentar a conscientização das forças policiais sobre o valor que as autoridades licenciadoras atribuem às informações recebidas, especialmente sobre inteligência não condenatória, ajudará a aprofundar essas relações e reforçará os benefícios de um maior compartilhamento de informações. Essa relação pode ser mutuamente benéfica, auxiliando a polícia na prevenção do crime. A polícia pode obter informações valiosas de motoristas e operadores ... ”

Embora essas relações tenham uma importância significativa para o controle do crime a nível da comunidade, parece que pouca atenção foi dada ao risco para as liberdades civis de acesso relativamente fácil a dados pessoais ricos de motoristas e passageiros coletados e armazenados por plataformas como Uber, Bolt e Ola Táxis.

“Estou encorajado pelo engajamento exibido pela Uber em relação a esse assunto e mais trabalho está planejado [em 2020] para desenvolver o trabalho até agora. Isso se concentrará em aspectos mais intrincados das Linhas do Condado, no fluxo de informações e inteligência e no fortalecimento da relação entre o Centro Nacional de Coordenação das Linhas do Condado.”

“Espero que esta carta descreva o impacto negativo no policiamento do Reino Unido caso a polícia não consiga acessar os dados e informações que descrevi.”

“Aumentar a consciência entre as forças policiais sobre o valor que as autoridades de licenciamento atribuem às informações recebidas, particularmente à inteligência não condenatória, ajudará a aprofundar essas relações e reforçará os benefícios de um maior compartilhamento de informações. Essa relação pode ser mutuamente benéfica, auxiliando a polícia a prevenir o crime. A polícia pode obter informações valiosas de motoristas e operadores...”

Estudo de caso: compartilhamento de inteligência com autoridades policiais

Outro trabalhador que nos procurou pedindo ajuda foi um motorista do Uber que foi suspenso por engano da plataforma do Uber por sete semanas, sofrendo uma perda de quase £ 5.000, após um pedido de inteligência feito pela polícia. Em 2019, o motorista recebeu uma mensagem do Uber informando que estava temporariamente suspenso devido a uma investigação em andamento. Ele não recebeu um motivo nem um prazo para sua suspensão. Na verdade, ele foi expressamente instruído a não entrar em contato com o Uber enquanto eles realizavam a investigação. Sete semanas depois, ele recebeu uma ligação informando que agora ele poderia trabalhar.

Dois anos depois, um pedido de renovação de licença feito pelo motorista ao TfL (que inclui uma verificação aprimorada do Serviço de Divulgação e Barramento) revelou o motivo da suspensão, quando o TfL o questionou sobre o fornecimento de drogas em 2019 e ameaçou retirar sua carteira. Chocado com a revelação, o motorista exigiu o número de referência do crime e fez mais consultas não apenas ao TfL, mas também à Polícia Metropolitana.

Auxiliamos o motorista na realização de solicitações de acesso de assuntos e reclamações para Uber, TfL e polícia. O Uber não atendeu à solicitação (o motorista foi informado de que sua solicitação foi repassada a uma equipe especializada, mas não recebeu nenhuma resposta), no entanto, a resposta do TfL revelou uma extensa cadeia de e-mails entre vários funcionários enquanto eles tentavam identificar a fonte da inteligência solicitar. O Uber alegou que eles foram abordados pela polícia enquanto a polícia não localizou nenhum registro ou evidência de investigação do motorista. Eventualmente, o Uber nomeou o oficial que havia feito o pedido de inteligência, mas quando o TfL buscou detalhes sobre o caso, o OIC alegou que ele não tinha nenhuma lembrança do motorista em questão.

A reclamação que o motorista fez à Polícia Metropolitana foi finalmente respondida em outubro de 2021 e concluiu que o motorista nunca havia sido identificado como suspeito:

“Os policiais foram encarregados de identificar um suspeito em relação a um crime grave. Os oficiais receberam o nome de uma pessoa de interesse. Posso confirmar que NÃO foi você. Um formulário de proteção de dados foi enviado em 20 de fevereiro de 2019 ao Uber com os detalhes desse suspeito. Não tenho liberdade para divulgar mais detalhes sobre isso.

“Em nenhum momento o seu nome apareceu nesta pesquisa feita com o Uber. O oficial NÃO abordou o Uber em busca de qualquer informação relacionada a você. Como resultado de nossa investigação, o Uber forneceu seus dados à polícia. Assim que as informações foram recebidas do Uber e eles nos forneceram seu nome, sabíamos que você NÃO estava vinculado à nossa investigação e nenhuma ação foi tomada e você foi excluído de quaisquer outras investigações. ”

“O policial não violou nenhum padrão profissional, nem agiu fora de sua função de policial, nem abusou de seu poder. Seu nome não era o propósito da solicitação e em nenhum momento informamos ao Uber que você era uma pessoa interessante. ”

“O Uber talvez deva explicar como eles suspendem alguém que não era o objeto da solicitação original e também por que, após 10 dias, você não foi reintegrado automaticamente no aplicativo e pode continuar trabalhando.”

EMBED: L's Video

“Os policiais foram encarregados de identificar um suspeito em relação a um crime grave. Os oficiais tinham recebido o nome de uma pessoa de interesse. Posso confirmar que não foi você. Um formulário de proteção de dados foi enviado em 20 de fevereiro de 2019 à Uber com os detalhes do suspeito. Não tenho liberdade para divulgar mais detalhes sobre isso.

“Em nenhum momento seu nome apareceu nesta pesquisa feita com a Uber. O policial NÃO se aproximou do Uber procurando qualquer informação relacionada a você. Como resultado da nossa consulta, a Uber forneceu os seus dados à polícia. Depois que as informações foram recebidas do Uber e eles nos deram seu nome, sabíamos que você NÃO estava vinculado à nossa investigação e nenhuma ação adicional foi tomada e você foi excluído de quaisquer outras investigações.”

“O policial não violou nenhum padrão profissional nem agiu fora de seu papel como policial ou abusou de seu poder. Seu nome não era o objetivo da solicitação e em nenhum momento dissemos ao Uber que você era uma pessoa de interesse.”

“O Uber talvez deva explicar como eles suspendem alguém que não era o objeto da solicitação original e também por que, após 10 dias, você não foi reintegrado automaticamente no aplicativo e não pôde continuar trabalhando.”

Parte II: Exercício dos direitos de dados no trabalho: acesso

A legislação trabalhista não possui as disposições necessárias para proteger totalmente os trabalhadores das práticas desleais decorrentes da gestão algorítmica. No entanto, os indivíduos têm direitos sob o GDPR que podem proteger seus interesses em contextos de emprego. Ao apoiar os trabalhadores, invocamos os seus direitos definidos nos artigos 15, 20 e 22, que lhes conferem o direito de acesso aos dados pessoais , o direito à portabilidade dos dados , bem como o direito a serem informados sobre a tomada de decisões automatizada e a lógica de processamento .

Artigo 22: Os titulares dos dados não podem estar sujeitos a decisões com efeitos jurídicos (ou igualmente significativos), baseadas exclusivamente no processamento automatizado de dados.

[Se o controlador de dados processa os dados com o consentimento explícito do titular dos dados ou para a execução de um contrato com ele, o titular dos dados tem o direito de obter intervenção humana, de expressar seu ponto de vista e de contestar a decisão]

Artigo 15: Os titulares dos dados têm o direito de receber uma cópia dos seus dados pessoais, juntamente com informações suplementares, como a finalidade do processamento dos dados, informações sobre com quem os dados podem ser partilhados, a duração do processamento, etc.

Artigo 20: Os titulares dos dados têm o direito de receber os dados pessoais que forneceram a um controlador em um formato estruturado, comumente usado e legível por máquina. Eles também têm o direito de transmitir ('portar') os dados para outro controlador. Sempre que possível, eles podem solicitar que os dados sejam transmitidos diretamente de um controlador para outro.

Embora as plataformas disponibilizem downloads de dados para os trabalhadores, elas frequentemente omitem as categorias de dados mais propícias e necessárias para interrogar as condições de trabalho (como justiça de pagamento, alocação de trabalho e utilização, conforme listado acima). Em nossa aspiração de expandir o escopo de dados disponibilizados aos trabalhadores, fazemos solicitações de acesso e portabilidade de assuntos específicos que cobrem toda a gama de plataformas de dados coletados deles. Nessas solicitações, buscamos obter três tipos diferentes de dados:

1) Dados de entrada - fornecidos pelos próprios trabalhadores

2) Dados de observação - com base no uso de plataformas pelos trabalhadores (ou seja, medição bruta e dados de vigilância, como dados de localização, telemática, etc.)

3) Dados inferidos - derivados da análise de dados de observação (por exemplo, criação de perfil do comportamento do trabalhador na forma de avaliações de risco e fraude)

Artigo 22: Os titulares dos dados não podem estar sujeitos a decisões com efeitos jurídicos (ou igualmente significativos), com base exclusivamente no tratamento automatizado de dados.

[Se o responsável pelo tratamento tratar dados com o consentimento explícito do titular dos dados, ou para a execução de um contrato com este, o titular dos dados tem o direito de obter intervenção humana, de expressar o seu ponto de vista e de contestar a decisão]

Artigo 15: Os titulares dos dados têm o direito de receber uma cópia dos seus dados pessoais, juntamente com informações complementares, como as finalidades do tratamento dos dados, informações sobre com quem os dados podem ser partilhados, a duração do tratamento, etc.

Artigo 20 : Os titulares dos dados têm o direito de receber os dados pessoais que forneceram a um controlador em um formato estruturado, comumente usado e legível por máquina. Eles também têm o direito de transmitir ('portar') os dados para outro controlador. Sempre que possível, eles podem solicitar que os dados sejam transmitidos diretamente de um controlador para outro.

Dados de entrada

Fornecido pelos próprios trabalhadores

Dados observados

Com base no uso de plataformas pelos trabalhadores (ou seja, dados brutos de medição e vigilância, como dados de localização, telemática, etc.)

Dados inferidos

Derivado da análise de dados de observação (por exemplo, perfil do comportamento do trabalhador na forma de avaliações de risco e fraude)

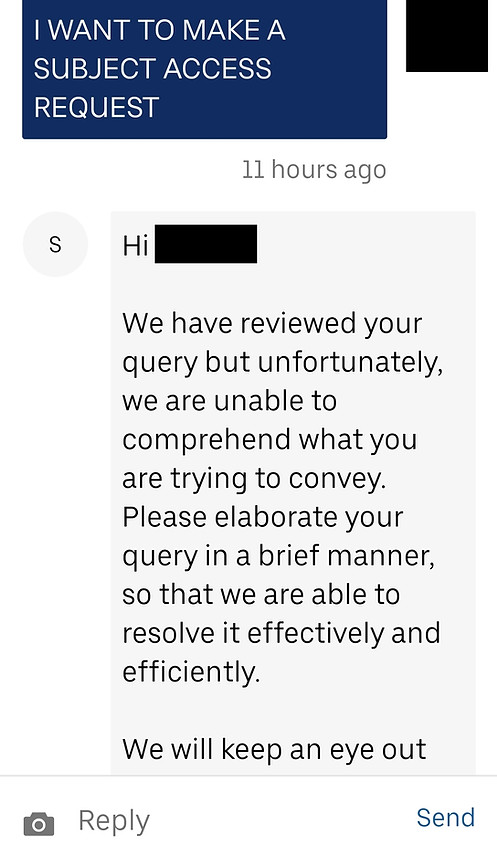

Essas categorias de dados geralmente são explicitadas em documentos de orientação e políticas de privacidade, mas não são compartilhadas com os motoristas quando eles baixam seus dados ou fazem solicitações de acesso do titular. Em nossa experiência, quando os trabalhadores procuram essas informações, as plataformas gig visam tornar o processo difícil e oneroso, engajando-se em uma variedade de comportamentos não conformes. Os trabalhadores que buscam dados abrangentes precisam navegar em arquiteturas de sites extremamente complexas e obstrutivas e precisam evitar mais esforços de frustração dos agentes de suporte, que prolongam desnecessariamente processos administrativos simples ou fornecem respostas automatizadas que não respondem adequadamente às consultas. Esses procedimentos podem ser descritos como ' padrões obscuros' projetados para orientar os trabalhadores a não exercerem seus direitos como titulares de dados. Nas ocasiões em que os trabalhadores conseguem obter seus dados, muitas vezes faltam segmentos consideráveis ou são apresentados em formatos inconsistentes e não legíveis por máquina, tornando a análise efetivamente impossível. Esses atos de obstrução forçam os trabalhadores a fazer repetidas solicitações que as empresas acabam usando como motivo para desacreditá-los.

Em todos os retornos de DSAR que vimos, nenhum empregador forneceu uma conta completa e adequada do processamento automatizado de dados pessoais. Isso é particularmente importante em áreas que podem determinar a segurança do emprego, como alocação de trabalho, gerenciamento de desempenho, segurança e proteção, conforme discutido neste relatório. Uber e Ola argumentaram no tribunal que a segurança de sua plataforma pode ser comprometida se a lógica desse processamento de dados for divulgada a seus funcionários. Em nossa opinião, a segurança e a proteção só podem ser aprimoradas quando as plataformas definem regras e padrões de desempenho de forma transparente, em vez de depender de vigilância secreta e demissões sumárias, que são alguns dos principais motivadores dos DSARs.

Diante dessa atitude de resistência aos DSARs, também é importante observar que muitos motoristas temem retaliações por parte das empresas por fazerem solicitações. Quando as plataformas gig realizam verificações de identidade imoderadas e prolongadas em resposta a solicitações de acesso do assunto, os trabalhadores são facilmente desencorajados e intimidados (veja os e-mails enviados aos motoristas pela Uber nos estudos de caso de resposta da plataforma). Nas inúmeras entrevistas que realizamos com motoristas, longas mensagens de busca de confirmação, transmitidas em linguagem jurídica complexa, têm sido frequentemente mencionadas como impedimentos à busca de solicitações. Para muitos motoristas, o ato de insistir no pedido equivale a colocar a cabeça acima do parapeito e arriscar seu sustento e segurança no emprego.

Essa percepção muitas vezes decorre de experiências de exploração e insegurança contínuas, decorrentes da capacidade e conhecimento limitados dos trabalhadores no exercício dos direitos democráticos, seja no Reino Unido como imigrantes ou em seus países de origem, que em muitos casos apresentam tendências autoritárias. Em uma força de trabalho já bastante fragmentada e propensa à precariedade econômica, onde a necessidade de segurança supera em muito o desejo de desafiar a injustiça, o impacto desse tipo de comportamento hostil das empresas não pode ser exagerado. Essa insegurança é ainda agravada pela opacidade dos algoritmos de gerenciamento. Na ausência de explicações claras de como a alocação de trabalho de caixa preta ou os sistemas de gerenciamento de desempenho funcionam, fica muito fácil para os trabalhadores se envolverem em pensamentos especulativos ou mesmo conspiratórios sobre como suas interações com a plataforma afetam seu trabalho. Isso pode então se estender a uma desconfiança generalizada em relação a outras instituições e a uma aversão à atividade organizadora. Essas são vulnerabilidades fortes e persistentes em toda a força de trabalho que exigem atenção e proteção especiais.

Estudos de caso: DSARs individuais

Os estudos de caso a seguir demonstram algumas das maneiras como o Uber se envolve em comportamentos obstrutivos e não conformes ao responder às solicitações de dados dos funcionários. Significativamente, esses exemplos não podem ser explicados como exceções ou eventos isolados relativos a agentes de suporte inexperientes. Essas respostas representam os procedimentos padrão seguidos pelo Uber quando os trabalhadores desejam exercer seus direitos de acesso aos dados.

Respostas circulares e fúteis

M. Ahmed é um ex-motorista do Uber e mensageiro do Uber Eats. Em outubro de 2020, suas contas de motorista e correio Uber foram suspensas e, em fevereiro de 2021, sua conta de motorista foi desativada. Isso afetou sua conta de correio UberEats também, que foi posteriormente desativada e excluída.

Quando o Sr. Ahmed perguntou a causa de sua demissão, ele recebeu respostas contraditórias. O Uber inicialmente citou falhas nas verificações de reconhecimento facial e, posteriormente, alegou que a desativação foi devido a um alto volume de pedidos não entregues. Ao longo da correspondência, eles o trataram com o nome errado e, por fim, aceitaram que as mensagens relacionadas às verificações de ID em tempo real que falharam foram enviadas por engano. A confusão em torno de sua demissão o levou a buscar seus dados pessoais.

Nos últimos meses, Ahmed tem tentado recuperar os dados associados à conta desativada do Uber Eats. O Sr. Ahmed tentou obter seus dados pela primeira vez em 15 de abril de 2021, por meio do formulário 'Enviar uma consulta de privacidade sem uma conta Uber' no site da Uber, pois sua conta foi excluída após sua demissão.

Em resposta, ele recebeu um e-mail do Uber declarando: “Nosso Aviso de Privacidade limita nossa capacidade de compartilhar informações do titular da conta. Só podemos fornecer essas informações por meio do processo descrito em nossas diretrizes de solicitação de dados. ” Esse processo se refere a entrar na conta e fazer a solicitação de dentro da conta. “Dito isso, podemos trabalhar com você por meio dos canais apropriados para ajudar conforme necessário.”

O Sr. Ahmed respondeu pedindo conselhos sobre como ele poderia acessar os dados associados à sua conta agora excluída. Ele explicou que estava escrevendo a partir do e-mail associado à sua conta do Uber Eats e que também forneceu o número do celular associado a essa conta. Ele acrescentou que ficou feliz em fornecer mais informações para confirmar sua identidade.

A isso, o Sr. Ahmed recebeu uma resposta afirmando que sua “preocupação não está relacionada a este relato. Escreva para nós usando a conta em questão ou faça login em help.uber.com com as credenciais relevantes e informe-nos sobre o problema para que possamos ajudá-lo mais. ”

O Sr. Ahmed respondeu, anexando uma imagem do e-mail de integração enviado a ele pelo Uber em 03 de julho de 2020, para demonstrar que estava escrevendo a partir da conta em questão. Em 19 de abril de 2021, ele recebeu a mesma mensagem afirmando que sua “preocupação não está relacionada a este relato”.

O Sr. Ahmed respondeu explicando mais uma vez que não consegue acessar sua conta e que forneceu os detalhes associados à sua conta no Uber Eats. Ele pediu para receber orientação sobre quais outras informações ele poderia fornecer para se identificar. Ele não obteve resposta.

Nesse ponto, o Sr. Ahmed procurou a ajuda do Sindicato de Drivers e Correios de Aplicativos e do Worker Info Exchange e encaminhamos o problema ao Uber. Em 11 de maio de 2021, o Sr. Ahmed recebeu um e-mail do Uber pedindo-lhe que confirmasse o pedido feito por nós em seu nome. Ele respondeu confirmando que nos havia dado seu mandato e que gostaria que seu pedido fosse processado.

Em 14 de maio de 2021, o Sr. Ahmed recebeu um formulário de verificação de identidade da Uber para processar o pedido. O formulário pedia os mesmos dados que ele já havia compartilhado em suas mensagens anteriores, como e-mail, telefone, país de residência, tipo de dados solicitados. Também pedia sua “classificação atual” - que era inaplicável, pois ele não tinha mais acesso à sua conta. O Sr. Ahmed enviou o formulário ao Uber, mas não obteve resposta.

Em 20 de maio de 2021, o Sr. Ahmed escreveu ao Uber para obter a confirmação de que estavam processando seu pedido. Ele não obteve resposta.

No momento da redação, o Sr. Ahmed não havia recebido seus dados. Ele também não recebeu nenhuma explicação do motivo pelo qual sua solicitação não está sendo processada.

Compartilhamento de dados inconsistentes e incrementais

O Sr. Amini é um ex-motorista do Uber que foi desativado em novembro de 2020 após uma falha na verificação de geolocalização . O Uber relatou sua demissão ao TfL, que então revogou a licença de locação particular do Sr. Amini, deixando-o sem trabalho. Em uma tentativa de entender a causa de sua demissão, o Sr. Amini procurou obter seus dados do Uber.

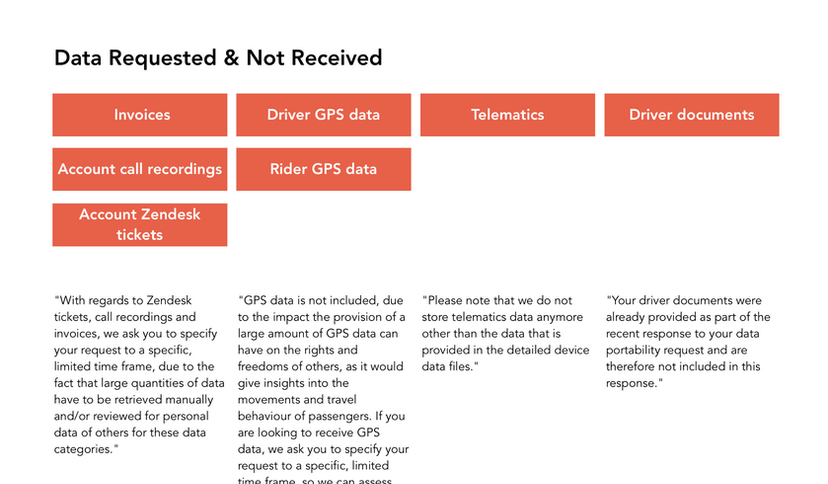

O Sr. Amini fez o seu primeiro pedido em 13 de abril de 2021 e solicitou todos os seus dados pessoais, incluindo as 26 categorias de dados descritas no documento de orientação produzido pela Uber, bem como as imagens enviadas por ele em resposta a verificações de identidade em tempo real. Ele especificou que queria dados cobrindo todo o período em que esteve ativo como motorista do Uber.

O Sr. Amini recebeu uma resposta ao seu pedido em 5 de maio de 2021, no entanto, os dados fornecidos abrangiam apenas os 30 dias anteriores ao seu pedido. Como o Sr. Amini não pôde trabalhar para a Uber durante esse período, muitos dos conjuntos de dados fornecidos estavam em branco.

O Sr. Amini então fez outro pedido em 06 de maio de 2021, afirmando mais uma vez que estava solicitando dados relativos a todo o período de tempo em que trabalhou com o Uber, acrescentando especificamente que desejava os dados coletados até novembro de 2020.

O Sr. Amini recebeu uma resposta em 28 de maio de 2021. No entanto, mais uma vez, foram enviados dados incompletos. Especificamente, o csv de dados detalhados do dispositivo do driver fornecido pelo Uber estava completamente em branco.

O Sr. Amini fez outro pedido em 2 de junho de 2021, solicitando os dados em falta. Ele recebeu seus dados de dispositivo detalhados do motorista para novembro de 2020 em 10 de junho de 2021. No entanto, apesar de especificar que queria todos os campos de dados listados nas notas de orientação produzidas pelo Uber, ele recebeu um conjunto de dados restrito que omitiu 32 dos 50 dados Campos.

Ofuscação e resistência

Majid é um ex-motorista do Uber que foi desativado em setembro de 2020 após uma falha na verificação de geolocalização. Como no caso do Sr. Amini, o Uber relatou a demissão do Sr. Majid à TfL, o que causou a revogação da sua licença de locação privada. Em um esforço para entender a base das alegações do Uber, ele tentou obter seus dados.

O Sr. Majid entrou em contato com o Uber para solicitar seus dados em 2 de junho de 2021. Em resposta, ele recebeu uma mensagem pedindo-lhe para explicar sua preocupação de maneira breve. O Sr. Majid respondeu com o seu pedido de 3 categorias de dados (das 26 categorias listadas nas notas de orientação do Uber) para setembro de 2020.

Em 8 de junho de 2021, o Sr. Majid recebeu uma mensagem do Uber afirmando: “Nossa Política de Privacidade não nos permite fazer alterações ou discutir informações pessoais sem contato por meio do endereço de e-mail associado à sua conta de parceiro. Para ajudá-lo com seu problema específico, você precisará escrever usando o endereço de e-mail associado a essa conta. Obrigado pela compreensão. ”

Nessa fase, o Sr. Majid entrou em contato conosco, confuso, pois havia escrito ao Uber de seu relato. Ele escreveu de volta, explicando ao Uber que os contatou fazendo login em sua conta de motorista, então ele definitivamente estava escrevendo do endereço de e-mail correto. Ele perguntou se poderia fornecer qualquer identificação / documentação adicional para garantir ao Uber que era ele quem estava fazendo a solicitação.

Em resposta, ele recebeu a mesma mensagem do Uber: “Oi ... obrigado pela sua mensagem. Entendemos que você gostaria de discutir informações relacionadas a uma conta Uber. Se você for o titular da conta, escreva usando o endereço de e-mail associado à sua conta Partner-Driver e seremos capazes de ajudá-lo imediatamente. ”

Em 09 de junho de 2021, o Sr. Majid fez login em sua conta de parceiro e iniciou um bate-papo com o suporte do Uber para tentar novamente. Sua mensagem perguntando se ele poderia fazer uma solicitação de acesso ao assunto foi ignorada.

Em 14 de junho de 2021, o Sr. Majid entrou em contato com o Uber mais uma vez, informando que tinha uma dúvida sobre sua conta de parceiro motorista. Ele recebeu uma resposta do Uber: “Obrigado por entrar em contato ... Aproveitamos a oportunidade para revisar sua preocupação e podemos ver que você já havia entrado em contato conosco sobre esse assunto. Um dos membros da nossa equipe está investigando seu problema e entraremos em contato com você assim que possível. Para agilizar nossa comunicação e evitar qualquer confusão, vamos encerrar este contato. ”

Em 16 de junho de 2021, o Sr. Majid contactou a Uber mais uma vez, informando que tinha sido convidado a iniciar sessão na sua conta para fazer um pedido e, depois de o ter feito, pretendia partilhar os detalhes do seu pedido. Ele recebeu uma resposta no dia seguinte e, posteriormente, enviou os detalhes da solicitação (dos três conjuntos de dados listados acima) em 18 de junho de 2021.

Ao não receber resposta, o Sr. Majid entrou em contato com o Uber novamente em 28 de junho de 2021, buscando a confirmação de que seu pedido estava sendo processado. Em 01 de julho de 2021, ele recebeu uma resposta informando que sua preocupação havia sido levantada com a equipe especializada e que eles entrariam em contato para maiores investigações.

Em 02 de julho de 2021, o Sr. Majid recebeu uma resposta à sequência de mensagens que havia iniciado em 09 de junho de 2021. Esta mensagem afirmava que o Uber exige que os pedidos sejam enviados pessoalmente ao endereço postal do Uber BV na Holanda.

O Sr. Majid não recebeu mais nenhuma comunicação.

“A questão dos algoritmos é central para o tema da uberização. Muitas vezes, é o algoritmo que desempenha o verdadeiro papel do chefe, pois a tecnologia fornece novos meios para a subordinação dos trabalhadores. Obviamente, há uma necessidade de transparência do gerenciamento algorítmico, mas além dessa transparência, há uma necessidade de co-gerenciamento do algoritmo. Os representantes dos trabalhadores devem poder participar no seu desenvolvimento."

Leila Chaibi, eurodeputada

Estudos de caso: Respostas da plataforma para

Solicitações em lote por troca de informações do trabalhador

Conforme demonstrado pelos exemplos acima, os processos de solicitação individuais podem consumir muito tempo e muita capacidade. Portanto, criamos processos que nos permitem fazer solicitações em lote em nome dos motoristas e agilizar esse procedimento complexo. Montamos um sistema usando a solução de assinatura eletrônica e identificação desenvolvida pela Scrive para receber uma autorização legal dos trabalhadores para fazer solicitações em seu nome. Esta solução também inclui uma verificação de ID executada pela Onfido (o mesmo serviço de verificação de ID usado pela Uber), para garantir que nós e o controlador de dados possamos ter certeza da identidade do solicitante e preservar sua privacidade de dados. A verificação de identidade exige que os trabalhadores apresentem um dos seguintes documentos de identidade: passaporte, carteira de habilitação, carteira de identidade ou autorização de residência. Por meio desse processo, é criado um documento de consentimento individual para cada pessoa, que é lacrado eletronicamente e verificável por meio de anexos ocultos contendo um registro de evidências para comprovar a autenticidade do processo de identificação. (A Scrive também oferece um serviço de verificação da integridade dos formulários de consentimento, que está vinculado nos documentos.) Enviamos esses documentos, juntamente com uma planilha contendo os nomes, emails, endereços e telefones dos trabalhadores que fazem as solicitações.

Algumas empresas têm sido receptivas e cooperativas ao responder às solicitações feitas por meio desse procedimento, enquanto outras adotam um comportamento muito mais obstrutivo e hostil. Porém, mesmo quando as empresas atendem às solicitações, há problemas consistentes no estabelecimento das categorias precisas dos dados coletados, bem como na obtenção de todos os dados solicitados em um formato estruturado e legível por máquina. Poucas empresas foram capazes de fornecer documentos de orientação com descrições claras das categorias de dados, e os dados que recebemos frequentemente exibem incongruências significativas com o processamento descrito nas políticas de privacidade. De um modo geral, as empresas têm demonstrado tendência a negar as práticas de dados que não desejam divulgar. Em um caso, uma empresa alegou que a avaliação de fraude mencionada em sua política de privacidade havia sido realizada apenas como parte de um teste e que a política de privacidade estava desatualizada. Outro referiu-nos a um documento que alegou ter substituído aquele em que baseamos o nosso pedido, embora ambos os documentos tenham sido atualizados na mesma data.

Apesar dessas dificuldades, a resistência mais polêmica que enfrentamos foi a negação de nosso direito de agir em nome dos trabalhadores ao fazer solicitações de acesso como terceiros. Esse direito inequívoco (claramente declarado na orientação da OIC e até promovido pela proposta de reforma do GDPR do governo) foi questionado por Bolt e Uber. Embora seja aparente que a resistência atua no sentido de frustrar o processo de solicitação, ela também aponta para uma lacuna importante na orientação existente sobre os processos de verificação de identidade. Quando as empresas insistem em conduzir verificações de identidade, fazendo contato direto com os trabalhadores, submetendo-os a correspondências legalmente complexas, isso nega em grande parte o propósito de apelar a terceiros para solicitações. Há um conflito preocupante entre os direitos das respectivas partes aqui, que requer orientação regulamentar urgente para garantir que não seja abusado e manipulado para aprofundar assimetrias informacionais.

Deliveroo

Das sete empresas às quais fizemos solicitações, a Deliveroo foi a que mais obedeceu. Em nossas solicitações, solicitamos às empresas que confirmem a data em que a solicitação será respondida e que processem as solicitações em massa, informando-nos quando todas as divulgações individuais forem feitas.

A Deliveroo respondeu às solicitações dentro do prazo legal, desde que documento de orientação, anotando claramente as categorias de dados e comunicados conosco durante o processo.

Livre agora

O Free Now atendeu ao nosso pedido dentro do prazo esperado e tem respondido ao longo do processo. No entanto, encontramos alguns problemas que vale a pena destacar.

1) O Free Now inicialmente tentou nos direcionar para seu formulário de contato online para fazer a solicitação. Isso não suportava o tamanho dos documentos que precisávamos compartilhar. Só conseguimos obter o e-mail do DPO depois de vários e-mails explicando o problema.

2) Os dados que recebemos não cobriam algumas das categorias de dados solicitadas, como dados relativos ao algoritmo de “floresta aleatória” usado para prevenção de fraude. Isso é explicado no política de privacidade do motorista que afirma: “Com base na pontuação calculada, podemos priorizar as viagens despachadas em conformidade. Isso garante um despacho justo e com minimização de riscos. ” Quando apontamos isso, o Free Now declarou:

“Não processamos pontuações de fraude em nossos motoristas e não usamos (e não usamos) o algoritmo de detecção de fraude em relação aos nossos motoristas e / ou seus dados pessoais.

A seção 3.4 do nosso aviso de privacidade do driver, portanto, requer atualização a esse respeito e lamentamos qualquer confusão sobre isso. A título de antecedentes, introduzimos primeiro esta seção no aviso em relação aos testes que estavam sendo realizados por nosso Departamento de Garantia de Receita. No entanto, nenhum driver foi incluído neste teste e, portanto, nenhuma pontuação de fraude relacionada ao driver (ou similar) foi criada. Desde então, paramos de realizar esses testes. ”