Contenu

Contenu

Sommaire

Partie I : Mauvaise classification 2.0 : Contrôlée par l'algorithme

Étude de cas de surveillance I : Échec de la reconnaissance faciale

Étude de cas de surveillance II : Vérifications de la géolocalisation

Gestion des performances opaques

Étude de cas : contrôle algorithmique

Expansion de l'infrastructure d'application de la loi

Étude de cas : partage de renseignements avec les forces de l'ordre

Partie II : Exercice des droits sur les données au travail : accès

Études de cas : DSAR individuels

Réponses circulaires et futiles

Partage de données incohérent et incrémentiel

Études de cas : réponses de la plate-forme aux demandes de lots par WIE

Partie III : Exercice des droits sur les données au travail : Litiges

Chauffeurs Uber contre Uber I (demandes générales de transparence)

Ola drivers c. Ola (demandes générales de transparence)

Chauffeurs Uber contre Uber II (transparence sur la prise de décision automatisée)

Cas d'appel de licence de Londres

Conclusion : la voie à suivre pour l'exercice des droits numériques au travail ?

Sommaire

Worker Info Exchange a été mis en place pour faciliter l'accès et la collectivisation des données afin de renforcer le pouvoir de négociation grâce à l'établissement d'une confiance dans les données.

C'était en réponse au développement de nouvelles pratiques de gestion algorithmique créant de profondes asymétries informationnelles et une exploitation des travailleurs.

Worker Info Exchange vise à aborder la convergence des données et des droits du travail en invoquant les droits des articles 15, 20 et 22 du RGPD dans les contextes d'emploi.

Cet objectif est gravement entravé par la non-conformité généralisée au RGPD dans l'industrie des concerts.

Au cours des huit derniers mois, nous avons effectué plus de 500 demandes d'accès à des personnes concernées auprès de sept plateformes de covoiturage différentes, notamment Amazon Flex, Bolt, Deliveroo, Free Now, Just Eat, Ola et Uber.

L'accès aux données est contesté par les entreprises qui déploient des modèles sombres et abusent délibérément de la mise en œuvre inégale du RGPD, ce qui pousse les travailleurs à résoudre les problèmes devant les tribunaux.

La collecte de données par les plateformes de concerts est excessive et conduit à une surveillance disproportionnée et irresponsable des travailleurs, ainsi qu'à une infrastructure d'application de la loi en expansion.

Il n'y a aucune transparence sur les systèmes de gestion algorithmique qui sont utilisés. Les récits de l'entreprise sur les technologies utilisées et comment sont incohérents et peu fiables.

© 2021 Échange d'informations sur les travailleurs

© 2021 Échange d'informations sur les travailleurs

introduction

L'année écoulée a marqué un tournant pour les travailleurs des plateformes de concerts dans la réalisation de leurs droits en matière d'emploi et numériques. La pratique du travail par médiation numérique a conduit à une convergence des droits en matière d'emploi et de protection des données et l'augmentation des litiges et des activités de plaidoyer par les travailleurs a donné des résultats dans ces domaines. Partout en Europe, les tribunaux ont rendu plusieurs jugements importants reconnaissant le rôle d'exploitation des pratiques de gestion algorithmique par les plateformes de concerts tout en condamnant le manque d'équité et de transparence de ces systèmes automatisés.

En Italie, le tribunal de Bologne a jugé que le système de notation de Deliveroo était discriminatoire à l'égard des travailleurs tandis que l'autorité de protection des données, Garante, a infligé deux amendes GDPR à Deliveroo et Glovo en raison de leur incapacité à divulguer de manière adéquate le fonctionnement de leurs algorithmes d'attribution des tâches et de gestion des performances.

L'Espagne a adopté la première législation pour tenter de réglementer l'IA dans le domaine de l'emploi, établissant à la fois le statut de travailleur pour les travailleurs sur scène et le droit d'être informé des règles et des paramètres des algorithmes auxquels ils sont soumis, déclenchant un torrent de plaintes. Cela résultait d'une autre affaire judiciaire contre Glovo qui s'est terminée devant la Cour suprême espagnole.

Parallèlement à ces décisions très médiatisées, la Cour suprême du Royaume-Uni a également conclu cette année que les chauffeurs d'Uber faisaient partie d'un service de transport « très étroitement défini et contrôlé par Uber » trahissant une relation de travail claire, qui, selon l'entreprise, n'existait pas dans ses efforts pour (mal) classer les travailleurs en tant qu'entrepreneurs indépendants. De manière significative, la preuve de cette relation provient des systèmes basés sur les données que les plateformes de covoiturage utilisent pour gérer leurs effectifs. Certains des problèmes mis en évidence par la Cour suprême du Royaume-Uni concernaient la gestion des conducteurs via le suivi algorithmique des taux d'acceptation des emplois, des choix d'itinéraires, du comportement de conduite et des évaluations des clients. Cependant, même s'il y a une plus grande reconnaissance de la gestion algorithmique, les gains récents dans les tribunaux ne protègent pas pleinement les travailleurs contre ses méfaits. Le statut de travailleur du membre (b) accordé aux chauffeurs Uber à la suite de la décision de la Cour suprême est un statut intermédiaire entre l'entrepreneur et l' employé , et ne parvient toujours pas à les protéger des licenciements abusifs, par exemple.

Notre expérience suggère que ces outils de gestion algorithmiques, auxquels s'ajoutent des pratiques de surveillance intensifiées, examinant en permanence les travailleurs à la recherche de fraudes ou d'actes répréhensibles potentiels, créent un environnement de travail profondément exploité. Nous assistons à un nombre démesuré de licenciements automatisés dans l'ensemble de l'industrie des concerts, dont beaucoup sont, selon nous, illégaux conformément à l' article 22 du règlement général sur la protection des données (RGPD) . L'article 22 offre aux travailleurs certaines protections limitées contre les effets néfastes de la prise de décision automatisée et du profilage, grâce au droit d'obtenir une intervention humaine et de contester la décision. L'article 15 du RGPD garantit le droit d'être informé de l'existence d'une telle prise de décision automatisée et de recevoir des informations significatives sur la logique du traitement.

Sur la base de ces droits, Worker Info Exchange a été mis en place avec pour mission d'aider les travailleurs du concert à naviguer dans cet espace complexe et sous-régulé. L'objectif et la mission de notre travail sont de tester si ces instruments GDPR peuvent être utilisés pour lutter contre les pratiques d'emploi déloyales et étendre la portée des données mises à la disposition des individus en leur qualité de travailleurs. En d'autres termes, notre ambition est d'utiliser l'accès aux données comme méthode de renforcement du pouvoir collectif des travailleurs pour tester les mécanismes de recours dans un marché du travail à médiation numérique.

Lorsque la relation de travail entre la plate-forme de concert et le travailleur est exécutée par le biais d'une collecte et d'une analyse approfondies des données, les droits du travail deviennent inextricablement liés à l'exercice des droits sur les données. Les plateformes de concerts assurent le contrôle des travailleurs en maintenant une asymétrie informationnelle, et l'accès aux données peut fournir un moyen d'exposer le (dés)équilibre de pouvoir généré par le fossé informationnel entre les plateformes de concerts et leurs travailleurs. L'accès aux données personnelles peut permettre aux travailleurs de faire des évaluations indépendantes de leurs conditions de travail et de répondre à des questions concernant leurs calculs de rémunération, la qualité et la quantité de travail offert, ainsi que de contester les motifs d'une mauvaise gestion des performances, y compris la suspension et congédiement.

Notre objectif en facilitant l'accès aux données est de créer des réserves collectives de données pour développer une meilleure compréhension des conditions de travail et, par conséquent, du pouvoir de négociation. Ces dernières années, un certain nombre d'initiatives remarquables ont vu le jour, fonctionnant avec des objectifs similaires mais utilisant des méthodologies différentes pour récupérer les données. Certains projets dans ce domaine gèrent leur propre collecte de données et analyses sur les revenus et les performances pour évaluer l'équité des conditions de travail (par exemple, Driver's Seat Coop et WeClock, entre autres.) Ceux-ci présentent tous des informations uniques sur l'économie des petits boulots et devraient être considérés comme constituant un continuum de pratique des données. Nous avons abordé ce problème en exigeant que les plateformes partagent les données auxquelles les travailleurs ont légalement droit, mais cela a introduit des obstacles supplémentaires à l'objectif plus large de collecte des données. Nous avons choisi cette voie parce que nous souhaitions établir des normes et des précédents dans le droit de la protection des données, mais aussi parce que nous pensons qu'il existe certains types d'informations qui ne peuvent être obtenus qu'en demandant les données directement aux plateformes.

Nous avons constaté, notamment dans le cas d'allégations d'activités irrégulières et de fraudes alimentées par la surveillance, qu'il est nécessaire de disposer des données détenues par les entreprises pour comprendre et contester les accusations. L'accès aux données peut nous aider à déceler les incohérences dans les récits avancés par les sociétés de plateformes et à déplacer la charge de la preuve des travailleurs vers les plateformes. De ce point de vue, l'effort d'exiger des données de plate-forme s'est avéré extrêmement efficace pour résoudre de nombreux conflits du travail. La simple démonstration du refus des plateformes de fournir des données personnelles a annulé plusieurs révocations de licence (appliquées par TfL) en justice et est ainsi devenue un outil supplémentaire dans l'exercice des droits du travail.

Ceci constitue l'autre branche d'activité de Worker Info Exchange ; comme nous sommes frustrés dans nos tentatives pour gagner en clarté et en transparence sur les systèmes complexes déterminant les conditions de travail, nous devons fréquemment recourir à des litiges et nous tourner vers les tribunaux pour obtenir des décisions dans le domaine émergent des droits du travail numériques. La «crise des données» artificielle que les plateformes de concerts ont créée est à bien des égards une tentative d'épuiser et d'épuiser les ressources des travailleurs précaires et des syndicats en attirant les litiges devant les tribunaux où ils peuvent être prolongés et la responsabilité pour faute professionnelle retardée.

En lien avec ces axes d'activité, ce rapport est rédigé en trois parties : La première section explore différentes facettes de la gestion algorithmique et ses méfaits, avec des études de cas associées. La deuxième section traite de notre processus d'utilisation des demandes d'accès aux personnes concernées (DSAR), tandis que la troisième offre un aperçu des cas liés au RGPD que nous avons traités à Amsterdam ainsi que des cas de licence que nous soutenons à Londres. Ce rapport conclut une période de travail portant sur ces fonctions de notre organisation, réalisée avec le soutien de la Fondation Mozilla, du Digital Freedom Fund et des Open Society Foundations. Nous espérons que ce rapport démontrera l'état actuel de l'exercice des droits à l'intersection des données et du travail et révélera les effets cumulatifs du non-respect répété des plateformes de concerts.

"Les entreprises de plates-formes opèrent dans un espace de non-droit où elles croient pouvoir établir les règles. Malheureusement, ce n'est pas un jeu ; les réalités virtuelles ont de graves conséquences pour les travailleurs des concerts dans la vie réelle. Ce qui est encourageant, c'est que les travailleurs eux-mêmes n'attendent pas les lois, les décideurs politiques ou même les alliés du mouvement des droits de l'homme pour les sauver. Les travailleurs du concert s'organisent et utilisent leur voix collective pour exiger de nouvelles protections adaptées à l'objectif d'une économie numérisée.

Bama Athreya, Fellow, Open Society Foundations

Partie I : Mauvaise classification 2.0 Contrôlé par algorithme

Au cours de la bataille de six ans pour les droits des travailleurs dans l'économie des concerts au Royaume-Uni, Uber a fait valoir qu'il s'agissait simplement de l'agent du chauffeur indépendant ne faisant rien de plus que de réserver passivement des ordres de travail et de percevoir les paiements. Pour faire avancer cette fiction, les plateformes de concerts ont mis en place des contrats élaborés qui donnent l'impression que le conducteur et le passager traitent directement les uns avec les autres, alors qu'en fait toutes les informations sur les passagers sont étroitement protégées par les entreprises. Uber, par exemple, génère une facture fictive au nom du conducteur pour chaque passager qu'il transporte. La facture ne citera que le prénom du passager et n'est jamais réellement envoyée au client.

Ces techniques de classification erronée, couramment utilisées dans l'économie des petits boulots, permettent aux plateformes d'éviter les responsabilités légales des employeurs telles que les protections fondamentales des droits des travailleurs et les cotisations d'assurance nationale. Au Royaume-Uni, cela a également permis aux sociétés de plateformes d'éviter la taxe sur la valeur ajoutée (TVA). Mais plus tôt cette année, la Cour suprême a affirmé le droit des juridictions inférieures d'écarter les contrats artificiels et de déterminer la véritable nature de la relation de travail sur la base de la preuve d'une relation de gestion de contrôle sur les travailleurs.

Alors que les sociétés de plateforme concluent que l'utilisation de contrats trompeurs n'est plus viable comme méthode de classification erronée de l'emploi, elles seront tentées de doubler l'automatisation des processus pour dissimuler le contrôle de gestion. Le contrôle algorithmique devient une erreur de classification 2.0. En effet, il existe de nombreuses preuves que cela se produit déjà. Les plateformes de concerts sont plus déterminées que jamais à poursuivre des stratégies de classification erronée afin de pouvoir continuer à contrôler la main-d'œuvre tout en évitant le risque que les conducteurs passent du statut de « travailleur » avec des droits limités au statut d'employé avec beaucoup plus de droits.

Alors, qu'est-ce que le contrôle algorithmique et quels sont les risques spécifiques pour les travailleurs des concerts ? Dans les secteurs du covoiturage et de la livraison en particulier, les moyens de gestion algorithmique qui nous préoccupent le plus sont les suivants :

Surveillance. Surveillance intrusive dans le but déclaré de sécurité et d'identification. Cela englobe l'utilisation de technologies de détection des fraudes et de reconnaissance faciale. Nous sommes conscients que la surveillance est effectuée même lorsque le travailleur ne s'est pas connecté pour se rendre disponible pour le travail. Cela comprenait également la surveillance de l'utilisation de l'application par le travailleur en tant que consommateur.

Gestion des performances. Cela inclut, mais sans s'y limiter, la surveillance du comportement de conduite, y compris l'ETA, les évaluations des clients, les taux d'acceptation et d'achèvement des travaux, l'interaction avec le personnel d'assistance, la disponibilité.

Attribution du travail. Uber a jusqu'à très récemment insisté sur le fait que la répartition du travail est décidée en fonction de la proximité des conducteurs et des passagers les uns par rapport aux autres, mais admet maintenant que les comportements et préférences passés sont pris en compte. sont utilisés dans la prise de décision automatisée de répartition du travail.

Prix. La prise de décision automatisée en matière de tarification est étroitement liée à la répartition du travail. La méthode la plus connue est peut-être la « surge » ou la « tarification dynamique » d'Uber qui vise à clarifier la demande du marché avec des fluctuations de prix locales en temps réel.

Les décisions de gestion ci-dessus sont pour la plupart automatisées ou semi-automatisées avec une intervention humaine limitée. Les modèles commerciaux de l'économie des petits boulots reposent sur l'automatisation de masse des décisions de gestion et la supervision du lieu de travail. Alors que certains employeurs sont réticents sur ce point, Deliveroo l'a été assez franchement dans sa politique de confidentialité des cavaliers :

« Compte tenu du volume de livraisons que nous traitons, nous utilisons des systèmes automatisés pour prendre les décisions automatisées décrites ci-dessus, car ils fournissent un moyen plus précis, juste et efficace d'identifier les fraudes présumées, de prévenir les violations répétées de votre accord de fournisseur et de limiter l'impact négatif sur notre service. Les contrôles humains ne seraient tout simplement pas possibles dans les délais et compte tenu des volumes de livraisons que nous traitons. »

Gestion des performances

Cela inclut, mais sans s'y limiter, la surveillance du comportement de conduite, y compris l'ETA, les évaluations des clients, les taux d'acceptation et d'achèvement des travaux, l'interaction avec le personnel d'assistance, la disponibilité.

Tarification

La prise de décision automatisée en matière de tarification est étroitement liée à la répartition du travail. La méthode la plus connue est peut-être la soi-disant « surtension » ou « tarification dynamique » d'Uber, qui vise à répondre à la demande du marché avec des fluctuations de prix locales en temps réel.

Surveillance

Surveillance intrusive dans le but déclaré de sécurité et d'identification. Cela englobe l'utilisation de technologies de détection des fraudes et de reconnaissance faciale. Nous sommes conscients que la surveillance est effectuée même lorsque le travailleur ne s'est pas connecté pour se rendre disponible pour le travail. Cela comprenait également la surveillance de l'utilisation de l'application par le travailleur en tant que consommateur.

Répartition du travail

Uber a jusqu'à très récemment insisté sur le fait que la répartition du travail est décidée en fonction de la proximité des conducteurs et des passagers les uns par rapport aux autres, mais admet maintenant que le comportement et les préférences passés sont pris en compte. sont utilisés dans la prise de décision automatisée de répartition du travail.

Partie I : Mauvaise classification 2.0 Contrôlé par algorithme

Au cours de la bataille de six ans pour les droits des travailleurs dans l'économie des concerts au Royaume-Uni, Uber a fait valoir qu'il s'agissait simplement de l'agent du chauffeur indépendant ne faisant rien de plus que de réserver passivement des ordres de travail et de percevoir les paiements. Pour faire avancer cette fiction, les plateformes de concerts ont mis en place des contrats élaborés qui donnent l'impression que le conducteur et le passager traitent directement les uns avec les autres, alors qu'en fait toutes les informations sur les passagers sont étroitement protégées par les entreprises. Uber, par exemple, génère une facture fictive au nom du conducteur pour chaque passager qu'il transporte. La facture ne citera que le prénom du passager et n'est jamais réellement envoyée au client.

Ces techniques de classification erronée, couramment utilisées dans l'économie des petits boulots, permettent aux plateformes d'éviter les responsabilités légales des employeurs telles que les protections fondamentales des droits des travailleurs et les cotisations d'assurance nationale. Au Royaume-Uni, cela a également permis aux sociétés de plateformes d'éviter la taxe sur la valeur ajoutée (TVA). Mais plus tôt cette année, la Cour suprême a affirmé le droit des juridictions inférieures d'écarter les contrats artificiels et de déterminer la véritable nature de la relation de travail sur la base de la preuve d'une relation de gestion de contrôle sur les travailleurs.

Alors que les sociétés de plateforme concluent que l'utilisation de contrats trompeurs n'est plus viable comme méthode de classification erronée de l'emploi, elles seront tentées de doubler l'automatisation des processus pour dissimuler le contrôle de gestion. Le contrôle algorithmique devient une erreur de classification 2.0. En effet, il existe de nombreuses preuves que cela se produit déjà. Les plateformes de concerts sont plus déterminées que jamais à poursuivre des stratégies de classification erronée afin de pouvoir continuer à contrôler la main-d'œuvre tout en évitant le risque que les conducteurs passent du statut de « travailleur » avec des droits limités au statut d'employé avec beaucoup plus de droits.

Alors, qu'est-ce que le contrôle algorithmique et quels sont les risques spécifiques pour les travailleurs des concerts ? Dans les secteurs du covoiturage et de la livraison en particulier, les moyens de gestion algorithmique qui nous préoccupent le plus sont les suivants :

Surveillance. Surveillance intrusive dans le but déclaré de sécurité et d'identification. Cela englobe l'utilisation de technologies de détection des fraudes et de reconnaissance faciale. Nous sommes conscients que la surveillance est effectuée même lorsque le travailleur ne s'est pas connecté pour se rendre disponible pour le travail. Cela comprenait également la surveillance de l'utilisation de l'application par le travailleur en tant que consommateur.

Gestion des performances. Cela inclut, mais sans s'y limiter, la surveillance du comportement de conduite, y compris l'ETA, les évaluations des clients, les taux d'acceptation et d'achèvement des travaux, l'interaction avec le personnel d'assistance, la disponibilité.

Attribution du travail. Uber a jusqu'à très récemment insisté sur le fait que la répartition du travail est décidée en fonction de la proximité des conducteurs et des passagers les uns par rapport aux autres, mais admet maintenant que les comportements et préférences passés sont pris en compte. sont utilisés dans la prise de décision automatisée de répartition du travail.

Prix. La prise de décision automatisée en matière de tarification est étroitement liée à la répartition du travail. La méthode la plus connue est peut-être la « surge » ou la « tarification dynamique » d'Uber qui vise à clarifier la demande du marché avec des fluctuations de prix locales en temps réel.

Les décisions de gestion ci-dessus sont pour la plupart automatisées ou semi-automatisées avec une intervention humaine limitée. Les modèles commerciaux de l'économie des petits boulots reposent sur l'automatisation de masse des décisions de gestion et la supervision du lieu de travail. Alors que certains employeurs sont réticents sur ce point, Deliveroo l'a été assez franchement dans sa politique de confidentialité des cavaliers :

« Compte tenu du volume de livraisons que nous traitons, nous utilisons des systèmes automatisés pour prendre les décisions automatisées décrites ci-dessus, car ils fournissent un moyen plus précis, juste et efficace d'identifier les fraudes présumées, de prévenir les violations répétées de votre accord de fournisseur et de limiter l'impact négatif sur notre service. Les contrôles humains ne seraient tout simplement pas possibles dans les délais et compte tenu des volumes de livraisons que nous traitons. »

"Compte tenu du volume de livraisons que nous traitons, nous utilisons des systèmes automatisés pour prendre les décisions automatisées décrites ci-dessus, car ils fournissent un moyen plus précis, juste et efficace d'identifier les fraudes présumées, d'empêcher les violations répétées de votre accord de fournisseur et de limiter l'impact négatif sur notre service. Les contrôles humains ne seraient tout simplement pas possibles dans les délais et compte tenu des volumes de livraisons que nous traitons.

Surveillance

Surveillance intrusive dans le but déclaré de sécurité et d'identification. Cela englobe l'utilisation de technologies de détection des fraudes et de reconnaissance faciale. Nous sommes conscients que la surveillance est effectuée même lorsque le travailleur ne s'est pas connecté pour se rendre disponible pour le travail. Cela inclut également la surveillance de l'utilisation de l'application par le travailleur en tant que consommateur.

Répartition du travail

Uber a jusqu'à très récemment insisté sur le fait que l'attribution du travail est décidée en fonction de la proximité des chauffeurs et des passagers les uns par rapport aux autres, mais déclare maintenant que le comportement et les préférences passés sont pris en compte. Ola utilise des profils de chauffeur qui incluent des « scores de probabilité de fraude » dans la prise de décision automatisée pour le travail. allocation.

Gestion des performances

L'évaluation des performances au travail comprend, mais sans s'y limiter, la surveillance du comportement de conduite, y compris l'ETA, les évaluations des clients, les taux d'acceptation et d'achèvement des travaux, l'interaction avec le personnel d'assistance, la disponibilité.

Tarification

La fixation automatisée des prix est étroitement liée à la répartition du travail. La méthode la plus connue est peut-être la soi-disant « surtension » ou « tarification dynamique » d'Uber, qui vise à répondre à la demande du marché avec des fluctuations de prix locales en temps réel.

Course aux armements de surveillance

Nous assistons à une course aux armements de surveillance dans l'économie des petits boulots depuis qu'Uber a introduit son soi-disant système d' identification en temps réel hybride en 2020. Juste un jour avant que Transport for London (TfL) n'annonce sa décision de refuser le renouvellement de leur licence en novembre 2019, Uber a proposé d'introduire ce système de surveillance qui intègre la reconnaissance faciale avec surveillance GPS.

C'était en réponse à la plainte de TfL selon laquelle 21 conducteurs avaient été détectés (sur 90 000 analysés sur plusieurs années) comme participant au partage de compte, ce qui permettait à des conducteurs potentiellement sans licence et non assurés d'offrir illégalement leurs services sur l'application. L'activité a été rendue possible en réinitialisant la position GPS de l'appareil en dehors du Royaume-Uni, où il est possible pour les conducteurs de télécharger leurs propres photos. Cet écart a été rapidement comblé par Uber et l'activité détectée était extrêmement faible par rapport à l'ampleur des opérations d'Uber. L'introduction de la technologie de reconnaissance faciale par l'industrie a été tout à fait disproportionnée par rapport au risque perçu. Néanmoins, l'exigence d'une identification en temps réel est devenue une condition du renouvellement de la licence d'Uber devant le tribunal de première instance de Westminster en septembre 2020.

Dans le cas d'Uber, la direction de la plate-forme et TfL n'ont pas veillé à ce que des garanties appropriées soient mises en place pour protéger les droits et libertés des conducteurs, bien que TfL ait examiné l'évaluation d'impact sur la protection des données pour la technologie en mars 2020. Nous avons fait un demande de liberté d'information à TfL d'avoir accès à la DPIA d'Uber pour les systèmes d'identification en temps réel, mais nous avons été refusés. Selon les rapports de TfL , 94% des conducteurs de véhicules de location privés (PHV) sont issus de minorités noires et ethniques et l'introduction de cette technologie, qui est bien connue pour ses faibles taux de précision au sein de ces groupes , s'est avérée désastreuse pour les travailleurs vulnérables déjà en emploi précaire.

Bolt a depuis annoncé qu'il investissait 150 millions d'euros dans des systèmes de détection anti-fraude des conducteurs d'IA, y compris la reconnaissance faciale. Deliveroo a annoncé qu'eux aussi introduiraient des contrôles d'identité par reconnaissance faciale. Ola Cabs a également déployé l' identification par reconnaissance faciale en tant que caractéristique de son système Guardian , intégrant l'apprentissage automatique qui, selon eux, leur permet « d'apprendre et d'évoluer en continu à partir de millions de points de données chaque jour, pour améliorer la signalisation des risques et la résolution instantanée ».

FreeNow, une coentreprise de Daimler et BMW, surveille également de près les conducteurs dans le cadre de leur programme de prévention de la fraude. En effet, les documents déposés par FreeNow auprès de la Haute Cour dans le cadre d'un examen judiciaire de la décision de TfL de leur accorder une licence à Londres, révélaient que TfL avait établi des rapports mensuels sur les licenciements de conducteurs pour diverses raisons (y compris « activités frauduleuses ») une condition de leur récent renouvellement de licence. Mais la description des données traitées à des fins de prévention de la fraude soulève plus de questions que la politique de confidentialité de FreeNow ne répond.

Dans ce document, Free Now déclare qu'ils utilisent un algorithme de « forêt aléatoire » pour produire un score de fraude qu'ils utilisent pour « prioriser les trajets expédiés en conséquence ». Cela garantit une expédition juste et minimisant les risques . Free Now a contesté leur utilisation de ce système de détection de fraude lorsque nous nous sommes renseignés à ce sujet en juin 2021, affirmant que cette section de la politique de confidentialité était obsolète (veuillez consulter l'étude de cas de l'entreprise dans la section II du rapport.) Cependant, la description de ce système est resté dans la politique, malgré une mise à jour effectuée en septembre 2021.

Ce qui est particulièrement préoccupant dans l'utilisation de ces systèmes, c'est qu'ils confondent gestion de la fraude et gestion de la performance. Le fait que de tels indicateurs de « fraude » soient utilisés comme variables pour l'attribution du travail et que les comportements qui les génèrent soient autorisés à se poursuivre sur la plate-forme démontre qu'il ne s'agit pas d'exemples de fraude pénale, mais de mécanismes de contrôle, qui évaluent les performances des travailleurs contre les mesures opaques fixées par les entreprises. Nous suggérons que toute terminologie de « fraude » utilisée dans ces contextes fonctionne également dans le cadre du jeu de classification erronée, conçu pour dissimuler la relation de travail.

Étude de cas de surveillance I : Échec de la reconnaissance faciale

En avril 2020, Uber a introduit un système de vérification d'identité en temps réel (RTID) au Royaume-Uni qui utilise une combinaison comprenant la reconnaissance faciale et la vérification de l'emplacement pour authentifier l'identité d'un conducteur et tenter d'empêcher les conducteurs de partager l'accès à leur compte pour le travail.

Le système RTID intègre l'utilisation de l'API FACE de Microsoft, du logiciel de reconnaissance faciale et oblige les chauffeurs et les coursiers à prendre régulièrement des selfies en temps réel pour continuer à utiliser l'application Uber. La photo est ensuite comparée à la photo de profil du compte du conducteur (et dans certaines juridictions, à des bases de données publiques pour « empêcher l'emprunt d'identité ou pour vérifier l'identité des utilisateurs » .)

Pa Edrissa Manjang travaillait avec Uber depuis environ un an lorsqu'il a été désactivé en raison d'un échec de vérification de selfie. Bien que les chauffeurs et coursiers d'Uber fournissent régulièrement des selfies, ceux-ci ne sont pas stockés sur les téléphones des travailleurs et ils ne peuvent pas conserver les preuves de leurs soumissions. Pa n'a reçu aucun avertissement ni aucun problème jusqu'à son licenciement ; le système de vérification d'identité en temps réel semblait approuver toutes ses photographies avec une coche verte.

Après son licenciement, Pa a envoyé de nombreux messages à Uber pour rectifier le problème, demandant spécifiquement à un humain de revoir ses soumissions. Chaque fois que Pa s'est fait dire « nous n'avons pas été en mesure de confirmer que les photos fournies étaient bien de vous et, en raison des incohérences persistantes, nous avons pris la décision finale de mettre fin à notre partenariat avec vous ». Nous avons obtenu les selfies en question via une demande d'accès au sujet, qui a révélé que toutes les photos soumises par Pa étaient en fait de lui. Ce fut le premier cas où nous avons réussi à obtenir les selfies soumis par un coursier ou un chauffeur. On ne sait pas pourquoi cette demande a réussi alors que beaucoup avant elle a échoué.

Nous avons également écrit à Microsoft plus tôt dans l'année pour faire part de nos préoccupations concernant l'utilisation non réglementée de l'API FACE par Uber sur sa plate-forme. En réponse , Microsoft a souligné que toutes les parties impliquées dans le déploiement de telles technologies ont des responsabilités qui incluent : « intégrer un examen humain significatif pour détecter et résoudre les cas d'identification erronée ou d'autres défaillances » et « apporter un soutien aux personnes qui pensent que leurs résultats sont incorrects ; et identifier et traiter les fluctuations de précision dues à la variation des conditions ». Le cas de Pa démontre clairement que ces contrôles cruciaux n'ont pas été mis en œuvre dans le traitement des images RTID.

Pa porte maintenant plainte contre Uber pour contester son déploiement de reconnaissance faciale racialement discriminatoire, représenté par Bates Wells, avec le soutien de la Commission pour l'égalité et les droits de l'homme, l'App Drivers and Couriers Union et Worker Info Exchange.

INTÉGRER : la vidéo de Papa

Étude de cas de surveillance II : Vérifications de la géolocalisation

Bien que l'utilisation de systèmes de reconnaissance faciale défectueux soit sans aucun doute problématique, nous avons également vu de nombreux conducteurs licenciés après de fausses accusations d'Uber selon lesquelles ils se livraient à un partage de compte frauduleux après que deux appareils aient été détectés par Uber à deux endroits en même temps. Dans tous les cas que nous avons analysés, nous avons constaté que le problème est lié au pilote ayant installé l'application sur deux appareils pour plus de commodité, mais avec un seul des appareils connecté pour le travail.

Juste avant 20 heures le 11 septembre 2020 et Aweso Mowlana travaillait pour Uber dans le sud de Londres. Il était un chauffeur classé 4,95 étoiles qui avait effectué plus de 11 500 trajets en plus de 5 ans en travaillant pour Uber. Aweso venait de déposer un passager près d'Elephant and Castle lorsqu'il s'est déconnecté pour une courte pause. Comme de nombreux pilotes, Aweso avait installé l'application sur un deuxième appareil qui était un iPhone. Ce soir-là, il avait quitté la maison de l'iPhone et travaillait avec son autre téléphone, un Samsung.

À 20 h 02, Aweso a tenté de se reconnecter à l'application Uber pour se rendre disponible pour son prochain emploi. Avant d'être autorisé à se reconnecter, il a été invité à fournir un selfie dans le cadre du contrôle d'identité en temps réel (RTID) d'Uber. Sa photo correspondait à la photo de référence d'Uber, il a donc terminé avec succès la procédure de connexion pour continuer son quart de travail. Mais à son insu, les systèmes Uber avaient détecté et/ou envoyé un ping à son deuxième téléphone. Son fils avait pris son deuxième téléphone par erreur et l'avait emporté avec lui chez sa petite amie à Uxbridge. Uber a déclaré plus tard avoir demandé un contrôle RTID à cet appareil à 20 h 03, mais à ce moment-là, Aweso était déjà en ligne dans le sud de Londres. Uber affirme que la réponse à la vérification d'identité a été envoyée depuis l'iPhone vers 23h55 ce soir-là.

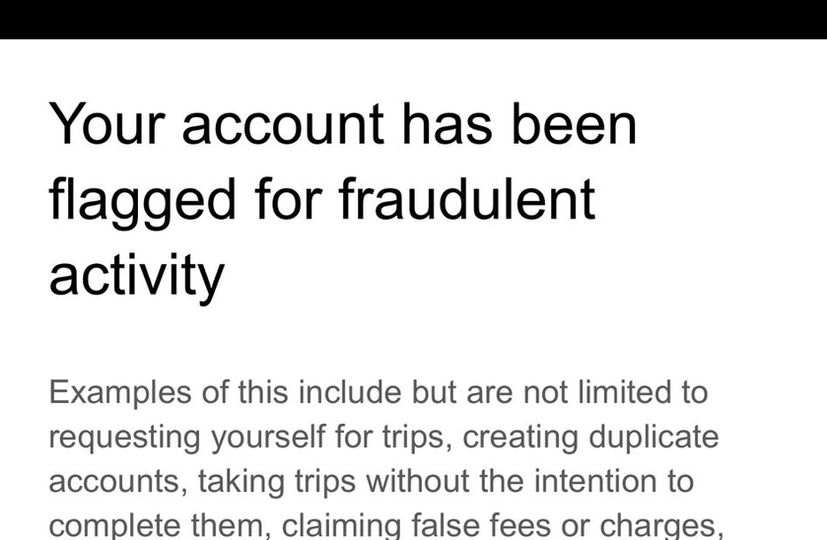

Le lendemain, Uber l'a informé que son compte avait été "signalé pour activité d'application suspecte" et que son compte serait désormais suspendu le temps qu'"une équipe spécialisée l'examine". Quelque temps plus tard, Uber a définitivement licencié Aweso par SMS disant qu'ils avaient "trouvé des preuves indiquant une activité frauduleuse" sur son compte. Uber a ensuite allégué qu'il partageait l'accès à son compte et, ce faisant, avait enfreint les termes et conditions. Le mois suivant, Transport for London a immédiatement révoqué la licence d'Aweso au motif qu'il ne pouvait plus être jugé «apte et apte» à détenir une licence publique en raison de son licenciement d'Uber.

Worker Info Exchange a aidé Aweso à faire une demande d'accès par sujet et à analyser les données reçues. Un fichier appelé « Données détaillées de l'appareil D river » enregistre au moins une partie des données en streaming des appareils vers Uber en temps réel. La propre politique de confidentialité d' Uber indique que lorsqu'un appareil a l'application ouverte en arrière-plan ou au premier plan, même s'il n'est pas en ligne et prêt à accepter les tarifs. Dans plus d'une douzaine de cas où nous avons soutenu l'appel des conducteurs contre leurs révocations devant la Magistrates Court, chaque appel a été confirmé et TfL a reçu l'ordre de rétablir les permis. À partir de ce fichier, nous avons pu voir jusqu'à 230 lignes de données par minute enregistrées par Uber à partir d'appareils. Les données Uber collectées à partir des appareils d'Aweso sont incluses géolocalisation, niveau de batterie, vitesse, cap du parcours, numéro IMEI, etc.

Les données ont montré que l'appareil à Uxbridge n'avait jamais été connecté pour travailler ce jour-là, car un champ intitulé « driver_online » montrait l'iPhone comme « FALSE » à tout moment ce jour-là, y compris l'heure à laquelle il a été enregistré à Uxbridge. C'est la preuve que l'appareil n'était pas partagé pour travailler avec d'autres, comme le prétendent Uber et Transport for London. Uber n'a pas fourni l'accès aux données personnelles traitées dans les deux contrôles RTID, y compris les photos collectées. Les « données détaillées de l'appareil » n'indiquent aucune autre activité pour l'iPhone après 20 h 03 min 43 s. Nous n'avons vu aucune preuve de données d'activité de l'appareil à 23 h 55 lorsque Uber a déclaré avoir reçu une réponse au contrôle d'identité émis précédemment.

L'expérience de Pa et Aweso a été très répandue au cours de l'année écoulée et a constitué un volume important de dossiers traités par Worker Info Exchange et l'App Drivers & Couriers Union. À Londres, Transport for London avait tendance à révoquer immédiatement les permis des conducteurs qui auraient échoué aux contrôles RTID d'Uber malgré les problèmes évidents avec le système. Il existe souvent des explications raisonnables à l'utilisation de plusieurs appareils, qui sont automatiquement classées comme fraude. La propre politique de confidentialité d' Uber indique que lorsqu'un appareil a l'application ouverte en arrière-plan ou au premier plan, même s'il n'est pas en ligne et prêt à accepter les tarifs. Dans plus d'une douzaine de cas où nous avons soutenu l'appel des conducteurs contre leurs révocations devant la Magistrates Court, chaque appel a été confirmé et TfL a reçu l'ordre de rétablir les permis.

Worker Info Exchange, Big Brother Watch et l'App Drivers & Couriers Union ont écrit une lettre conjointe au maire de Londres pour faire part de nos inquiétudes quant à la confiance que Transport for London s'est fondée sur des preuves erronées d'Uber pour prendre une décision de révocation et ont exigé que, en tant que président de Transport pour le conseil d'administration de Londres, qu'il ordonne un examen de toutes ces révocations injustifiées. À ce jour, ni le maire ni TfL n'ont répondu.

Gestion des performances opaques

L'opacité des entreprises de plate-forme empêche les travailleurs de comprendre comment le contrôle algorithmique peut être intégré sur l'ensemble des processus critiques et dans le temps. Par exemple, les travailleurs n'ont pas bénéficié de la transparence à laquelle ils ont légalement droit afin de comprendre comment le profilage des performances est lié à la qualité et à la quantité du travail offert ainsi qu'aux rendements attendus pour un tel travail.

Dans le cas d'Ola, nous avons une certaine connaissance des catégories de données qu'ils collectent et traitent dans leurs systèmes d'attribution du travail - telles que les scores de probabilité de fraude, le profil de rémunération, l'historique d'acceptation et d'annulation des réservations, entre autres - mais cela ne révèle pas les différentes pondérations. appliqué à ces variables, ni la logique de traitement.

Uber a longtemps soutenu que son système de correspondance est uniquement déterminé par l'emplacement, bien que sa propre interface « Partenaire-Chauffeur » suggère le contraire. Le programme Pro d'Uber (auquel les conducteurs sont automatiquement inscrits afin qu'ils puissent être incités à atteindre les objectifs de performance en échange d'avantages et de récompenses) informe les conducteurs dans un langage vague que « des taux de confirmation plus élevés signifient des temps d'attente plus courts pour les clients et des temps de prise en charge plus courts pour tous conducteurs » faisant vaguement allusion au fait que la baisse des emplois entraînera une diminution des offres d'emploi.

Uber n'a que récemment offert plus de transparence sur le système de correspondance grâce à une mise à jour de sa politique de confidentialité qui stipule que « les utilisateurs peuvent être jumelés en fonction de la disponibilité, de la proximité et d'autres facteurs tels que la probabilité d'accepter un voyage en fonction de leur comportement ou de leurs préférences passés » mais, au moment de la rédaction, le lien offrant des informations complémentaires sur le système d'appariement est rompu, attestant du caractère évolutif de ces traitements de données. Une récente demande d'accès à l'information que nous avons adressée à TfL, demandant quelles mises à jour Uber avait fournies sur son système de correspondance (comme il est obligé de le faire lors de la modification de son modèle de fonctionnement) n'a donné aucun résultat, soulignant davantage l'obscurcissement de ses pratiques de gestion algorithmique. et l'absence de surveillance réglementaire.

Les récentes révélations sur les variables déterminant la répartition du travail soulèvent également d'importantes questions sur la qualité des emplois offerts aux conducteurs. Les chauffeurs ayant des taux d'acceptation d'emploi élevés se voient-ils proposer des trajets plus longs et plus longs, entraînant une rémunération plus élevée, sur la base d'un profilage similaire ? Ou, pour aller plus loin, les chauffeurs proposent-ils des tarifs différents via le système de tarification dynamique ? En effet, savoir si et comment la tarification algorithmique est associée à l'allocation du travail est une question sensible dont on sait encore peu de choses.

Ces dernières années, Uber a remplacé la tarification variable en fonction du temps et de la distance pour les clients par un modèle de tarification fixe dans lequel un prix initial est accepté au début d'un voyage. Uber déclare que "la tarification initiale est dynamique, ce qui signifie que le prix est calculé en temps réel pour aider à équilibrer l'offre et la demande". Plus récemment, des chauffeurs ont déclaré se voir offrir des tarifs très bas pour des emplois individuels. Il y a ici une opportunité évidente pour Uber d'augmenter sa part du tarif éventuel payé par les passagers. Des inquiétudes ont été exprimées concernant les résultats discriminatoires de l'utilisation de ces systèmes de tarification dynamique sur les passagers, ce qui introduit la perspective que les conducteurs pourraient également être soumis à une tarification personnalisée en temps réel. Il y a ici de sérieux problèmes éthiques si les opérateurs proposent des prix inférieurs aux travailleurs vulnérables sur la base d'un profilage qui prédit leur volonté d'accepter un travail à différents niveaux de prix.

Au Royaume-Uni, de telles pratiques semblent aller à l'encontre des dispositions de l' article 1 de l'Employment Rights Act qui autorise les travailleurs à recevoir de leur employeur une déclaration claire des conditions de leur travail, y compris les taux de rémunération.

Étude de cas : contrôle algorithmique

Uber envoie régulièrement des messages aux conducteurs lorsqu'ils sont signalés par ses systèmes de détection de fraude pour les avertir qu'ils peuvent perdre leur emploi s'ils continuent le comportement qui déclenche le système. Les messages contiennent une liste non exhaustive des déclencheurs potentiels, mais ne fournissent pas de raison spécifique au conducteur individuel accusé de fraude. Lorsque Alexandru a reçu le deuxième et dernier de ces messages, sachant qu'un autre drapeau entraînerait le licenciement, il a décidé d'appeler l'équipe d'assistance aux conducteurs pour obtenir plus de détails sur les raisons pour lesquelles il déclenchait le système anti-fraude et ce qu'il pouvait faire pour l'éviter. . Au cours de l'appel , Alexandru et l'agent d'assistance ont discuté de diverses situations qui peuvent avoir fait que ses déplacements semblent irréguliers, révélant la capacité limitée des équipes d'assistance à déchiffrer les indications fournies par le système. Trois mois après cet appel, Uber a envoyé un message d'excuses indiquant qu'il avait reçu les avertissements par erreur.

Alors que la conversation est instructive en termes de compréhension des dilemmes auxquels sont confrontés les conducteurs lorsque la politique de l'entreprise et les demandes des passagers divergent, nous avons été particulièrement intéressés par la discussion (25 minutes après le début de l'appel) concernant un détour qu'Alexandru a pris en raison de travaux routiers, ainsi que son faible taux d'acceptation de l'emploi comme causes potentielles de sa détection par le système anti-fraude. À la suite de la décision de la Cour suprême qui a classé les chauffeurs d'Uber comme des travailleurs plus tôt cette année, Uber a affirmé avoir apporté des modifications importantes à sa plate-forme, telles que la transparence des prix et de la destination, ainsi que la suppression des mesures punitives pour refus d'emploi, dans le but de faire valoir que la décision de la Cour suprême ne s'appliquait pas aux conducteurs Uber actuels.

L'expérience d'Alexandru sur la plate-forme va à l'encontre de ce récit, car il devient évident qu'il est probablement signalé pour s'être écarté de l'itinéraire (malgré le fait qu'Uber utilise désormais un modèle de prix fixe, ce qui signifie que les conducteurs effectuent de tels changements d'itinéraire à leurs propres frais) et n'acceptant pas assez le travail qui lui est proposé sur la plateforme. Cet appel montre indéniablement qu'en pratique, les chauffeurs sont toujours aussi étroitement contrôlés par Uber qu'avant.

En plus de ces pratiques de gestion, le programme Pro mentionné ci-dessus est un autre outil qu'Uber utilise pour exercer un contrôle sur ses effectifs, tout en se soustrayant aux obligations légales qui peuvent être associées à un tel contrôle. Par exemple, en liant certaines récompenses résultant du maintien d'une note élevée à des sociétés tierces ou en présentant la participation aux avantages tarifaires comme purement facultative par le biais d'un coup de pouce comportemental, Uber crée l'illusion de laisser les chauffeurs opérer en toute indépendance et flexibilité. L'engagement volontaire supposé des conducteurs dans ces programmes se traduit par l'abandon des droits résultant d'une relation de travail.

INTÉGRER : la vidéo d'Alexandru

Expansion de l'infrastructure d'application de la loi

Il est également prouvé que les plateformes sont devenues de plus en plus une source de renseignements attrayante pour les services de police et de sécurité. Dans une déclaration de témoin présentée en preuve en septembre 2020 lors de l'appel de licence d'Uber devant le tribunal de première instance de Westminster, le directeur général d'Uber pour le Royaume-Uni et l'Europe occidentale, Jamie Heywood, a attesté d'une relation de plus en plus étroite avec la police et les services de sécurité. Il s'agit notamment du National Counter Terrorism Policing Network, du SO15 - le Counter Terrorism Command of the Metropolitan Police Service, du National Police Chiefs Council (NPCC), du College of Policing, de la National Crime Agency et de la British Transport Police. L'un des domaines de coopération a été le problème du transport de drogue sur les lignes de comté. Citant l'inspecteur-détective Stuart Liddell du NPCC, Heywood a témoigné d'une relation mature basée sur des niveaux sophistiqués de partage de renseignements :

"Je suis encouragé par l'engagement affiché par Uber à ce sujet et d'autres travaux sont prévus [en 2020] pour s'appuyer sur les travaux réalisés jusqu'à présent. Cela se concentrera sur des aspects plus complexes des lignes de comté, le flux d'informations et de renseignements et le renforcement des relations entre le Centre national de coordination des lignes de comté.

En effet, le NPCC a fait pression sur le commissaire de Transport for London, Mike Brown, pour soutenir l'appel de licence d'Uber. Le chef de police Mark Collins est même allé jusqu'à suggérer qu'une décision de refuser à Uber son permis pourrait avoir un impact négatif sur la police britannique.

"J'espère que cette lettre décrit l'impact négatif sur la police britannique si la police n'était pas en mesure d'accéder aux données et informations que j'ai décrites."

Heywood a également déclaré que Collins avait affirmé que le service de police métropolitaine à lui seul faisait plus de 2 000 demandes de données à Uber chaque année. Il s'agit d'un nombre relativement élevé de demandes étant donné que, selon le propre rapport sur la transparence d' Uber, en 2020, toutes les autorités américaines chargées de l'application de la loi ont fait un peu moins de 5 000 demandes de données et toutes les autorités canadiennes combinées n'ont fait que 411 de ces demandes.

Il est probable que la direction d'Uber ressente une pression pour coopérer avec les initiatives de collecte de renseignements de la police, en particulier à la lumière de la décision de Transport for London de refuser le renouvellement de leur licence à deux reprises. Cela est dû au fait que l' article 17 de la loi de 1998 sur la criminalité et le désordre confère une responsabilité directe aux autorités chargées de l'octroi des licences de prévenir le crime et le désordre dans leur région. Cela impose aux autorités de délivrance de licences telles que Transport for London d'établir des partenariats de réduction de la criminalité et des troubles (CDRP) auxquels les opérateurs de transport tels qu'Uber sont censés participer.

Dans les directives statutaires du ministère des Transports aux autorités de délivrance des licences, le gouvernement renforce l'attente d'un partage de renseignements entre la police, les autorités de délivrance des licences et les opérateurs de transport tels qu'Uber :

« Faire prendre conscience aux forces de police de la valeur que les autorités de délivrance des licences accordent aux informations reçues, en particulier aux renseignements sans condamnation, contribuera à approfondir ces relations et renforcera les avantages d'un plus grand partage d'informations. Cette relation peut être mutuellement bénéfique, aidant la police à prévenir le crime. La police peut obtenir des renseignements précieux de la part des conducteurs et des opérateurs... »

Bien que de telles relations aient une importance significative pour le contrôle de la criminalité au niveau communautaire, il semble que peu d'attention ait été accordée au risque pour les libertés civiles d'un accès relativement facile aux riches données personnelles des conducteurs et des passagers telles que collectées et stockées par des plateformes telles que Uber, Bolt et Ola. Les taxis.

"Je suis encouragé par l'engagement affiché par Uber à ce sujet et d'autres travaux sont prévus [en 2020] pour s'appuyer sur les travaux réalisés jusqu'à présent. Cela se concentrera sur des aspects plus complexes des lignes de comté, le flux d'informations et de renseignements et le renforcement des relations entre le Centre national de coordination des lignes de comté.

"J'espère que cette lettre décrit l'impact négatif sur la police britannique si la police ne pouvait pas accéder aux données et aux informations que j'ai décrites."

« Sensibiliser davantage les forces de police à la valeur que les autorités de délivrance des licences accordent aux informations reçues, en particulier aux renseignements sur les non-condamnations, contribuera à approfondir ces relations et renforcera les avantages d'un plus grand partage d'informations. Cette relation peut être mutuellement bénéfique, aidant la police à prévenir le crime. La police peut obtenir des renseignements précieux auprès des chauffeurs et des opérateurs... »

Étude de cas : partage de renseignements avec les forces de l'ordre

Un autre travailleur qui nous a demandé de l'aide était un chauffeur Uber qui a été suspendu à tort de la plate-forme Uber pendant sept semaines, entraînant une perte de près de 5 000 £, à la suite d'une demande de renseignement faite par la police. En 2019, le chauffeur a reçu un message d'Uber indiquant qu'il était temporairement suspendu en raison d'une enquête en cours. Il n'a reçu ni motif ni délai pour sa suspension. En fait, il lui a été expressément dit de ne pas contacter Uber pendant qu'ils menaient l'enquête. Sept semaines plus tard, il a reçu un appel l'informant qu'il pouvait désormais travailler.

Deux ans plus tard, une demande de renouvellement de permis que le conducteur a présentée à TfL (qui comprend un contrôle amélioré du service de divulgation et d'interdiction) a révélé le motif de la suspension, lorsque TfL l'a interrogé sur la fourniture de drogue en 2019 et a menacé de lui retirer son permis. Choqué par la révélation, le conducteur a demandé un numéro de référence du crime et a mené des enquêtes supplémentaires non seulement auprès de TfL, mais également de la police métropolitaine.

Nous avons aidé le chauffeur à faire des demandes d'accès et des plaintes à Uber, TfL et la police. Uber n'a pas répondu à la demande (le chauffeur a été informé que sa demande avait été transmise à une équipe de spécialistes mais n'a reçu aucune autre réponse), cependant, la réponse de TfL a révélé une vaste chaîne d'e-mails entre divers responsables alors qu'ils tentaient d'identifier la source du renseignement. demander. Uber a affirmé qu'ils avaient été approchés par la police alors que la police n'avait trouvé aucun dossier ou preuve d'enquête sur le conducteur. Finalement, Uber a nommé l'officier qui avait fait la demande de renseignement, mais lorsque TfL a demandé des détails sur l'affaire, l'OCI a affirmé qu'il n'avait aucun souvenir du conducteur en question.

La plainte que le conducteur a déposée auprès de la police métropolitaine a finalement reçu une réponse en octobre 2021 et a conclu que le conducteur n'avait jamais été identifié comme suspect :

«Les agents ont été chargés d'identifier un suspect en rapport avec un crime grave. Les agents avaient reçu le nom d'une personne d'intérêt. Je peux confirmer que ce n'était PAS vous. Un formulaire de protection des données a été soumis le 20 février 2019 à Uber avec ces détails suspects nommés. Je ne suis pas autorisé à divulguer d'autres détails à ce sujet.

« À aucun moment votre nom n'a figuré dans cette enquête de recherche menée avec Uber. L'agent ne s'est PAS approché d'Uber à la recherche d'informations vous concernant. À la suite de notre enquête, Uber a fourni vos coordonnées à la police. Une fois que les informations ont été reçues d'Uber et qu'ils nous ont donné votre nom, nous savions que vous n'étiez PAS lié à notre enquête et aucune autre mesure n'a été prise et vous avez été exclu de toute autre enquête.

« L'agent n'a enfreint aucune norme professionnelle, n'a pas agi en dehors de son rôle de policier ou n'a abusé de son pouvoir. Votre nom n'était pas le but de la demande et à aucun moment nous n'avons dit à Uber que vous étiez une personne d'intérêt.

"Uber devrait peut-être expliquer comment ils suspendent quelqu'un qui ne faisait pas l'objet de la demande initiale et aussi pourquoi, après 10 jours, vous n'étiez pas automatiquement réintégré dans l'application et capable de continuer à travailler."

INTÉGRER : La vidéo de L

"Les agents ont été chargés d'identifier un suspect en relation avec un crime grave. Les officiers avaient reçu le nom d'une personne d'intérêt. Je peux confirmer que ce n'était PAS vous. Un formulaire de protection des données a été soumis le 20 février 2019 à Uber avec les détails de ce suspect nommé. Je ne suis pas libre de divulguer d'autres détails à ce sujet.

"A aucun moment votre nom n'a figuré dans cette enquête de recherche menée avec Uber. L'agent n'a PAS approché Uber à la recherche d'informations vous concernant. À la suite de notre enquête, Uber a fourni vos coordonnées à la police. Une fois que les informations ont été reçues d'Uber et qu'ils nous ont donné votre nom, nous savions que vous n'étiez PAS lié à notre enquête et aucune autre mesure n'a été prise et vous avez été exclu de toute autre enquête.

«L'officier n'a enfreint aucune norme professionnelle, n'a pas agi en dehors de son rôle de policier ou abusé de son pouvoir. Votre nom n'était pas le but de la demande et à aucun moment nous n'avons dit à Uber que vous étiez une personne d'intérêt.

"Uber devrait peut-être expliquer comment ils suspendent quelqu'un qui ne faisait pas l'objet de la demande initiale et aussi pourquoi, après 10 jours, vous n'avez pas été automatiquement réintégré dans l'application et capable de continuer à travailler."

Partie II : Exercice des droits sur les données au travail : accès

Le droit du travail ne contient pas les dispositions nécessaires pour protéger pleinement les travailleurs contre les pratiques déloyales découlant de la gestion algorithmique. Cependant, les individus ont des droits en vertu du RGPD qui peuvent protéger leurs intérêts dans des contextes d'emploi. En soutenant les travailleurs, nous invoquons leurs droits tels que définis par les articles 15, 20 et 22, qui leur donnent le droit d' accéder aux données personnelles , le droit à la portabilité des données , ainsi que le droit d'être informés sur la prise de décision automatisée et la logique de traitement .

Article 22 : Les personnes concernées ne peuvent faire l'objet de décisions ayant des effets juridiques (ou d'une importance similaire), fondées uniquement sur le traitement automatisé des données.

[Si le responsable du traitement traite des données avec le consentement explicite de la personne concernée, ou pour l'exécution d'un contrat avec elle, la personne concernée a le droit d'obtenir une intervention humaine, d'exprimer son point de vue et de contester la décision]

Article 15 : Les personnes concernées ont le droit de recevoir une copie de leurs données personnelles, ainsi que des informations supplémentaires telles que les finalités du traitement des données, les informations sur les personnes avec lesquelles les données peuvent être partagées, la durée du traitement, etc.

Article 20 : Les personnes concernées ont le droit de recevoir les données personnelles qu'elles ont fournies à un responsable du traitement dans un format structuré, couramment utilisé et lisible par machine. Ils ont également le droit de transmettre ("port") les données à un autre responsable du traitement. Dans la mesure du possible, ils peuvent demander que les données soient transmises directement d'un responsable de traitement à un autre.

Bien que les plates-formes mettent des téléchargements de données à la disposition des travailleurs, celles-ci omettent fréquemment les catégories de données les plus propices et les plus nécessaires pour interroger les conditions de travail (telles que l'équité des salaires, la répartition des tâches et l'utilisation, comme indiqué ci-dessus.) Dans notre aspiration à élargir la portée de données mises à la disposition des travailleurs, nous faisons des demandes d'accès et de portabilité spécifiques qui couvrent la gamme complète des plates-formes de concerts de données collectées auprès d'eux. Dans ces requêtes, nous cherchons à obtenir trois types de données différents :

1) Données d'entrée - fournies par les travailleurs eux-mêmes

2) Données d'observation - basées sur l'utilisation des plates-formes par les travailleurs (c'est-à-dire les données brutes de mesure et de surveillance telles que les données de localisation, la télématique, etc.)

3) Données inférées - dérivées de l'analyse des données d'observation (par exemple, profilage du comportement des travailleurs sous la forme d'évaluations des risques et de la fraude)

Article 22 : Les personnes concernées ne peuvent pas faire l'objet de décisions ayant des effets juridiques (ou d'une importance similaire), fondées uniquement sur le traitement automatisé des données.

[Si le responsable du traitement traite des données avec le consentement explicite de la personne concernée, ou pour l'exécution d'un contrat avec elle, la personne concernée a le droit d'obtenir une intervention humaine, d'exprimer son point de vue et de contester la décision]

Article 15 : Les personnes concernées ont le droit de recevoir une copie de leurs données personnelles, ainsi que des informations supplémentaires telles que les finalités du traitement des données, des informations sur les personnes avec lesquelles les données peuvent être partagées, la durée du traitement, etc.

Article 20 : Les personnes concernées ont le droit de recevoir les données personnelles qu'elles ont fournies à un responsable du traitement dans un format structuré, couramment utilisé et lisible par machine. Ils ont également le droit de transmettre ("porter") les données à un autre responsable du traitement. Dans la mesure du possible, ils peuvent demander que les données soient transmises directement d'un responsable de traitement à un autre.

Des données d'entrée

Fourni par les travailleurs eux-mêmes

Données observées

Sur la base de l'utilisation des plateformes par les travailleurs (c'est-à-dire des données brutes de mesure et de surveillance telles que les données de localisation, la télématique, etc.)

Données inférées

Dérivé de l'analyse des données d'observation (par exemple, profilage du comportement des travailleurs sous la forme d'évaluations des risques et de la fraude)

Ces catégories de données sont souvent rendues explicites dans les documents d'orientation et les politiques de confidentialité, mais ne sont pas partagées avec les conducteurs lorsqu'ils téléchargent leurs données ou font des demandes d'accès. D'après notre expérience, lorsque les travailleurs recherchent ces informations, les plateformes de concerts visent à rendre le processus difficile et fastidieux en adoptant une variété de comportements non conformes. Les travailleurs à la recherche de données complètes doivent naviguer dans des architectures de sites Web extrêmement complexes et obstructives et doivent contourner les efforts supplémentaires de frustration des agents de support, qui prolongent inutilement des processus administratifs simples ou fournissent des réponses automatisées qui ne répondent pas de manière adéquate aux requêtes. Ces procédures peuvent être décrites comme des « modèles sombres » conçus pour empêcher les travailleurs d'exercer leurs droits en tant que personnes concernées. Lorsque les travailleurs sont en mesure d'obtenir leurs données, il leur manque souvent des segments considérables ou elles sont présentées dans des formats incohérents et non lisibles par machine, ce qui rend l'analyse effectivement impossible. Ces actes d'obstruction obligent les travailleurs à faire des demandes répétées que les entreprises invoquent en fin de compte pour les discréditer.

Dans toutes les déclarations DSAR que nous avons vues, aucun employeur n'a fourni un compte rendu complet et approprié du traitement automatisé des données personnelles. Ceci est particulièrement important dans les domaines qui peuvent déterminer la sécurité de l'emploi tels que la répartition du travail, la gestion des performances, la sûreté et la sécurité, comme discuté dans ce rapport. Uber et Ola ont fait valoir devant le tribunal que la sûreté et la sécurité de leur plate-forme pourraient être compromises si la logique d'un tel traitement de données était divulguée à leurs employés. À notre avis, la sûreté et la sécurité ne peuvent être améliorées que lorsque les plateformes établissent de manière transparente des règles et des normes de performance plutôt que de s'appuyer sur une surveillance secrète et des licenciements sommaires, qui sont quelques-unes des principales motivations des DSAR.

Compte tenu de cette attitude de résistance aux DSAR, il est également important de noter que de nombreux conducteurs craignent des représailles de la part des entreprises pour avoir fait des demandes. Lorsque les plateformes de concerts effectuent des contrôles d'identité immodérés et prolongés en réponse aux demandes d'accès des sujets, les travailleurs sont facilement découragés et intimidés (voir les e-mails envoyés aux chauffeurs par Uber dans les études de cas de réponse de la plateforme). Dans les nombreux entretiens que nous avons menés avec des conducteurs, de longs messages de demande de confirmation, transmis dans un langage juridique complexe, ont souvent été référencés comme des éléments dissuasifs pour poursuivre les demandes. Pour de nombreux conducteurs, le fait de persister dans la demande équivaut à mettre sa tête au-dessus du parapet et à risquer son gagne-pain et sa sécurité d'emploi.

Cette perception découle souvent d'expériences d'exploitation et d'insécurité continues, résultant de la capacité et des connaissances limitées des travailleurs dans l'exercice des droits démocratiques, que ce soit au Royaume-Uni en tant qu'immigrants ou dans leur pays d'origine, qui dans de nombreux cas affichent des penchants autoritaires. Dans une main-d'œuvre déjà très fragmentée et sujette à la précarité économique, où le besoin de sécurité l'emporte largement sur le désir de défier l'injustice, l'impact de ce type de comportement hostile de la part des entreprises ne peut être surestimé. Cette insécurité est en outre aggravée par l'opacité des algorithmes de gestion. En l'absence d'explications claires sur le fonctionnement des systèmes d'allocation du travail ou de gestion des performances de la boîte noire, il devient très facile pour les travailleurs de s'engager dans une réflexion spéculative ou même complotiste sur la manière dont leurs interactions avec la plateforme affectent leur travail. Cela peut alors s'étendre à une méfiance généralisée à l'égard des autres institutions et à une aversion pour l'organisation de l'activité. Il s'agit de vulnérabilités fortes et persistantes au sein de la main-d'œuvre qui nécessitent une attention et une protection particulières.

Études de cas : DSAR individuels

Les études de cas suivantes montrent certaines des manières dont Uber adopte un comportement obstructif et non conforme en répondant aux demandes de données des travailleurs. De manière significative, ces exemples ne peuvent pas être expliqués comme des exceptions ou des événements isolés concernant des agents de soutien inexpérimentés. Ces réponses représentent les procédures standard suivies par Uber lorsque les travailleurs souhaitent exercer leurs droits d'accès aux données.

Réponses circulaires et futiles

M. Ahmed est un ancien chauffeur Uber et coursier Uber Eats. En octobre 2020, ses comptes de chauffeur et de coursier Uber ont été suspendus et en février 2021, son compte de chauffeur a été désactivé. Cela a également affecté son compte de messagerie UberEats, qui a ensuite été désactivé et supprimé.

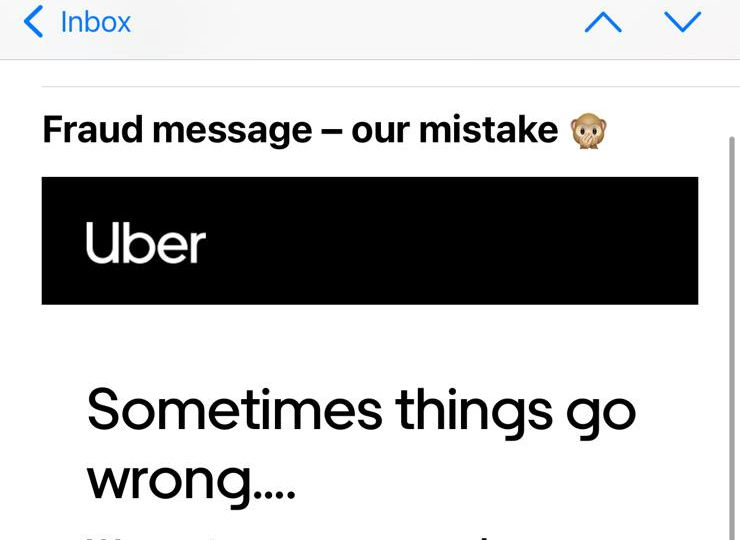

Lorsque M. Ahmed a demandé la cause de son licenciement, il a reçu des réponses contradictoires. Uber a initialement cité l'échec des contrôles de reconnaissance faciale, puis a affirmé que la désactivation était due à un volume élevé de commandes non livrées. Tout au long de la correspondance, ils se sont adressés à lui par un mauvais nom et ont finalement accepté que les messages concernant les échecs des vérifications d'identité en temps réel avaient été envoyés par erreur. La confusion autour de son licenciement l'a conduit à rechercher ses données personnelles.

Au cours des derniers mois, M. Ahmed a tenté de récupérer les données associées à son compte Uber Eats désactivé. M. Ahmed a d'abord tenté d'obtenir ses données le 15 avril 2021, via le formulaire « Soumettre une demande de confidentialité sans compte Uber » sur le site Web d'Uber, puisque son compte avait été supprimé à la suite de son licenciement.

En réponse, il a reçu un e-mail d'Uber déclarant : « Notre avis de confidentialité limite notre capacité à partager les informations des titulaires de compte. Nous ne pouvons fournir ces informations que via le processus décrit dans nos directives de demande de données. » Ce processus consiste à se connecter au compte et à faire la demande depuis le compte. « Cela dit, nous sommes en mesure de travailler avec vous via les canaux appropriés pour vous aider au besoin. »

M. Ahmed a répondu en demandant des conseils sur la façon dont il pourrait accéder aux données associées à son compte désormais supprimé. Il a expliqué qu'il écrivait à partir de l'e-mail associé à son compte Uber Eats et qu'il avait également fourni le numéro de téléphone mobile associé à ce compte. Il a ajouté qu'il était heureux de fournir de plus amples informations pour confirmer son identité.

À cela, M. Ahmed a reçu une réponse indiquant que sa « préoccupation n'est pas liée à ce compte. Veuillez nous écrire à partir du compte concerné ou vous connecter via help.uber.com avec les informations d'identification pertinentes et nous informer du problème afin que nous puissions vous aider davantage.

M. Ahmed a répondu en joignant une image de l'e-mail d'intégration qui lui a été envoyé par Uber le 3 juillet 2020, pour démontrer qu'il écrivait à partir du compte concerné. Le 19 avril 2021, il a reçu le même message indiquant que son « inquiétude n'est pas liée à ce compte ».

M. Ahmed a répondu en expliquant une fois de plus qu'il ne pouvait pas accéder à son compte et qu'il avait fourni les détails associés à son compte Uber Eats. Il a demandé à recevoir des conseils sur les autres informations qu'il pourrait fournir pour s'identifier. Il n'a reçu aucune réponse.

À ce stade, M. Ahmed a demandé l'aide de l'App Drivers and Couriers Union et de Worker Info Exchange et nous avons remonté le problème avec Uber. Le 11 mai 2021, M. Ahmed a reçu un e-mail d'Uber lui demandant de confirmer la demande que nous avons faite en son nom. Il nous a répondu en confirmant qu'il nous avait confié son mandat et qu'il souhaitait que sa demande soit traitée.

Le 14 mai 2021, M. Ahmed a reçu d'Uber un formulaire de vérification d'identité pour traiter la demande. Le formulaire demandait les mêmes détails qu'il avait déjà partagés dans ses messages précédents, tels que l'e-mail, le numéro de téléphone, le pays de résidence, le type de données demandées. Il lui a également demandé sa «note actuelle» – qui était inapplicable, car il n'avait plus accès à son compte. M. Ahmed a envoyé le formulaire à Uber, mais il n'a reçu aucune réponse.

Le 20 mai 2021, M. Ahmed a écrit à Uber pour obtenir la confirmation qu'ils traitaient sa demande. Il n'a reçu aucune réponse.

Au moment de la rédaction, M. Ahmed n'a pas reçu ses données. Il n'a pas non plus reçu d'explications sur les raisons pour lesquelles sa demande n'est pas traitée.

Partage de données incohérent et incrémentiel

M. Amini est un ancien chauffeur Uber qui a été désactivé en novembre 2020 suite à l' échec d'une vérification de géolocalisation . Uber a signalé son licenciement à TfL, qui a ensuite révoqué le permis de location privée de M. Amini, le laissant sans travail. Afin de comprendre la cause de son licenciement, M. Amini a cherché à obtenir ses données auprès d'Uber.

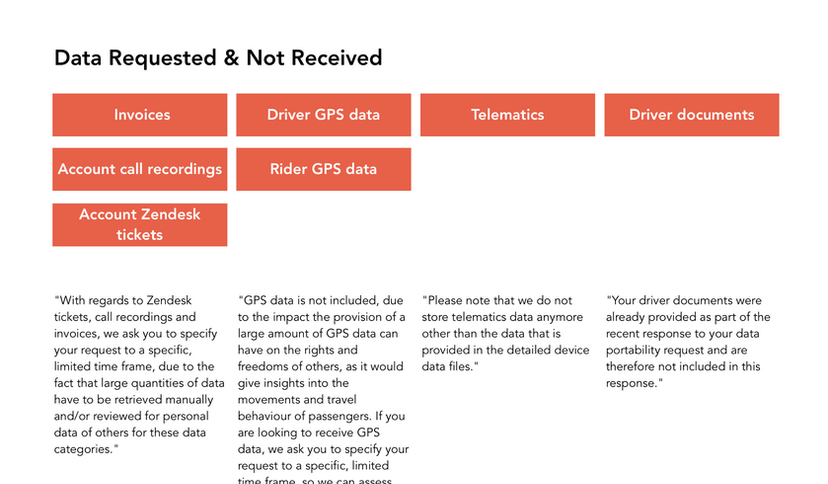

M. Amini a fait sa première demande le 13 avril 2021 et a demandé toutes ses données personnelles, y compris les 26 catégories de données décrites dans le document d'orientation produit par Uber, ainsi que les images qu'il a soumises en réponse aux contrôles d'identité en temps réel. Il a précisé qu'il voulait des données couvrant toute la période où il a été actif en tant que chauffeur Uber.

M. Amini a reçu une réponse à sa demande le 05 mai 2021, cependant les données fournies ne couvraient que les 30 jours précédant sa demande. Étant donné que M. Amini n'avait pas pu travailler pour Uber pendant cette période, de nombreux ensembles de données fournis étaient vides.

M. Amini a ensuite fait une autre demande le 6 mai 2021, déclarant à nouveau qu'il demandait des données concernant toute la période pendant laquelle il a travaillé avec Uber, ajoutant spécifiquement qu'il souhaitait des données collectées jusqu'en novembre 2020.

M. Amini a reçu une réponse le 28 mai 2021. Cependant, des données incomplètes lui ont de nouveau été transmises. Plus précisément, le fichier csv des données détaillées sur le périphérique fourni par Uber était complètement vide.

M. Amini a fait une autre demande le 02 juin 2021 pour demander les données manquantes. Il a reçu ses données détaillées sur l'appareil du conducteur pour novembre 2020 le 10 juin 2021. Cependant, bien qu'il ait précisé qu'il souhaitait tous les champs de données répertoriés dans les notes d'orientation produites par Uber, il a reçu un ensemble de données restreint qui omettait 32 des 50 données. des champs.

Obfuscation et résistance

M. Majid est un ancien chauffeur Uber qui a été désactivé en septembre 2020 suite à l'échec d'une vérification de géolocalisation. Comme dans le cas de M. Amini, Uber a signalé le licenciement de M. Majid à TfL, ce qui a entraîné la révocation de son permis de location privée. Afin de comprendre le fondement des allégations d'Uber, il a tenté d'obtenir ses données.

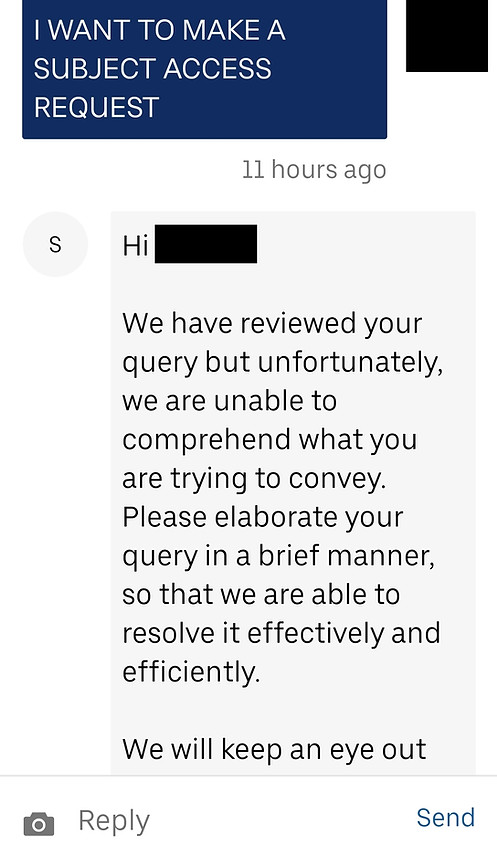

M. Majid a contacté Uber pour la première fois pour demander ses données le 2 juin 2021. En réponse, il a reçu un message lui demandant d'expliquer brièvement sa préoccupation. M. Majid a répondu en demandant 3 catégories de données (sur les 26 catégories énumérées dans les notes d'orientation d'Uber) pour septembre 2020.

Le 8 juin 2021, M. Majid a reçu un message d'Uber indiquant : « Notre politique de confidentialité ne nous permet pas d'apporter des modifications ou de discuter d'informations personnelles sans contact via l'adresse e-mail associée à votre compte partenaire. Afin de vous aider avec votre problème spécifique, vous devrez écrire en utilisant l'adresse e-mail associée à ce compte. Merci de votre compréhension."

À ce stade, M. Majid nous a contactés, confus, car il avait écrit à Uber depuis son compte. Il a répondu, expliquant à Uber qu'il les avait contactés en se connectant à son compte de chauffeur, donc il écrivait certainement à partir de la bonne adresse e-mail. Il a demandé s'il pouvait fournir des pièces d'identité/documents supplémentaires pour assurer à Uber qu'il était celui qui avait fait la demande.

En réponse, il a reçu le même message d'Uber : "Bonjour... merci pour votre message. Nous comprenons que vous souhaitez discuter des informations relatives à un compte Uber. Si vous êtes le titulaire du compte, veuillez nous écrire à partir de l'adresse e-mail associée à votre compte Partner-Driver, et nous serons en mesure de vous aider immédiatement.

Le 9 juin 2021, M. Majid s'est connecté à son compte partenaire et a commencé une discussion avec l'assistance Uber pour réessayer. Son message lui demandant s'il pouvait faire une demande d'accès au sujet a été ignoré.

Le 14 juin 2021, M. Majid a de nouveau contacté Uber, indiquant qu'il avait une question sur son compte partenaire chauffeur. Il a reçu une réponse d'Uber : « Merci de nous avoir contactés… Nous avons profité de l'occasion pour examiner votre préoccupation et pouvons voir que vous nous avez déjà contacté à propos de ce problème. L'un des membres de notre équipe étudie actuellement votre problème et nous vous répondrons dans les plus brefs délais. Pour rationaliser notre communication et éviter toute confusion, nous allons de l'avant pour clore ce contact.

Le 16 juin 2021, M. Majid a de nouveau contacté Uber, indiquant qu'il lui avait été demandé de se connecter à son compte pour faire une demande, et après avoir fait cela, il souhaitait partager les détails de sa demande. Il a reçu une réponse le lendemain et a ensuite envoyé les détails de la demande (des trois ensembles de données énumérés ci-dessus) le 18 juin 2021.

N'ayant reçu aucune réponse, M. Majid a recontacté Uber le 28 juin 2021, lui demandant de confirmer que sa demande était en cours de traitement. Le 1er juillet 2021, il a reçu une réponse indiquant que sa préoccupation avait été soulevée auprès de l'équipe spécialisée et qu'ils seraient en contact pour enquêter plus avant.

Le 2 juillet 2021, M. Majid a reçu une réponse au fil de discussion qu'il avait lancé le 9 juin 2021. Ce message indiquait qu'Uber exigeait que les demandes soient personnellement signifiées à l'adresse postale d'Uber BV aux Pays-Bas.

M. Majid n'a reçu aucune autre communication.

« La question des algorithmes est au cœur de la thématique de l'ubérisation. Trop souvent, c'est l'algorithme qui joue le véritable rôle du patron, la technologie offrant de nouveaux moyens de subordination des travailleurs. Il y a bien évidemment un besoin de transparence de la gestion algorithmique mais au-delà de cette transparence, il y a un besoin de co-gestion de l'algorithme. Les représentants des travailleurs doivent pouvoir participer à leur développement."

Leïla Chaibi, eurodéputée

Études de cas : réponses de la plate-forme à

Demandes par lots par l'échange d'informations sur les travailleurs